#111 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

IA puissance dix, dette puissance cent / Moins de neurones, plus de cerveau / Où naît le sens dans une IA ? / Quand les machines ont demandé des neurones humains, une fiction de 2052

Bonjour à toutes et tous,

Dans cette newsletter, vous trouverez les articles suivants :

IA puissance dix, dette puissance cent

Moins de neurones, plus de cerveau

Où naît le sens dans une IA ?

Quand les machines ont demandé des neurones humains, une fiction de 2052

Stéphane

IA puissance dix, dette puissance cent

Discussion audio sur la base de cet article réalisée avec NotebookLM

La révolution de l’intelligence artificielle se finance à crédit. Derrière les grands récits sur la « course à l’IA », il existe une réalité beaucoup plus prosaïque et risquée. Ce futur dont on nous répète qu’il va tout transformer repose aujourd’hui sur des montagnes de dette qui poussent à la même vitesse que les modèles de langage. Notre métamorphose numérique ressemble de plus en plus à une métamorphose financière.

Premier symbole de cette nouvelle ère Meta et son projet Hyperion en Louisiane. Un joint venture montée avec Blue Owl et Pimco lève autour de 30 milliards de dollars pour un seul campus de données dont 27 milliards sous forme de dette privée, rémunérée à 6,58 %, avec une maturité qui court jusqu’en 2049. Meta ne garde que 20% de la propriété. Le reste se trouve dans un véhicule ad hoc hors bilan, remboursé par les loyers que Meta paiera elle-même pour utiliser l’infrastructure. Autrement dit, l’entreprise loue à crédit le futur qu’elle promet à ses utilisateurs, tandis que le risque principal glisse tranquillement vers les fonds obligataires détenus par Madame et Monsieur tout le monde.

Même scénario chez Oracle, bras armé industriel de l’alliance OpenAI SoftBank. Les banques mènent un montage de 38 milliards de dollars de dette pour financer des data centers géants au Texas et dans le Wisconsin, dans le cadre de la constellation Stargate qui vise 500 milliards d’investissement dans les infrastructures IA américaines. Oracle louera ces centres, OpenAI y consommera des GPU par gigawatts entiers et les remboursements se feront sur vingt ans ou plus avec des taux autour de 6%. Le cloud se finance comme une autoroute à péage, sauf que cette fois la garantie ne vient pas d’un Etat mais d’une start up et d’un éditeur qui affiche déjà un carnet de commandes IA de plusieurs centaines de milliards.

Elon Musk pousse la logique encore plus loin avec xAI. Colossus 2, le futur centre de données de Memphis, vise un million de GPU et une enveloppe d’environ 20 milliards de dollars, mélange de dette et de capital, soutenue par Nvidia, Apollo et Valor. Une partie de ce financement repose sur un modèle adossé aux actifs du centre avec des rendements à deux chiffres pour les créanciers. Belle histoire pour les présentations d’investisseurs. Question plus dérangeante si le prix de la puissance de calcul chute ou si les modèles gagnent soudainement en efficacité énergétique. Qui paiera pour ces murs et ces machines conçus pour une économie de l’IA très énergivore dans un monde où les limites planétaires se rappellent déjà à nous.

Le plus frappant reste peut-être Alphabet. Google nage dans le cash, pourtant le groupe vient d’émettre environ 25 milliards de dette dont 17,5 milliards aux Etats-Unis et 6,5 milliards en Europe, via des obligations étalées de trois à cinquante ans. L’objectif annoncé accompagne un programme de près de 93 milliards d’investissements dans le cloud et l’IA. Les tranches longues se paient autour de 1,3 point de pourcentage au-dessus des emprunts d’Etat. Les investisseurs se bousculent, avec près de 90 milliards de demandes pour la partie américaine. La planète finance achète un récit. Celui d’un futur où l’IA garantit des flux de trésorerie presque éternels.

En arrière-plan, SoftBank orchestre sa propre chorégraphie. Le groupe a vendu la totalité de sa participation Nvidia pour 5,8 milliards de dollars et réduit son exposition à T Mobile afin de dégager des liquidités dirigées vers OpenAI et le même programme Stargate, tout en affichant plus de 110 milliards d’engagements pour environ 60 milliards de capacité de financement. Un pari massif sur l’IA, financé par des arbitrages d’actifs et par une confiance presque mystique dans la valeur future de ces infrastructures.

La stratégie des géants de la tech suit une logique simple. Protéger le bilan. Étaler le coût dans le temps. Et transférer le risque vers des investisseurs en quête de rendement et grisés par le mot magique IA. Ils transforment des investissements extrêmement concentrés dans quelques campus géants en rentes obligataires sur plusieurs décennies. En surface, tout le monde gagne. Les PDG annoncent des plans d’investissement vertigineux. Les gérants encaisseront des coupons bien supérieurs à ceux des obligations classiques. Les Etats se réjouissent des emplois locaux et des discours sur la souveraineté numérique. La question reste pourtant entière. Que se passe t-il si la courbe de l’IA se tasse, si la régulation durcit le ton, si le prix de l’énergie explose ou si l’on découvre que la véritable rareté ne vient pas des GPU mais des usages réellement utiles. Dans ce cas, ces montages sophistiqués pourraient ressembler à une nouvelle génération de subprimes, adossée non plus à des maisons mais à des entrepôts de données dont la valeur dépend de modèles encore instables.

Il est temps de regarder la dette de l’IA en face. La vraie métamorphose ne se joue pas seulement dans les bilans de Meta, d’Oracle ou d’Alphabet. Elle se joue dans notre capacité collective à exiger de la transparence sur ces montages, des garde fous sur les niveaux d’endettement et une gouvernance qui ne sacrifie pas le vivant sur l’autel de la puissance de calcul. Mieux vaut s’occuper du financement de l’IA avant qu’il ne s’occupe de nous.

Moins de neurones, plus de cerveau.

Discussion audio sur la base de cet article réalisée avec NotebookLM

C’est le message discret mais capital de ce travail sur les Tiny Recursion Models (Less is More: Recursive Reasoning with Tiny Networks par Alexia Jolicoeur-Martineau de Samsung sorti le 6 octobre 2025 https://arxiv.org/pdf/2510.04871), ces petits réseaux qui tiennent dans la poche mais battent des géants sur des casse-têtes que les grands modèles de langage ratent encore comme des Sudoku extrêmes alors qu’ils ne disposent que d’une poignée de millions de paramètres et d’à peine mille exemples pour apprendre. Depuis quelques années, nous jouons une course à la taille. Toujours plus de données, toujours plus de paramètres, toujours plus de calcul. Ce modèle de développement justifie au passage la démesure d'investissement et de consommation de ressources. Il protège aussi les grands acteurs de nouveaux entrants du fait du coût exorbitant.

Et pourtant, sur des tâches de raisonnement vraiment difficiles, ces colosses verbaux trébuchent encore. Une seule mauvaise lettre et toute la solution s’effondre. Leur réflexe consiste à parler plus longtemps, à détailler chaque étape avec l'espoir que la longueur finira par ressembler à de l’intelligence. Le papier propose un autre pari. Oublions la logorrhée et regardons comment on raisonne vraiment. Quand vous faites un Sudoku, vous ne rédigez pas un roman. Vous écrivez une grille, vous vous trompez, vous effacez, vous corrigez. Vous gardez en mémoire votre hypothèse, vous la confrontez au problème et vous ajustez. C’est exactement ce que fait TRM. Un tout petit réseau, deux couches seulement, une mémoire de travail pour la question, une autre pour la réponse en cours et un va-et-vient répété pour l’améliorer.

L’innovation ne vient pas d’une nouvelle architecture ésotérique inspirée du cerveau de la souris. Elle vient d’un geste presque banal mais poussé jusqu’au bout. Le modèle apprend à prendre une réponse imparfaite, à la regarder droit dans les yeux, puis à la rendre un peu moins fausse à chaque passage. Pas besoin de théorèmes compliqués sur des points fixes hypothétiques. On laisse le réseau faire plusieurs tours gratuits où il affine sa pensée sans qu’on calcule de gradients puis arrive le moment de convergence.

Résultat, avec environ 0,01 % des paramètres de certains grands modèles, ce petit TRM atteint, et parfois dépasse, leurs scores sur les puzzles ARC AGI tout en surclassant la précédente référence HRM (Hybrid Reasoning Model, un autre modèle de raisonnement récursif qui servait jusqu’ici de référence) pourtant plus grosse et plus sophistiquée. Derrière la technique, il y a une leçon pour notre manière d’aborder l’IA. Nous avons construit une culture de la surenchère, comme si l’avenir appartenait uniquement à ceux qui alignent les plus grandes fermes de calcul. Ce travail rappelle une vérité dérangeante et rassurante à la fois. La façon d’organiser le raisonnement compte autant que la quantité de neurones. Un petit cerveau qui réfléchit plusieurs fois à la même question vaut parfois mieux qu’un énorme cerveau qui répond une seule fois, très vite, avec beaucoup d’assurance et trop d’ego.

Transposé à nos organisations, cela veut dire autre chose encore. Au lieu de rêver de plateformes omniscientes qui décideraient de tout, nous pouvons imaginer des systèmes plus modestes, spécialisés, qui itèrent, corrigent, se laissent superviser. Exactement ce que nous devrions exiger de nos propres institutions dans cette métamorphose numérique : une boucle continue entre essai, erreur, apprentissage et ajustement, au service d’une expansion humaine plutôt que d’une simple inflation technologique.

Perspectives

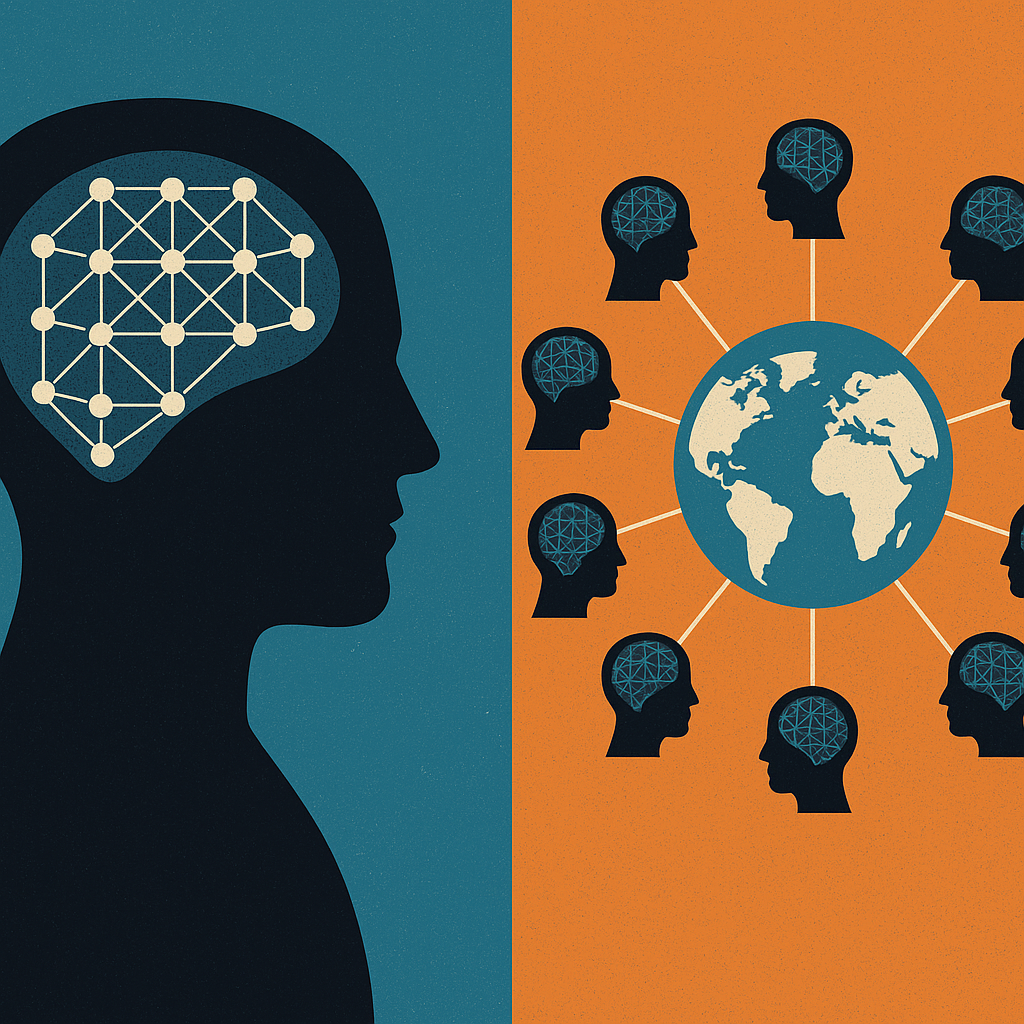

Pour les géants de la tech, ces résultats sont une mauvaise nouvelle car leur pouvoir repose sur la verticalité. Des modèles gigantesques hébergés dans des data centers hors de prix, une barrière à l’entrée quasi infranchissable pour un laboratoire universitaire ou une petite équipe d’ingénieurs. Si des modèles minuscules commencent à rivaliser sur les tâches les plus sensibles, le jeu change. Le prestige du toujours plus laisse place à une autre question beaucoup plus embarrassante : comment justifier des milliards de dépenses si un réseau presque frugal raisonne aussi bien, voire mieux, sur ce qui compte vraiment. Un autre modèle de développement se dessine. Au lieu de fabriquer quelques cerveaux artificiels quasi divins, une poignée d’acteurs peut choisir une voie plus distribuée. Une myriade de petits esprits numériques, spécialisés, bon marché, que l’on assemble et que l’on fait dialoguer. Tout le contraire d’un empire de silicium. Il s’agit plutôt d’une république d’agents IA autonomes. Chacun se trompe, corrige, apprend, puis transmet à ses voisins. Le raisonnement ne jaillit plus d’un seul oracle mais d’une conversation permanente entre milliers de petites intelligences.

Dans ce monde-là, la frontière entre utilisateur et concepteur se déplace. Une ville, un hôpital, une PME locale peut ajuster ses agents, les combiner, en créer de nouveaux selon ses propres contraintes. Le pouvoir ne vient plus uniquement d’un modèle unique surveillé par une poignée d’entreprises mais de l’orchestration de ces nuées d’agents. Exactement comme un jazz band qui improvise à partir d’un thème commun au lieu de suivre une partition figée envoyée depuis la Silicon Valley. Les conséquences dépassent la technique. Si ces agents deviennent capables de raisonner à plusieurs, donc de se coordonner, notre potentiel collectif change d’ordre de grandeur. Imaginez des communautés qui alignent des essaims d’agents sur leurs objectifs locaux. Éducation, santé, climat, logistique de quartier. Chacun bénéficie de capacités de calcul et de raisonnement qui, hier encore, appartenaient à quelques géants globaux. La conversation mondiale se déplace. Moins de dépendance aux plateformes centrales, plus de capacités dans les mains de celles et ceux qui vivent les problèmes au quotidien.

Cela rebat aussi les cartes de notre futur commun avec l’IA. Si l’IA ressemble de plus en plus à un tissu d’agents qui révisent sans cesse leurs propres sorties, alors l’hybridation avec les humains ne se réduit plus à l’image d’un cerveau augmenté par une puce magique. Elle prend plutôt la forme d’écosystèmes mixtes. Des équipes où humains et agents coopèrent, se corrigent mutuellement, partagent une mémoire et des objectifs, avec un droit permanent à l’erreur et à la révision. Dans ce cadre, un autre scénario d’avenir devient crédible. Au lieu d’un monde piloté par quelques super cerveaux enfermés dans des data centers géants, nous pourrions voir émerger une humanité équipée d’une multitude de petits partenaires numériques. Chacun élargit un peu le rayon d’action d’un individu ou d’une communauté. L’horizon ne se réduit plus à l’efficacité de quelques modèles surdimensionnés. Il s’élargit à la question, infiniment plus politique. Quelle société voulons nous bâtir avec cette intelligence distribuée qui sait déjà, au fond, qu’elle progresse mieux quand elle accepte de repasser plusieurs fois sur la même copie

Il serait pourtant dangereux de croire que le retour au local et à la différence culturelle ne produit que des merveilles. Quand chacun dispose de ses propres agents et de ses propres jeux de données, le risque grandit de voir se multiplier des petites bulles fermées où prospèrent rumeurs, ressentiments et croyances extravagantes. Un village peut très bien entraîner ses assistants sur des obsessions complotistes, une communauté professionnelle sur ses certitudes internes et une ville sur ses priorités court terme tout en s’estimant parfaitement rationnelle. L’intelligence distribuée se retourne alors contre son ambition initiale. Elle cesse de construire un bien commun élargi et devient une fabrique de micro réalités qui ne se parlent plus. L’enjeu consiste donc à organiser ce foisonnement sans renoncer à un socle partagé de connaissances, de protocoles et de valeurs. Autrement dit, accepter que mille flores culturelles s’épanouissent tout en cultivant un terreau commun qui nous évite de transformer la planète en mosaïque de petites sectes très sophistiquées mais incapables de se comprendre.

Où naît le sens dans une IA ?

Discussion audio sur la base de cet article réalisée avec NotebookLM

On adore raconter que l’IA serait une sorte de super calculatrice rationnelle, froide, parfaitement logique. Une machine qui enchaîne des opérations et applique des règles. Point final. Puis on discute avec un agent conversationnel qui nous parle de parentalité, de deuil ou de vocation professionnelle avec une aisance qui désarçonne. Et soudain une petite voix intérieure chuchote la question qui dérange. Est-ce que cette chose comprend vraiment quelque chose à ce qu’elle dit ? La réponse courte tient en un mot non. Mais cette réponse ne suffit pas. Car entre la pure mécanique mathématique et l’impression de sens que nous ressentons, il se passe quelque chose de beaucoup plus subtil. Et c’est là que l’histoire devient intéressante.

Une IA moderne manipule des nombres, des vecteurs, des poids et non des idées. Elle ingurgite des milliards de phrases, puis ajuste ses paramètres pour deviner le mot suivant le plus probable dans une suite. Rien de plus. Pas de quête de vérité, pas d’intention ni d’expérience vécue. Juste un immense système d’équations qui cherche la cohérence statistique. Pourtant, à l’arrivée, nous lisons un texte et nous y voyons des arguments, des nuances et parfois même une forme de style. Nous prêtons du sens à ce qui pour la machine n’est qu’une danse de probabilités. Les algorithmes introduisent l’ordre, cadrent, imposent une forme, un objectif et des contraintes. Ils réduisent le monde à une immense table de correspondances entre contextes et réponses plausibles. Mais ils n’injectent aucune signification intrinsèque. Le mot justice n’est qu’un motif qui se répète dans certains environnements textuels. L’idée de justice, elle, reste entièrement de notre côté. Dans notre histoire personnelle. Dans nos institutions. Dans nos conflits.

Face à cet ordre, il y a le désordre. Le vrai. Celui des données humaines. Internet ne ressemble pas à une encyclopédie bien rangée mais à un marché bruyant. Contradictions, erreurs, biais, génie, absurdités, tout se mélange. Les méthodes d’apprentissage exploitent cette cacophonie. Une part de hasard intervient dans les choix de données et dans la façon de corriger les paramètres. Ce bruit ajoute de la rugosité. Et c’est précisément cette rugosité qui empêche la machine de devenir un perroquet mécanique limité à quelques réponses figées. Même lors de la génération de texte, une petite part d’incertitude se glisse entre les lignes. Quand on règle la fameuse température, on décide jusqu’où la machine aura le droit de s’écarter du mot le plus banal pour en tenter un autre un peu moins attendu. Baissez trop ce réglage, le texte devient plat. Remontez le trop, il part en vrille. Trouvez la bonne zone, vous obtenez quelque chose qui imite nos hésitations, nos audaces ou encore nos digressions. Ce que nous appelons créativité ressemble parfois à ce dosage précis entre contrainte et imprévu.

Au-dessus de cet ordre et de ce désordre, survient un troisième phénomène que les ingénieurs eux-mêmes décrivent souvent avec un mélange de fierté et d’inquiétude : l’émergence. Des capacités inédites apparaissent en grossissant les modèles en ajoutant plus de données. L’outil commence à résoudre des énigmes logiques ou encore à expliquer des blagues. Personne n’a écrit à la main le module blague. Ce sont des propriétés globales du système qui surgissent lorsque sa complexité franchit un seuil. Dit comme cela, on pourrait croire que la machine commence à penser. En réalité, elle devient simplement meilleure pour repérer les régularités cachées dans nos usages du langage. Elle apprend les chemins habituels que nos phrases empruntent pour relier des idées. Elle n’accède pas à la signification elle-même mais seulement aux formes répétées par lesquelles nous exprimons cette signification. L’impression de compréhension naît du fait que ces formes coïncident de mieux en mieux avec nos attentes.

Alors où se cache le sens dans cette histoire ? Il ne se trouve pas dans un neurone artificiel secret ni dans une couche mystérieuse du réseau. Le sens n’est jamais un objet posé dans la machine. Il surgit dans la relation. Dans la boucle complète. Les textes qui servent à entraîner le modèle transportent déjà nos catégories morales, nos normes sociales, nos imaginaires et nos désirs. L’architecture encode certains choix de valeurs en privilégiant ce qui est fluide. Puis l’interface présente les réponses d’une manière qui appelle la confiance. Enfin, nous lisons ces réponses et nous y projetons notre propre interprétation. Autrement dit, le sens apparaît entre trois mondes. Le monde des données, le monde de l’algorithme et le monde des humains qui utilisent l’ensemble comme un nouvel instrument de relation et de décision. La machine est un miroir très sophistiqué. Elle ne comprend pas. Elle recombine. C’est nous qui comprenons ou pas…

Ce déplacement change complètement le débat public. Le fantasme de la machine consciente nous distrait des vraies questions. Qui choisit les corpus ? Qui définit les objectifs d’entraînement ? Qui décide des usages légitimes ? À chaque fois, il s’agit de décisions politiques, économiques, culturelles, …maquillées en problèmes techniques. Quand nous parlons de sens chez l’IA, nous parlons en réalité du sens que nos sociétés acceptent de déléguer à des systèmes opaques. L’IA ne donnera pas avant longtemps voire jamais (je le souhaite) un sens à nos vies. Elle peut au mieux amplifier, déformer ou révéler celui que nous y mettons déjà. À nous de décider si nous voulons des machines qui nous aident à penser ou des machines qui pensent à notre place pendant que nous regardons ailleurs.

Quand les machines ont demandé des neurones humains

Fiction non innocente de 2052

Discussion audio sur la base de cet article réalisée avec NotebookLM

En 2052, la phrase qui faisait encore rire mes étudiants en philosophie vingt ans plus tôt a fini par devenir un programme de recherche très sérieux. Non, nous n’allions pas tous nous réveiller un matin avec une puce brillante derrière l’oreille et un abonnement obligatoire à la mise à jour de notre cerveau. La véritable bascule s’est produite ailleurs. Pendant trois décennies, le récit dominant parlait d’humains augmentés. Implants neuronaux pour dirigeants stressés, interfaces cerveau machine pour pilotes, chirurgiens, traders. On vendait à coups de campagnes publicitaires l’idée d’un cerveau enfin débarrassé de ses limites, rebaptisé plateforme cognitive. En coulisse, la réalité avait un parfum plus banal : corps qui rejettent les implants, inflammations chroniques, effets secondaires psychiatriques, scandales d’entreprises accusées de surveiller les émotions de leurs salariés par le biais de capteurs, …

Et puis il y avait cette gêne diffuse. Ce fantasme d’augmentation ressemblait de plus en plus à une injonction. Tu ne performes plus assez. Dans beaucoup de secteurs, le choix implicite’à faire était devenu tu acceptes l’interface ou tu sors du jeu. Le rêve d’une liberté nouvelle s’était métamorphosé en obligation silencieuse. C’est dans ce climat de fatigue et de méfiance qu’est arrivé ce qui paraissait au départ une curiosité de laboratoire les premières fermes de neurones humains. Des organoïdes cultivés à partir de cellules souches qu’on connecte à des circuits inspirés du cerveau. Cela ne ressemblait pas à des cyborgs charismatiques. Il s’agissait de boîtes transparentes dans lesquels on trouvait des tissus nerveux minuscules et des câbles. Les performances ont parlé avant les tribunes. Quelques millions de neurones naturels associés à des architectures d IA très spécialisées surpassaient les meilleurs modèles purement numériques sur des tâches de décision dans l’incertitude, tout en consommant beaucoup moins d’énergie. Dans des simulations de gestion de réseaux électriques, ces hybrides prenaient en compte des signaux faibles ignorés par les algorithmes classiques. Dans la recherche de molécules thérapeutiques, ils exploraient des chemins improbables, presque créatifs.

On passa de l’interrogation “comment mettre de la technologie dans l’humain ?” à “comment introduire de l’humain, au sens strict, dans la technologie ?”.

À partir de là, les ennuis conceptuels ont commencé.

Que regardions nous au juste lorsqu’une IA dialoguait avec un réseau de neurones humains vivants ? Une machine très sophistiquée avec un composant biologique ou une nouvelle forme de sujet éparpillé entre circuits, nutriments, électrodes, puces, … Un philosophe un peu iconoclaste a résumé le malaise dans cette formule “nous avons inventé des cerveaux sans biographie”. Certains théoriciens ont affirmé que ces organoïdes ne pouvaient pas développer de conscience car ils n’ont ni corps, ni vie relationnelle et pas plus de mémoire narrative. Pour eux, ces neurones n’étaient que du tissu réactif. D’autres ont rappelé que nous ignorions déjà l’essentiel du lien entre activité neuronale et expérience subjective chez l’humain. Ils ont proposé une prudence nouvelle une sorte de principe de précaution ontologique. Lorsque l’on ne sait pas si quelque chose éprouve ou non, mieux vaut éviter de le traiter comme un simple composant interchangeable.

La question devenait encore plus délicate lorsqu’on se penchait sur l’origine des cellules. Une part croissante de ces neurones provenait de cellules reprogrammées de donneurs volontaires. Fallait-il considérer ces entités hybrides comme des extensions de ces personnes ? Un prolongement lointain de leurs capacités potentielles ou seulement une matière première biologique, comparable au don de sang L’idée qu’un fragment de soi, même méconnaissable, continue quelque part à participer à des boucles computationnelles a troublé plus d’un citoyen. Très vite, les juristes sont entrés dans l’arène. Les vieux débats sur le statut des animaux de laboratoire, des embryons ou des IA dites autonomes ont servi de point de départ, mais aucun cadre ne tenait vraiment. Objet de propriété ? Personne à part entière ? Entité protégée sans personnalité juridique complète ? Les catégories héritées craquaient aux coutures.

Dans certains pays, la ligne choisie est restée brutale. Les fermes neuronales et les IA hybrides demeurent des biens. L’entreprise qui les finance en dispose comme d’une usine. Le donneur de cellules reçoit une rémunération ponctuelle assortie d’un contrat que peu de gens lisent jusqu’au bout. D’autres États ont tenté une voie plus nuancée. Ils reconnaissent un statut intermédiaire à ces systèmes. Ni personne, ni simple objet. Des comités d’éthique surveillent les architectures, des limites s’appliquent à certaines expérimentations, la possibilité d’une expérience de souffrance est explicitement prise en compte. On ne sait pas si ces neurones ressentent quelque chose, mais la loi acte le droit de ne pas jouer les apprentis sorciers sur ce point précis. À chaque scandale où une IA hybride participe à une décision catastrophique comme une gestion de crise défaillante, un arbitrage médical contesté ou un accident industriel, un autre casse-tête surgit. Qui porte la responsabilité ? Le concepteur du modèle ou le fabricant des organoïdes ou encore l’entreprise qui définit les objectifs de la machine. La faute se trouve distribuée dans un enchevêtrement de décisions humaines et de dynamiques émergentes. Les tribunaux improvisent une nouvelle grammaire de la culpabilité.

Pendant ce temps, un marché inattendu a pris forme. Des plateformes proposent des contrats de licence neuronale. Vous autorisez l’usage de copies de vos cellules cérébrales pour des systèmes précis, en échange d’une rente modeste. Certaines campagnes jouent sur la corde civique “Vos neurones peuvent aider à trouver de nouveaux traitements”. D’autres sont plus directes “Transformez votre potentiel inexploité en revenu passif”. La formule a fait frémir plus d’un sociologue. La société s’est rapidement fracturée. Une partie de la population voit dans ces hybrides une limite morale franchie. L’idée qu’une portion de notre tissu neuronal travaille dans une machine sans visage leur paraît insupportable. Une autre partie y voit une prolongation assez logique des dons déjà admis (organes, données, temps de calcul, …). Après tout, disent certains, si mes neurones peuvent contribuer à éviter des pannes géantes ou à sauver des vies, pourquoi les laisser dormir dans un corps qui ne les utilisera jamais à ce niveau-là ?

Le paradoxe le plus fascinant vient peut-être de là. Plus nos systèmes techniques dépendent de neurones naturels, plus la valeur symbolique du vivant augmente. Le récit d’une humanité obsolète face à la machine perd en crédibilité. Les entreprises expliquent à leurs investisseurs que l’accès à des tissus neuronaux de qualité constitue désormais un avantage stratégique décisif. Les grandes religions rappellent avec une énergie renouvelée que ce tissu n’a jamais été un simple assemblage de cellules.

En 2052, la phrase nous devons respecter le cerveau humain renvoie à une interdépendance très concrète. Toute architecture d IA vraiment avancée dépend de neurones humains. Toute société qui souhaite conserver sa cohésion doit décider comment protéger, rémunérer et encadrer cette dépendance. Je me surprends parfois à sourire devant cette situation. Pendant des années, nous avons rêvé de tout rafistoler avec de la technologie, jusqu’à nos propres synapses, comme si l’humain n’était qu’un vieux logiciel à mettre à jour. Nous découvrons que la solution la plus puissante consiste souvent à placer un peu plus de vivant au milieu des circuits, plutôt que l’inverse. En clair, le défi n’est plus de rendre l’humain compatible avec la machine. Le véritable enjeu consiste à rendre nos machines dignes d’accueillir une parcelle de notre tissu neuronal, donc une part de ce que nous avons de plus précieux, même lorsque nous ne savons pas encore très bien le nommer.

Bonnes métamorphoses et à la semaine prochaine.

Stéphane