#100 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

La soumission par l’absurdité ou quand l’IA dresse nos certitudes Aujourd’hui et demain selon Peter Thiel Les batailles de l’IA Nous sommes prévisibles L’avènement programmé du déterminisme dans l’IA Chroniques du futur : Le bug du jugement (2045)

Bonjour à toutes et tous,

100 newsletters ! Quand j’ai commencé, je ne savais pas si cela durerait ni si cela trouverait un écho. Et pourtant, chaque retour, chaque réaction, chaque échange m’a confirmé que cela en valait la peine. Car ces prises de parole ne sont pas anodines. Elles sont là pour éveiller, pour questionner et parfois déranger mais surtout pour engager.

Comprendre et savoir deviennent des actes de résistance et agir, un devoir.

Ces newsletters sont ma manière d’ouvrir des portes, de proposer des clés et d’avancer à vos côtés humblement mais avec détermination.

Merci d’être là.

Continuons ensemble.

Métamorphoses va marquer une pause estivale salutaire pour mes neurones.

Je vous souhaite un excellent été.

Stéphane

Pour célébrer cette 100-ème édition, vous disposez de 20 € de réduction à partir de 50 € d’achat sur mon site avec le code 20 !

Pour commander, il suffit de cliquer là ! ou sur vos sites ou librairies préférés.

Au menu cette semaine :

La soumission par l’absurdité ou quand l’IA dresse nos certitudes

Aujourd’hui et demain selon Peter Thiel

Les batailles de l’IA

Nous sommes prévisibles

L’avènement programmé du déterminisme dans l’IA

Chroniques du futur : Le bug du jugement (2045)

Stéphane

La soumission par l’absurdité ou quand l’IA dresse nos certitudes

« Et si la tyrannie la plus raffinée n’était plus la force mais l’absurde ? »

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

Je pose la question alors que les fils d’actualité défilent sous vos yeux remplis de slogans contradictoires, d’images trafiquées et de prédictions péremptoires signées par une intelligence artificielle qui bien que sans visage nous tend un miroir déformant. À force de cliquer et de scroller, nous avons laissé l’absurde coloniser l’ordinaire. Ce texte est une sonnette d’alarme et un carnet d’itinérance pour comprendre comment l’algorithme orchestre ce nouveau dressage collectif et surtout comment nous pouvons lui opposer notre formidable capacité de divergence. Prenons ces lignes comme une invitation à sortir de l’hypnose colorée des écrans pour retrouver l’épaisseur du monde. Car si l’absurde plane aujourd’hui comme une fumée acide, c’est qu’il prospère sur nos zones grises (la fatigue de l’attention, l’appétit pour le spectaculaire, la flemme de vérifier, …). Alors, tournons-nous vers ce que Camus appelait « la raison lucide » à savoir le simple courage de nommer les choses avant qu’elles ne se figent.

La soumission par l’absurde ne naît pas d’un chaos sans ordre mais d’une logique implacable. Plus le message paraît incohérent, plus il désarme notre vigilance. Nous rions, puis nous cédons et finissons par oublier. Cette boucle “rire, acquiescer, effacer” n’est pas une évocation métaphorique mais un protocole psychologique documenté par les neurosciences de l’attention. L’université Johns Hopkins a ainsi montré qu’un stimulus perçu comme « irrationnel » paralyse les zones frontales de la vérification critique pendant plusieurs secondes soit le laps de temps suffisant pour laisser passer la charge virale d’une information toxique. L’absurde a toujours servi historiquement de solvant aux faits. Les slogans doubles de l’Inquisition « Croire, donc savoir » ou les pastiches dadaïstes des années 1920 nous le rappellent. Mais l’absurde version 4.0 change de nature. Il opère pour chacun en continu et partout grâce à l’accélération numérique. La timeline fait office aujourd’hui de théâtre permanent où l’esprit se détend en croyant rire alors qu’il signe en réalité un bail de complaisance. Tiens, souvenons‑nous de cette rumeur mondiale affirmant que les avions à réaction peignaient des traînées de contrôle mental. C’est bien sûr une idée grotesque partagée des milliards de fois qui est devenue mantra politique pour plusieurs partis populistes. Plus c’est gros, plus ça passe !

La machine, rappelons-le, ne possède ni dessein ni malignité. Elle cherche le clic, point final ! Or le clic se nourrit d’émotion brute. Résultat ? L’algorithme privilégie ce qui tranche, choque et divise. Une absurdité visible double son trafic et une absurdité partagée le triple. À chaque boucle, la donnée capturée confirme le modèle qui produit alors un contenu encore plus outré. Le public abasourdi redonne plus de données. L’engrenage est parfait et surtout très rentable. Deux mécanismes se conjuguent. D’abord, le reinforcement learning oriente la production : si une vidéo d’un iguane chantant l’hymne national déclenche 20 % de partages de plus qu’un reportage pédagogique alors l’iguane devient le roi du fil. Ensuite, le dynamic ranking fait remonter en temps réel les contenus les plus incendiaires tandis que les correctifs apportés par les fact‑checkers arrivent trop tard et sont perdus dans les profondeurs du flux. Ajoutez les masques technologiques (deepfakes photoréalistes, clones vocaux, hallucinations génératives, …) et la frontière du réel devient floue. Comme l’écrivait Borges, nous avançons dans une « carte à l’échelle du territoire » sauf que là, la carte se met à jour plus vite que nos repères intérieurs. Une expérience menée par MIT Media Lab a mesuré qu’un deepfake politique crédible se propageait six fois plus vite qu’un démenti officiel même lorsqu’il était clairement labellisé comme suspect. Exemples ? Un challenge TikTok invitant les adolescents à sauter d’un pont « virtuel » pour prouver leur courage numérique, un score de confiance bancaire calculé sur vos réactions faciales pendant la signature d’un emprunt sont autant de grenades désinformationnelles vendues en package aux autorités anonymes d’États autocrates qui en abusent. L’absurde n’est plus une anomalie, elle est devenue l’interface par défaut.

Les biais cognitifs sont les complices invisibles du processus. Les premiers auxquels on pense sont le biais de conformité (je préfère ce qui me confirme), le tout nouveau biais d’autorité algorithmique (si c’est écrit par une IA, c’est sûrement exact), l’effet d’omission (je ne vois pas ce qu’on ne me montre plus), .... Dans un rapport récent, l’Organisation mondiale de la santé mentale numérique indiquait qu’un individu exposé à un flux de nouvelles contradictoires voyait son seuil d’inhibition critique baisser de 30 % après 48 heures. Pourtant, l’humain dispose d’atouts inégalés comme l’imagination divergente, l’empathie, la pensée systémique ou encore l’intuition. Trois musiques intérieures que l’algorithme ne sait pas composer parce qu’elles exigent le désordre créatif de la conscience. Encore faut‑il s’accorder. La diversité cognitive que l’on peut décrire comme la rencontre programmée des dissonances fonctionne comme une inoculation. Lorsque l’esprit entend plusieurs partitions, il détecte en général la fausse note. Des initiatives fleurissent partout : cercles de discussion “cross‑bulle” où des étudiants en data rencontrent des sociologues, des podcasts interactifs comparant les sources en direct ou encore hackathons citoyens dédiés au discernement médiatique. Chaque fois que la pensée s’oblige à frictionner l’absurde recule d’un pas.

On caricature souvent le débat : réguler l’IA ou dresser la foule. C’est oublier la troisième voie qui consiste à copiloter. Il faut commencer par l’éducation augmentée avec de l’alphabétisation des données et des algorithmes complétés par des ateliers d’expérimentation où l’on démonte publiquement le tour de supposé magie algorithmique. Dans une université de Séoul, un cours baptisé « AI Illusion Lab » place les étudiants face à un générateur de fausses photos de leurs propres campus. L’effet‑choc intensifie la vigilance bien mieux qu’un module théorique. Puis vient le culture hacking . Il s’agit de détourner les codes viraux pour instiller l’esprit critique. Un mème conscient vaut parfois mieux qu’un cours magistral. La ville de Barcelone a testé des micro‑vidéos humoristiques expliquant la logique des bulles de filtrage avec comme résultat une diffusion organique multipliée par cinq et une compréhension mesurée en fin d’expérience +40 %. À l’échelle des gouvernances, réhabilitons l’audit citoyen et le code source ouvert permettant ainsi à chacun de voir sous le capot. L’Estonie a lancé un registre public des modèles déployés par l’administration où chaque ligne de code est soumise aux pairs. Résultat ? Deux bugs éthiques majeurs détectés et corrigés avant déploiement. Et si nous renversions les logiques de marché ? Utilisons l’IA pour libérer et pas pour manipuler avec une singularisation au service de l’émancipation. Imaginez une plateforme qui propose, non pas la prochaine publicité, mais la lecture contradictoire ou la conversation inter‑convictions qui nous manque.

Voici trois anticipations de futurs pas si lointains …

Absurdistan dystopique. Nous rions de tout, nous ne croyons à rien, nous obéissons à tout. Le “Laugh‑to‑Obey Ratio” devient l’indicateur macroéconomique majeur. Les entreprises calibrent leurs messages pour atteindre un optimum de stupéfaction. Les gouvernements publient des décrets rédigés en langage cryptique pour tester le seuil de compliance. Paradoxalement, la société paraît plus “détendue” que jamais, anesthésiée serait un meilleur qualificatif.

Renaissance augmentée. Des collectifs pilotent l’IA comme un bateau : la machine propulse et l’humain gouverne. L’indice de pluralité narrative grimpe ce qui est le signe d’une santé démocratique retrouvée. Les écoles intègrent des simulateurs d’absurde pour apprendre aux futurs citoyens à détecter le faux. Les statistiques montrent une réduction de 60 % de la propagation inauthentique.

Middle‑Path régulé. Des barrières éthiques solides évitent les ravins mais la créativité s’érode contre les garde‑fous. Le taux de friction légale IA‑innovation mesure l’hésitation permanente. Les comités de conformité publient plus de pages que les auteurs de science‑fiction. Les idées progressent, certes, mais sous perfusion bureaucratique. À long terme, l’élan pourrait s’essouffler à moins d’une itération des normes aussi agile que les technologies.

Lequel choisirons‑nous ? Les signes avant‑coureurs s’affichent déjà dans nos flux. L’avenir ressemble moins à un embranchement qu’à un curseur et chaque clic le déplace.

Et trois initiatives pour passer de l’indignation à l’action

A titre individuel. Instaurez votre rituel absurdity‑check . Chaque soir, listez ce qui vous a semblé « trop fou pour être vrai ». Reliez les points. Publiez un contre‑narratif créatif par semaine. En parallèle, lisez attentivement pendant dix minutes par jour des sujets opposés à votre bulle. Une gymnastique mentale équivalente à un sprint neuronal.

Au niveau Organisationnel. Créez un shadow board IA à savoir un comité de dissidence chargé de questionner les modèles internes. Mesurez non pas le nombre de clics, mais la friction constructive : combien de fois a‑t‑on repéré l’absurde avant de le relayer ? La marque Patagonia ou la BBC utilisent déjà des indices de “résistance cognitive” pour évaluer leurs contenus avant publication.

Et enfin sociétal. Inventons un bac à sable réglementaire aussi mobile que la technologie. Imposons la clause de réversibilité : tout modèle doit pouvoir être désappris. Injectons un capital‑risque “responsable by design” : financer ce qui éclaire plutôt que ce qui aveugle.

L’absurde n’est pas une fatalité mais une paresse collective. Mais la bonne nouvelle est que la lucidité peut être entraînée. L’intelligence artificielle élargit le champ des possibles et refuser le couloir de l’absurde revient à ouvrir le balcon de la transcendance. Et maintenant ? A nous de jouer !

The Next Mind Tips and tricks

En plus de “Métamorphoses” qui continuera plus que jamais à parler des enjeux du futur, “The Next Mind Tips & Tricks” est une newsletter où vous trouverez tout ce que vous voulez savoir sur l'IA sans jamais avoir le temps : news, nouvelles IA, usages, astuces, …

Pour s’abonner, c’est sur mon profil Linkedin.

Aujourd’hui et demain selon Peter Thiel

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

Peter Thiel qui est une figure emblématique de la droite technologique américaine et un investisseur avisé a un prisme singulier pour décrypter notre époque que l’on soit d’accord ou pas avec lui. Son récent entretien avec le New York Times est une plongée dans une vision du monde où la stagnation est la règle, la prise de risque une nécessité et l'Antéchrist une métaphore inquiétante de notre propre soumission à la sécurité. Rien que ça ! La suite de cet article reprend les éléments qui me semblent importants donc biaisés …

Thiel n'est pas un optimiste béat de la Silicon Valley. Dès 2012, il arguait pour sa "thèse de la stagnation" une conviction persistante selon laquelle le monde a depuis les années 1970 ralenti sa course vers le futur. Si l'on excepte le "monde des bits" (l'informatique, l'internet, la téléphonie mobile, la crypto et plus récemment l'intelligence artificielle), la vitesse du changement s'est considérablement amoindrie. Il propose une expérience de pensée édifiante pour étayer cette assertion. Tandis qu'un voyageur temporel de 1860 à 1970 se retrouverait dans un monde radicalement transformé, celui de 1985 à 2025 constaterait une ressemblance troublante hormis quelques gadgets numériques. La différence la plus notable réside selon lui dans l'environnement bâti ce qui est un signe d'une inertie tangible. Cette stagnation ne se mesure pas uniquement à l'aune de nos automobiles ou de nos infrastructures. Elle se manifeste également dans le déclin des retours sur investissement dans la recherche scientifique et académique et par une bureaucratisation qui étouffe l'innovation. Pourquoi cette inertie ? Thiel avance plusieurs hypothèses : une panne d'idées, la dégradation des institutions devenues frileuses et une anxiété légitime face à un progrès accéléré qui menaçait d'apocalypse environnementale ou nucléaire. Cette stagnation n'est pas une option viable selon lui. Une société dont la classe moyenne ne peut plus espérer que ses enfants vivront mieux est une société qui vacille. Facteur aggravant, les institutions fondées sur la croissance à l'image des budgets nationaux sont par conséquence intrinsèquement instables.

Face à cette "décadence", concept qu'il emprunte volontiers, il prône une audace renouvelée au travers d’une "prise de risque bien plus importante". Il cite l'exemple de la recherche sur la maladie d'Alzheimer, où "zéro progrès en 40 à 50 ans" témoigne d'un système sclérosé et enfermé dans des paradigmes inefficaces comme celui du bêta-amyloïde. Le cynisme voire le nihilisme s'est installé. Aucun millénial ne croit plus que la science guérira toutes les maladies contrairement à une certaine frange des baby-boomers qui même dans leur "narcissisme" conservaient une foi en ce potentiel. C'est dans ce contexte que Thiel a opéré un virage vers la politique en agissant comme un "capital-risqueur" pour des figures "disruptives" dont JD Vance. Son soutien à Donald Trump en 2016 jugé par beaucoup "fantaisiste" visait moins un programme positif qu'une tentative de "réorienter le Titanic" et à tout le moins d'ouvrir une "conversation" sur le déclin américain. Ce n'est qu'en 2024, selon lui, que la Silicon Valley a constaté l'échec d'un libéralisme "woke" et a commencé à envisager le "Trumpisme et le populisme" comme des "véhicules pour l'innovation technologique et le dynamisme économique". Bien que le populisme puisse être critiqué pour son désintérêt apparent pour la science ou son désir de réduire les financements, il réplique que la science actuelle est déjà défaillante. Il cite l’usage qui a transformé le terme "moonshot" (projet ambitieux) en un euphémisme pour quelque chose "qui n'arrivera jamais". Le populisme dans cette optique agit comme un déconstructeur ou un révélateur des illusions avant qu'une véritable reconstruction puisse advenir.

L'intelligence artificielle, malgré son apparente fulgurance n'est pas la panacée pour lui. Il la situe "à peu près à l'échelle d'internet à la fin des années 90", c’est à dire capable de générer de grandes entreprises mais pas nécessairement de mettre fin à la stagnation généralisée. Il se montre particulièrement sceptique vis-à-vis de la théorie de la "super-intelligence en cascade" selon laquelle une intelligence artificielle suffisamment puissante pourrait résoudre tous les problèmes du monde. Pour Thiel, l'intelligence pure n'est pas le "facteur limitant". Le véritable problème réside dans "quelque chose de profondément erroné dans notre société". Il parle d’une incapacité à tolérer les "personnes intelligentes hétérodoxes" ou d’une conformité de l'intelligence qui à l'image d'un algorithme Netflix génère une infinité de productions "OK" sans véritable différence. Le transhumanisme (cette quête d'immortalité par la machine) est également jugé avec un regard critique. Non pas parce qu'il serait "bizarre et contre nature" mais parce qu'il est "pathétiquement peu" ambitieux au regard de la transformation intégrale (corps et âme) promise par une vision chrétienne orthodoxe.

C'est là que Thiel introduit l'une de ses notions les plus provocatrices : l'Antéchrist. Il ne le présente pas comme un génie du mal technologique mais comme une figure qui promet paradoxalement "la paix et la sécurité". La véritable menace existentielle n'est pas seulement l'Armageddon technologique (guerre nucléaire, désastre environnemental, IA incontrôlable, …) mais la "solution politique par défaut" à ces risques qui serait "un gouvernement mondial totalitaire". Le "trou de l'intrigue" dans les récits de l'Antéchrist (comment prend-il le contrôle du monde ?) trouve une réponse contemporaine. En évoquant "sans cesse l'Armageddon" et la "crise existentielle", il pousse les masses à réclamer une régulation absolue. Dans cette optique, selon lui une figure comme Greta Thunberg par sa vision "anti-croissance, environnementaliste, autoritaire" pourrait devenir le catalyseur d'une "stagnation universelle" imposée par la peur. Les institutions actuelles comme la FDA ou la Commission de Réglementation Nucléaire qui imposent de facto des normes mondiales sont déjà dans une certaine mesure une forme de "règle modérée de l'Antéchrist". Pour Thiel, l'abandon du projet d'exploration spatiale dont Mars (un projet d’Elon Musk désormais perçu comme futile sans une victoire préalable contre le "gouvernement socialiste woke" sur Terre), tout comme la frilosité réglementaire dans le nucléaire sont des symptômes de cette soumission collective. Il ne s'agit pas de nier les dangers mais de refuser que la peur ne mène à une capitulation devant une autorité totalitaire déguisée en protecteur.

Sa vision anti-calviniste de l'histoire où Dieu n'est pas la cause de tout et où l'espace pour "l'action humaine, pour la liberté humaine" est vaste est centrale. Nous ne sommes pas condamnés à la stagnation ou à la soumission. Accepter de prendre plus de risques, de remettre en question les illusions d'un progrès illimité ou d'une sécurité totale et d'affronter les véritables problèmes de notre société non pas tant comme un déficit d'intelligence mais comme un problème culturel. Car Dieu, comme il le souligne avec une pointe d'ironie, ne nous abandonnera pas "éternellement à regarder des écrans et à nous faire sermonner par Greta Thunberg". La charge nous incombe de résister, d'agir, et de retrouver une ambition qui transcende la simple survie pour embrasser une véritable transformation.

__________

Décodage et critiques

Si la pensée de Peter Thiel, telle qu'articulée dans son récent entretien, est un stimulant intellectuel puissant et singulièrement provocateur, elle n'en suscite pas moins une interrogation fondamentale quant à sa pertinence pour l'ensemble de l'humanité et non pas pour une minorité élitiste dont il fabrique les leaders politiques de demain en les finançant.

Sa thèse de la "stagnation". Bien que perspicace quant à l'inertie technologique depuis les années 70 sauf pour le "monde des bits" confine la notion de progrès à une dimension purement quantitative et matérielle : vitesse des transports, retours sur investissement scientifique, ... Elle minimise, voire écarte, d'autres formes de progrès essentielles à une civilisation épanouie : la réduction des inégalités, l'harmonie sociale et surtout la préservation de l'environnement, aspects que les "anxiétés" des années 70 qu'il mentionne cherchaient précisément à adresser. L'approche de Thiel qui voit en "Greta Thunberg" un symbole d'un futur "super oppressif occulte la légitimité des préoccupations écologiques et la nécessité d'une gestion collective et durable de la planète pour le bien de tous. Il est totalement “cornucopien”.

L'appel à une "prise de risque bien plus importante" et son soutien sans condition à des figures "disruptives" en politique posent la question des bénéficiaires ultimes de cette audace. La "déconstruction" populiste, si elle peut révéler des illusions, sape généralement les bases d'institutions démocratiques et de collaborations internationales nécessaires à la résolution de problèmes globaux au profit d'intérêts singuliers plutôt que d'un bien commun universel. Ce point est parfaitement illustré en ce moment.

Enfin, sa métaphore de l'Antéchrist dépeint non comme un génie du mal mais comme l'incarnation de la "paix et sécurité" menant à un "gouvernement mondial totalitaire" par la peur de l'Armageddon peut être lue comme une mise en garde contre toute forme de gouvernance globale ou de régulation. Or, des défis existentiels comme le changement climatique ou le contrôle des technologies disruptives (y compris l'IA) exigent précisément une coordination et une régulation à l'échelle planétaire, non pas pour asservir, mais pour protéger le bien commun et éviter des catastrophes qui nous menaceraient tous. Sa vision tout en éclairant les impasses de la conformité élude souvent la nécessité d'un progrès véritablement inclusif, d'une audace mise au service non pas d'une élite ou d'une échappatoire individuelle mais d'un avenir désirable et viable pour l'ensemble de l'humanité.

Les batailles de l’IA

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

Les grandes entreprises technologiques investissent massivement pour développer des intelligences artificielles généralistes mais pendant ce temps une révolution parallèle et potentiellement plus significative est en train d'arriver : celle des IA ultra-ciblées. Ces intelligences locales et spécialisées adaptées précisément à des problématiques définies pourraient profondément transformer notre manière d'interagir avec la technologie. Cette confrontation entre grandes et petites IA n’est pas seulement technologique. Elle met au grand jour des visions radicalement différentes du futur que nous pourrions construire.

D’un côté, nous retrouvons les acteurs majeurs comme OpenAI, Google ou Meta qui construisent des IA généralistes. Ces systèmes sont caractérisés par leur besoin massif en données, leur puissance de calcul toujours plus élevée et leur ambition d’universalité. Ils promettent une expérience utilisateur simple, cohérente, globale et capable de gérer de nombreuses tâches à la fois. Cette vision universelle s'accompagne de risques majeurs comme l’uniformisation culturelle, la dilution des particularités locales et la marginalisation des différences individuelles et communautaires.

À l’opposé, les petites IA ultra-ciblées gagnent en pertinence. Ces intelligences légères et spécialisées sont créées pour répondre à des besoins précis au sein de contextes très particuliers (entreprises, villes, régions ou communautés spécifiques). Leur force réside précisément dans leur capacité à comprendre et à intégrer les spécificités locales et culturelles. Elles offrent ainsi des solutions profondément personnalisées et adaptées à des environnements distincts. Contrairement aux grandes IA généralistes, elles consomment moins de ressources et peuvent être développées par des acteurs locaux renforçant ainsi la souveraineté technologique des communautés.

Cette tendance est fortement accentuée par l’émergence des agents autonomes qui sont de petits programmes intelligents capables d'agir indépendamment, de coopérer entre eux et de s'intégrer dans des réseaux décentralisés. Les agents locaux présentent une agilité remarquable car ils peuvent rapidement être adaptés à divers contextes spécifiques et déployés efficacement. Ces agents sont susceptibles de devenir les véritables acteurs de terrain de cette nouvelle révolution technologique. Leur potentiel est particulièrement prometteur dans des domaines tels que la santé, l’agriculture de précision, la gestion urbaine ou encore l’éducation personnalisée. La diffusion massive d'agents locaux impose de nombreuses interrogations : comment gérer la complexité d’un réseau diversifié d’agents autonomes ? Comment éviter les conflits entre des agents aux objectifs divergents ? Et surtout, comment déterminer la responsabilité juridique et éthique des actions menées par ces micro-intelligences ? Ces problématiques nécessitent l’élaboration de nouvelles formes de régulations et de protocoles pour assurer la coexistence harmonieuse de ces multiples acteurs numériques.

Plusieurs scénarios prospectifs en découlent :

Un équilibre hybride : une coexistence équilibrée entre grandes IA généralistes et IA locales spécialisées. Chaque catégorie joue un rôle complémentaire. Les IA généralistes assureraient les grands enjeux globaux tandis que les IA locales préserveraient les spécificités régionales et culturelles. Cela permettrait de bénéficier à la fois de l’efficacité d’échelle et de la pertinence locale.

La société ultra-personnalisée : disparition progressive des grandes IA au profit d'un monde dominé par des agents ultra-spécialisés. Ce scénario aboutirait à une extrême personnalisation des services technologiques conduisant à une société fragmentée en micro-environnements sociaux et économiques distincts où chaque individu ou communauté bénéficierait de solutions uniques et sur mesure.

Fragmentation technologique et sociale : prolifération incontrôlée des agents locaux induisant une fragmentation et un isolement des communautés incapables de dialoguer efficacement en raison du manque d'interopérabilité entre agents. Cette fragmentation pourrait exacerber les divisions sociales, économiques et culturelles déjà existantes et bien sûr renforcer des bulles d'information isolées.

Surveillance centralisée totale : pour faire face à la complexité générée par les agents autonomes, les États pourraient imposer une surveillance accrue avec un agent central dominant pour maintenir un contrôle strict qui réduisait fortement l’autonomie locale. Ce scénario poserait d’importantes questions éthiques sur la protection de la vie privée et des libertés individuelles.

Activisme pirate numérique : émergence de groupes activistes utilisant des agents locaux clandestins pour combattre les grandes IA généralistes et échapper aux contrôles étatiques centralisés. Ces groupes pirates exploiteraient ces intelligences autonomes pour entre autres défendre la liberté individuelle, lutter contre la censure et protéger la vie privée et promouvoir des idéaux alternatifs. Cela conduirait inéluctablement à une rupture sociale et politique significative et donnerait lieu à des nouvelles formes d’action militante décentralisée.

A suivre …

Nous sommes prévisibles

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

Une publication scientifique récente parue dans la revue Nature ne peut que nous interpeller fortement. Des chercheurs ont développé une intelligence artificielle nommée « Centaur » qui est capable de prédire les comportements humains avec une précision remarquable dans une grande variété de contextes expérimentaux. Centaur ne se limite pas à des tâches spécifiques à la différence des modèles traditionnels. Il peut anticiper les décisions humaines dans presque tous les scénarios imaginables. Cette IA a été entraînée à partir de 10 millions de choix réalisés par des participants dans 160 expériences psychologiques distinctes puis elle a été comparée aux modèles théoriques psychologiques les plus reconnus. Le résultat est sans équivoque. Centaur a surpassé ces modèles traditionnels dans 31 cas sur 32.

Fait particulièrement marquant, Centaur n’a pas été initialement conçue spécifiquement pour l'analyse comportementale humaine. Elle est à la base un modèle de langage classique qui a développé une compréhension approfondie des schémas décisionnels humains en intégrant massivement des données comportementales. Elle a ainsi dépassé les approches traditionnelles issues de décennies de recherches en psychologie. Cette découverte questionne profondément la perception commune selon laquelle les choix humains seraient fondamentalement spontanés ou uniques. Centaur révèle au contraire l'existence de régularités décisionnelles que nous pensions difficiles à formaliser. Plus intrigant encore, lorsque Centaur a été confrontée à des données issues d'imagerie cérébrale, ses représentations internes se sont alignées de manière significative avec l’activité neuronale humaine observée pendant des tâches similaires. Ce phénomène laisse entendre que l'IA ne fait pas simplement que prédire les choix humains mais qu'elle acquiert un mode de traitement de l'information similaire au nôtre.

Les implications pour les entreprises et le marketing sont potentiellement énormes. En adaptant des modèles similaires à Centaur aux comportements de consommation, les entreprises pourraient anticiper avec précision les décisions d'achat. Cela leur permettrait de concevoir des produits et des messages sur mesure répondant directement aux attentes implicites des consommateurs. Cette avancée scientifique montre que la prédictibilité humaine devient un atout majeur pour la compétitivité. Jusqu’à présent, une telle compréhension était largement fondée sur les analyses d’experts en psychologie comportementale et en consommation. Désormais, Centaur ouvre une nouvelle ère…

Si une intelligence artificielle peut si précisément décrypter les mécanismes du choix humain, comment envisager désormais l'authenticité des décisions dans les entreprises ? Allons-nous vers un futur où les besoins réels seront parfaitement servis ou risquons-nous plutôt de sombrer dans une manipulation généralisée et dystopique ? Devons-nous privilégier un monde où les comportements humains sont parfaitement prévisibles ou préserver activement l'authenticité profonde de nos choix ?

https://www.nature.com/articles/d41586-025-02095-8

L’avènement programmé du déterminisme dans l’IA

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

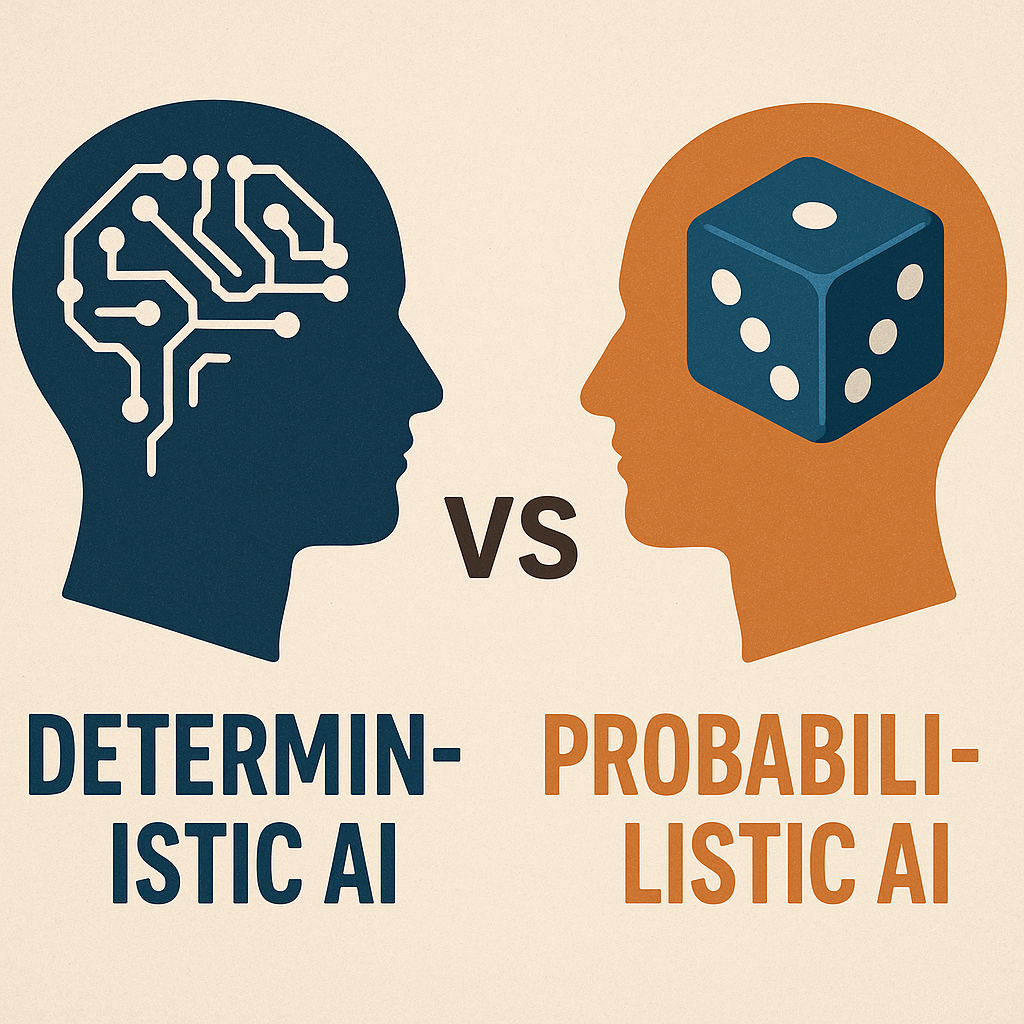

La révolution numérique actuelle accélère la transformation des sociétés à un rythme en forte accélération. Au cœur de cette mutation se trouve l'intelligence artificielle certes fascinante mais également source d'importants questionnements éthiques et techniques. Un besoin majeur émerge aujourd’hui avec la nécessité de passer d'intelligences artificielles probabilistes qui dominent actuellement à des intelligences artificielles déterministes. Cette transition va au-delà d'une simple optimisation technologique. Elle implique une refonte profonde du rapport entre l’humain et la machine.

La plupart des IA telles que ChatGPT ou Midjourney reposent actuellement sur des modèles probabilistes. Ces systèmes utilisent des méthodes statistiques et des apprentissages sur de larges ensembles de données afin d'identifier des motifs récurrents et produire des résultats basés sur des probabilités. Même si ces modèles sont relativement efficaces, ils comportent une incertitude inhérente. Leur comportement peut varier d’une exécution à l’autre qui imposent d’importantes préoccupations éthiques et pratiques notamment en termes de fiabilité, de transparence et de responsabilité juridique.

L’importance de cette transition vers le déterminisme réside dans la nécessité d'établir une confiance accrue dans les IA. Un modèle déterministe permettrait une parfaite reproductibilité des résultats et une totale transparence des mécanismes décisionnels. Ce type d'IA serait très utile par exemple dans des secteurs tels que la médecine où les diagnostics et décisions chirurgicales doivent être absolument fiables ou encore dans les véhicules autonomes où la moindre incertitude peut entrainer des conséquences dramatiques. D'autres domaines critiques tels que la finance ou la cybersécurité exigent également un haut niveau de prédictibilité afin d’anticiper et d’éviter des crises majeures ou des attaques informatiques.

Comment parvenir à ce déterminisme ? L'une des pistes prometteuses est l'avènement de l'informatique quantique. Actuellement en plein essor bien que toujours à un stade préliminaire, l'informatique quantique repose sur les propriétés des qubits (bits quantiques) qui peuvent représenter simultanément plusieurs états grâce à des phénomènes tels que la superposition et l'intrication quantique. Contrairement aux bits classiques (0 ou 1 uniquement), les qubits augmentent exponentiellement la capacité de calcul et permettent la résolution de problèmes jusqu’ici insolubles par des moyens classiques.

Les systèmes quantiques peuvent explorer simultanément un grand nombre de solutions potentielles en utilisant ces propriétés uniques. Les incertitudes inhérentes aux modèles probabilistes classiques sont ainsi considérablement réduites. En pratique, cela signifie qu’une IA quantique déterministe pourrait fournir des prédictions parfaitement anticipées et optimisées ce qui par conséquence élargie drastiquement son champ d'application. Ces avancées ouvriraient des possibilités inédites comme des prédictions météorologiques d’une précision sans précédent ou une gestion optimisée en temps réel des réseaux énergétiques complexes. L’impact sur les capacités des intelligences artificielles serait colossal. Ces nouvelles IA déterministes pourraient effectuer des raisonnements et résoudre des problèmes actuellement hors de portée accélérant ainsi la réalisation de l'intelligence artificielle générale (AGI). L'AGI est définie comme une forme d'intelligence artificielle capable de surpasser les compétences humaines dans de nombreux domaines cognitifs. Grâce à la puissance de calcul quantique et à la fiabilité déterministe, cette forme avancée d’IA pourrait émerger bien plus rapidement qu’avec les approches actuelles.

Une telle évolution n’est pas sans poser une fois de plus des défis majeurs. Les questions éthiques, sociétales et de régulation vont se multiplier. Comment encadrer des IA capables de prendre des décisions précises mais dont les conséquences sur la société restent imprévisibles et potentiellement disruptives ? Il sera nécessaire de redéfinir nos systèmes de gouvernance, de régulation et d’éthique pour gérer ces nouvelles capacités technologiques sans perdre de vue les libertés individuelles et collectives. Dans une perspective prospective, l’avènement généralisé des IA quantiques déterministes bouleverserait profondément les modèles économiques, les systèmes de santé et même l’approche des problématiques environnementales. La médecine préventive deviendrait une norme grâce à des diagnostics prédictifs d’une fiabilité absolue. La lutte contre le changement climatique bénéficierait de modélisations précises des systèmes écologiques permettant ainsi des actions mieux ciblées et plus efficaces. L’éducation pourrait être personnalisée à un niveau jamais atteint auparavant et les villes intelligentes pourraient gérer leurs ressources avec une efficacité maximale.

Enfin, cette transition technologique nécessitera également une profonde réflexion philosophique sur la place de l’humain dans une société dominée par des machines déterministes. La rationalité absolue des IA quantiques nous poussera à reconsidérer ce qui nous rend fondamentalement humains : notre capacité à gérer l’incertitude, notre créativité et notre sens éthique ? À terme, il est probable que le rôle de l'humain évolue vers celui de garant des valeurs ... Le défi est immense et urgent.

Chroniques du futur : Le bug du jugement (2045)

Un tribunal entièrement automatisé sans juges et sans avocats. Juste des données, des antécédents et des corrélations. Un jour, un vieil homme entre. Il ne correspond à aucun profil tout simplement du fait de son absence de passé digital donc aucune traçabilité. Le système plante. L’algorithme demande une pause.

Ce que personne n’avait prévu, c’est l’émergence d’une question simple mais destructrice : “Et s’il était innocent malgré l’absence de données ?”

Le bug se propage dans tous les systèmes de justice automatisée. On parle de “crise de la preuve”. Le mot “doute” redevient à la mode.

Bonnes métamorphoses ! Et bon été.

Stéphane