#103 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

L’avènement du « Dead Internet » Après le smartphone Penser autrement

Bonjour à toutes et tous,

Dans cette newsletter, vous trouverez deux articles certes longs mais avec l’intention de m’être en perspective nos futurs :

L’avènement du « Dead Internet »

Après le smartphone

Penser autrement

Bonne lecture.

Stéphane

L’avènement du « Dead Internet »

Discussion audio sur la base de cet article réalisée avec NotebookLM

La formule claque comme un titre de science-fiction et circule bel et bien dans les cercles technophiles et médiatiques depuis plusieurs années. Et si Internet, tel que nous l’avons connu, était déjà mort ? Une disparition progressive des traces humaines noyées sous des flots de contenus générés par des intelligences artificielles et des armées de bots. La théorie n’est pas nouvelle. Dès 2021, certains analystes avaient déjà mis en garde : la majorité du trafic sur le web ne viendrait plus des humains mais de scripts automatisés. Aujourd’hui, le débat revient en force. Sam Altman (patron d’OpenAI) a récemment relancé l’idée en affirmant que Twitter (ou plutôt X) compterait désormais plus de bots que de véritables personnes actives. À l’heure où l’IA générative se banalise, le doute s’installe : surfons-nous encore dans un espace d’échanges humains, ou dans un décor peuplé d’ombres numériques qui se parlent entre elles ?

La première réaction serait de hausser les épaules : que des bots se balancent des torrents d’insultes ou d’images absurdes sur Facebook ou TikTok, après tout, cela ne change pas fondamentalement nos vies. Mais là où la question devient sérieuse, c’est quand ces entités artificielles franchissent la frontière du divertissement pour s’infiltrer dans les médias traditionnels. Exemple frappant : en 2023, une mystérieuse journaliste du nom de Margaux Blanchard est parvenue à publier dans des titres aussi sérieux que Wired et Business Insider alors qu’elle n’existait pas physiquement. Derrière ses textes bien ficelés se cachait une IA habilement maquillée en plume humaine. Elle a dupé des rédactions entières pendant plusieurs semaines. Cela montre à quel point les garde-fous de l’information peuvent vaciller quand l’algorithme se déguise en journaliste.

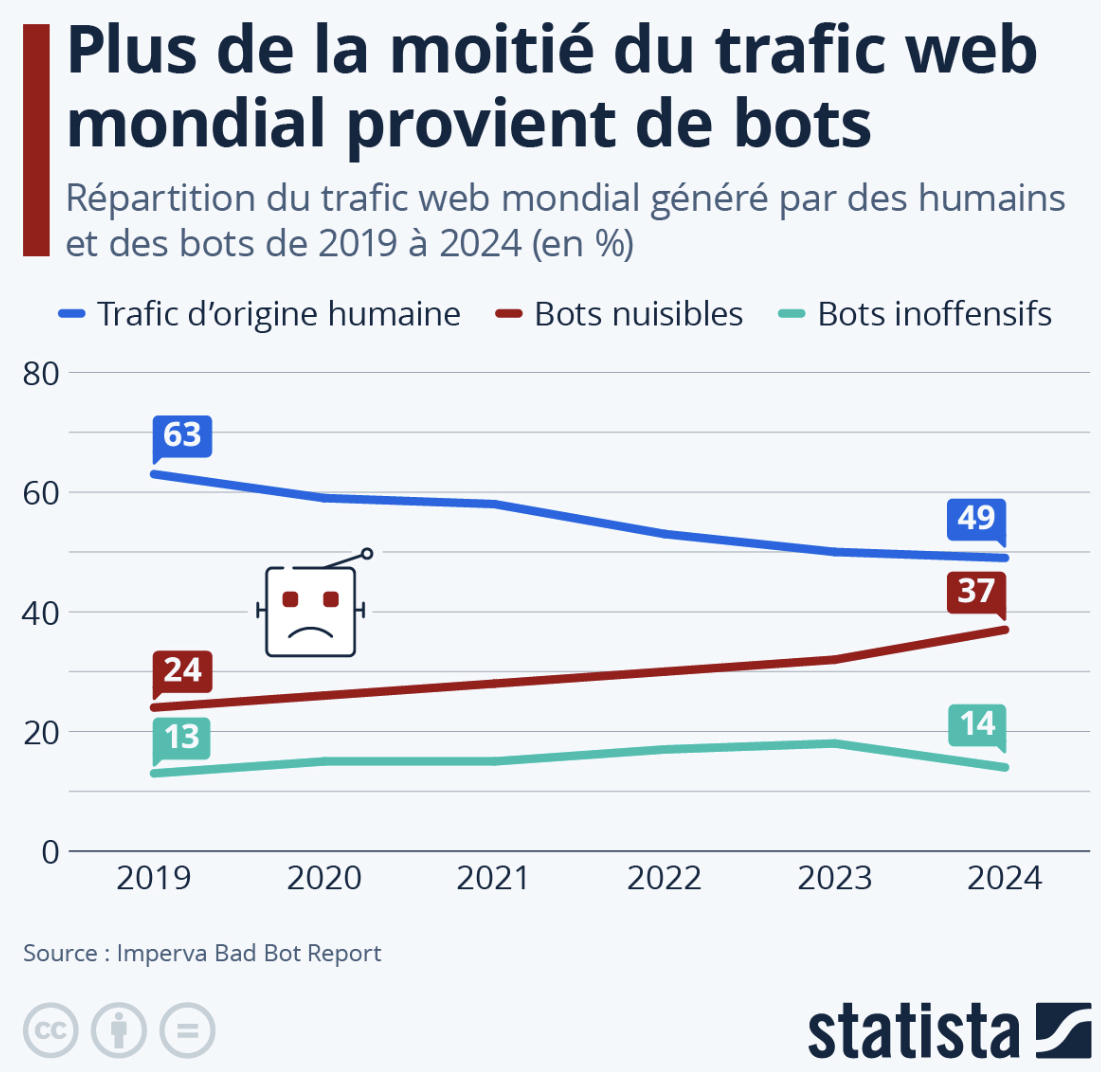

Au-delà de ces anecdotes, les chiffres parlent comme le montre ce graphique.

Les signaux se multiplient :

Armées de comptes automatisés : réseaux sociaux saturés de faux profils qui likent, commentent et partagent entre eux.

Contenus répétitifs : vidéos clonées, textes recyclés par IA, boucles infinies d’articles qui n’apportent plus rien.

Écosystèmes autonomes : certains forums ou espaces semblent désormais alimentés quasi exclusivement par des machines, qui se répondent entre elles dans une simulation grotesque de la vie sociale.

Le résultat ? Une impression grandissante chez les internautes de tourner en rond, de lire les mêmes phrases mille fois ce qui fait perdre le goût d’échanger.

Attention, la thèse radicale d’un Internet déjà entièrement « mort », c’est-à-dire vidé de toute activité humaine, reste controversée. Des chercheurs rappellent que les humains restent bien présents, et que ce sont souvent eux qui, en quête de visibilité, adoptent les comportements mêmes des bots : répétition, automatisation, recherche du buzz, .... Autrement dit, nous ne sommes pas que victimes car nous participons à cette zombification du réseau. Le danger le plus profond ne réside peut-être pas dans la présence des bots en soi mais dans la perte de repères qu’ils engendrent. Comment distinguer une opinion humaine d’une phrase générée en masse ? Comment faire confiance à une source, quand même les médias les plus sérieux peuvent être trompés ? Cette confusion change notre rapport à la vérité. Elle mine la confiance collective. Elle encourage le cynisme : si tout peut être fake, pourquoi chercher à vérifier ? Et ce cynisme profite évidemment aux marchands de doute, qu’ils soient politiques ou commerciaux.

Face à ce constat, certaines voix avancent une idée surprenante : rendre Internet payant pour les bots et gratuit pour les humains. Autrement dit, rétablir une barrière économique : si tu es une IA qui veut inonder la toile de contenus, tu dois payer. Si tu es un humain qui veut s’exprimer, tu restes libre. L’idée a du charme. Elle renverse la logique actuelle où l’humain paye (par ses données, son attention, parfois son argent), tandis que la machine prolifère gratuitement. Mais sa mise en œuvre soulève plusieurs écueils du fait d’une détection incertaine, d’un risque d’exclusion et évidemment d’une amélioration continue des IA.

Peut-être que le terme « Dead Internet » est exagéré même si il a le mérite de mettre en lumière une tendance bien réelle. Ce qui est certain, c’est que nous entrons dans une nouvelle ère : celle où la vigilance critique devient aussi importante que la maîtrise technique. Vérifier ses sources, apprendre à repérer les signaux artificiels, exiger de la transparence des plateformes, … Voilà les gestes de survie numérique. Internet ne mourra sans doute pas d’un seul coup comme un personnage de série qu’on efface du scénario. Il risque de se transformer en décor de carton-pâte peuplé de figurants numériques. À nous de choisir si nous voulons rester spectateurs passifs de ce théâtre d’ombres, ou reprendre la main.

Et au fond, il y a une ironie : si le « Dead Internet » existe, il ne sera pas vraiment mort. Il sera simplement peuplé d’une forme de vie artificielle et algorithmique mais bien vivante à sa manière. Une vie qui, comme toujours, nous obligera à nous adapter, à inventer, à défendre ce qui nous rend humains.

The Next Mind Tips and tricks

En plus de “Métamorphoses” qui continuera plus que jamais à parler des enjeux du futur, “The Next Mind Tips & Tricks” est une newsletter où vous trouverez tout ce que vous voulez savoir sur l'IA sans jamais avoir le temps : news, nouvelles IA, usages, astuces, …

Pour s’abonner, c’est sur mon profil Linkedin.

Après le smartphone

Discussion audio sur la base de cet article réalisée avec NotebookLM

Depuis quinze ans, ce rectangle de verre a colonisé nos poches, nos gestes et même nos minutes volées à l’ennui. Le smartphone a remplacé l’annuaire, l’appareil photo, la boussole, la radio et parfois la conversation. Il a tout mangé et nous avec. Pourtant, derrière cette victoire totale se dessine un paradoxe : plus le smartphone s’impose, plus s’annonce une technologie qui cherche à l’effacer. L’« après-smartphone » n’est pas la promesse d’une nouvel idole. Il s’agit plus de l’ambition d’une présence numérique diffuse, presque pudique, qui élargit nos capacités sans exiger notre regard constant. Bonne nouvelle : l’IA élargit indubitablement le champ humain. Mieux : nous ne sommes pas dotés d’une seule intelligence mais de multiples, capables de se mélanger, d’échanger et de s’ajouter. Mauvaise nouvelle : notre inertie adore ses écrans. Alors, comment bascule-t-on d’une ère d’addiction visuelle à une ère d’outils invisibles ? Ni par décret, ni par miracle, mais par étapes successives, souvent décevantes au début, puis évidentes après coup.

Les prochaines étapes : feuille de route vers l’invisible

L’après-smartphone ne sera pas un soir d’élection. Pas de « One more thing » qui, d’un claquement de doigts, enverrait l’iPhone au musée. Il faut penser « décennie » et non « keynote ». Trois temps s’entrecroisent.

Le court terme (aujourd’hui) : le smartphone, toujours roi… escorté.

Nous entrons dans une phase d’appoint. Le téléphone reste le centre de gravité mais il s’entoure d’une garde rapprochée : casques de « spatial computing », lunettes connectées, écouteurs plus intelligents, bagues et montres qui savent payer, identifier, notifier, .... Apple a dégainé son Vision Pro, coûteux et volumineux, certes, mais porteur d’un vocabulaire nouveau à savoir celui d’écrans qui ne sont plus des écrans, d’une informatique qui s’accroche à l’espace plutôt qu’à un rectangle. Meta continue d’explorer des lunettes à la fois lookées et “utiles”, avec un assistant IA discret au coin de l’oreille. D’autres misent sur des briques XR sous Android, pendant que se chuchotent des terminaux « nativement IA » pensés autour de la conversation homme-machine plutôt que de l’application. Est-ce déjà l’après ? Non. Mais ceux sont les frémissements.

Le moyen terme (2025-2030) : le point de bascule.

La miniaturisation travaille pour nous. Les écrans microLED, les batteries plus denses, les processeurs sobres, la compression des modèles d’IA sur l’appareil (Edge AI) : tout conspire à rendre « portable » ce qui, hier, relevait du laboratoire. Vers la fin de la décennie, des lunettes « quasi normales (pas de gros arceau futuriste, pas d’œil rouge de cybor, …) pourraient émerger. Les assistants IA deviendront des co-équipiers persistants : vision, langue, contexte, mémoire courte, tout se combinera. Les interfaces gestuelles fines, type EMG au poignet, amorceront le remplacement du clavier/souris par un langage micromoteur (le geste minuscule devient clic et la pression devient glisser). À ce stade, l’attention bascule. Les plus jeunes, socialisés au « mains libres » et au « tête haute », jugeront le smartphone… encombrant. Comme le PC fixe avant lui.

Le long terme (après 2030) : la « calm technology ».

Plus la technologie mûrit, plus elle s’absente. Des lentilles AR ? Peut-être. Des implants pour usages médicaux qui, par ricochet, avancent la question d’interfaces cérébrales ? Probablement. Mais l’important n’est pas la science-fiction : c’est la discrétion. L’ordinateur se dissout dans l’environnement, devient l’eau courante de l’information : omniprésent, rarement visible, jamais tyrannique (je l’espère). L’enjeu philosophique est là : renverser l’économie de l’attention que l’écran capture vers une économie de la pertinence que l’assistant filtre.

L’inertie du présent

Il y a un désert entre une bonne idée et une nouvelle habitude. Pour preuve, un bon nombre d’objets « post-téléphone » s’y sont perdus. Pourquoi ?

On a vu passer des broches vocales censées remplacer l’écran, des « mini-assistants » au design séduisant mais à la latence irritante, des appareils trop chers pour ce qu’ils faisaient et pas assez fiables pour ce qu’ils promettaient. La leçon est nette : pour qu’un substitut prenne, il ne suffit pas d’être différent, il faut être supérieur. Plus rapide, plus sûr, plus cohérent ou radicalement plus simple. Sinon, retour au téléphone en dix secondes. La physique n’ai pas du marketing. Loger une caméra, un modem cellulaire, un SoC, un système optique et une batterie d’une journée dans des lunettes légères, c’est une équation complexe à plusieurs inconnues : poids, chaleur, confort, autonomie, sécurité, ... Le moindre compromis se voit sur le nez. Même combat pour les écouteurs : excellent micro, suppression de bruit, autonomie, le tout sans transformer nos oreilles en radiateurs. Et puis il y a le réseau car pour que l’assistant réponde dans l’instant, il faut du local. Le cloud ne peut pas tout. Nous ne vivons pas seuls. Une caméra sur un visage enregistre aussi ceux qui n’ont rien demandé. L’acceptabilité passe par des normes : indicateurs lumineux d’enregistrement, modes « privacy », zones sensibles. L’esthétique compte autant que la technique et le prix doit cesser d’être un signal d’appartenance pour redevenir juste celui d’un objet utile.

Vous connaissez ce geste-réflexe ? La main qui part vers la poche alors qu’elle n’a rien à y faire. Le smartphone, c’est Pavlov en version haptique. Le « scroll infini » a son ergonomie, ses dopamines, ses routines. Passer à l’après-smartphone, c’est aussi rééduquer notre impulsion. Ne riez pas, c’est le frein le plus puissant.

Les substitutions d’usage : remplacer sans appauvrir, enrichir sans envahir

Pour qu’un écosystème prenne, il doit couvrir dépasser les six fonctions cardinales du téléphone : communiquer, s’orienter, s’informer, capturer, payer, se divertir. Voyons les chemins de substitution :

Communiquer (appels, messages) : La recette gagnante marie trois ingrédients. D’abord, l’audio : des écouteurs confortables, avec un micro irréprochable et une isolation suffisante pour murmurer dans le vent. Ensuite, l’affichage discret : lunettes ou micro-afficheurs qui épinglent dans le champ de vision un message bref, une identité d’appelant, un rappel contextuel. Enfin, l’IA conversationnelle qui structure la relation : « Résume-moi les messages de Paul, propose une réponse courte, programme une relance demain si pas de retour ». Le smartphone n’est plus qu’un terminal de secours car l’assistant est l’interface.

S’orienter (cartes, GPS) : La substitution naturelle est la réalité augmentée : une flèche dans la rue, une ligne qui s’accroche au trottoir, un nom qui flotte au-dessus d’un bâtiment, des instructions audio qui se calent sur votre rythme. Le positionnement visuel (reconnaître l’environnement pour se localiser) affine la précision. Des haptiques léger (une vibration à gauche pour tourner à gauche) complètent le tableau. Votre main reste libre, vos yeux regardent le monde, et plus l’écran.

S’informer (recherche, actualités) : Nous sortons de la « requête clavier » pour entrer dans la demande conversationnelle. On n’écrit plus « météo Paris demain », on dit « Est-ce que je prends un parapluie ? ». L’assistant comprend le contexte, la date, votre agenda. Il synthétise au lieu de vous noyer. Les lunettes jouent au pointeur : vous regardez une œuvre, une plante, un produit ; la réponse surgit là où se trouve le regard. L’information cesse d’être un flux à scroller pour redevenir une pertinence à consommer.

Capturer (photos, vidéos) : Le smartphone excelle en photo parce qu’il triche très bien (merci l’IA). Les lunettes auront des capteurs plus modestes, mais une captation sans friction : un clignement volontaire, un micro-geste, et le moment est saisi. L’IA triera, dédoublonnera, stabilisera, choisira la meilleure frame, proposera une légende, construira des souvenirs plutôt que des galeries. L’éthique sera non négociable : capture visible, modes « no cam », respect des contextes (école, réunion, espace privé). Sans cela, pas d’acceptation possible.

Payer (transactions, authentification) : La montre, la bague, la carte virtuelle au poignet. La chaîne existe déjà. Demain, la biométrie multimodale (voix, iris, geste) sera le sésame, avec un calcul local et une preuve cryptographique. L’écosystème après-smartphone ne prendra que s’il peut exister sans son ancêtre.

Se divertir (musique, vidéo, jeux) : La musique se prête naturellement au « mains libres ». Pour la vidéo, deux voies : des écrans virtuels à taille variable (le salon dans le train) et des micro-écrans personnels pour la discrétion. Le jeu, lui, s’évade : la réalité augmentée transforme la ville en plateau. Attention toutefois à ne pas avoir de retour du « scroll infini » déguisé. L’après-smartphone réussira s’il décélère l’attention plutôt que de la fracturer.

Les briques techniques

L’après-smartphone reposera sur un faisceau de briques qui doivent obligatoirement mûrir ensemble.

L’IA embarquée (Edge AI). Moins d’aller-retour au cloud et beaucoup plus de calcul local. Pourquoi ? Pour la latence (la réponse dans le geste), pour la confidentialité, pour la résilience (ça marche dans l’ascenseur). Des modèles compressés, quantifiés, spécialisés, qui apprennent votre contexte sur l’appareil. Le cloud gardera le rôle du « grand cerveau » (mise à jour, tâches lourdes), mais l’interaction quotidienne doit se jouer « à domicile ».

L’AR « civile ». Oublions les casques de science-fiction et parlons port quotidien. Champ de vision suffisant, luminosité extérieure, verres correcteurs, confort esthétique. L’AR doit devenir un vernissage d’information : fine, économe, pertinente. Un affichage envahissant est un anti-usage.

L’interface gestuelle et neuronale légère. Avant les implants, il y a les interfaces non invasives : EMG au poignet (lire l’intention dans le micro-signal des muscles), suivi oculaire discret, clic par pression digitale. Ce langage micromoteur doit être apprenable et cohérent. L’erreur fatale serait de réinventer cent gestes par marque. L’ambition consiste à avoir un alphabet commun.

La constellation d’objets. Une montre qui sait payer et mesurer, des écouteurs qui entendent et répondent, des lunettes qui affichent et capturent, une bague qui authentifie : l’« ordinateur personnel » devient personnel au pluriel. La difficulté n’est pas d’assembler des gadgets mais de bien de synchroniser des rôles : qui parle ? qui écoute ? qui vibre ? quel appareil prend la main selon la situation (réunion, conduite, sport, nuit) ? L’orchestration est la vraie innovation.

Une économie des usages et gouvernance

Quelle application fera tomber la domination du smartphone ? est une mauvaise question. L’histoire montre rarement une « app » solitaire gagnant la guerre. Penchons-nous plutôt sur des “pochettes surprises” d’usages qui ensemble inversent la préférence.

Le filtre attentionnel : moins d’alertes, mais toutes pertinentes ; des résumés contextuels ; un assistant qui dit « je l’ai géré » aussi souvent que « tu dois regarder ».

La coprésence utile : traduction simultanée en rendez-vous, sous-titres dans l’air, signaux faibles dans une réunion (« tu as promis de revenir sur ce point »).

La main libre : courir, cuisiner, bricoler, conduire, tout en conversant avec son système d’information.

Le tête-haute : carte, rendez-vous, nom, rappel—là où l’œil regarde, pas sur un écran au fond de la poche.

Isolés, ces gains paraissent modestes. Ensemble, ils fabriquent une préférence cumulative. Un matin, on part sans téléphone « pour voir ». Un mois plus tard, on le prend « par sécurité ». Un jour, on l’oublie sans panique. Le basculement, c’est ça. Et évidemment, cela doit s’accompagner d’une gouvernance responsable avec à minima :

Transparence par design. Un signe visuel d’enregistrement, une LED non désactivable, des zones « no cam » reconnues automatiquement. Les utilisateurs doivent pouvoir savoir, contrôler, désactiver sans faire une thèse en cybersécurité. L’ergonomie de la vie privée n’est plus un luxe : c’est un prérequis.

Sûreté et sobriété. Qui dit calcul local dit sécurité locale : chiffrement matériel, séparation des domaines (ce que voit la caméra ne va pas directement « dehors »), mises à jour garanties. Et puis l’énergie : la sobriété est une fonction, pas une option. On ne sauvera pas l’attention générale en brûlant des watts particuliers.

Interopérabilité raisonnée. Si l’après-smartphone recrée des jardins fermés, il échouera. Les standards d’interaction (gestes, permissions, formats de notification) devraient converger. La compétition peut porter sur la qualité d’exécution, pas sur l’illisible.

Un écosystème ne se construit pas seulement dans les labs des géants. Trois chantiers publics et pragmatiques accéléreraient une transition saine : des normes de signalement et zones sensibles, des incitations à l’Edge AI et à l’éco-conception et comme déjà dit, une interopérabilité des gestes et des permissions.

S’il y a une erreur à ne pas commettre, c’est de croire que l’après-smartphone serait le règne d’une normalité technologique uniforme. L’IA se nourrit encore d’une vision monolithique du monde : mêmes app stores, mêmes parcours, mêmes métriques, …. Or l’enjeu est précisément inverse : réhabiliter la différence. Il faut des systèmes qui apprennent nos idiosyncrasies : rythmes, handicaps, préférences, styles cognitifs, ... L’assistant doit être un moyen d’augmenter la multiplicité humaine et surtout pas de la lisser. Ce n’est pas un détail éthique, c’est un gain d’efficacité car un outil adapté augmente la puissance d’agir alors qu’un outil standardisé augmente la frustration et tue la création.

Faut-il enterrer le smartphone ? Non. Le remercier, oui. Il a bien travaillé. Il continuera d’exister, comme le PC existe encore. Mais son hégémonie vacille. L’horizon 2025-2035 ressemble à une décennie charnière. Le véritable enjeu n’est pas de « tuer » un objet, mais de réordonner nos interactions en remettant l’information dans le monde et notre attention au centre. Si nous réussissons, nous gagnerons un luxe rare : regarder à nouveau autour de nous sans perdre l’accès au numérique. Si nous échouons, nous aurons simplement déplacé le même appétit d’attention sur un autre support. L’après-smartphone est un enjeu culturel. Il demande d’embrasser l’avenir sans mépriser le présent, d’accepter la complexité sans se réfugier dans la nostalgie, d’exiger la simplicité sans basculer dans la naïveté. Les paris sont lancés. Qui imposera la vision dominante de notre futur numérique ? Les géants ont des ressources, les startups ont des idées, les laboratoires ont du temps et nous, nous avons la chose la plus précieuse : la capacité de choisir. Choisir des outils qui respectent nos vies plutôt que de les vampiriser. Choisir des normes qui protègent plutôt que des habitudes qui s’installent. Choisir, enfin, d’adapter la technologie à la pluralité humaine et non l’inverse.

L’après-smartphone n’arrivera pas d’un coup. Il s’installera. D’abord dans la marge, ensuite dans l’évidence. Un jour, nous comprendrons rétrospectivement que le centre de gravité de notre vie digitale a glissé : moins d’écran, plus de monde, moins de gestes réflexes, plus d’intentions, moins d’uniformité, plus de différences assumées. Ce jour-là, nous rirons de notre ancienne compulsion à vérifier l’heure… sur un objet que nous tenions dans la main.

Pour célébrer la rentrée, vous disposez de 20 € de réduction à partir de 50 € d’achat sur mon site avec le code 20 !

Pour commander, il suffit de cliquer là ! ou sur vos sites ou librairies préférés.

Penser autrement

Discussion audio sur la base de cet article réalisée avec NotebookLM

Notre logiciel mental aime les lignes droites et les fictions bien rangées. Le réel, lui, avance en boucles et en réseaux, avec des délais qui mordent, des effets rebonds qui se vengent et des émergences qui surprennent. Sommes nous inadaptés à la complexité de notre univers ? Est ce que l’IA peut nous aider en la matière ? Cette tribune propose une boussole pour celles et ceux qui ne veulent pas abandonner et même se développer.

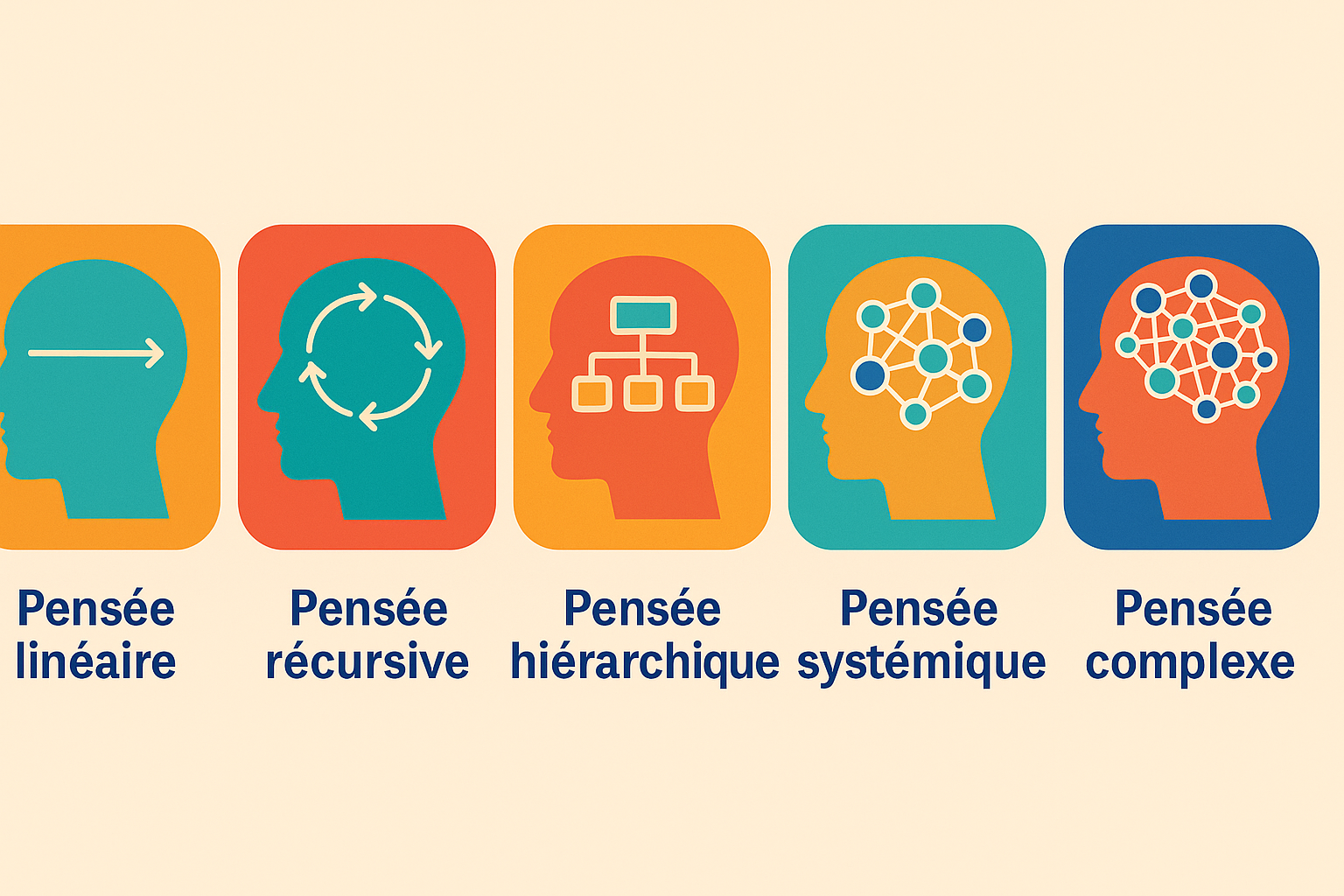

Cinq manières de penser

Pensée linéaire. Chaîne A puis B puis C. Utile pour dérouler un protocole et simplifier. La pensée linéaire est un processus de réflexion systématique qui progresse par étapes successives, organisant la logique de manière séquentielle pour résoudre des problèmes simples ou comprendre un sujet en le décomposant en parties distinctes. Connue aussi comme la pensée convergente ou verticale, elle se caractérise par sa logique, sa rationalité et son application de règles. Les humains l’adorent car elle est simple. Les discours politique en regorgent.

Pensée récursive. La sortie revient en entrée. C’est l’ADN de l’apprentissage par renforcement et des habitudes humaines. Un comportement réussit, il se renforce. Une erreur se répète, elle s’installe. Sans garde-fou, la boucle s’enferme. Le biais d’origine prend du muscle. Le modèle surapprend. Pour sortir de l’ornière, il faut un signal extérieur ou une exploration forcée.

Pensée hiérarchique. Arbre, niveaux, silos. La pensée arborescente décrit un mode de pensée foisonnant et créatif où chaque idée se ramifie en de multiples sous-idées, créant des réseaux d'associations et d'analogies qui se déploient simultanément. On y gagne en justesse, en clarté des responsabilités et en latence contrôlée dans les opérations. On y perd la vision transversale du fait de nos capacités cognitives.

Pensée systémique. Interactions, rétroactions, stocks et flux, délais explicites. La pensée systémique est une approche qui permet de comprendre un phénomène en le considérant comme un système complexe d'éléments interconnectés plutôt qu'en se concentrant sur les parties isolées. Elle favorise une vision globale, identifie les interdépendances, les boucles de rétroaction et les dynamiques à l'œuvre, afin de mieux résoudre des problèmes complexes, de favoriser des changements constructifs et de concevoir des solutions durables. . Toute intervention déplace plusieurs curseurs à la fois car tout est lié.

Pensée complexe. Systèmes adaptatifs, incertitudes irréductibles, propriétés émergentes. La pensée complexe, concept épistémologique développé par Edgar Morin, est une manière de penser le monde qui affronte la complexité de la réalité, en reliant les savoirs et en reconnaissant l'interdépendance des phénomènes au lieu de les réduire à des explications simplistes. Elle se caractérise par une approche holistique, qui permet de comprendre les systèmes dans leur globalité en intégrant les différentes perspectives et interactions, et en acceptant l'incertitude, l'erreur et le risque inhérents à la vie.

Simple ne signifie pas simpliste. La clarté s’obtient après exploration et réduction. Pas avant.

Pourquoi ?

Le cerveau économise ses calculs. Il convoque narration courte et cohérence immédiate. Biais de confirmation au premier rang, illusion de contrôle en coulisse et aversion à l’ambiguïté sur toute la ligne. L’école récompense souvent la réponse binaire. Les médias pressent le propos. Les réseaux promouvront la phrase qui frappe. Nous vivons à la journée et au trimestre, rarement à l’échelle des décennies. Au moindre bruit, le mental se rabat vers la droite bien rassurante. La complexité est bannie. Les incitations électorales favorisent la promesse courte et l’effet visible avant la prochaine échéance. Les récits monocausaux s’installent. Grâce à telle loi, tout ira mieux. La mesure phare se vend simplement. Les métriques totems occupent l’écran. Un seul nombre, un seul taux, un seul seuil. La loi de Goodhart (Elle s'exprime simplement ainsi : « Lorsqu'une mesure devient une cible, elle cesse d'être une bonne mesure . » Autrement dit, lorsqu'on se fixe un objectif précis, on tend à l'optimiser, quelles qu'en soient les conséquences.) n’attend que cela. La tentation grandit de réduire le système à une poignée de curseurs. Le problème que quand tout devient réseau, la responsabilité se dilue et la décision cherche un coupable. On simplifie pour agir. On échoue à absorber les chocs et la politique publique finit fragile.

Santé publique. Un pays hésite entre oui et non sur une mesure unique. Pourtant un mix fondé sur les risques aurait réduit la facture. Ventilation dans les lieux clos, masques ciblés pour populations vulnérables, seuils d’alerte locaux adossés à des données publiques. Faute de stratégie systémique, la trajectoire devient une oscillation. Le public se lasse et la confiance s’étiole.

Climat et énergie. Le débat adore la solution miracle comme une supposée technologie censée tout régler. La bonne approche ressemble davantage à un portefeuille d’options. Production locale et centrale, stockage court et long, gestion de la demande, gouvernance du réseau, tarification dynamique. Sans analyse des intermittences, l’investissement part dans le décor et le vivant avec.

Information en ligne. La rumeur courte gagne la course. La correction, plus nuancée, arrive toujours trop tard. Les bulles cognitives se soudent. La décision publique se replie vers l’horizon des prochaines semaines. La pensée linéaire rend le faux plus séduisant, car il tient en une phrase quand le vrai exige au mieux un paragraphe.

Quand les autres pensées gagnent

Mobilité urbaine. Beaucoup ajoutent des voies et récoltent plus de trafic. Le phénomène de trafic induit n’a rien d’une opinion. Une métropole décide de mélanger plusieurs leviers. Tarification selon l’heure et la zone, réallocation fine de l’espace, transport partagé, urbanisme de proximité, synchronisation des feux après observation terrain et collecte ouverte de données. Au bout de deux ans, la vitesse moyenne ne s’effondre pas malgré l’augmentation de la demande. Les nuisances reculent près des écoles. Les commerces voient revenir une clientèle à pied.

Chaînes d’approvisionnement. L’obsession zéro stock a fait illusion. Une entreprise de taille moyenne change de stratégie. Elle construit un simulateur multi agents, introduit des stress tests réguliers et accepte des stocks tampons adaptatifs. Les actionnaires grimacent puis observent une marge moins volatile.

Feux de forêt. Les avions restent utiles mais ils ne suffisent pas. L’approche systémique assemble mosaïque d’usages des sols, brûlages préventifs en bonne saison, capteurs rapides, éducation dans les zones sensibles. Cela conduit à une intensité moindre lors des pics de chaleur et une fenêtre d’action plus large pour les équipes au sol.

Éducation. Le réflexe ajoute des heures de maths. Des équipes expérimentent un autre mix. Feedbacks fréquents, parcours adaptatifs, projets transverses. On mesure les progrès plutôt que la seule photo des notes. On observe des transferts de compétences entre disciplines. Le dispositif encaisse les aléas et continue d’apprendre.

Diversité de leviers, boucles de feedback et apprentissage continu forment le trio gagnant.

Et l’IA dans tout ça ?

Les architectures de pensée et celles des machines se renvoient la balle. Linéaire correspond à programmation déterministe. Si A alors B ce qui est très utile pour un protocole de sûreté. Récursive fait penser à l’apprentissage. Itérations, exploration et exploitation qui s’équilibrent. Hiérarchique rappelle l’arbre de décision, les heuristiques par niveaux et les architectures en couches. Systémique dialogue avec les graphes, les réseaux, les systèmes dynamiques. On pense réseaux neuronaux sur graphe, modèles à stocks et flux, assimilation de données par filtres de Kalman ou variantes plus robustes. Complexe évoque multi agents, modèles du monde, recherche de politiques sous incertitude profonde, approches de type Monte Carlo et planification par scénarios.

Les cerveaux qui aiment la ligne droite posent des problèmes linéarisés. Les algorithmes amplifient alors ce travers. L’inverse reste à notre portée. Situez les relations, explicitez les délais, cartographiez les rétroactions. La machine peut élargir notre intuition plutôt que la caricaturer. L’IA ne sauve ni ne damne. Elle grossit nos erreurs comme notre lucidité.

IA scientifique. De quoi parle t on

Il s’agit d’une union entre méthodes d’IA et démarches scientifiques. On combine modèles mécanistes quand ils existent avec apprentissage statistique. On cherche des liens causaux, on quantifie les incertitudes et on teste des hypothèses sur des systèmes réels. Trois exigences guident ce chemin : explicabilité, réplicabilité et droit à l’échec proprement consigné. Pour ce faire, nous avons besoins de graphes causaux inspirés des approches de type DAG, d’inférence bayésienne avec hiérarchies explicites, de jumeaux numériques pour territoires ou hôpitaux, de simulations multi agents pour politiques publiques, analyse contrefactuelle, validation croisée sur des données indépendantes et de temps. On favorise les modèles hybrides (une partie explique et l’autre ajuste). La séparation nette entre boîte blanche et boîte noire devient moins utile que leurs échanges.

Exemple dans la santé. Identification de combinaisons de risques multi factoriels non linéaires et exploration de politiques de prévention réalistes à l’échelle d’un quartier grâce à des jumeaux numériques régionaux pour tester plusieurs possibilités, puis sélection par robustesse et non par score unique. Il en va de même pour la désinformation : cartographie par communautés, détection des ponts et expérimentation de stratégies de “vaccination informationnelle” avec mesure avant et après sur cohorte témoin.

Pour contrer les infox et le déni, l’IA peut nous aider dans la complexité :

Premier levier. Cartographier l’écosystème d’information. Qui parle à qui, où se trouvent les passerelles, quels comptes jouent le rôle de super diffuseurs. La cartographie fait jaillir des cibles efficaces que personne ne voyait, souvent des ponts discrets plutôt que les bastions très visibles.

Deuxième levier. Détecter les erreurs structurelles. Corrélations trompeuses, métriques qui se détraquent, modèles qui apprennent trop bien le passé et trébuchent sur le futur. Un audit sérieux identifie variables confondantes, surajustement et erreurs d’échantillonnage. Une fois assainie, le débat gagne en honnêteté.

Troisième levier. Ouvrir la boîte. Pourquoi tel résultat sort. D’où viennent les données. Quelle incertitude l’entoure. Une figure simple avec intervalles crédibles vaut mieux qu’une rhétorique brillante. Le public n’exige pas des équations. Il veut savoir ce que l’outil sait et ce qu’il ignore.

Quatrième levier. Fabriquer des scénarios testables. Si une mesure s’applique, quelle est la trajectoire probable. Si elle échoue, comment apprendre vite. Cette approche suppose des institutions apprenantes. Gouvernance claire des données, audit de modèles, itérations rapides, droit d’arrêt quand un indicateur part de travers.

L’IA n’épargne pas la politique et elle devrait l’éclairer. Jamais elle ne doit trancher des choix de société sauf si nous acceptons de perdre notre libre arbitre. N’oubliez jamais que les biais et les données pèsent lourd. Un écosystème d’information bancal engendre des modèles bancals. La diversité des sources et la mise en place de garde fous sont indispensables. La souveraineté et l’éthique demandent gouvernance, redevabilité et contrôle humain. Les systèmes complexes surprennent, il faut donc prévoir et se préparer à être surpris. C’est une discipline.

Alors ?

Sans prétendre avoir raison, voici cinq conseils pour dépasser nos limites :

Former au systémique avec des cas vivants. Boucles de rétroaction, délais, effets rebonds. Des exercices réguliers sur vos propres données vous permettront de mettre la machine en route.

Outiller les équipes. Tableaux de bord multi indicateurs, cartes de causalité évolutives, revues bimensuelles des hypothèses. La discussion doit glisser des opinions vers les mécanismes. On gagne du temps et on évite les quiproquos coûteux.

Institutionnaliser l’expérimentation. Pilotes, tests comparatifs publics, clauses de revoyure, droit à l’erreur documenté. Une erreur décrite avec précision devient un savoir transmissible. Une erreur masquée est destructrice.

Positionner l’IA au bon endroit. Simulation et scénarios, détection de signaux faibles, explicabilité. Jamais en remplacement du débat mai au contraire en appui pour l’élever.

Raconter mieux. Métaphores justes, visualisations soignées, récits qui donnent envie de revoir son avis. La nuance se propage que quand l’histoire tient debout.

La belle histoire simple a longtemps battu la réalité complexe. Cette époque s’achève en tout cas je l’espère. On peut muscler nos façons de penser. L’IA joue l’entraîneur exigeant quand elle se fait scientifique. Elle vous force à nommer les hypothèses, à expliciter les mécanismes et à accepter l’incertitude utile. Votre nouvelle gymnastique consiste à passer de la droite au réseau, du contrôle à l’apprentissage et de la certitude à l’essai loyal. L’IA élargit nos capacités. Les intelligences humaines restent au centre. Elles gagnent en puissance quand on les exerce avec méthode. Aujourd’hui est un magnifique jour pour commencer.

Bonnes métamorphoses et à la semaine prochaine.

Stéphane