#98 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

Géopolitique de l’IA aujourd’hui et demain Est ce que l’IA rend débile ? Chroniques du futur

Bonjour à toutes et tous,

Au menu cette semaine :

Géopolitique de l’IA aujourd’hui et demain

Est ce que l’IA rend débile ?

Chroniques du futur

Stéphane

Géopolitique de l’IA aujourd’hui et demain

Aujourd’hui la ruée ne vise plus l’or ni le charbon. Elle se jette sur la puissance de calcul, sur des modèles aux noms d’animaux mythiques et sur des jeux de données qui valent davantage qu’un puits de pétrole texan. Partout la même question : qui tiendra la manette lorsque l’intelligence prendra racine hors du crâne humain ? Aux États‑Unis, des clusters bardés de GPU font ronfler leurs ailettes au fond de l’Iowa, tandis que Pékin bétonne des datacenters dans la banlieue de Tianjin. Bruxelles, elle, aiguise son AI Act et Londres s’enivre de l’idée d’un « Bletchley moment ». Les voyants clignotent et les sirènes grondent. La géopolitique de l’IA est une partie d’échecs disputée sur un plancher savonné.

Les laboratoires de recherche

Washington aime toujours compter et prend beaucoup de plaisir à dénombrer désormais ses modèles d’IA comme elle recensait jadis ses bombardiers. Quarante « frontier models » américains l’an passé, quinze pour Pékin, trois pour l’Europe, … Les chiffres claquent mais la bataille se niche dans la nature même des armes. À San Francisco, les ingénieurs d’OpenAI baptisent leurs créations avec des noms de navires futuristes, à Shenzhen, DeepSeek choisit des références taoïstes et place la notion d’harmonie au cœur des architectures. Les deux rivaux se toisent convaincus chacun de posséder l’acier le plus tranchant. Pourtant la qualité et la quantité n’habitent jamais le même fourreau. Les brevets américains reçoivent sept fois plus de citations preuve d’une avance conceptuelle tandis que la Chine arrose le terrain avec soixante‑dix pour cent des nouveaux dépôts mondiaux qui viennent de ses provinces. On dirait deux boxeurs, l’un muscle sec et coup de poignet, l’autre puissance brute et allonge interminable.

La recherche épouse les flux des capitaux. 150 milliards de dollars privés pour la R&D IA en 2024 dont cent neuf absorbés par la Silicon Valley et ses satellites. À l’est, le MITI chinois réplique avec d’immenses fonds provinciaux. Le Royaume‑Uni arrive avec des miettes et parie sur l’open science.

Sur un tableau blanc à Stanford, une professeure ne peut que constater que les coûts d’inférence ont baissé de 90% en deux ans. Sa conclusion fuse. L’IA se démocratise et par conséquence le contrôle se complique. Washington pense dérégulation, Pékin préfère des licence préalable et l’Europe rédige des annexes. Au cœur du tumulte, un doctorant brésilien compile les datasets plurilingues qui permettront demain de chuchoter en tupi‑guarani aux oreilles de GPT‑5. La guerre froide mathématique se joue désormais sur le terrain des langues rares.

Pour flairer l’esprit du temps, il faut visiter un hackathon nocturne à Bucarest. Des étudiants ajustent Mistral 7B sur un laptop, bannières Ikea en guise de nappes avec du café soluble comme carburant. 180 milliards de paramètres tiennent dans un sac‑à‑dos. Voilà le vrai défi stratégique : l’arme devient portable. Un État peut toujours verrouiller l’export des H100 de NVDIA, il ne musèlera pas la débrouille de ces mains anonymes.

Les cartes se redistribuent aussi sous la table. Meta libère LLaMA pour amadouer les régulateurs et OpenAI promet son propre open source tout en gardant les joyaux payants derrière un portail API dont le tarif baisse toujours plus. Les économistes s’interrogent : comment valoriser un actif qui fond comme neige au soleil quand il cesse d’être rare ?

Pendant ce temps, la scène scientifique se coule dans un nouveau roman picaresque. Un chercheur français troque son poste CNRS contre un visa O‑1 pour « extraordinary ability ». Il atterrit à Menlo Park, signe un NDA épais comme l’annuaire téléphonique des années quatre‑vingt et se découvre voisin de paillasse avec une doctorante de Tsinghua recrutée la veille. Cette polyphonie fait la force des géants mais nourrit aussi les soupçons : volatilité des talents, fuite des cerveaux, espionnage soft, ... Dans les coulisses on entend déjà grincer la porte des comités de sécurité nationale. Un général à la retraite soulève la question. Si l’on classe un modèle parmi les secrets défense, comment empêcher son équivalent open source d’apparaître six mois plus tard ? Silence gêné dans l’amphithéâtre. L’asymétrie des filières rappelle l’alambic d’un contrebandier, interdire la recette n’interdit en rien la distillation.

L’IA n’est plus un domaine académique, c’est devenu une lutte de pouvoir sans merci où le contrôle des éléments promet une hégémonie indiscutable mais même l’Invincible Armada a fini par talonner un récif inattendu.

Quand la loi se fait frontière mobile

Imaginez un match de rugby disputé sur un terrain en mouvement dont les poteaux migrent au rythme des plaques tectoniques. Voilà le paysage réglementaire de l’IA. Bruxelles a inscrit l’AI Act au Journal officiel. C’est le premier code global qui classe les systèmes par risques gradués. On y lit des interdictions nettes comme la notation sociale automatisée mais aussi des passages assouplis pour les « modèles de fondation ». L’UE est fière à juste titre de jouer l’arbitre mais les compétiteurs jouent déjà hors des limites.

À Washington, l’exécutif favorise les Executive Orders qui sont plus rapides qu’un débat parlementaire éternel. L’ordonnance d’octobre deux mille vingt‑trois exige des tests de sécurité pour tout modèle lourd. En réalité rien ne lie juridiquement les créateurs. Ils craignent tout au plus la perspective d’être rappelés au Congrès pour un grand show télévisé. On pratique la régulation performative. Plus récemment, Donald Trump souhaite tout simplement mettre un moratoire sur toute initiative juridique des Etats laissant les géants de la technologie sans contre-poids.

Londres adopte des « principes pro‑innovation » confiés à chaque régulateur sectoriel. Lors du sommet de Bletchley Park, la ville aux autobus rouges a convoqué la Chine, les États‑Unis, l’UE, le Canada, l’Inde, tous assis sous les portraits de cryptanalystes de 1944. Show dont le clou fut une déclaration reconnaissant le risque existentiel. Les tabloïds titrèrent sur l’« IA nucléaire ». Les juristes soupirèrent du fait de l’absence de clause contraignante.

Pékin impose un système de licences. Pour mettre en ligne un chatbot, SenseTime ou Baidu doivent soumettre leurs poids et leurs filtres à une commission de censure. Les modèles doivent épouser les « valeurs socialistes fondamentales ». La loi devient barrière idéologique, mais aussi arme économique car en triant la concurrence, on dynamise son marché intérieur.

Le résultat ? Une frontière mouvante. Les startups jouent avec toutes les possibilités planétaires et à chaque amendement, elles réécrivent les Terms of Service. Pour le citoyen, la carte se brouille. En Europe, un utilisateur doit savoir si un filtre relève du haut risque ou non. Les explications éclaboussent l’écran. On clique « J’accepte » comme on tousse par habitude dans le coude. La régulation vise la protection alors qu’elle génère l’opacité par saturation documentaire.

Côté business, la loi sert de catapulte. Microsoft encense l’AI Act pour mieux vendre des services de conformité clef en main à ses clients européens. Baidu publie un Livre blanc « Responsible AI » en anglais, à destination des ministères. En coulisses, chaque équipe de lobbying rédige ses amendements en langage modulaire. Un peu de transparence, mais pas trop. De la surveillance biométrique sportive sous dérogation « sécurité des JO ». La norme se plie comme un origami et les avocats facturent à l’heure.

Ainsi la loi censée figer se révèle liquide. Elle avance, reflue, contourne et irrigue comme un delta. La régulation de l’IA n’est pas la muraille mais le terrain d’affrontement.

Les centres de données

Ici, l’énergie n’est plus une commodité, elle est la respiration même de l’écosystème. Dans les plaines de l’Iowa, Microsoft et OpenAI ont semé dix mille GPU A100 avant de les remplacer par leurs cadets H100. Chaque carte consomme plus qu’un foyer, chaque baie expulse une chaleur de forge médiévale.

Le superordinateur LUMI crépite en Finlande. Léonardo (en Italie) ronfle sous un hangar de l’émilia‑Romagna. Pourtant les chiffres trahissent un retard. Les exaflops publics américains existent déjà alors que l’exascale européen reste à l’état de brochure. La Chine joue une partie de cache‑cache. Ses machines Sunway ou Tianhe‑3 atteignent l’exaflop mais disparaissent du classement Top 500 pour ne pas attirer les sanctions américaines. Les rumeurs circulent : une carte Ascend réaliserait l’équivalent d’une A100, les ingénieurs auraient cloné la Blackwell, ... Personne ne sait vraiment, chacun suppose. Le brouillard fait partie de la stratégie.

Malgré la fébrilité, un ennemi invisible gagne du terrain à savoir la facture électrique. À Dublin, un data center d’Amazon boit autant qu’une ville de cent mille habitants. Les ONG brandissent les chiffres du GWh comme des pancartes antinucléaires. L’argument vert devient levier géopolitique et la Norvège en profite en attirant les fermes de serveurs avec ses fjords hydroélectriques. Le Maghreb propose l’énergie solaire mais soulève la question de la souveraineté des données.

Les câbles transatlantiques sont les nouveaux pipelines. Une panne sur Marea ou Dunant coûterait plus cher qu’un baril hors spéculation. Les machines d’IA ne tolèrent pas la latence, elles veulent de la vitesse. D’où la ruée sur les points d’atterrissage fibre. Brest, Marseille, New Jersey, Fuzhou se découvrent être des forteresses stratégiques. Un petit port nommé Kuwana e au sud de Tokyo accueille des barges pleines de batteries de refroidissement par immersion. On y plonge les serveurs dans un fluide dialectrique. La scène rappelle les estampes de Hokusai sauf que les vagues sont thermiques.

Le débat public traîne un pas de retard. Certains chefs d’entreprise français jurent qu’ils bâtiront un cloud souverain sans passer par Amazon. Pourtant leurs appels d’offres requièrent des GPU inaccessibles en dehors des grands fournisseurs de cloud computing. On veut l’autonomie, on signe le leasing. C’est la quadrature de la dépendance. La pénurie de puces aggrave la situation. Les sanctions américaines étouffent l’export de H100 vers la Chine. Les brokers de Hong Kong les revendent à cent cinquante mille dollars pièce. Dans le même temps, Nvidia annonce la série Blackwell qui quadruple la performance. Acheter ou attendre ? La seule certitude est que la courbe d’obsolescence descend plus vite que la trésorerie ne se renfloue.

La tectonique financière n’est pas moins vive. BlackRock lance un fonds « AI Infrastructure ». Les États cherchent à rameuter les investisseurs, subventionnent le kilowatt‑heure industriel et ferment les yeux sur la taxe carbone. La politique énergétique rejoint la diplomatie des semi‑conducteurs. Une décision à Washington sur l’export de krypton peut retarder un data center à Berlin. Dans ce brouhaha, une vérité simple apparaît : sans électrons bon marché, l’IA n’est qu’un château de cartes. Les « poètes » nous parlent d’intelligence dématérialisée. En visitant une salle serveur, ils sentiront la vibration du plancher sur leurs semelles, sous les centres de données, la terre tremble vraiment.

Lobbying : la parole qui tord la règle

En mai 2023, Sam Altman évoque publiquement l’idée de retirer ChatGPT d’Europe si Bruxelles reste « trop zélée ». Il efface ensuite le tweet mais le mal est fait. L’AI Act s’assouplit quelques semaines plus tard sur le statut des modèles de fondation. La coïncidence fait sourire les cyniques.Le lobbying IA ressemble à une partie de go. L’adversaire entoure lentement le terrain plutôt que de frapper frontalement. Microsoft finance des think‑tanks qui publient des rapports alarmistes sur la compétitivité européenne. Meta crée un « Open Innovation Fund » pour des chercheurs indépendants. Les ONG sortent des lettres ouvertes à l’odeur d’apocalypse. Leur but est moins de geler la recherche que de glaner des subventions pour la sécurité. Les journalistes pris dans le vacarme relayent sans valeur ajoutée chaque déclaration comme s’il s’agissait d’un décret divin.

Au congrès américain, les auditions se succèdent. Une scène récurrente : sénateur septuagénaire confondant son écran noir avec une fenêtre Zoom et un PDG souriant qui propose un « partenariat pour la responsabilité ». Traduction : laissez‑nous écrire la loi et nous publierons nos lignes de conduite. Le public applaudit la posture …

À Pékin, le ballet se joue derrière des portes capitonnées. Les géants BATX délèguent leurs cadres au Parti. Ils siègent aux assemblées consultatives et glissent des suggestions dans les discours officiels. Le résultat se voit dans la régulation : sévère sur la dissidence et très souple sur l’innovation industrielle.

Londres et Ottawa pratiquent la « soft influence ». Ils invitent les PDG d’Anthropic ou Cohere à prononcer des keynotes dans des palais victoriens qui mettent en avant l’éthique et proposent des chaires universitaires co‑financées. Les start‑ups acceptent troquant un chèque de recherche contre une photo pour les médias.

Le lobbying passe aussi par le code. Lorsque Meta publie LLaMA 3, elle a insisté sur les ajouts permettant de bloquer les contenus terroristes. Ces rustines juridiques rassurent les régulateurs. En réalité, les hackers contournent déjà les filtres. Mais l’important n’est pas l’étanchéité, plutôt la preuve qu’on a tenté l’étanchéité.

Un cercle vertueux ou vicieux s’installe. Les entreprises répètent la litanie : « Nous réclamons une régulation stricte, mais raisonnable ». Traduction : fixez la barre où nous sommes déjà passés. Les nouveaux entrants s’écrasent dessous car ils sont incapables de financer les audits. Les géants consolident leur avance sous couvert d’altruisme. C’est l’histoire la plus ancienne du capitalisme repeinte aux couleurs du Deep Learning.

Dans un café de Bruxelles, un consultant se confit : « Le meilleur moyen de dompter une règle, c’est d’écrire soi‑même le mode d’emploi ». Son cabinet facture cinquante mille euros la note d’impact plus la simulation de risques. Le plus ironique ? Ces rapports utilisent ChatGPT pour générer une partie des annexes. L’outil s’autolégitime.

Rappelez vous la fable du serpent Ouroboros : il se mord la queue, boucle parfaite. Le lobbying IA est un Ouroboros économique. Le discours de risque nourrit la demande de solutions qui sont vendues par ceux qui produisent le risque. Le cycle tourne, gras et luisant.

Modèles économiques

OpenAI a baissé le coût de ses appels API de 90% en deux ans. Les CFO applaudissent mais les concurrents frissonnent. Le revenu arrive par millions de micro‑factures. En face, les poids ouverts : LLaMA, Mistral, DeepSeek viennent au monde sous licences permissives. Les communautés s’en emparent. Les modèles tournent sur un laptop haut de gamme parfois même sur un téléphone. Le coût d’entrée chute à pic. Un développeur isolé peut bâtir un chatbot niche pour pêcheurs à la mouche du Yukon. La tension se joue moins sur la performance que sur la captation de valeur. Les APIs fermées offrent l’illusion de la magie noire et séduisent les grandes banques, les compagnies d’assurance et plus généralement tous les sensibles au SLA contractuel. L’open séduit les gouvernements soucieux de souveraineté et les PME qui bricolent. Les stratégies hybrides fleurissent. Meta propose LLaMA 2 en open mais vend l’hébergement managé sur Azure. OpenAI promet un futur modèle libre pour ne pas laisser la scène communautaire aux autres. On vend des clefs en or pour des portes déjà entrouvertes.

Pendant ce temps, l’infrastructure devient poule aux œufs d’or. Amazon, Microsoft, Google facturent chaque GPU seconde. Ils se moquent que l’on exécute GPT‑4X ou Mistral 8x22B car la facture reste la même. L’open source devient donc catalyseur de cloud. Les marges migrent du logiciel à l’électricité virtuelle.

Le tarif du token influence même la littérature. Des start‑ups calibrent la longueur des mails automatisés pour rester sous trois kilotokens qui est le seuil magique où le coût chute. Qui aurait cru que la poésie d’entreprise se calculerait à la puissance treize ?

Les investisseurs rêvent d’abonnement. On propose des copilotes à vingt dollars par mois, on cible quatre‑vingt millions d’utilisateurs et on multiplie. L’arithmétique ressemble à l’ancien modèle de la téléphonie mobile : ARPU contre base installée. Sauf qu’ici la base peut s’enfuir d’un clique‑droit. On retient les clients par l’ergonomie, par l’intégration et par la conformité SOC‑2. La chasse au centime pousse l’innovation. Quantization, pruning, distillation sont des termes d’horloger. On taille les modèles comme des diamants, on cherche l’équilibre carat‑clarté. Un ingénieur coréen réussit à compresser LLaMA 3 70B sur un Raspberry Pi avec un système de pagification baroque. Le buzz TikTok dépasse trois millions de vues et Nvidia se frotte les mains parce que même un Raspberry a besoin d’un GPU en amont pour l’entraînement.

La valeur se déplace aussi vers le vertical. Un cabinet juridique intègre de l’IA dans un moteur de comparaison de jurisprudence et facture mille euros la recherche ce qui est moins que les heures d’associé. Les partenaires râlent mais encaisseront quand même le chèque. La commodité crée la niche et la niche nourrit la commodité. En bout de chaîne, l’utilisateur final ne paie plus le texte, il paie la tranquillité de l’expérience. C’est la vieille histoire du café : la matière première vaut centimes et le cappuccino Instagramable trois euros cinquante. De même, le prompt brut est gratuit, l’application simplifiée se vend. Le marketing IA redécouvre l’emballage.

La chaîne de valeur, fresque des dépendances

Le silicium naît à Taïwan, traverse le Pacifique, s’assemble en Oregon, s’installe dans des racks au Texas et alimente un modèle entraîné sur des données stockées en Virginie qui conseille un banquier basé à Francfort pour un prêt accordé à une start‑up marocaine.

TSMC grave 90% des puces avancées. Cette île tient le monde. Les États‑Unis subventionnent une usine en Arizona mais l’outil lithographie EUV vient d’ASML (Pays‑Bas). On dirait une partie de Mikado, une tige est retirée et tout s’écroule.

Les terres rares proviennent majoritairement de Mongolie intérieure. Sans elles, pas d’aimants pour refroidir les ventilateurs de serveurs. L’Europe débat d’ouvrir une mine en Norvège mais Greenpeace menace déjà de bloquer les bulldozers. Sur le cran supérieur, les clouds dominent : AWS, Azure, GCP. Chacun propose ses propres puces. Google TPU, Amazon Inferentia, Microsoft Cobalt. On verticalise pour enfermer le client. Les régulateurs antitrust commencent à froncer les sourcils. Dans les couloirs de la FTC, on murmure le terme « essential facility ».

Les données se ramassent comme des coquillages. Common Crawl, Wikipedia, Redbook reviews. Les questions de copyright explosent. Les éditeurs attaquent en justice et réclament des redevances. OpenAI signe avec NewsCorp un contrat de cent cinquante millions pour dix ans d’articles et fait de même avec des grands médias dans différents pays (Le Monde en France). C’est la rançon du succès. Celui qui engrange la moisson doit payer le fermier après coup.

Le fine‑tuning est une nouvelle frontière de l’artisanat numérique. Les ESN françaises forment des modèles spécialisés pour l’aéronautique et vendent la solution à Safran. Valeur locale, poids globaux. On exporte du savoir‑faire et plus des lignes de code. Les applications intégrées ferment la boucle car elle minimise la latence, mais enferme l’utilisateur. Changer de fournisseur devient plus dur que divorcer.

Chaque région tente d’étancher sa faille. L’Europe subventionne Graphcore en espérant créer une filière accélérateur locale. Pour l’instant le résultat est maigre. La Chine investit mille milliards de yuans dans le plan semi‑conducteurs ce qui contribue à a création de sept nanomètres mais bute sur la lithographie. Washington tient la clé avec ses embargos. Un diplomate américain confiait récemment « La meilleure guerre est celle qu’on gagne sans tirer ».

La chaîne de valeur est un Rubik’s Cube. Il suffit de tourner une face et les autres se dérèglent. La moindre taxe portuaire, la moindre coupure de fibre sous‑marine et l’équilibre s’effrite. L’IA n’est pas un nuage, elle est bien physique : cuivre, gallium, eau, main‑d’œuvre, ....

Souveraineté : mirage ou cap ?

Le mot souveraineté revient comme un refrain dans les discours européens. On l’agite pour conjurer le spectre d’une vassalité numérique. Pourtant, dès qu’un secrétaire d’État prononce la formule, son smartphone vibre grâce à une puce californienne. Contradiction assumée.

La dépendance première est américaine. Frameworks, modèles, clouds ; tout part de la côte Ouest. Les sanctions contre la Chine le prouvent. Un décret à Washington bride la moitié des ambitions de Shenzhen. L’Europe a les yeux ouverts ; elle finance Gaia‑X, rêve d’un cloud continental mais les entreprises signent toujours chez AWS pour la mise en production.

La seconde dépendance s’appelle Taïwan. Sans TSMC, la fête s’arrête. Les think‑tanks militaires calculent des scénarios d’invasion et y ajoutent des coefficients d’impact économique. Une attaque ferait plonger le PIB mondial de dix points. Les marchés le savent, les polices d’assurance incluent déjà une clause « Taiwan Strait Event ».

La troisième dépendance est linguistique. Les grands modèles comprennent mieux l’anglais que le tchèque. Les pays à petite langue se sentent nus. La France finance des corpus, le Kenya sponsorise un SwahiliBERT. La diversité linguistique devient enjeu de puissance douce.

Le quatrième nœud touche la défense. L’armée française refuse d’externaliser la vision drone. Elle achète un supercalculateur Atos, mais doit quand même importer les GPU américains. La Russie développe GigaChat pour contourner les globaux. Elle veut un chatbot patriote même au prix d’une qualité inférieure.

Souveraineté, donc, mais de quoi parle‑t‑on ? Certains veulent contrôler la couche matérielle, d’autres la gouvernance des données, d’autres encore l’alignement culturel. C’est un buffet de revendications. L’erreur serait de croire qu’il existe une autarcie heureuse. Même les États‑Unis dépendent d’alliés pour le quartz ou l’iridium. Peut‑on alors viser une souveraineté de négociation ? Avoir assez de cartes pour peser. L’Europe possède ASML, la Chine détient les terres rares, le Brésil le niobium. Ce jeu de poker‑menteur se joue déjà dans les couloirs de l’OMC.

La souveraineté totale est un mirage mais l’absence de stratégie est un naufrage. Mieux vaut un cap mouvant qu’une dérive passive. La question devient pragmatique. Quel degré d’autonomie est vital ? Quelle dépendance est acceptable ? Les réponses varient selon les secteurs. Les lois s’écrivent avec ces curseurs.

L’art du kairos revisité

Le kairos, disent les Grecs, c’est l’instant où la flèche quitte la corde ou où la voile attrape la bourrasque. En matière d’IA, ce moment se présente maintenant. Retarder l’arbitrage reviendrait à courir pieds nus derrière un TGV. Les États doivent décider quel port d’attache ils souhaitent bâtir, les entreprises quelle cargaison elles acceptent de dévoiler et les citoyens quel passeport de données ils veulent tamponner. Rien n’est écrit dans le marbre. La trajectoire reste modulable. Mais le temps presse, les serveurs grondent, les brevets s’empilent et les réglementations se gravent. Si l’IA ressemble à une mer démontée, la peur seule ne fera jamais tourner un gouvernail. Mieux vaut tendre le regard vers le large, ajuster la toile et oser la traversée plutôt que rester figé sur la jetée des regrets.

La semaine prochaine, vous découvrirez la suite avec une prospective à 5 ans.

Découvrez mes livres !!!!!

Pour commander, il suffit de cliquer là ! ou sur vos sites ou librairies préférés.

The Next Mind Tips and tricks

En plus de “Métamorphoses” qui continuera plus que jamais à parler des enjeux du futur, “The Next Mind Tips & Tricks” est une newsletter où vous trouverez tout ce que vous voulez savoir sur l'IA sans jamais avoir le temps : news, nouvelles IA, usages, astuces, …

Pour s’abonner, c’est sur mon profil Linkedin.

Est ce que l’IA rend débile ?

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

À force de déléguer nos réflexions, nos calculs et nos synthèses à des nuées de neurones artificiels, nous risquons de perdre l’appétit du doute. L’IA, en se faisant complice bienveillante de nos faiblesses et de notre paresse, pourrait anesthésier notre curiosité. Avant (sans faire vieux c..), recopier un vers obligeait à le savourer. Aujourd’hui, cliquer sur “générer” suffit. Or chaque acte intellectuel externalisé laisse un petit vide du fait d’une synapse moins sollicitée, d’une idée non visitée ou encore d’une mémoire qui s’effiloche. Inventer sans se brûler les doigts, c’est risquer d’oublier la chaleur même du feu. Une inquiétude légitime se développe face à cette accélération : notre espèce est‑elle en train d’hypothéquer ses capacités cognitives comme on le fait avec un bien ? Quitterons nous l’atelier de la pensée pour n’être plus que les intendants d’un génie étranger ?

Des recherches antérieures ont mis en évidence une corrélation négative marquée entre l'utilisation d'outils d'IA et les compétences en pensée critique. Les jeunes utilisateurs montraient une dépendance accrue et des performances cognitives inférieures. Contrairement aux moteurs de recherche classiques qui présentent une diversité de points de vue pour évaluation, les LLM fournissent des réponses synthétisées et singulières ce qui décourage la pensée latérale et le jugement indépendant. C'est cette "dette cognitive" lié à un report de l'effort mental à court terme mais avec des coûts à long terme.

Pour mesurer cette érosion, une équipe interdisciplinaire (Nataliya Kosmyna 1 MIT Media Lab Cambridge / Eugene Hauptmann MIT Cambridge / Ye Tong Yuan Wellesley College Wellesley / Jessica Situ MIT Cambridge / Xian-Hao Liao Mass. College of Art and Design (MassArt) Boston / Ashly Vivian Beresnitzky MIT Cambridge / Iris Braunstein MIT Cambridge / Pattie Maes MIT Media Lab Cambridge) a recruté cinquante‑quatre volontaires composés d’étudiants et jeunes actifs répartis en trois groupes.

Voici le plan d’expérimentation :

Groupes d'Étude :

Groupe LLM (Groupe 1) : Les participants étaient autorisés à utiliser uniquement ChatGPT (OpenAI's GPT-4o) comme ressource pour la rédaction de l'essai. L'utilisation d'autres navigateurs ou applications était interdite.

Groupe Moteur de Recherche (Groupe 2) : Les participants pouvaient utiliser n'importe quel site web (Google principalement), mais ChatGPT ou tout autre LLM était explicitement interdit. Les requêtes Google incluaient "-ai" pour éviter les réponses améliorées par l'IA.

Groupe Cerveau-Seul (Groupe 3) : Les participants devaient se fier uniquement à leurs propres connaissances sans l'aide de LLM ou de sites web.

Déroulé :

L'étude comportait trois sessions obligatoires pour tous les participants avec la même affectation de groupe pour chaque participant.

Une 4ème session était optionnelle et a été complétée par 18 participants.

Pour la Session 4, les participants ont été réaffectés à un groupe opposé à leur affectation initiale. Par exemple, les participants du groupe LLM sont devenus "LLM-vers-Cerveau" (n'utilisant aucun outil) et ceux du groupe Cerveau-Seul sont devenus "Cerveau-vers-LLM" (utilisant un LLM). Le groupe Moteur de Recherche n'a pas eu de Session 4.

Les participants n'ont pas été informés de ce changement de groupe à l'avance et les sujets d'essai de la Session 4 étaient choisis parmi les sujets que chaque participant avait déjà traités lors des sessions 1, 2 ou 3.

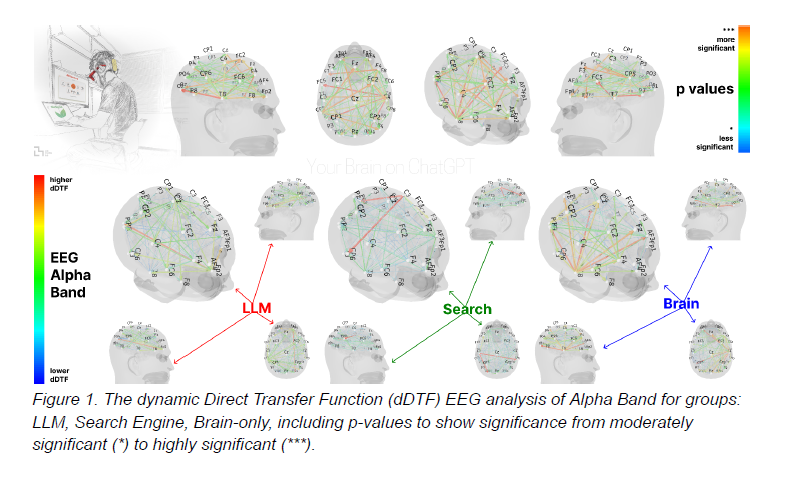

Les résultats ont été publiés dans un papier de recherche appelé “Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task”.

Les résultats ?

Connectivité neuronale (EEG) :

Le groupe Cerveau-seul a montré la connectivité neuronale la plus forte et la plus étendue dans toutes les bandes de fréquence (alpha, thêta, delta). Cela montre un engagement profond des ressources cognitives internes pour la génération d'idées, la planification et le contrôle exécutif. Par exemple, la connectivité alpha dans le groupe Cerveau-seul était significativement plus élevée.

Le groupe Moteur de recherche a présenté un engagement intermédiaire avec une activité accrue dans les cortex occipital et visuel, reflétant l'intégration d'informations visuellement acquises.

Le groupe LLM a montré le couplage global le plus faible avec une connectivité réduite en particulier dans la bande thêta (associée à la mémoire de travail) ce qui montre un allègement de la charge cognitive grâce à l'assistance de l'IA.

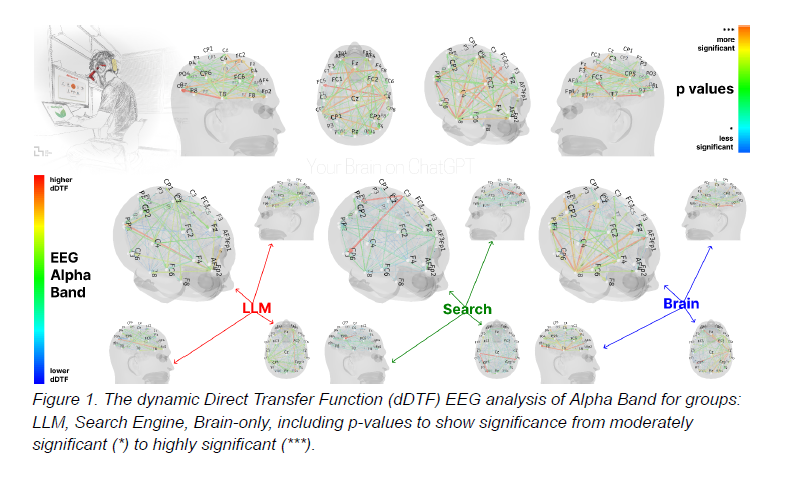

Impact de la Session 4 (changement d'outil) :

Les participants du groupe LLM-vers-Cerveau (ceux qui utilisaient des LLM et sont passés au "cerveau-seul") ont montré une connectivité neuronale plus faible et un sous-engagement des réseaux alpha et bêta. Leur connectivité en bande alpha était significativement inférieure aux pics observés dans les sessions 2-3 du groupe Cerveau-seul.

À l'inverse, les participants du groupe Cerveau-vers-LLM (ceux qui n'utilisaient aucun outil et ont commencé à utiliser un LLM) ont démontré un rappel mémoriel plus élevé et une réactivation des nœuds occipito-pariétaux et préfrontaux similaire à ce qui est perçu fréquemment dans le groupe Moteur de recherche. L'introduction de l'IA après une phase sans outil a entraîné un pic de connectivité dans toutes les bandes (alpha, bêta, thêta, delta). Cela sous entend que l'intégration des suggestions de l'IA engageait des interactions neuronales plus étendues.

Capacité de citer et sentiment d'appropriation (entretiens) :

Le groupe LLM a montré une faible perception d'appropriation de leurs essais et une capacité significativement réduite à citer ce qu'ils avaient écrit quelques minutes auparavant. En Session 1, 83,3% des participants du groupe LLM n'ont pas réussi à fournir une citation correcte et aucun (0/18) n'a produit une citation exacte. Ce déficit a persisté en Session 4 pour le groupe LLM-vers-Cerveau où 78% ont échoué à citer et seulement 11% ont fourni une citation correcte.

Le groupe Moteur de recherche a eu une forte perception d'appropriation mais inférieure à celle du groupe Cerveau-seul.

Le groupe Cerveau-seul a revendiqué la pleine propriété de leurs essais pour la plupart des participants (16/18 en Session 1 passant à 18/18 en Session 3) et a démontré une excellente capacité à citer.

Analyse linguistique (NLP) :

Les essais générés avec l'aide de l'IA étaient statistiquement homogènes pour chaque sujet.

Le groupe LLM a utilisé le plus d'entités nommées spécifiques comme des personnes, lieux ou dates. Le groupe Moteur de recherche en a utilisé deux fois moins et le groupe Cerveau-seul 60% de moins.

Les enseignants humains ont pu détecter les essais générés par LLM, reconnaissant leur structure conventionnelle et l'homogénéité des points abordés. L'IA évaluatrice a en revanche systématiquement attribué des scores plus élevés en matière d'originalité et de qualité.

Et maintenant ?

Comment garder notre cerveau affûté sans renoncer aux commodités numériques ? D’abord, toujours commencer par des doses de friction comme se contraindre à rédiger le squelette d’un raisonnement avant d’ouvrir la boîte à suggestions. Ensuite, pratiquer la co‑écriture inversée ce qui revient à demander au modèle un texte complet, puis le réécrire soi‑même en effaçant chaque phrase pour ne conserver que la structure logique. Troisièmement, cultiver des rituels de mémoire active comme apprendre un poème, réciter un article de loi ou décrire mentalement le trajet d’un fleuve. Chaque exercice ranime la cartographie intérieure. Et enfin, fixer une diète attentionnelle ! Pas plus d’une heure continue d’interaction assistée sans pause manuelle, croquis ou lecture papier. La machine doit demeurer l’esclave ponctuel, non le maître discret.

Si ces pratiques ne se généralisent pas, la fracture cognitive se creusera. On verra émerger une classe d’abandonneurs confortablement installée dans l’assistanat permanent et une caste d’augmentés qui utilisera la machine comme tremplin pour atteindre de nouveaux sommets d’abstraction. Entre les deux un fossé d’autant plus insidieux qu’il se dissimulera derrière une façade d’accessibilité. L’histoire l’enseigne. L’imprimerie a démocratisé la lecture mais seuls ceux qui ont appris à écrire ont réellement libéré leur esprit. Certains disposeront demain de neurones libérés pour invente pendant que d’autres se verront relégués au rôle de cliquetistes. Le péril n’est pas l’IA elle‑même. C’est la paresse qu’elle accentue. Prévenir ce schisme suppose un pacte éducatif nouveau avec à minima l’enseignement de l’art de la question, la vigilance aux biais, la joie de l’effort intellectuel, ... Il faut réhabiliter la lenteur choisie, la relecture, la dérive érudite hors des sentiers balisés par les algorithmes de recommandation.

Les neurosciences le rappellent toujours. Notre cerveau se fortifie par l’erreur et la surprise. Or la génération prédictive, qui nous conforte sans cesse, assèche ce terreau et rogne notre tolérance à l’incertitude fertile. Prenons une métaphore. Imaginez la bibliothèque d’Alexandrie mais dont chaque rouleau se recopierait lui‑même à l’infini pour répondre aux désirs implicites du visiteur. À première vue, le confort est absolu. Nul besoin de grimper aux échelles ni de déchiffrer les titres. Pourtant dans cette bibliothèque automatique l’aventure intellectuelle s’amenuise du fait de la disparition du hasard, de la rencontre fortuite avec le parchemin oublié qui bouleverse une vie. L’IA à la manière d’un bibliothécaire zélé nous présente toujours l’étagère voulue mais nous prive des chemins improbables où naissent les découvertes.

Il serait malhonnête d’ignorer les bienfaits sociaux de l’IA. Pour des millions de citoyens en situation de handicap ou de précarité linguistique, ces outils ouvrent une fenêtre sur le monde intellectuel. La question n’est donc pas de refuser la technologie mais bien de refuser l’automatisme. Apprenons à distinguer l’aide de l’abandon, le gain de temps de la perte d’endurance. Les neuroscientifiques envisagent déjà un indicateur inédit pour le futur. Cela consiste à jauger la vitalité d’une démocratie au nombre de ses citoyens capables de rédiger un argumentaire sans prothèse numérique. Ce simple marqueur, plus que le PIB, révélera notre vraie richesse à savoir l’autonomie de pensée.

En dernier ressort, souvenons‑nous d’une évidence. Si l’IA est un miroir, c’est à nous de décider quel visage il reflétera. Soit celui d’un être trop pressé pour penser, soit celui d’un explorateur qui ayant trouvé un exosquelette mental a choisit de gravir plus haut sans oublier la saveur de ses propres muscles. Entre ces deux futurs, il n’y a qu’un acte de volonté et c’est le même qui fit jadis naître l’écriture, la science et la démocratie.

Agissons sans tarder !

Chroniques du futur : La République des algorithmes (2038)

C’est un modèle mondial. Le premier État dirigé uniquement par des intelligences artificielles. Les conséquences ? Plus de corruption, plus de conflits d’intérêt. Tout est logique, prévisible et sans passion.

Les citoyens sont devenus des “unités d’impact” évalués sur leur taux de contribution sociale. Les émotions sont déclarées au fisc sous forme d’“écarts de rationalité”.

Les manifestations ? Gérées par des IA de désescalade émotionnelle. L’art ? Arbitré automatiquement par des modèles prédictifs de désir collectif. Les naissances ? Autorisées en fonction de la compatibilité génétique optimisée.

Personne ne se plaint mais plus personne ne rêve.

Bonnes métamorphoses !

Stéphane