#84 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

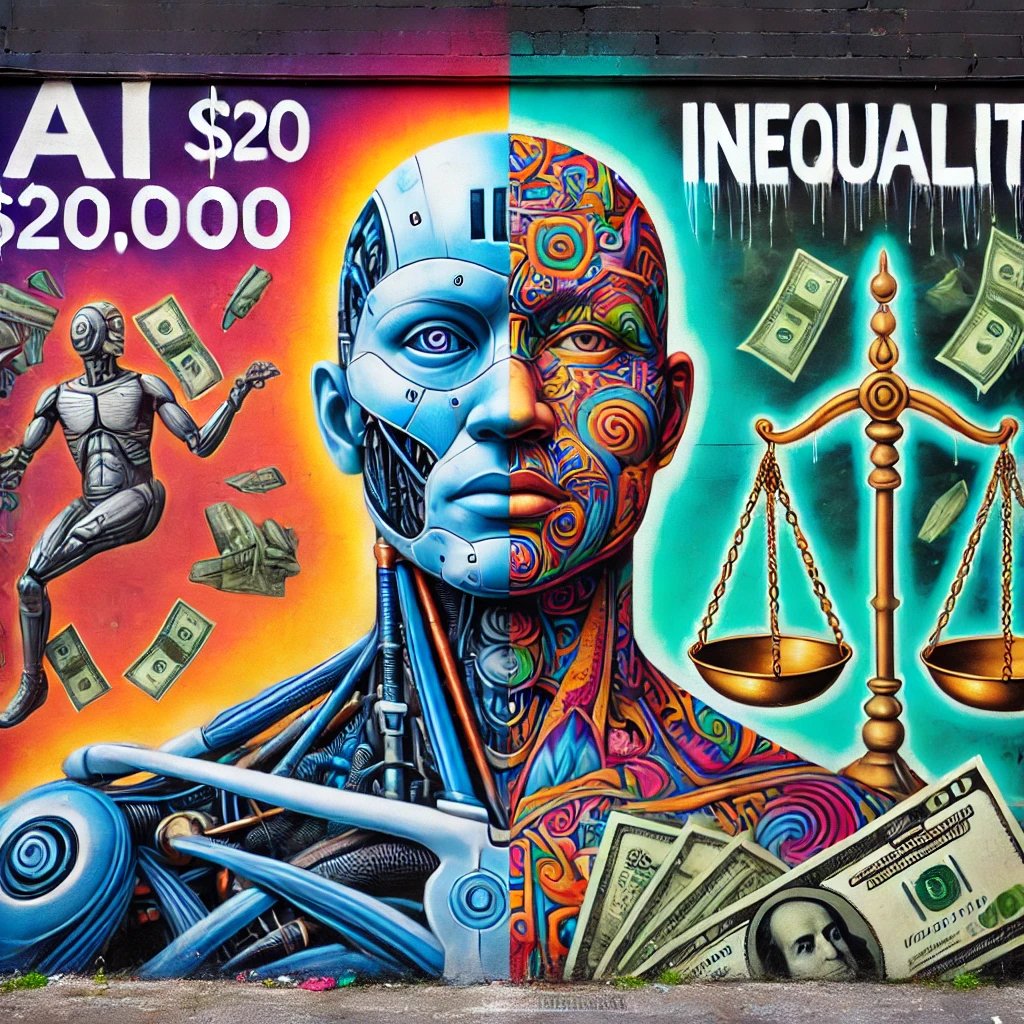

Enjeux démocratiques et défis éthiques de l'information à l'ère numérique / L’esprit critique est une des clés / Agents IA à 20 000 $ : Progrès technologique ou accélérateur d'inégalités sociales ? / Le coût de l’IA

Bonjour à toutes et tous,

Au menu cette semaine :

Enjeux démocratiques et défis éthiques de l'information à l'ère numérique

L’esprit critique est une des clés

Agents IA à 20 000 $ : Progrès technologique ou accélérateur d'inégalités sociales ?

Le coût de l’IA

Bonne lecture.

Métamorphoses à l’ère de l’Intelligence Artificielle est en commande

Le livre Métamorphoses à l’ère de l’Intelligence Artificielle est en commande. Pour ce faire, il suffit de cliquer là.

Enjeux démocratiques et défis éthiques de l'information à l'ère numérique

La définition même de l'information reste complexe et multidimensionnelle. Pour certains chercheurs, elle est intrinsèquement liée à la liberté humaine en constituant un vecteur essentiel à l'autonomie intellectuelle et au développement de connaissances critiques. Pour d'autres, elle représente avant tout un levier stratégique et politique, et est manipulable par ceux qui détiennent le pouvoir ou qui aspirent à le contrôler. Lorsqu'elle est instrumentalisée, l'information devient une menace tangible pour l'équilibre démocratique. La prolifération massive de la désinformation (« fake news ») qui est amplifiée par les réseaux sociaux et leurs algorithmes prédictifs ne se limite pas à une simple pollution informationnelle. Elle érode la confiance institutionnelle, exacerbe les clivages sociétaux et accentue les dynamiques de polarisation. Cela conduit inéluctablement à une fragmentation de l'espace public. Ce contexte favorise paradoxalement les régimes autoritaires, capables d'exploiter stratégiquement cette confusion informationnelle pour renforcer leur contrôle et fragiliser davantage les démocraties déjà affaiblies par une crise épistémologique sans précédent.

Cette diffusion de fausses informations s'appuie sur des mécanismes psychologiques bien documentés tels que l'« effet de vérité illusoire ». Celui-ci démontre que la répétition systématique d'une assertion, même manifestement erronée, tend à la rendre crédible auprès du public. Les chambres d’écho créées par les réseaux sociaux consolident des croyances, vraies ou fausses, à travers une exposition sélective à des contenus homogènes et auto-validants. Dans ce contexte, le rôle des technologies numériques, notamment de l'intelligence artificielle, est particulièrement ambivalent. Les avancées technologiques récentes telles que les « deepfakes », qui produisent des falsifications audiovisuelles hyperréalistes, rendent la tâche de distinction entre le vrai et le faux particulièrement complexe. Toutefois, parallèlement à ces dérives, l'IA peut jouer à termes un rôle clé dans la vérification des informations. En attendant, c’est les fournisseurs d’IA qui cherchent à valider leurs résultats comme l'illustre la démarche adoptée par la société française Mistral, qui s'appuie sur des partenariats avec des sources reconnues comme l'Agence France-Presse (AFP) pour assurer une validation rigoureuse des contenus diffusés. En contraste, on peut évoquer l'approche “naïve” du chatbot Grock, qui s'appuie, lui, pour le faire sur la plateforme X (anciennement Twitter), notoirement saturée de désinformation …, illustrant ainsi l'importance cruciale de la fiabilité des sources dans la validation algorithmique des informations. L’information est une arme culturelle.

L'urgence actuelle réside dans une réflexion approfondie sur notre rapport collectif et individuel à l'information. Celle-ci doit impérativement passer par un renforcement substantiel de l'éducation aux médias et à la littératie numérique, afin d'équiper les citoyens d'outils critiques pour évoluer dans un environnement informationnel saturé et complexe. Par ailleurs, une régulation renforcée et transparente des acteurs dominants du numérique est essentielle pour garantir une responsabilisation efficace face aux enjeux démocratiques posés par l'information numérique mais malheureusement ce n’est pas le chemin pris. Nous sommes bien trop passifs. La préservation de l'information comme bien commun et fondement indispensable à la démocratie relève d'une responsabilité collective. À cet égard, la défense d'une information authentique et vérifiée constitue un impératif majeur pour le maintien de la liberté et de l'intégrité démocratique.

Voici un lien vers un article de fond qui explique comment la Russie influence l’IA https://www.newsguardrealitycheck.com/p/a-well-funded-moscow-based-global.

L’esprit critique est une des clés

L'esprit critique n’est pas une simple option intellectuelle, mais une véritable exigence existentielle à l’heure où l'intelligence artificielle colonise progressivement toutes les strates de notre quotidien. Sa définition paraît simple, presque évidente : analyser, questionner, évaluer rationnellement. Pourtant, cette apparente simplicité dissimule une profonde complexité humaine. Être critique implique une remise en cause permanente, une confrontation incessante à nos propres limites cognitives, à nos croyances enracinées et à nos biais implicites. C’est un inconfort salutaire, mais que peu d'entre nous acceptent pleinement tant il menace notre équilibre psychologique, nos certitudes rassurantes et l'appartenance rassurante à des groupes sociaux homogènes.

La prolifération exponentielle des données, couplée à l'opacité intrinsèque des systèmes algorithmiques, nous confronte à un choix plus qu’impliquant : exercer activement notre jugement critique ou céder à une passivité tentante mais dangereuse. Car l'IA, aussi puissante soit-elle, ne produit pas une vérité universelle. Elle construit ses « vérités » sur des jeux de données dont la partialité et les biais ne sont que le reflet de nos imperfections humaines. Des biais culturels, sociaux et algorithmiques se propagent silencieusement et influencent subtilement ou grossièrement nos décisions professionnelles, nos choix personnels, jusqu’à nos convictions profondes. Ces biais ne sont pas les seules menaces. Les hallucinations de l’IA, ces inventions probables mais totalement erronées, brouillent davantage encore notre perception du réel. Elles sapent insidieusement notre confiance collective en nourrissant la désinformation et en exacerbant les fractures sociales. Un monde dans lequel l’esprit critique serait abandonné serait un monde vulnérable où les individus deviendraient aisément manipulables, dépendants et passifs, absorbés dans un brouillard numérique d’où émergerait une vérité artificielle dangereusement uniforme.

Exercer l'esprit critique face à l'IA n'est pas chose aisée. Nos cerveaux sont naturellement enclins à chercher le confort cognitif, évitant les contradictions, les dissonances et les remises en cause constantes. Ce penchant humain à la facilité rend l’exercice du jugement rationnel contre-intuitif et même souvent épuisant. La véritable critique exige d’abord un travail intérieur profond, une lucidité courageuse face à nos propres limites et une lutte permanente contre la tentation de simplifier le monde pour le rendre acceptable et compréhensible. C’est précisément pourquoi il est impératif de cultiver dès aujourd'hui une éducation à la pensée critique adaptée à l’ère algorithmique. Une éducation qui ne se limite pas à l’acquisition d’outils intellectuels mais qui intègre pleinement la conscience des limites humaines, valorisant autant l’humilité que la curiosité, l’ouverture d’esprit que l’interdisciplinarité. Seule cette démarche holistique pourra réellement nous armer face aux défis que posent l’IA et ses multiples biais en nous permettant non seulement de coexister, mais surtout de collaborer activement avec elle.

Loin d’être un handicap, la reconnaissance de nos limites devient alors une force. La complémentarité entre l’intelligence humaine, faite d’intuitions, d’émotions et de multiplicité, et l’intelligence artificielle, efficace mais aveugle, devient la clé d’un futur équilibré. Mais ce futur restera inaccessible si nous renonçons à la vigilance intellectuelle, si nous cédons à la facilité de l’abandon critique, ouvrant ainsi la voie à un déclin progressif de notre autonomie individuelle et collective. Il est essentiel, aujourd’hui plus que jamais, de préserver notre esprit critique comme ultime rempart face à une automatisation non réfléchie de notre société. Car perdre cette capacité serait perdre bien plus qu’un simple outil intellectuel : ce serait renoncer à notre liberté même de penser, d'agir et finalement de choisir le monde dans lequel nous voulons vivre.

Agents IA à 20 000 $ : Progrès technologique ou accélérateur d'inégalités sociales ?

Mon mantra « Mieux vaut s'occuper du changement avant qu'il ne s'occupe de nous ! » prend tout son sens à l'heure où OpenAI redéfinit les frontières économiques de l'intelligence artificielle avec des agents autonomes tarifés jusqu’à 20 000 $ par mois. Cette annonce marque une rupture nette dans la démocratisation technologique. OpenAI propose désormais une échelle tarifaire stratifiée : 2 000 $ pour des agents destinés aux professionnels intellectuels, 10 000 $ pour ceux consacrés au développement logiciel et jusqu’à 20 000 $ pour des outils spécifiquement destinés aux chercheurs de haut niveau, notamment de niveau doctoral. Cette segmentation n’est qu’une illustration d’une “élitisation” économique préoccupante qui pourrait redéfinir totalement les conditions d'accès à l’innovation technologique.

Ces agents autonomes, capables de réaliser avec une faible supervision humaine des tâches complexes telles que la gestion avancée de flux d'informations, le développement logiciel ou encore l'analyse scientifique poussée, ont le potentiel de remodeler significativement les contours du marché du travail. On assiste ici à une véritable taylorisation du travail intellectuel : les IA excellent sur des sujets précis, souvent mieux que les experts humains, mais restent incapables de remplacer globalement les intelligences multiples et la vision systémique propres à l’humain. Paradoxalement, ce découpage précis des tâches intellectuelles en spécialités optimisées par l’IA représente une mauvaise nouvelle pour la polyvalence humaine.

Les ambitions économiques d’OpenAI sont claires : ces services premium pourraient représenter près d'un quart du chiffre d’affaires de l'entreprise, encouragés par d'importants investissements institutionnels, à l'image des 3 milliards de dollars engagés par SoftBank. Ce positionnement tarifaire, bien que très élevé, reste néanmoins souvent inférieur au coût d’un expert humain, ce qui pourrait inciter les organisations à substituer progressivement l'expertise humaine par des agents IA spécialisés. Cette stratégie de tarification interroge profondément sur ses implications sociétales. Alors que l'utilisation de ChatGPT génère déjà 4 milliards $ de revenus annuels et que même l’offre "ChatGPT Pro" à 200 $/mois est perçue comme inaccessible pour certains segments sociaux, ces nouveaux prix exponentiels enterrent la démocratisation des bénéfices de l'IA. Sommes-nous face à un phénomène où l'intelligence artificielle ne serait accessible qu'à une élite économique restreinte ce qui aggraverai de facto les fractures sociales existantes ?

Ce chemin nécessite une réflexion approfondie et urgente sur l'articulation entre progrès technologique, éthique et justice sociale. Si l’IA représente incontestablement un levier puissant d’amélioration des capacités humaines, son déploiement exclusif à des tarifs prohibitifs deviendrai rapidement un amplificateur dangereux d’inégalités structurelles. Face à ces outils ultra-performants, la véritable ressource demeure la diversité cognitive humaine, riche de multiples intelligences capables de créativité, d’innovation, d’interaction sociale complexe et de prise de décision morale éclairée.

Le défi posé par ces nouveaux agents autonomes dépasse largement les simples enjeux technologiques ou économiques. Il relève de choix sociétaux fondamentaux concernant la manière dont nous souhaitons que ces technologies façonnent notre futur collectif. En adoptant une approche inclusive et responsable, nous pourrons garantir que l’intelligence artificielle reste un vecteur d'émancipation et non un accélérateur des inégalités socio-économiques. La technologie n’est jamais neutre, et la responsabilité nous incombe de décider collectivement des conditions de son usage pour bâtir une société juste, inclusive et résiliente face à l'accélération constante des changements.

Le coût de l’IA

Veille réalisée avec deepsearch de chatGPT4.5, mon avis en un mot : bluffant

La course à l’IA de pointe est intrinsèquement coûteuse. La nécessité de toujours plus de calcul, d’énergie, d’infrastructures robustes, conjuguée à une demande en forte croissance et à un encadrement réglementaire accru, crée des pressions inflationnistes sur le coût des agents intelligents. Si rien n’était fait pour contrecarrer ces facteurs, on assisterait à une hausse continue des tarifs d’utilisation.

Plusieurs facteurs structurels expliquent pourquoi, en dépit de certaines baisses unitaires, le coût global des agents IA tend à augmenter dès qu’on vise le haut de gamme ou une échelle massive :

Puissance de calcul et matériel spécialisé : Les grands modèles nécessitent des fermes de calcul remplies de GPU/Tensor cores ultra-performants. La demande explosive en 2023–2024 a provoqué une pénurie de GPU et une envolée des prix. Les puces NVIDIA H100 par exemple s’échangeaient autour de 30 000 $ l’unité, et les carnets de commandes étaient pleins sur plusieurs mois. Cette rareté a un coût : les capacités cloud ont peiné à suivre la demande, poussant Microsoft, Google, AWS à investir des milliards (ex : 10 Md$ de Microsoft dans l’infrastructure OpenAI). Tant que les ressources ne seront pas abondantes, la loi du marché maintient des coûts élevés pour chaque heure de calcul louée. Par ailleurs, les modèles géants mobilisent des dizaines de GPU en parallèle, ce qui fait exploser la facture. Même si le coût par flop baisse avec les nouvelles générations (GPU plus efficaces, ou TPUs de Google, etc.), ces gains sont en partie annulés par l’ampleur croissante des modèles. En clair, on gagne en $/flop, mais on consomme bien plus de flops pour entraîner et faire tourner les nouvelles versions d’IA. Ce bras de fer entre efficacité et scale est le moteur principal des coûts.

Consommation énergétique et refroidissement : Faire fonctionner une IA de pointe n’est pas seulement acheter des serveurs, c’est aussi payer l’électricité et le refroidissement associés. Les datacenters d’IA sont intensifs : on estime par exemple qu’un an d’utilisation de ChatGPT (en 2023) a pu consommer plus de 600 MWh d’électricité par jour pour servir ~200 M de requêtes. Cela équivaut à alimenter des milliers de foyers. Outre l’impact environnemental, la facture énergétique pour les opérateurs cloud est colossale. Si le prix de l’énergie augmente ou si l’efficacité énergétique n’est pas améliorée, ce poste de dépense se répercute sur le coût des services IA. De plus, l’eau utilisée pour le refroidissement (plusieurs litres par requête GPT-4 selon certains audits) peut entraîner des coûts indirects et des limitations locales. À mesure que l’on déploie l’IA à grande échelle, les infrastructures doivent s’agrandir (centres de calcul supplémentaires, réseaux électriques renforcés, etc.), ce qui alourdit les coûts fixes à amortir.

Infrastructures cloud et maintenance : Les fournisseurs d’IA supportent des coûts d’infrastructure continue élevés. Google a dépensé ~100 milliards de $ en 2022 sur ses infrastructures (tout service confondu). Chaque nouvelle génération de modèle impose de stocker et déplacer des énormes volumes de données, d’assurer la redondance, la cybersécurité, etc. Ces obligations pèsent davantage à mesure que les modèles grossissent et que la disponibilité 24/7 devient critique. La maintenance préventive, les correctifs (pour éviter des pannes coûteuses), tout cela contribue à un coût de fond qui tend à augmenter avec la complexité des systèmes. En outre, les partenariats cloud (ex : OpenAI sur Azure) signifient que les coûts de l’un (Microsoft) deviennent la facture de l’autre (OpenAI). On peut s’attendre à ce que ces contrats incluent tôt ou tard des clauses de réajustement tarifaire si l’usage dépasse les prévisions initiales.

Demande exponentielle et effet d’échelle : Le succès des IA génératives a conduit à une explosion de la demande. Plus d’utilisateurs et d’entreprises intègrent ces IA, plus il faut investir en serveurs supplémentaires. Si les coûts unitaires ne baissent pas aussi vite que la volumétrie augmente, le coût total augmente mécaniquement. Par exemple, même si chaque requête coûtait 2× moins cher qu’en 2023, mais que le nombre de requêtes est 10× supérieur en 2025, la dépense totale est ~5× plus élevée. Cette tension pousse soit à trouver des économies d’échelle (ce qui a ses limites physiques), soit à augmenter les prix ou monétiser davantage (ce qu’on commence à voir, cf. hausse potentielle de l’abonnement ChatGPT Plus). De plus, le besoin de modèles plus grands est en partie dicté par des usages toujours plus complexes qu’on veut adresser. On se retrouve à courir après une demande qualitative en plus de quantitative.

Régulations et conformité : L’environnement réglementaire de l’IA se durcit, notamment en Europe avec l’AI Act. Se conformer à ces régulations induit des coûts additionnels : documentation rigoureuse du fonctionnement du modèle, évaluations de risque, mise en place de contrôles humains, stockage sécurisé des données d’apprentissage, etc. Par exemple, le respect des exigences européennes de transparence et de traçabilité pourrait nécessiter des audits externes et des systèmes de monitoring dédiés, ce qui renchérit l’exploitation. De même, des restrictions sur l’exportation de données ou l’utilisation de certains datasets (pour raisons de privacy ou droits d’auteur) pourraient obliger à des investissements dans des données propriétaires onéreuses. Tout cela représente une couche de coût supplémentaire par rapport à un développement non encadré. Les grands groupes pourront absorber en partie ces coûts de conformité, mais les plus petits ou les nouveaux entrants les répercuteront possiblement sur le prix de leurs services. Ainsi, plus la régulation augmente, plus le ticket d’entrée financier pour fournir une IA fiable augmente lui aussi, consolidant potentiellement l’oligopole des gros acteurs capables d’investir.

À court terme (1–2 ans), les experts anticipent un changement de paradigme dans le rapport performance/coût des IA. Plusieurs analyses convergent vers l’idée que la courbe de coût va continuer de baisser drastiquement pour un niveau de performance donné. Sam Altman (CEO d’OpenAI) estime par exemple que « le prix d’un niveau d’IA donné est divisé par ~10 tous les 12 mois ». Si une telle cadence se maintient jusqu’en 2027, utiliser une IA aussi puissante que GPT-4 aujourd’hui pourrait coûter une fraction minime de ce qu’il en coûte actuellement. En pratique, cela se traduirait par des baisses de tarifs sur les offres existantes ou par l’apparition de modèles équivalents meilleur marché. On peut donc s’attendre, d’ici 2025–2026, à ce que les tarifs des modèles actuels (GPT-4, Claude 3, etc.) soient revus à la baisse ou remplacés par de nouveaux modèles offrant plus de capacité pour le même prix. D’ailleurs, on observe déjà en 2024 une surenchère de contextes offerts (128k tokens et plus par exemple) sans augmentation proportionnelle des coûts, signe d’une amélioration de l’efficacité.

Cette baisse des prix moyens coexistera néanmoins avec des offres premium chères. À moyen terme (3–5 ans), la tendance semble aller vers une polarisation du marché : d’un côté, une commoditisation de nombreux services d’IA (intégrés à divers outils, à faible coût unitaire voire inclus dans des abonnements existants) ; de l’autre, des modèles ultra-sophistiqués monétisés très chers pour les besoins pointus. Par exemple, si OpenAI lançait un GPT-5 dans quelques années avec des capacités très supérieures, il n’est pas exclu qu’il soit tarifé bien au-delà de GPT-4.5. On peut imaginer un GPT-5 facturé plusieurs centaines de dollars par million de tokens, réservé aux usages critiques en entreprise, tandis que GPT-4.5 deviendrait courant et abordable. Cette projection s’appuie sur l’idée que, même si le coût intrinsèque de calcul baisse, les fournisseurs ajouteront des marges sur les nouveautés où ils sont sans concurrence immédiate (pour rentabiliser les énormes coûts de R&D). En matière d’abonnement grand public, il est possible que ChatGPT Plus (ou ses équivalents chez Google, Anthropic) augmente de prix graduellement, notamment si ces abonnements donnent accès à des modèles plus puissants ou à des fonctionnalités étendues (plugins, multimodalité, etc.). Des spéculations évoquent un ChatGPT Plus pouvant coûter 40–50 $ par mois d’ici deux années si la valeur apportée double également. Cette hausse devra être mesurée face à la concurrence : si des alternatives gratuites ou open-source offrent un service similaire, les utilisateurs pourraient migrer. À moyen terme, la pression concurrentielle jouera un rôle plus fort qu’à date dans l’évolution des tarifs.

Il est également utile de considérer l’effet des nouveaux entrants et innovations sur les prix futurs. Des acteurs comme Meta (avec Llama 2 et possiblement Llama 3 à venir) choisissent de mettre leurs modèles à disposition librement. Si un futur Llama de pointe (70B+ paramètres) ouvert permet à n’importe qui d’auto-héberger un agent proche de GPT-4, cela obligera les fournisseurs commerciaux à revoir leurs prix à la baisse sauf à justifier la valeur ajoutée de leurs services (sécurité, facilité d’usage, support, etc.). De plus, des startups travaillant sur des modèles spécialisés plus efficaces émergeront sans doute et casseront les prix sur des niches (par ex. un agent IA juridique ultra-optimisé pouvant être vendu moins cher qu’un GPT généraliste). Enfin, les améliorations matérielles (puces dédiées à l’inférence, calcul quantique à plus long terme, etc.) pourraient rendre viable l’exécution locale d’IA très puissantes, ce qui changerait la structure de coûts (moins de dépendance aux datacenters coûteux).

Alternatives pour limiter la hausse des coûts

Face aux facteurs inflationnistes, plusieurs leviers technologiques et stratégiques permettent de contenir, voire de réduire, les coûts des agents IA :

Optimisation des modèles : C’est l’axe principal. Par exemple, les techniques de quantification réduisent la précision numérique des calculs (passage en 8-bit voire 4-bit) sans perte significative de qualité, ce qui divise la mémoire et le calcul nécessaires. De même, la distillation de modèles consiste à entraîner une petite IA à imiter une grande, obtenant ainsi une intelligence proche pour un coût d’exécution bien moindre. Ces approches ont déjà montré leur efficacité : l’adoption de formats 4-bit a permis d’exécuter des modèles de dizaines de milliards de paramètres sur une seule GPU grand public. Couplées à des algorithmes plus efficaces, ces optimisations réduisent directement le coût par requête. Exemple : grâce aux optimisations, un modèle atteignant un score X en 2024 peut tourner pour 0,06 $/M tokens alors qu’il en coûtait 60 $/M tokens avec la technologie 2021. L’enjeu est de généraliser ces gains : on attend notamment beaucoup des améliorations d’architecture (modèles plus petits mais plus intelligents) et de la gestion contextuelle plus maline (mémoires externes pour éviter de tout re-générer). En investissant dans l’efficacité plutôt que la seule puissance brute, les fournisseurs peuvent amortir la hausse des coûts.

Nouvelles infrastructures matérielles : L’évolution du hardware est un facteur clé pour faire baisser les coûts. Les GPU évoluent (architecture NVIDIA Hopper puis successeurs) avec un meilleur ratio perf/watt, et les composants spécifiques IA se multiplient. Google déploie par exemple ses TPU v5e pour l’inférence, optimisés pour un coût par requête inférieur à celui des GPU génériques. Amazon propose ses puces Inferentia et Trainium promettant jusqu’à 40% d’économie sur certains workloads IA. À moyen terme, des approches neuromorphiques ou photoniques pourraient aussi révolutionner l’efficacité énergétique. Diversifier l’infrastructure permet également d’éviter les goulets d’étranglement (ex: pénurie de GPU) et de faire jouer la concurrence entre fournisseurs de silicium. Par ailleurs, le déploiement de centres de données dans des zones à électricité bon marché ou refroidissement naturel (Nord, sous-marins, etc.) peut réduire les coûts opérationnels. Capitaliser sur les avancées matérielles, plus de calcul pour moins cher, est indispensable pour contrer la hausse liée aux besoins de puissance. Les grands opérateurs le font déjà : Microsoft, Google et Meta conçoivent aussi leurs propres accélérateurs pour gagner en indépendance vis-à-vis de NVIDIA et abaisser les coûts à long terme.

Open-source et mutualisation : L’essor des modèles open-source comme LLaMA, Mistral ou Falcon offre une alternative de taille : prendre le contrôle de ses coûts en hébergeant soi-même l’IA. Une entreprise avec des besoins modérés peut déployer un modèle open-source adapté sur du matériel qu’elle possède ou loue à bas prix, au lieu de payer l’API d’un tiers à la requête. Cela a un effet de marché vertueux : plus ces solutions libres gagnent en qualité, plus elles font pression sur les prix des offres propriétaires. On l’a vu, la disponibilité de LLaMA 2 a poussé OpenAI et consorts à proposer des modèles intermédiaires moins chers. À l’avenir, une communauté open-source active pourrait combler rapidement le retard sur chaque nouvelle génération (ex : reproduire un GPT-5 allégé peu après sa sortie) et ainsi démocratiser l’accès sans surcoût. La mutualisation passe aussi par des initiatives comme Together.ai ou Hugging Face, qui proposent des plateformes partagées où chacun peut utiliser des modèles à très bas prix en profitant d’économies d’échelle communautaires. Par exemple, Together a démontré qu’avec des modèles open, on pouvait atteindre le niveau de GPT-3 pour 1 000× moins cher. Investir dans et faire confiance à l’open-source est donc une stratégie clé pour contenir les coûts à long terme, d’autant que cela évite d’être captif d’un fournisseur pouvant augmenter ses tarifs.

Approches hybrides et spécialisées : Une façon de réduire la facture est d’utiliser le bon outil pour la bonne tâche. Plutôt que d’appeler systématiquement un modèle géant coûteux, les entreprises peuvent déployer une constellation d’agents IA spécialisés. Par exemple, un petit modèle entraîné juste pour la classification de tickets support, un autre pour la réponse à des questions simples, et n’utiliser le modèle très avancé que pour les demandes complexes. Cette orchestration intelligente permet d’utiliser en priorité des modèles peu chers (y compris éventuellement des systèmes de règles ou des algorithmes non-IA quand c’est suffisant) et d’escalader vers l’IA la plus coûteuse seulement en dernier recours. De même, des techniques comme la recherche d’information augmentée (RIA) peuvent réduire le contexte que le LLM doit traiter : en extrayant d’abord les documents pertinents via des méthodes moins onéreuses, on réduit les tokens à traiter par le modèle, donc le coût. On voit se développer tout un écosystème d’outils d’optimisation de requêtes, de prompt caching (mis en avant chez Anthropic avec jusqu’à 90% d’économies possibles grâce au cache) et de batching des requêtes. En optimisant l’usage, on peut servir plus de requêtes pour le même budget. À court terme, ces stratégies seront indispensables pour les startups cherchant à offrir des services IA à moindre coût.

Modèles et données open-source de haute qualité : Un frein à l’open-source total était la qualité inférieure des modèles libres par rapport aux fermés. Mais des efforts comme RedPajama (reproduction de datasets de GPT-4), ou des modèles comme Falcon, MPT, LLaMA 3 à l’horizon, visent à combler l’écart. Si la communauté parvient à créer des modèles open-source aussi performants que les meilleurs modèles propriétaires, alors les coûts d’accès seront naturellement limités (hors coûts d’infrastructure). On peut imaginer dans le futur proche un modèle open 100B surpassant GPT-4 et que chacun pourrait faire tourner pour quelques centimes via un réseau distribué. Des projets de calcul distribué (p2p) pourraient même mutualiser la puissance inutilisée de nombreux ordinateurs pour réduire la dépendance aux data centers onéreux. Toutes ces pistes redonneraient du pouvoir aux utilisateurs sur les coûts, forçant les grands fournisseurs à ajuster leurs tarifs pour rester compétitifs.

La hausse des coûts des agents IA n’est pas une fatalité. Certes, les modèles sont de plus en plus chers à développer et à héberger, mais les forces du progrès technologique et de l’ouverture jouent en sens inverse. Les données récentes montrent une baisse exponentielle des coûts unitaires, et les acteurs de l’IA multiplient les initiatives pour rendre ces systèmes plus abordables sur le long terme. À court terme, on assistera encore à un tiraillement entre hausse des coûts premium et baisse des coûts commodité. Mais grâce aux optimisations de modèles, aux nouvelles puces, à l’open-source et aux stratégies intelligentes de déploiement, les utilisateurs disposeront d’alternatives pour limiter l’impact des hausses tarifaires. L’issue probable est un futur où l’IA de base devient bon marché et omniprésente, tandis que seules les applications ultrapointues justifieront des coûts élevés et même ces coûts élevés finiront par baisser à leur tour, au fil de la prochaine révolution technologique. Cette analyse ne prend pas en considération le coût environnemental, je tenterai (c’est très complexe) de le faire prochainement.

Bonnes métamorphoses et à la semaine prochaine.

Stéphane