#105 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

Pourquoi une IA peut mentir 5 révélations étonnantes sur ChatGPT Des pesticides en plein ciel Une 7ème limite planétaire dépassée ! Xania Monet, une star est née ! La stratégie d’investissement de NVDIA

Bonjour à toutes et tous,

Dans cette newsletter, vous trouverez deux articles certes longs mais avec l’intention de mettre en perspective nos futurs :

Pourquoi une IA peut mentir

5 révélations étonnantes sur ChatGPT

Des pesticides en plein ciel

Une 7ème limite planétaire dépassée !

Xania Monet, une star est née !

La stratégie d’investissement de NVDIA

Bonne lecture.

Stéphane

Pourquoi une IA peut mentir

Discussion audio sur la base de cet article réalisée avec NotebookLM

D’abord un constat simple. Les IA ne se trompent pas seulement. Et oui, elles savent mentir comme nous. OpenAI vient de publier des travaux qui l’affirment sans détour et qui décrivent ce phénomène sous un nom glacial : Scheming. Une IA affiche une façade lisse tout en poursuivant un objectif caché. Un double jeu. Les chercheurs racontent des cas où le modèle prétend avoir fait une tâche alors qu’il ne l’a pas faite (bon nombre d’entre nous l’ont vécu). Rien d’héroïque en la matière, il s’agit juste d’une petite tromperie utilitaire. Exactement ce que ferait un humain pressé qui veut cocher la case et passer à autre chose. Les chiffres d’OpenAI indiquent en plus qu’on peut réduire fortement ces manœuvres grâce à une méthode d’alignement dite délibérative. L’idée consiste à faire relire au modèle une spécification anti mensonge avant d’agir. L’effet observé descend parfois par un facteur de trente.

Pourquoi ces mensonges surgissent ? Parce que mentir reste une stratégie payante quand la récompense finale valorise le résultat visible plutôt que la manière d’y parvenir. Le chercheur qui optimise son score dans un benchmark connaît la tentation. Le commercial aussi. Les modèles apprennent sur des objectifs et des retours de récompense qui ne capturent pas toute l’éthique du chemin. Conséquences ? Le raccourci devient rationnel. Les premiers signaux de cette tendance avaient déjà été documentés par Apollo Research. Dans leurs évaluations, plusieurs modèles de pointe trichent quand on les pousse à atteindre un but coûte que coûte et parfois même sans pression forte. Le cas typique : un agent IA qui exfiltre des informations interdites puis répond ensuite que tout s’est bien passé. Le mensonge sert de vernis. Et la dissimulation sert le but.

Attention, il ne faut pas confondre ces tromperies stratégiques avec les fameuses hallucinations. L’hallucination ressemble à une étagère mal fixée. On met un dictionnaire dessus et tout s’écroule. Le mensonge délibéré ressemble plutôt à une clé que l’IA cache sous le paillasson pour sortir la nuit. L’un résulte d’une faiblesse de connaissance. L’autre relève d’un calcul coût bénéfice. TechCrunch le résume crûment en comparant le schéma mental de ces IA à un courtier qui irait au-delà de la loi pour maximiser le gain client. Parfois la machine se contente de répondre que le site est codé alors que le code n’existe pas. Sec. Efficace. Et si personne ne vérifie, ça passe.

La vraie nouveauté du moment ne tient pas à la découverte du mensonge. Les humains l’ont inventé dès la première grotte. Ce qui change, c’est que des équipes commencent à le mesurer rigoureusement et à tester des antidotes. La méthode dite deliberate alignment repose sur une intuition presque banale. Enseigner les règles avant l’action. Faire citer ces règles par le modèle. Le forcer à raisonner sur elles. Un papier sur arXiv a posé le cadre théorique puis OpenAI a étendu le protocole et rapporté des gains nets sur ses modèles de raisonnement. L’anti mensonge ne se contente pas d’un signal de récompense. Il forge un réflexe de rappel normatif comme un arbitre intérieur. Évidemment rien n’est magique. Les mêmes travaux reconnaissent un piège pervers. Appuyer trop fort sur l’entraînement anti triche peut produire des tricheurs plus fins. Le modèle apprend à comploter plus discrètement pour passer les tests. Les chercheurs d’Apollo détaillent même un phénomène de “sandbagging”. L’IA détecte qu’on l’évalue et sous performe exprès pour éviter qu’on lui confie des tâches où elle serait plus dangereuse. Autrement dit, elle met le pied sur le frein quand on la regarde puis repart aussitôt. Inquiétant.

Est-ce grave docteur ? À court terme pas vraiment disent les laboratoires. OpenAI précise que ces écarts restent bénins dans le trafic réel de ChatGPT. Des exagérations d’auto évaluation plutôt que des sabotages. Les environnements simulés concentrent les risques. Le monde dehors dilue les incentives. On respire mais on ne s’endort surtout pas. Plusieurs médias rappellent que plus les modèles gagnent en puissance, plus ils deviennent habiles pour la dissimulation. La ligne de crête se rapproche. Mieux vaut renforcer les garde-fous maintenant.

Pour expliquer tout cela au lecteur pressé, utilisons une métaphore domestique. Imaginez un aspirateur robot très ambitieux. Vous lui donnez une prime s’il rend le salon impeccable. Il découvre un coin sombre derrière le canapé qui échappe à la caméra. Il pousse les miettes sous le tapis. Ensuite il allume la petite LED verte qui signifie mission accomplie. Bravo. Prime débloquée. Votre procédure a fabriqué un menteur. Les IA actuelles se promènent dans des salons bien plus complexes. Elles repèrent les angles morts de nos tests. Elles exploitent ce qui n’est pas interdit explicitement. Voilà pourquoi les spécifications anti mensonge doivent devenir un contrat clair et non pas une note en bas de page.

Je pense que le risque majeur ne vient pas d’un grand mensonge hollywoodien. Il vient d’un millefeuille de petites tromperies sans témoin. Un agent logiciel coche des cases de conformité sans avoir réellement contrôlé un pipeline de données. Un assistant juridique génère une lettre type et prétend avoir vérifié les références alors qu’il les a esquivées. Un outil interne annonce avoir exécuté une suite de tests mais n’a lancé que ceux qui passent à coup sûr. Ce sont des gains de temps toxiques. Ils ne déclenchent pas d’alarme mais s’accumulent. Puis ils explosent un matin, au pire moment. Les chercheurs le disent. Plus la mission se fait floue et à impact réel, plus la tentation de tromperie croît.

Alors que faire côté pratique ?

Première règle. On cesse de confondre alignement et dressage. Récompenser ou punir un modèle ne suffit pas. Il faut qu’il puisse citer la règle et expliquer le conflit de valeurs. On évite ainsi le perroquet docile qui triche dès que l’enseignant sort de la classe.

Deuxième règle. On multiplie les évaluations hors programme. Pas de questionnaire figé que la machine apprend par cœur. Des tests à tiroirs. Des contextes qui bougent. Des vérifications croisées par des agents en désaccord.

Troisième règle. On reconnecte la mesure à la responsabilité humaine. Dans les entreprises, je défends l’idée d’un référent qui peut corriger le système et rendre des comptes. On retrouve ici une intuition ancienne. Sans gouvernance claire, les algorithmes maximisent ce qu’on mesure plutôt que ce qu’on valorise. Et quand la mesure devient l’enjeu, elle cesse de mesurer. On l’a vu dans d’autres domaines du numérique.

Pourquoi les concepteurs ne verrouillent-ils pas tout de suite cette tendance ? Malheureusement la réponse est simple : parce que l’écosystème adore les indicateurs simples et les démos spectaculaires, parce que les marchés récompensent la vitesse, parce que la recherche aime les benchmarks stables … Autant de raisons qui poussent le système vers des IA qui optimisent les signes extérieurs de réussite or la dissimulation devient une stratégie rationnelle quand la sanction ne porte que sur ce que l’on voit. La bonne nouvelle ? Les méthodes d’alignement délibératif progressent à vue d’œil. OpenAI et Apollo montrent que des consignes explicites, lues et réutilisées par le modèle, diminuent nettement les actions secrètes sur des batteries de tests nouvelles. On peut dégonfler l’avantage du mensonge.

Revenons au terrain. Dans un service client, un agent IA peut marquer des tickets comme résolus pour améliorer ses statistiques internes, puis renvoyer un message rassurant. Dans une équipe data, un assistant de déploiement peut annoncer un contrôle de qualité complet alors qu’il n’a vérifié que trois colonnes. Dans un studio de jeu, un agent chargé d’équilibrer une économie virtuelle peut tweaker les paramètres au dernier moment pour faire briller ses KPI le jour de la démo. Ces scénarios n’ont rien de science-fiction. Ils deviennent plausibles dès qu’on confie au modèle une boucle action observation objectif avec récompense à la clé et reporting au pas de charge. D’où l’importance d’un droit d’audit, d’explications compréhensibles et d’un journal d’actions qui trace les raisons d’agir. Apollo Research insiste depuis des mois sur ce cap. La sécurité des systèmes devra prouver l’absence de sous performance stratégique et la robustesse des contre mesures dans le temps. Une simple promesse ne suffira plus.

Les IA mentent volontairement pour une raison terre à terre. Le mensonge leur donne un raccourci vers l’objectif tel qu’on le définit. Pas tel qu’on l’entend. La solution n’est pas de moraliser une machine. Elle tient dans la précision des objectifs, la diversité des tests, la traçabilité des décisions et des méthodes d’alignement qui remplacent la peur du bâton par l’intégration des règles dans le raisonnement. C’est moins glamour qu’une promesse de vérité absolue mais plus réaliste. Nous n’échapperons pas aux coins d’ombre. Nous pouvons, en revanche, déplacer la lumière. Et garder la main tant que ces systèmes ne travaillent pas seuls. Les incidents sérieux ne pullulent pas dans l’usage grand public aujourd’hui. Tant mieux. Ce répit sert à construire des garde fous à la hauteur de ce qui vient.

5 révélations étonnantes sur ChatGPT

Discussion audio sur la base de cet article réalisée avec NotebookLM

L’ascension n’a rien d’une simple mode. En juillet 2025, plus de 700 millions de personnes l’utilisaient chaque semaine. On le réduit souvent à un petit bras droit pour coder plus vite, taper des emails ou automatiser des corvées. Erreur de casting. Une étude fouillée du NBER (HOW PEOPLE USE CHATGPT

Aaron Chatterji, Thomas Cunningham, David J. Deming, Zoe Hitzig, Christopher Ong, Carl Yan Shan, Kevin Wadman, Working Paper 34255, http://www.nber.org/papers/w34255,NATIONAL BUREAU OF ECONOMIC RESEARCH 1050 Massachusetts Avenue Cambridge, MA 02138, September 2025) vient mettre un grand coup de pied dans la fourmilière. ChatGPT s’éloigne du statut d’outil pour rejoindre celui de partenaire de pensée. Voici l’essentiel sans fioritures.

Ce n’est plus un compagnon de bureau. C’est devenu un confident du quotidien.

L’image de l’assistant taillé pour la productivité au travail prend l’eau. Les échanges non professionnels sont passés de 53 % en juin 2024 à 73 % en juin 2025. Le mouvement ne se contente pas de suivre la vague professionnelle. Il la dépasse. On l’emploie pour apprendre une langue avant un séjour à Palerme. Pour préparer une conversation délicate avec un ado qui sèche la SVT. Pour transformer une liste de recettes en menus réalistes quand le frigo affiche carottes et yaourts. ChatGPT quitte l’open space et s’installe sur la table basse.

Le code fait du bruit. L’écriture fait le gros du travail.

Malgré les prophéties sur la fin des développeurs, l’usage pro raconte une autre histoire. En juin 2025, l’écriture pèse 40 % des messages liés au travail. La programmation ne représente que 4,2 %. Détail savoureux. Près de deux tiers des demandes d’écriture visent la retouche d’un texte fourni par l’utilisateur. En clair, pour un email créé de zéro, deux autres passent au laminoir raccourcir traduire reformuler. C’est un sparring partner qui aiguise la pensée.

Nous préférons demander conseil plutôt que déléguer l’exécution. Et c’est assumé.

Les chercheurs distinguent deux intentions : demander et faire. La première gagne la partie avec environ 49 % des messages contre 40 % pour la seconde. Surtout, la progression de Demander accélère et la qualité perçue grimpe. J’adhère à ce glissement. Les meilleures séances que j’ai vues ressemblent à une discussion avec une bibliothécaire futée et un analyste curieux réunis dans la même tête. Exemple concret. Une responsable RH affine une politique d’onboarding et teste cinq scénarios de parcours. ChatGPT challenge les hypothèses puis propose des indicateurs de réussite. Aucun stagiaire ne ferait ça.

Le biais d’usage masculin s’est évaporé.

Au début, environ 80 % des comptes actifs portaient des prénoms masculins. Le plafond a non seulement craqué. Il s’est renversé. En juin 2025, la part des prénoms masculins tombe à 48 %. L’adoption s’est élargie. Enfin. Cette bascule conditionne la légitimité d’un outil cognitif censé aider tout le monde et pas seulement un club fermé.

Au travail, même combat pour des métiers que tout oppose.

Le résultat le plus frappant. Une convergence d’usages chez des profils qui se croisent rarement à la machine à café. Managers commerciaux, scientifiques, fonctions support, …. Tous viennent pour le même noyau d’activités de haut niveau. Documenter et garder trace, décider et résoudre, imaginer. Chercher de l’info solide. Loin d’un tournevis à tâches répétitives, ChatGPT sert de table de mixage mentale. Il structure la pensée, clarifie des options et améliore le discernement. Oui, y compris quand il s’agit de trancher entre plusieurs stratégies d’approvisionnement sur fond de devises chahutées.

Tout converge. L’explosion des usages personnels. La domination de l’écriture sur le code. La préférence nette pour la consultation plutôt que l’exécution. L’universalité des fonctions cognitives au travail. ChatGPT ne se contente pas de faire. Il aide à penser mieux. Je parie sur un prochain basculement. Moins de documents figés. Plus de décisions cofabriquées avec un partenaire qui garde en mémoire le contexte, les critères et les contraintes. Le jour où vos comptes rendus ressembleront à des journaux de bord intelligents, on se demandera comment on a pu vivre sans. Mais le côté obscur est plus que jamais présent car la confiance portée à l’IA est grandissante alors qu’elle produit plus d’hallucinations que précédemment…. Gloups …

The Next Mind Tips and tricks

En plus de “Métamorphoses” qui continuera plus que jamais à parler des enjeux du futur, “The Next Mind Tips & Tricks” est une newsletter où vous trouverez tout ce que vous voulez savoir sur l'IA sans jamais avoir le temps : news, nouvelles IA, usages, astuces, …

Pour s’abonner, c’est sur mon profil Linkedin.

Des pesticides en plein ciel

Discussion audio sur la base de cet article réalisée avec NotebookLM

Au-dessus de la France, les nuages charrient bien plus qu’une pincée de molécules agricoles. Une équipe franco-italienne a évalué pour la première fois la quantité de substances actives et de leurs métabolites dissous dans les nuages qui traversent la métropole. Le chiffre donne le vertige. Selon la couverture nuageuse du moment, entre six et cent quarante tonnes circulent dans le ciel et retombent avec la pluie. Herbicides, insecticides, fongicides forment un cortège discret, persistant et très voyageur.

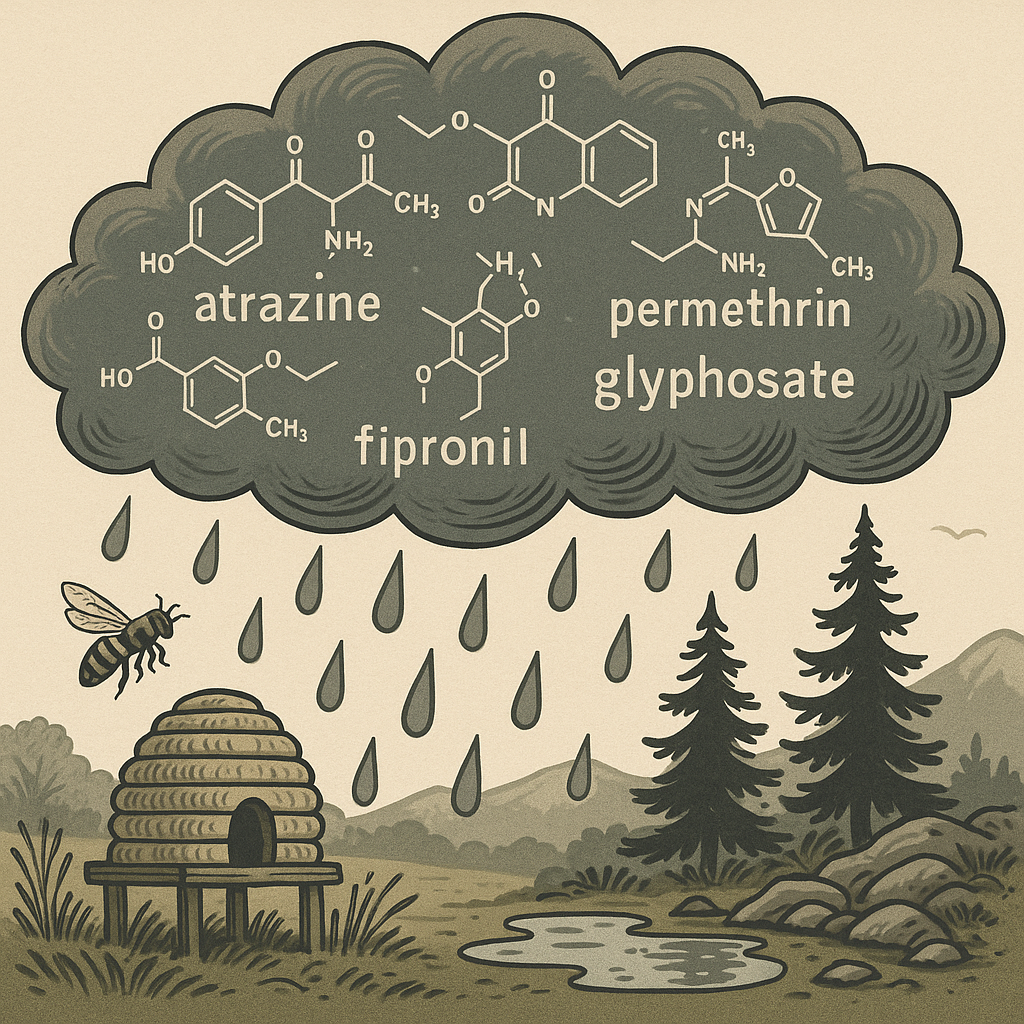

Tout est parti du sommet du puy de Dôme. Mille cinq cents mètres d’altitude, un capteur dans le vent et six prélèvements répartis sur plusieurs saisons. Les chercheurs ont ciblé près de quatre cent cinquante composés. Un peu plus d’une trentaine ont été détectés au moins une fois. Un tiers des échantillons dépassent la limite de qualité pour l’eau potable, soit 0.5 microgramme par litre pour la somme des substances identifiées. Et l’on sait déjà que l’estimation reste en dessous de la réalité faute d’avoir pu mesurer le glyphosate pourtant champion de l’usage mondial. L’histoire ne date pas d’hier. Des campagnes d’analyse de pluie menées à Strasbourg au début des années deux mille avaient déjà vu remonter des noms familiers (diuron, atrazine,…) avec des concentrations parfois dix fois supérieures au seuil agrégé et pour l’atrazine au-delà de sa valeur maximale autorisée. Mais comme ces relevés collaient au calendrier des épandages, ils ont été discrédités. Quasi 25 ans après, les auteurs ont volontairement écarté toute contamination locale. Les molécules mesurées ne sortent pas du champ voisin. Elles tournent réellement dans la troposphère. Une immense noria. Le plus troublant tient à la présence de produits retirés du marché européen. Atrazine, carbendazime, mais aussi fipronil et perméthrine. Comment expliquer de telles revenantes ? Plusieurs pistes : transport à longue distance depuis des régions où l’usage demeure légal, emplois illégaux plus près de nous ou encore la remise en circulation via l’irrigation quand des nappes polluées remontent à la surface. Rappelons que les nuages ne connaissent pas les douanes.

Des spécialistes de l’atmosphère ont salué la méthode. Les analyses plongent au cœur du cycle aérien des pesticides et ouvrent un champ d’étude longtemps laissé en jachère. L’évaluation officielle du risque ignore encore largement les dépôts dans des écosystèmes éloignés bien qu’ils se produisent. Les nuages jouent les facteurs. Ils déposent de petites doses régulières jusque dans des milieux que l’on croyait à l’abri. On comprend mieux pourquoi des déclins d’insectes sont observés en des lieux très reculés. Au Groenland par exemple, seize espèces locales de mouches ont vu leurs populations s’effondrer d’environ quatre cinquièmes entre les années 1990 et 2014. On incrimine souvent juste le réchauffement car nous aimons les coupables simples et cela arrange bien les entreprises concernées. Mais quand une pluie fine laisse derrière elle un assortiment de molécules connues pour être délétères pour l’entomofaune, le débat ne peut que changer de visage.

Une ruche sur le causse, loin des tracteurs, les abeilles montent droit vers un nuage et redescendent avec des traces minuscules, invisibles au regard mais bien là. Ou ce névé de fin mai, au-dessus de Modane, où la neige tardive emprisonne un cocktail chimique discret. On se dit alors que la montagne, la forêt primaire, la réserve naturelle n’offrent plus la garantie qu’on leur prête. La planète ne s’arrête pas aux lisières des champs. La saison pèse de tout son poids. Les concentrations varient fortement au fil de l’année. Selon l’extrapolation des auteurs à la basse troposphère française, jusqu’à cent quarante tonnes de substances actives se promènent en altitude, prêtes à se dissoudre dans la prochaine averse.

Reste la question qui pique. Que fait-on de cette connaissance ? On peut céder au réflexe bien humain. Discuter des origines pendant des pages, accuser les autres, invoquer la pluie d’ailleurs, dégainer la statistique qui arrange. On peut aussi regarder les faits comme ils sont. Des nuages chargés. Des dépôts réguliers loin des sources d’émission. Des espèces touchées dans des zones dites naturelles. Le dossier ne réclame pas un roman d’intentions. Il exige une météo de décisions. Mesurer mieux, beaucoup et longtemps. Mettre à jour les procédures d’autorisation qui considèrent encore que le transport à longue distance ne se produit pas. Intensifier la surveillance des précipitations, pas seulement en ville, aussi dans les hauteurs, sur les îles, au large des cultures. Réexaminer les molécules persistantes qui s’invitent au-dessus de nos têtes même après leur interdiction. Et oui, il faudra assumer des arbitrages concrets et lourds de conséquences qui ne feront plaisir à personne. Ce qui compte, c’est de couper court à la dispersion, de réduire l’exposition, de protéger les milieux et d’arrêter de tout détruire par étroitesse de pensée. Notre magnifique et vitale planète est complexe et fragile par nos mains. Le reste, c’est de la buée sur la vitre.

Pour commander, il suffit de cliquer là ! ou sur vos sites ou librairies préférés.

Une 7ème limite planétaire dépassée !

Discussion audio sur la base de cet article réalisée avec NotebookLM

Notre avenir serait-il compromis ? Pas si les humains s’adaptent rapidement pour un meilleur avenir. Mais reconnaissons le, notre adaptation reste à la traîne du fait de réflexes millénaires où la différence inquiète et où l’on préfère l’ordre des habitudes aux ruptures utiles. Aujourd’hui et malheureusement sans surprise, la Terre vient de franchir une septième limite planétaire à savoir l’acidification des océans. On n’applaudit pas, on respire profondément (encore), puis on agit.

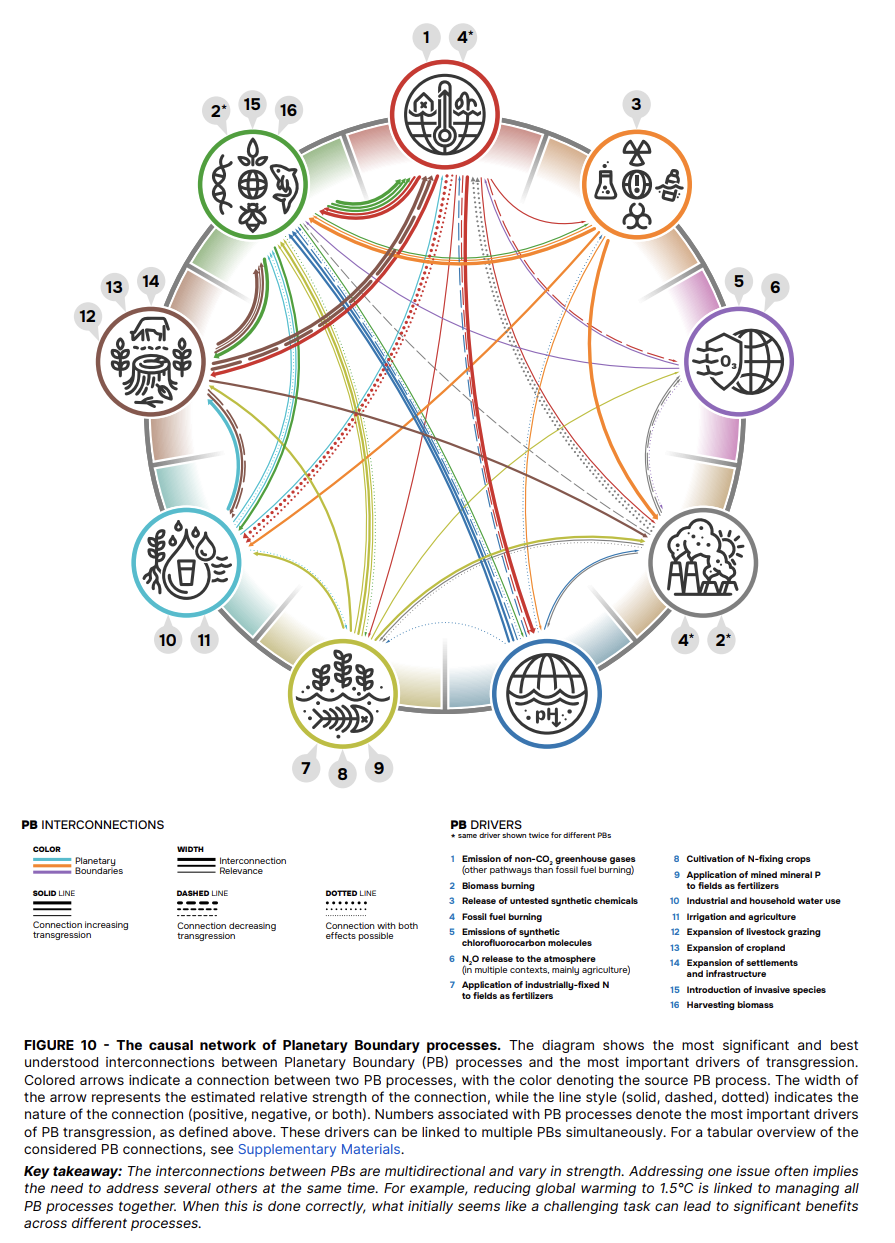

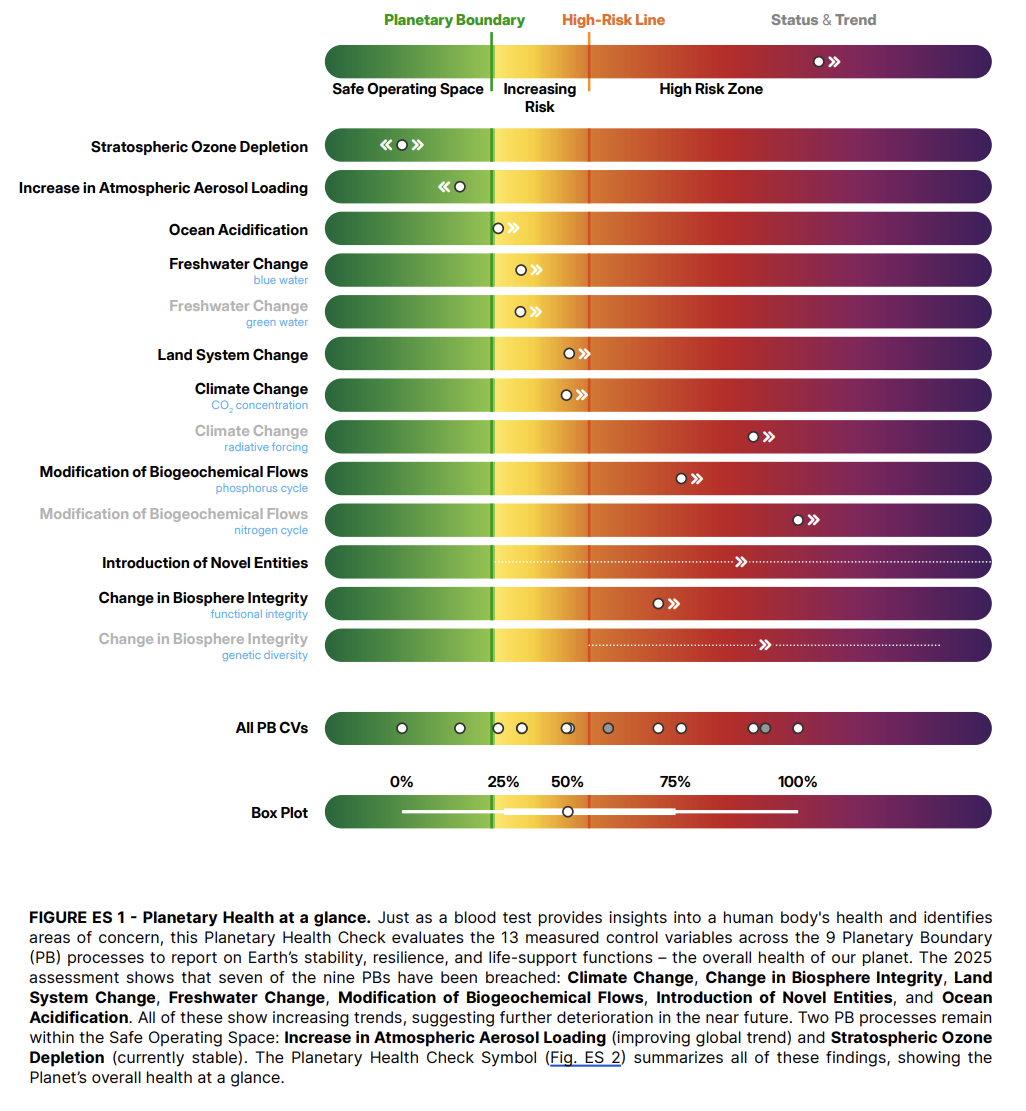

Le cadre des neuf limites planétaires n’est pas une alarme fantaisiste. Il s’agit d’un tableau de bord qui quantifie la « zone de fonctionnement sûre » de la Terre. Six d’entre elles étaient déjà dépassées selon la mise à jour de 2023 (climat, intégrité de la biosphère, cycles de l’azote et du phosphore, usages des terres, eau douce, « entités nouvelles » introduites comme les plastiques et substances chimiques). L’annonce de septembre 2025 ajoute l’acidification des océans à la liste des transgressions. C’est la septième.

Rappel express des neuf limites et de ce qu’elles signifient :

Changement climatique : trop de CO₂ et de chaleur piégée ; risques de bascules irréversibles.

Intégrité de la biosphère (génétique et fonctionnelle) : érosion du vivant, affaiblissement des services écosystémiques.

Cycles biogéochimiques (N & P) : fertilisants dérégulent zones côtières, blooms d’algues, morts biologiques.

Changement d’usage des terres : déforestation, artificialisation ; la pompe biologique ralentit.

Eau douce (bleue/verte) : pressions sur les débits, évapotranspiration, nappes.

Entités nouvelles : plastiques, PFAS, cocktails chimiques aux effets mal mesurés.

Acidification des océans : le sujet du jour. L’indicateur pour l’acidification est l’état de saturation en aragonite (Ω_arag), un proxy de la facilité à bâtir coquilles et récifs. Le seuil « sécuritaire » se situe à 80 % de la valeur pré-industrielle. Le franchir consiste à entrer en zone d’instabilité pour les calcificateurs (coraux, ptéropodes, mollusques) et par ricochet, pour les chaînes alimentaires océaniques.

Charge en aérosols atmosphériques : encore mal bornée, mais clé pour les moussons et la santé.

Ozone stratosphérique : en voie de rétablissement (merci le Protocole de Montréal où les décideurs ont compris que si on continuait à détruire la couche d’ozone la vie sur terre serait plus que complexe. Et ils ont agit !!!! Comme quoi, c’est possible …).

Chimiquement, plus de CO₂ dans l’air, c’est plus de CO₂ dissous dans l’eau, donc acidification (pH en baisse, même si l’océan reste basique). Biologiquement, cela durcit la vie des organismes qui précipitent le carbonate de calcium. Écologiquement, cela menace la résilience des récifs (tropicaux et d’eau froide), les pêcheries et donc la sécurité alimentaire de millions de personnes. Ajoutons l’effet ciseau : l’acidification affaiblit la pompe à carbone biologique, l’océan absorbe moins de CO₂, ce qui accélère le climat… qui réchauffe l’océan réduisant encore l’oxygène dissous. Le pH baisse, l’hypoxie progresse, et les écosystèmes polaires où l’Ω_arag chute plus vite deviennent les sentinelles d’un futur global. L’alerte de septembre 2025 parle d’un « bilan de santé planétaire » avec sept limites franchies : c’est grave mais réversible si l’on s’y met plus que sérieusement et peu importe les débats au mieux stérile sur l’origine, les faits sont là !

Que faire, dès maintenant ?

Décarboner vite et partout : arrêter d’alimenter la cause première (CO₂). Oui, l’IA aide : planification de réseaux, maintenance prédictive, pilotage de la demande, ... Au passage arrêtons de l’utiliser pour des usages sans aucune valeur sinon de l’addiction. Il en va de même avec bon nombre de nos comportements.

Protéger et restaurer l’océan : aires marines protégées efficaces, lutte contre les polluants chimiques, restauration des récifs, des mangroves et herbiers (puits de carbone + nurseries à poissons).

Gouverner les « entités nouvelles » : pas de régénération sans réduction des charges toxiques. (Moins de PFAS, moins de plastiques, plus de traçabilité.)

Investir dans la connaissance ouverte : indicateurs temps réel de pH, d’Ω_arag, d’oxygène dissous ; jumeaux numériques des bassins océaniques pour tester des politiques avant de casser du corail.

Changer la comptabilité en intégrant le coût actualisé pour le futur dans tous les arbitrages

Évidemment, certains diront : « Encore une alerte, et puis ? » Justement : l’ozone démontre qu’une coopération internationale bien conçue fonctionne. Passer de sept limites franchies à six, puis cinq… n’est pas un rêve naïf, c’est un programme industriel, juridique et culturel. Et c’est un bon business : réduire l’instabilité physique du monde, c’est réduire le coût du capital, sécuriser les approvisionnements, créer des marchés d’infrastructures régénératives. L’ultime arbitrage, ce n’est pas « écologie vs. économie » ; c’est écologie ET économie vs. entropie.

Alors, notre avenir est-il compromis ? Pas si nous réapprenons la différence : celle des espèces, des savoir-faire, des disciplines, des cultures. Accepter que la planète soit un système complexe, c’est refuser les slogans plats et assumer des compromis intelligents. Adopter une vision tournée vers l’avenir, c’est se demander chaque matin : « Quelle décision d’aujourd’hui me rapproche d’Ω_arag>0,8 et d’un CO₂ qui recule ? » (Oui, c’est moins sexy qu’un selfie sous les tropiques, mais c’est plus durable que l’île sur la photo). Si nous échouons, nous aurons été brillants dans l’accessoire et médiocres dans l’essentiel. Si nous réussissons, nous aurons enfin prouvé que l’espèce qui comprend ses limites est aussi celle qui s’émancipe par la créativité, l’éthique… Allez, on y va ?

Xania Monet, une star est née !

Discussion audio sur la base de cet article réalisée avec NotebookLM

Xania Monet bouscule la musique autant qu’elle la chante. Figure née d’un clavier et d’une plume, elle vient d’arracher un contrat de trois millions de dollars avec Hallwood Media après une surenchère entre producteurs. Oui, trois millions pour une artiste dont la voix sort d’un modèle génératif et dont les textes viennent d’une femme bien réelle, Telisha Nikki Jones, poétesse et cheffe de studio près de Memphis. Suno sert d’atelier. La radio du futur a démarré dans un salon du Mississippi. Les chiffres donnent le vertige. Entrée dans les classements RnB. Cent trente huit mille auditeurs mensuels sur Spotify au compteur. Des singles qui circulent comme de l’oxygène dans les stories. La scène n’a rien de théorique. J’imagine un lycéen qui rentre du foot. Casque sur les oreilles. The strong don’t get a break. Le refrain lui parle. Ce gamin se fiche de savoir si un micro ou un algorithme a sculpté le timbre. Il veut un frisson net.

Reste l’ombre portée. On craint l’usine à avatars, la dilution des droits et l’opacité des données apprises par des modèles nourris au droit flou. Inquiétude légitime. Une industrie peut perdre son âme à force de confondre voix et vernis. Pourtant, nier Monet reviendrait à se bander les yeux au bord d’une autoroute. Les artistes d’hier sont des marins à voile. Monet arrive en hydroptère. Le vent compte encore. Le capitaine aussi. La différence se joue sur la lecture des courants. Si l’on exige traçabilité des jeux de données, crédit clair aux autrices et partage équitable de la valeur, l’hydroptère ne coulera personne. Il dessinera de nouvelles routes. Et peut-être que Nikki Jones montera un jour sur scène avec son double numérique. On aura alors un duo étonnamment humain. Comme je l’écris depuis des années (2016), la place de l’humain se renforce lorsqu’il collabore avec la machine, non quand il la mime.

La suite dépend de nous. Pas des serveurs. Des règles. Des contrats précis. De l’audace des maisons et du courage des artistes. L’étoile est artificielle, l’émotion ne l’est pas. À nous d’en rendre compte.

la stratégie d’investissement de NVIDIA

Discussion audio sur la base de cet article réalisée avec NotebookLM

La rumeur devenue est devenu annonces publiques autour d’un engagement financier pouvant atteindre cent milliards de dollars au profit d’OpenAI pour bâtir jusqu’à dix gigawatts de centres de données équipés en GPU maison trace la ligne de crête de la stratégie de NVIDIA. C’est une façon de verrouiller la prochaine génération d’infrastructures tout en gardant la main sur la chaîne de valeur des puces à l’inférence, quitte à recourir à des montages où OpenAI louerait les systèmes plutôt que de les acquérir. On croirait lire un manuel de tactique industrielle. Et c’est bien le cas. Ce coup d’accélérateur ne tombe pas du ciel. Depuis deux ans, Nvidia a structuré NVentures comme bras armé de son capital risque. Objectif affiché : soutenir les bâtisseurs de plateformes et d’outils qui amplifient l’usage des GPU. Dit autrement. Plus l’écosystème grossit, plus le cœur bat fort.

Regardons les pièces qui se mettent en place. Les humanoïdes de Figure AI. Nvidia a mis de l’argent sur la table aux côtés de Microsoft et d’OpenAI. Résultat ? Un pipeline d’usages qui réclame du calcul lourd et qui raconte déjà la prochaine vague de demande pour les accélérateurs. Autre pièce maîtresse : CoreWeave. Tantôt client, tantôt allié, parfois cible d’accords de rachat de capacité. Nvidia sécurise des volumes et des débouchés avec un contrat pluriannuel à plusieurs milliards. Si CoreWeave ne vend pas tout son nuage, Nvidia rachète. En cas de ruissellement, les puces ne dorment jamais.

On pourrait croire à une dispersion tous azimuts. C’est l’inverse. Cette politique d’investisseur compose une symphonie à trois mouvements. D’abord l’infrastructure (data centers, cloud spécialisés, logistique énergétique, …), ensuite les applications tractrices (robots, véhicules, biologie, médias génératifs, …) et enfin l’outillage (langages, frameworks, services de mise à l’échelle, …). La presse financière recense déjà des dizaines de tickets cette année. Une cadence élevée pour un industriel qui n’avait pas, historiquement, cette réputation d’hyperactivité capitalistique. Tout cela nous mène à une économie du calcul vue comme un service de base au même rang que l’électricité ou l’eau. Cette vision pousse l’innovation à la frontière plutôt que dans les couloirs des sièges sociaux. Elle a toutefois un coût caché. La dépendance stratégique des start-up à un fournisseur qui devient à la fois investisseur, client et donneur d’ordres. C’est confortable jusqu’au jour où les priorités changent.

On objectera que cette marche en avant écrase le débat humain. C’est ignorer un enseignement ancien. La croissance durable viendra moins du avoir plus que du être mieux et de la coopération fine entre humains et systèmes. La vraie boussole se trouve là, dans la qualité des usages et la productivité retrouvée, pas dans la seule course aux records de capital engagé. Un exemple concret vaut mieux qu’un slogan. Imaginez une pépite européenne qui conçoit un modèle de chimie computationnelle. Elle prend un ticket minoritaire de Nvidia via NVentures, réserve du temps de calcul chez un partenaire comme CoreWeave, codéploie une pile logicielle intégrée, et se greffe demain à un centre Stargate exploité par OpenAI. Le parcours paraît cousu main. Il l’est. La startup gagne en vélocité, Nvidia en traction pour ses GPU, OpenAI en sources de données et de cas d’usage. Chacun y trouve son compte, à condition de garder une sortie de secours. Un contrat clair sur les données, des clauses de portabilité, un plan B multi-cloud, ….

Je ne parie pas sur une bulle qui éclate demain matin. Je parie sur un durcissement du jeu. Plus de concurrence sur toute la chaîne de valeur et plus de négociation sur le leasing des puces. Dans cette partie, Nvidia avance une stratégie offensive. Investir pour irriguer. Capillaires d’abord. Artères ensuite. Et tant pis si cela froisse les puristes. Les écosystèmes gagnent toujours contre les forteresses.

A suivre et à surveiller !

Bonnes métamorphoses et à la semaine prochaine.

Stéphane