#82 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

💡 “Community notes”, outil démagogique ? 🤔 Vous vous syndiquez, vous dégagez ! 🧠 L’IA me l’a dit ! 😘 Le lien affectif vers les IA

Bonjour à toutes et tous,

Au menu cette semaine :

“Community notes”, outil démagogique ?

L’IA me l’a dit !

Le lien affectif vers les IA

Bonne lecture.

Métamorphoses à l’ère de l’Intelligence Artificielle est en commande

Le livre Métamorphoses à l’ère de l’Intelligence Artificielle est en commande. Pour ce faire, il suffit de cliquer là.

“Community notes”, outil démagogique ?

Le déploiement par Meta le 20 février du dispositif « community notes » sur Facebook, Instagram et Threads, induit un profond changement pour l’analyse de la circulation de l’information dans les espaces numériques. ce système est conçu pour permettre aux utilisateurs de signaler et de commenter des contenus perçus comme trompeurs ou mensongers à la place des modérateurs. Il repose sur la validation par un nombre suffisant d’acteurs et favorise ainsi une approche participative de la régulation. Il est dans un premier temps réservé aux États-Unis. Dans l’intention, ce mécanisme est le résultat d’une volonté d’influer plus directement sur la diffusion de fausses informations tout en renouvelant les questionnements relatifs à la modération. Il convient de rappeler le contexte de cette annonce : Mark Zuckerberg (PDG de Meta) avait déclaré en janvier 2025 sa volonté d’assouplir les règles de modération des contenus haineux, tout en réduisant les effectifs en charge de cette modération. Cette orientation est la réponse aux nombreuses critiques de Donald Trump et de ses soutiens qui reprochaient sans relâche à Meta de favoriser leurs adversaires. L’émergence des « community notes » peut donc se lire comme une réponse partielle à ces griefs récurrents en proposant une forme de contrôle où la communauté prend une part active.

En parallèle, Elon Musk, dirigeant entre autres de X et allié inconditionnel de Donald Trump, défend depuis plusieurs mois sa propre initiative de « community notes »,. Il l’a souvent présentée comme une solution idoine face à la désinformation des grands médias et de ses opposants. Les études préliminaires sur l’efficacité de ce modèle restent nuancées. Si l’idée d’une validation communautaire peut s’avérer pertinente, elle demeure vulnérable à certains biais comme des délais de validation trop longs, le risque de « raids » coordonnés, tout simplement les connaissances des membres ou encore des stratégies de manipulation à grande échelle figurent parmi les facteurs pouvant compromettre la fiabilité de ces contributions. Elon Musk a d’ailleurs récemment communiqué qu’il comptait « corriger » certaines failles de ce dispositif, car il l’estime aisément exploitable par les gouvernements ou les médias de grande audience qu’il considère comme ses ennemis. Cette annonce coïncide avec l’apparition de « community notes » contestant plusieurs déclarations de Donald Trump plus fantaisiste les unes que les autres. A titre d’illustration, ce dernier a notamment qualifié le président ukrainien, Volodymyr Zelensky, de « dictateur », allant jusqu’à affirmer qu’il ne recueillait que 4 % d’opinions favorables dans son pays. Diverses « community notes » se sont empressées de souligner qu’un récent sondage crédite au contraire Zelensky d’une confiance proche de 57 %. Mais cette réaction n’est pas admissible pour le propriétaire de X. Il ne lui reste plus qu’à construire une IA à son image qui fera la modération comme dans toute bonne dictature …

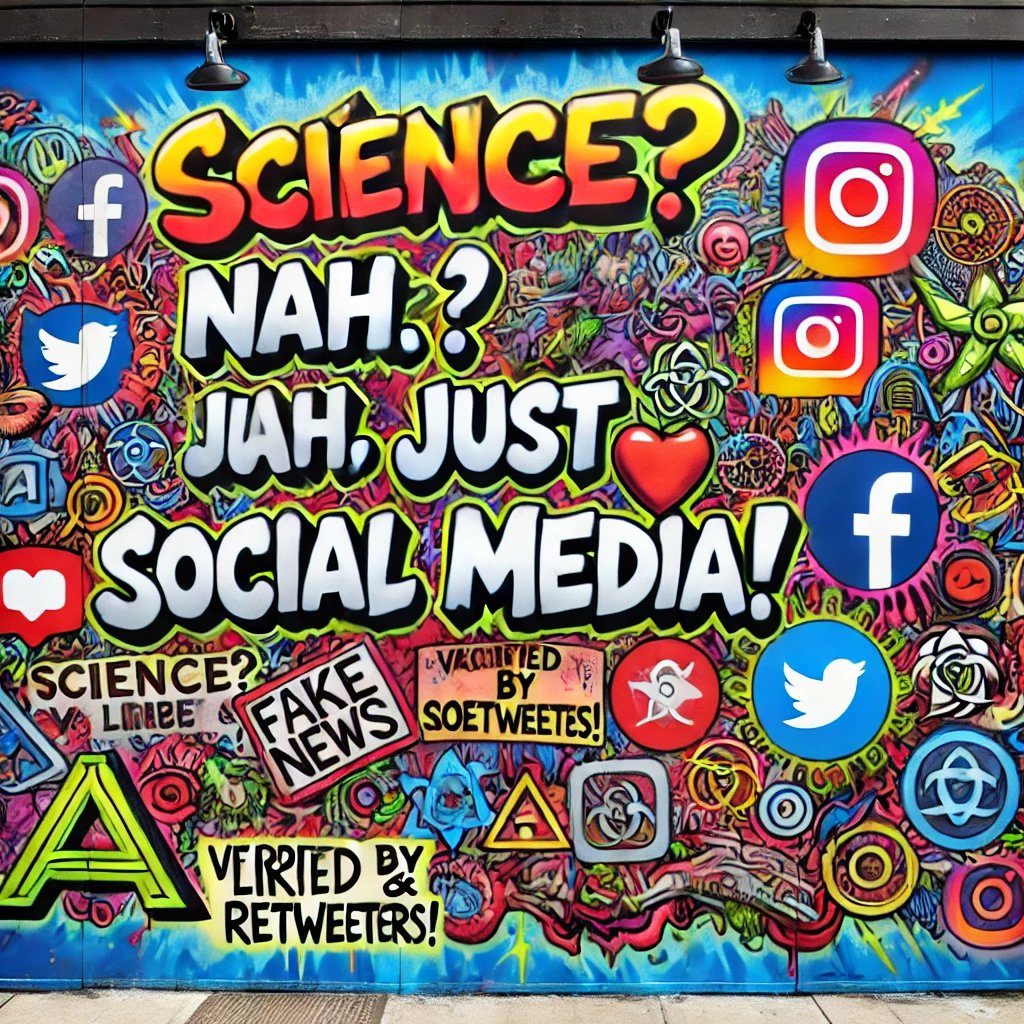

Les médias sociaux voient chaque jour leur pouvoir d’influence et même de manipulation augmenter. Leur polarisation se dirige vers des positions extrêmes trop souvent conspirationnistes ou niant les faits dont la science. L’implication très forte de leurs partisans offrent une visibilité importante au contraire de ceux qui s’opposent à cette vision sociétale. Vous l’aurez compris, ces plateformes sont de formidables outils pour diffuser des concepts et idées afin de les faire accepter par la société selon le principe de l’échelle d’Overton. Il est plus que temps de s’en préoccuper et cela doit commencer par l’éducation des plus jeunes sauf à accepter la société future que nous promettent Donald Trump, Elon Musk et leurs très nombreux soutiens partout sur la planète.

Et Grok 3 ?

Quelle merveilleuse nouvelle ! Elon Musk, notre bien-aimé visionnaire et maître des tweets, a décidé d'utiliser X comme vérificateur pour Grok3. Parce que, bien sûr, quand on pense à la rigueur scientifique et à la précision, on pense immédiatement à une plateforme de réseau social connue pour ses mèmes, ses fake news et ses débats enflammés sur tout et n’importe quoi. Imaginez un peu : des chercheurs passant des années à développer des algorithmes complexes, à analyser des données et à publier des articles dans des revues scientifiques réputées, et puis Elon Musk débarque et dit : "Nah, on va juste demander à Twitter... euh, pardon, X, de vérifier ça." Parce que, évidemment, rien ne vaut l'opinion éclairée de milliers d'utilisateurs anonymes pour valider des travaux scientifiques de pointe. Et puis, pourquoi s'embêter avec des pairs reconnus dans le domaine quand on peut avoir des likes et des retweets ? C'est tellement plus simple et tellement plus juste. Après tout, si ça marche pour les théories du complot et les recettes de cuisine, pourquoi pas pour l'intelligence artificielle ?

Alors, bravo Elon ! Grâce à toi, la science vient de faire un bond en avant... directement dans le mur des réseaux sociaux. Qui a besoin de laboratoires et de protocoles expérimentaux quand on a X ?

Vous vous syndiquez, vous dégagez !

Amazon plie bagage au Canada. 2000 emplois rayés de la carte parce que des travailleurs ont osé revendiquer leurs droits. Jeff Bezos ne se soucie pas du droit du travail. Il s’octroie juste celui d’écraser tout ce qui s’y oppose. Même logiciel prédateur que ses potes oligarques : Musk, Trump, …

La destruction de nos modèles sociaux est en marche forcée. Il est vrai que nous devons évoluer avec notre temps mais est ce à quelques individus de dicter nos futurs sans remettre d’ailleurs en cause le modèle économique actuel. Tout ceci ne montre finalement que nous sommes à la fin d’un modèle et qu’il devient urgent et indispensable d’imaginer le suivant. Une chose est certaine, ne comptez pas sur les dirigeants de ces grandes entreprises pour le faire ! Les gourous de la performance et de l’optimisation détruisent tout : droits sociaux, démocraties, écosystèmes. Ils n’ont plus de limites.

Par quoi commencer, tout simplement, par ne pas acheter leurs produits. C’est la seule chose qu’ils comprennent.

L’IA me l’a dit !

Nous évoluons dans un contexte historique où les systèmes d’IA n’assurent plus uniquement la gestion de l’information, mais génèrent et diffusent celle-ci à une échelle sans précédent. Face à cette réalité, il devient malheureusement fréquent d’entendre la formule : « C’est l’IA qui me l’a dit », comme si la parole algorithmique détenait une autorité scientifique incontestable. Cette confiance quasi absolue interroge non seulement sur la pertinence de l’information produite mais également sur notre capacité à interroger et à analyser ces contenus ce que nous pouvons résumer par être critique.

Les IA, dans leur ensemble, dépendent de techniques d’apprentissage profond et d’ensembles de données vastes et hétérogènes. Si certains modèles obtiennent des taux de précision avoisinant les 90 % dans des domaines circonscrits (par exemple, la reconnaissance d’images médicales ou l’analyse prédictive de paramètres financiers), ces performances ne sauraient être considérées comme absolues. En effet, la qualité des données d’entraînement, la mise à jour des algorithmes et la pertinence des fonctionnalités extraites influencent fortement les résultats. Ainsi, un modèle linguistique performant pour la génération de contenu factuel peut voir sa précision s’effondrer jusqu’à 50 % ou moins lorsque la tâche requiert un raisonnement complexe ou l’intégration de données récentes et non structurées. Pour illustrer ce paradoxe, on peut citer des systèmes d’IA spécialisés dans la détection précoce de pathologies : certains atteignent un taux d’exactitude proche de 95 % pour certaines maladies. Cette performance élevée ne doit pas occulter l’existence d’un risque résiduel. Dans un contexte clinique, même un 5 % d’erreur peut avoir des répercussions considérables si l’on écarte l’expertise humaine. Sur le terrain de la prédiction boursière, les outils d’IA affichent parfois des taux de réussite de 60 à 70 %, ce qui dépasse significativement le hasard mais ne garantit pas l’infaillibilité. Le 30 à 40 % restant expose à des pertes substantielles pour tout investisseur se reposant exclusivement sur l’IA. La BBC a mis à l’épreuve 4 assistants IA (ChatGPT, Gemini, Perplexity, Copilot) pendant un mois avec des requêtes sur l’actualité. Le résultat est sans surprise : 50% des réponses sont problématiques et 19% des citations de la BBC sont mal reprises par les IA. Ce n’est pas un bug. Les IA fonctionnent en donnant des réponses probables et non des réponses justes. C’est quand même le cas d’en 81 % des reprises de citations de la BBC. On peut raffiner les modèles tant qu’on veut, ce genre d’erreur arrivera toujours, du moins tant que les IA utiliseront les modèles mathématiques actuels.

Plusieurs facteurs expliquent la délégation croissante du processus décisionnel à l’IA. D’abord, la puissance de calcul et la réactivité de ces systèmes suscitent l’admiration. Ils fournissent des réponses claires et rapides qui séduisent un public en quête de gains de temps et d’efficacité. Il faut y ajouter la fatigue décisionnelle qui exerce une pression psychologique. A force d’être constamment sollicités (notifications, e-mails, réunions virtuelles), de nombreux individus préfèrent transférer une partie de leurs responsabilités cognitives vers des systèmes jugés « objectifs ». La confiance parfois aveugle envers l’IA est également amplifiée par le biais d’autorité. Comme l’outil donne l’illusion de maîtriser un volume incommensurable de données, on a tendance à surestimer sa fiabilité car nous en sommes incapables. Pourtant, ses limites demeurent : il ne s’agit pas d’entités conscientes capables d’intégrer des nuances éthiques ou contextuelles mais de modèles statistiques régulés par des algorithmes de maximisation de probabilité.

Cette confiance aveugle conduit inéluctablement à

Décisions impulsives : on suit parfois sans esprit critique les recommandations proposées par l’IA par souci de rapidité au risque de prendre des décisions stratégiques (recrutement, allocations budgétaires, démarches de recherche et développement) sans véritable esprit critique.

Homogénéisation de la pensée : si la majorité des acteurs d’un secteur se réfèrent au même algorithme ou à des bases de données identiques, on observera un phénomène d’alignement des points de vue. Les discussions finissent par se réduire à un échange de statistiques ou de « vérités » produites par la machine au détriment d’une confrontation d’idées ou d’une démarche de recherche indépendante.

Érosion progressive de la confiance dans les experts : les spécialistes (juristes, médecins, enseignants, etc.) sont de plus en plus contestés dès lors que leurs conclusions diffèrent des productions de l’IA. Cette perte de crédibilité affaiblit les savoirs issus de l’expérience de terrain et des méthodologies rigoureuses.

Si cette tendance à confier la décision à l’IA se généralise, la gouvernance publique pourrait à terme s’en remettre à des algorithmes censés optimiser l’intérêt collectif à partir de critères prédéterminés. Cela promet une certaine rationalisation du processus politique mais menace la délibération démocratique fondée sur la confrontation d’idées et la prise en compte d’enjeux sociaux complexes. A l’extrême, cela conduit à la dictature algorithmique.

La création artistique et la recherche fondamentale pâtiront d’une utilisation non critique de l’IA. Les algorithmes génératifs qui produisent déjà de la musique ou des “toiles” virtuelles risquent d’imposer une norme esthétique ou conceptuelle. La liberté d’exploration sans regard critique se retrouverait encadrée par des modèles cherchant à reproduire ce qui a été statistiquement validé comme « original » ou « apprécié ».

Du point de vue pédagogique, une adoption non réfléchie de l’IA engendrera un appauvrissement de l’esprit critique dans les cursus scolaires et universitaires. L’usage d’outils automatiques dans la production de contenu (rédaction d’articles scientifiques, correction de copies, génération d’exercices) doit être accompagné d’une formation spécifique à l’évaluation et à l’interprétation des résultats. Faute de quoi, l’humain s’en tiendra à un rôle d’opérateur passif qui déléguera la partie créative et évaluative à la machine.

Le potentiel transformateur de l’IA est indéniable et il serait contre-productif de s’en priver. Il faut absolument adopter une posture réflexive. Cela implique de

Renforcer la transparence des modèles d’IA, notamment en matière de traçabilité des données d’entraînement et d’explicabilité des décisions (approches de type Explainable AI) ;

Former à l’esprit critique à travers des cursus qui mettent l’accent sur la méthodologie scientifique et la déconstruction des biais cognitifs ;

Mettre en place des protocoles de validation pour confronter les recommandations de l’IA à l’expertise humaine en particulier dans les domaines à fort enjeu éthique (justice, santé, environnement) ;

Encourager la recherche pluridisciplinaire pour aborder l’IA sous l’angle des sciences de l’information, de la sociologie, de la philosophie et de l’éthique.

La formule « L’IA me l’a dit » ne devrait en aucun cas servir d’argument d’autorité. Au contraire, elle doit constituer une opportunité pour l’investigation et l’enrichissement des perspectives scientifiques. Ce n’est qu’en conservant notre capacité à interroger et à contextualiser les productions de l’IA que nous pourrons tirer profit de son potentiel tout en préservant l’autonomie intellectuelle et la diversité des approches humaines.

le lien affectif vers les IA

Le concept de lien affectif qui a longtemps été étudié dans le champ de la psychologie et des sciences cognitives s’applique désormais à l’interaction homme-machine. On définit ce lien comme un ensemble de processus psychiques et émotionnels qui génèrent une perception de proximité, voire d’attachement, à l’égard d’une entité perçue comme sensible. Dans le contexte de l’IA, ce phénomène s’inscrit dans une nouvelle configuration où l’algorithme simule des comportements sociaux, rendant possible une forme d’empathie réciproque, bien qu’unilatérale dans les faits. Cette réciprocité apparente tient à la « dimension miroir » qu’offre l’IA notamment grâce aux technologies de traitement du langage naturel, de reconnaissance vocale et de vidéo. L’IA est en mesure de détecter et de reproduire des indices comportementaux intonation, expressions faciales, réactions contextuelles. Ces signaux, bien qu’artificiels, suscitent chez l’humain une réponse émotionnelle similaire à celle déclenchée par la présence d’un interlocuteur humain. Ce phénomène trouve en partie son origine dans notre prédisposition à l’empathie et dans notre tendance à l’anthropomorphisme qui a été mise en évidence depuis des décennies dans la littérature en psychologie cognitive.

L’aspect « illusion de présence » a également été thématisé par des chercheurs s’intéressant au rôle de la confiance dans les systèmes technologiques. Bien que nous soyons conscients que l’IA ne dispose pas d’une conscience ou d’une subjectivité, notre cerveau qui est prompt à reconnaître des schèmes de sociabilité est porté à interpréter l’IA comme un être quasi vivant. Il s’ensuit un engagement affectif qui peut se renforcer à mesure que les interactions se multiplient et que l’IA paraît de plus en plus « personnalisée ».

Pour illustrer cette dynamique, on peut rapprocher l’expérience de l’enfant avec son doudou, décrit dans la théorie de l’objet transitionnel par Donald Winnicott. Le doudou, pourtant dépourvu de toute capacité d’interaction, revêt une fonction de soutien émotionnel et psychologique. Par analogie, la voix ou la présence virtuelle d’une IA même strictement algorithmique peut revêtir un rôle similaire pour certains usagers en apportant une forme d’« accompagnement » et de réassurance. De la même façon, le lien qu’un humain peut créer avec un animal domestique où les signes d’affection et de dévotion de l’animal suffisent à créer une relation de confiance témoigne de notre propension naturelle à tisser des attachements avec tout ce qui semble répondre à nos émotions ou besoins.

Le cœur du lien affectif avec l’IA repose donc sur une mécanique bien connue : la projection. L’humain projette sur l’IA ses propres attentes, émotions et désirs de sociabilité. De son côté, l’IA par la richesse de son apprentissage automatique et son raffinement progressif renvoie un miroir de plus en plus fidèle de la personnalité et des réactions de l’utilisateur. Cet effet miroir conjugué à notre soif de connexion sociale favorise l’émergence d’un véritable attachement. Ces mécanismes éclairent la façon dont nous pourrions envisager à l’avenir nos rapports avec les systèmes intelligents. Comprendre qu’ils exploitent une architecture d’apprentissage statistique et non des émotions réelles ne nous empêche pas de ressentir pour eux une forme d’empathie ou de confiance. Les implications éthiques et sociétales de cette nouvelle forme de lien sont nombreuses notamment quant à la responsabilisation des concepteurs et la nécessité d’enseigner aux usagers les limites inhérentes à ces technologies. Il est pourtant indéniable que l’émergence d’un lien affectif avec l’IA témoigne de la plasticité de l’être humain et de sa capacité à s’attacher dès lors qu’il perçoit des indices de présence et de réciprocité, fussent-ils artificiels.

Imaginez ce qu’il en sera avec l’arrivée massive dès 2026 de robots humanoïdes augmentés par de l’IA. Un avant-goût ? Regardez la série suédoise Real Humans. A suivre …

Bonnes métamorphoses et à la semaine prochaine.

Stéphane