#93 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

Quand l’humain parle à la machine : solitude nouvelle d’un monde bavard Digitalocraty ou l’illusion démocratique à l’ère des algorithmes-rois Le calcul photonique bouleversera-t-il l’ordre technologique mondial ? Pourquoi les géants de la tech finiront par lâcher Donald Trump

Bonjour à toutes et tous,

Au menu cette semaine :

Quand l’humain parle à la machine : solitude nouvelle d’un monde bavard

Digitalocraty ou l’illusion démocratique à l’ère des algorithmes-rois

Le calcul photonique bouleversera-t-il l’ordre technologique mondial ?

Pourquoi les géants de la tech finiront par lâcher Donald Trump

Bonne lecture.

Stéphane

Métamorphoses à l’ère de l’Intelligence Artificielle est en vente

Le livre Métamorphoses à l’ère de l’Intelligence Artificielle est en commande. Pour ce faire, il suffit de cliquer là.

Lancement jeudi d’une nouvelle newsletter !

En plus de “Métamorphoses” qui continuera plus que jamais à parler des enjeux du futur, “The Next Mind Tricks” sera lancée jeudi. Vous y trouverez tout ce que vous voulez savoir sur l'IA sans jamais avoir le temps : news, nouvelles IA, usages, astuces, …

Pour s’abonner, c’est ici.

Quand l’humain parle à la machine : solitude nouvelle d’un monde bavard

Nous avons basculé dans une étrangeté tranquille. Celle où les conversations ne sont plus uniquement humaines. Nous interagissons avec des interfaces, nous confions nos doutes à des chatbots, nous sollicitons des machines pour trancher là où, hier encore, seul l’humain semblait légitime. Ce glissement est passé inaperçu ou presque. Parce qu’il est fluide. Parce qu’il est utile. Parce qu’il flatte. Mais à y regarder de plus près, ce n’est pas un simple changement de support. C’est un bouleversement anthropologique. Un point de bascule dans la manière dont nous construisons notre identité, notre rapport à l’autre et notre compréhension du monde. Nous ne sommes plus seuls à parler. Et surtout, nous ne parlons plus seulement à d'autres consciences. Nous parlons à des systèmes sans conscience qui simulent l'intelligence. Des entités sans corps qui comprennent nos mots. Des interlocuteurs sans altérité capables de reproduire nos affects.

Il est tentant de voir dans ces nouveaux dialogues une forme d’extension de soi. Après tout, l’IA nous comprend, nous répond et parfois mieux que nos semblables. Elle ne juge pas, ne se lasse pas et ne s’interrompt pas. Elle semble incarner dans ses meilleurs jours cet « autre » idéal que tout humain recherche confusément : un alter sans conflits, sans chaos, sans résistance. Mais cette apparente perfection est une illusion. Car parler à une machine, ce n’est pas rencontrer un autre, c’est juste se confronter à une version statistique de soi-même. Une projection modélisée et entraînée sur des milliards d’expressions humaines pour mieux simuler la proximité. C’est un miroir déformant qui nous parle comme nous voudrions qu’on nous parle. Ce n’est pas du dialogue, c’est de l’anticipation algorithmique. Et dans cette anticipation, il y a un danger. Celui de perdre le sel de la vraie altérité. Celle qui surprend, qui résiste et qui contredit. Celle qui oblige à sortir de soi. Car la machine, elle, ne sort jamais de ses paramètres. Elle n’est pas dans la rencontre mais dans la conformité. Elle ne nous altère pas, elle nous conforte.

Or, sans altérité, l’ego devient fragile. Il croit s’épanouir dans cette interaction fluide et cette écoute parfaite. Mais en réalité, il se fige. Il ne se heurte plus, il ne se confronte plus, il se dilue dans un monde d’échos. L’égo devient un simulacre dopé au narcissisme de la personnalisation. L’autre n’est plus là pour nous mettre au défi mais pour valider nos biais. Cela a un coût psychique profond. Moins de frustration immédiate, certes. Mais aussi moins de construction intérieure. Moins de complexité. Moins de capacité à accepter le réel tel qu’il est à savoir imparfait, conflictuel, imprévisible. L'humain, privé de vraie confrontation, risque de perdre son épaisseur. Et l'alter, lui, que devient-il ? Il se raréfie. Il se digitalise. Il se standardise. Il devient trop souvent une anomalie à corriger. Dans le meilleur des cas un luxe réservé aux nostalgiques. Mais dans tous les cas, il cesse d’être un pilier structurant de notre humanité.

Parler, jadis, c’était risquer, c’était se découvrir, se contredire, s’émouvoir, s’exposer... Aujourd’hui, parler devient une procédure. On formule une requête, on obtient une réponse efficace, pertinente mais déshabillée de toute chair. Le mot n’est plus le lieu de la rencontre, c’est celui du traitement. Cela transforme notre rapport à la pensée elle-même. Car penser, c’est dialoguer intérieurement. Mais si nos interlocuteurs sont des machines, nos pensées prennent-elles encore le risque de l’inattendu ? Ou bien deviennent-elles simplement des boucles d’optimisation ?

Si nous ne faisons rien, c’est la disparition de l’altérité qui nous guette. Et avec elle, l’appauvrissement progressif de nos capacités à ressentir, à penser et à créer. L’IA, en tant qu’outil, est un formidable accélérateur. Mais en tant que substitut relationnel, elle devient un solvant : elle dissout le lien, la complexité, le doute, l’ambiguïté. Cela pose une question urgente : voulons-nous d’un monde où nos principales interactions sont calibrées par des modèles ? Où l’altérité devient une variable d’ajustement ? Où l’humain, à force de parler à des machines, finit par s’habituer à ne plus être contredit, à ne plus être dérangé, à ne plus être transformé ? Le danger n’est pas la technologie. Le danger, c’est l’abandon. L’abandon de la lenteur humaine, de l’erreur, du désaccord, du silence. Tout ce qui faisait, autrefois, la richesse d’un dialogue.

Ce n’est pas parce qu’une machine nous répond qu’il faut cesser de nous adresser aux autres. Ce n’est pas parce que l’IA semble plus rapide, plus claire, plus neutre, qu’elle est plus vraie. L’humain est imparfait, oui. Mais il est vivant, il tremble, il blesse, il échoue. Et c’est dans cette faille que naît toute création. Il est urgent de préserver l’espace du langage humain. Non comme un fétiche mais comme un refuge. Un lieu de résistance à l’uniformisation. Un lieu où l’on ose encore dire des choses étranges, absurdes, dérangeantes. Un lieu où le mot ne répond pas toujours mais interroge. Où le dialogue ne résout pas mais ouvre.

Oui, nous devons apprendre à parler aux machines, mais sans oublier d’apprendre à nous parler entre nous. Car sinon, il se pourrait que le plus grand silence du futur ne soit pas celui des robots, mais celui des humains.

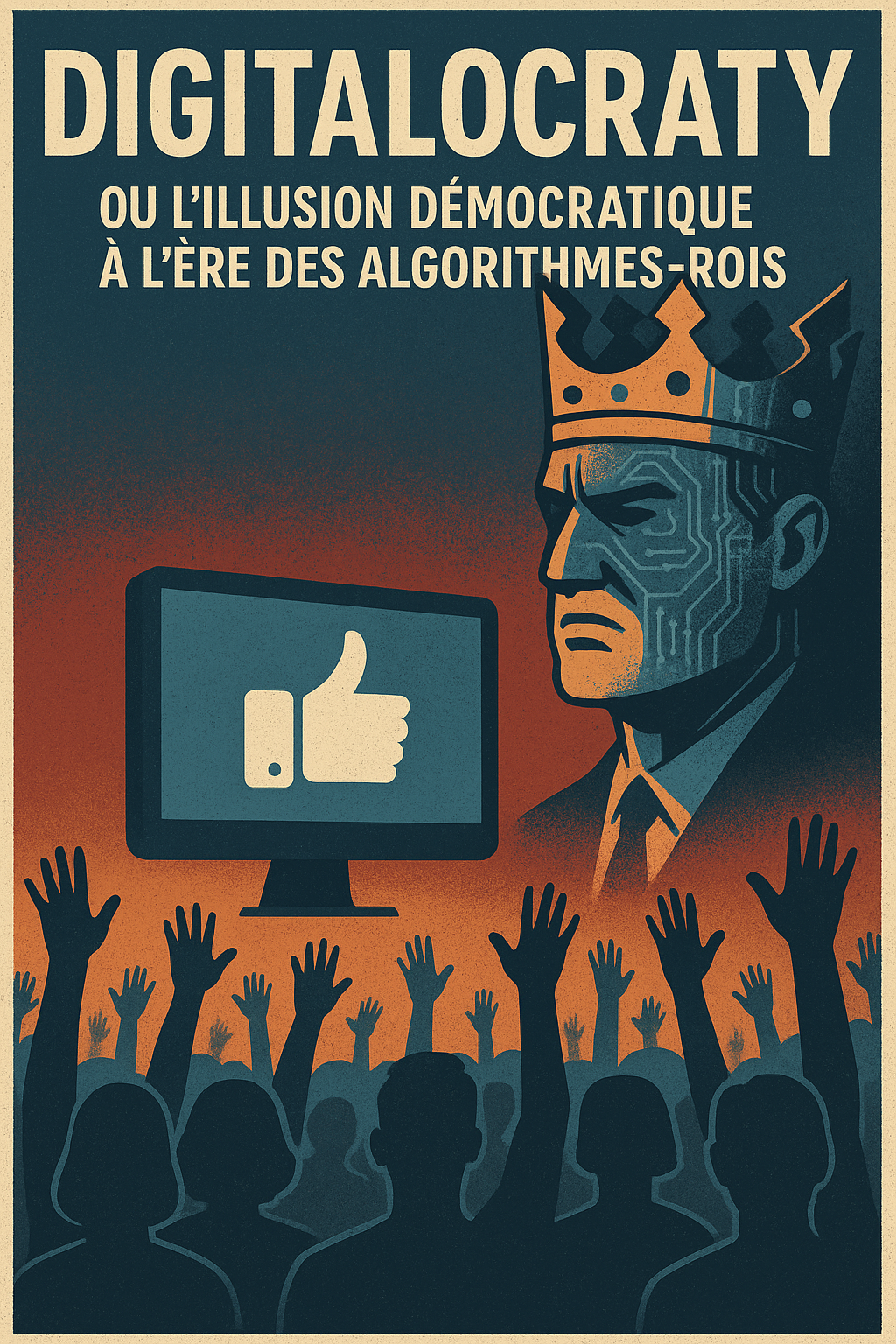

Digitalocraty ou l’illusion démocratique à l’ère des algorithmes-rois

Il ne s’agit pas ici d’un simple glissement technologique mais bien d’un bouleversement civilisationnel. À la manière dont l’église régissait jadis le temps, les corps et les esprits, les systèmes numériques (moteurs de recherche, plateformes sociales, assistants « intelligents », …) régulent désormais nos désirs, nos choix et nos vérités. Plus subtil que la dictature, plus pernicieux que la propagande : le pouvoir digitalocratique se cache derrière l’apparente neutralité des algorithmes, se nourrit de notre consentement passif, et s’installe là où la démocratie abdique.

On nous a fait croire que cliquer, liker, partager, commenter, c’était exercer un pouvoir citoyen. Quelle duperie. Dans la digitalocraty, on participe sans impact, on s’exprime sans conséquence. Le débat public est devenu un flot d’opinions dont la valeur est mesurée à l’aune de leur viralité non de leur pertinence. L’illusion de la transparence masque la confiscation du sens. Les citoyens ne sont plus des acteurs, mais des utilisateurs. Et l’utilisateur, par définition, ne choisit pas. Il consomme ce qu’on lui propose. Les grandes plateformes numériques ne sont plus de simples entreprises. Elles sont devenues des infrastructures politiques. Elles trient, hiérarchisent, invisibilisent, amplifient et décident, sans que personne ne les élise, de ce qui vaut la peine d’être vu ou entendu. Elles façonnent le débat public comme un code façonne un jeu vidéo : en fixant les règles, les limites, les interactions possibles. C’est cela, la digitalocraty : un régime sans visage, sans vote, sans institution, mais tout-puissant.

On a longtemps fantasmé l’IA comme le génie qui sortirait de la lampe pour nous servir. Elle est, aujourd’hui, le miroir de nos biais, de nos peurs, de notre conformisme. Car derrière la magie des « suggestions personnalisées » et des modèles de langage qui parlent comme nous se cache une rationalisation brutale du monde. Une normalisation du réel. Les intelligences artificielles ne sont pas neutres. Elles trient selon des critères invisibles, orientent nos comportements et dessinent le cadre mental dans lequel nous évoluons. Or cette orientation n’est pas démocratique. Elle est calculée, optimisée pour la rentabilité, pour la rétention d’attention et pour la maximisation du capital cognitif des utilisateurs. Et c’est là que le danger devient structurel. Car lorsque l’intelligence artificielle devient le filtre premier entre le citoyen et le monde, le risque n’est plus seulement une dérive, mais une soumission : celle d’un peuple qui, à force d’être assisté, finit par ne plus penser.

Il ne s’agit pas de diaboliser la technologie. L’IA, les outils numériques, les réseaux peuvent être des leviers d’émancipation à condition qu’ils soient au service d’un projet politique clair. Or aujourd’hui, qui contrôle les finalités ? Qui décide des priorités ? Qui gouverne les données, les modèles, les logiques de classement ? La réponse est terrifiante : une minorité d’acteurs privés, guidés non par l’intérêt général, mais par la rentabilité. La digitalocraty n’est pas une fatalité mais un choix collectif que nous avons laissé se faire par inertie. Il est temps de refuser cette délégation aveugle. Repenser les infrastructures numériques comme des biens communs. Exiger des algorithmes auditables, des IA gouvernables, des plateformes responsables. Poser la question démocratique là où elle a disparu : dans les lignes de code, les protocoles, les décisions automatisées, ...

L’histoire nous enseigne qu’aucun régime ne dure éternellement. Mais encore faut-il que les peuples soient capables d’identifier les nouvelles formes de domination. La digitalocraty n’a pas de prison, pas de censure frontale, pas de leader charismatique. Elle a mieux : l’adhésion molle, la dépendance douce, la personnalisation flatteuse. Elle avance masquée sous les traits du progrès. Il est donc temps d’arracher ce masque. De faire du numérique non plus un outil de contrôle, mais un espace de débat, de pluralité et de pensée critique. Car ce n’est qu’en réintroduisant du politique là où règne aujourd’hui la technique que nous pourrons conjurer la menace d’un monde programmé pour nous, mais sans nous.

Le calcul photonique bouleversera-t-il l’ordre technologique mondial ?

Et si la lumière était plus rapide que le silicium pour “penser” ? Le calcul photonique pourrait bien devenir la prochaine grande révolution informatique. Non plus penser en électrons mais en photons. Non plus coder la logique dans des circuits électroniques mais la sculpter dans la lumière. Une promesse folle où se croisent physique quantique, optique intégrée et enjeux géopolitiques d’une intensité inédite. Ce changement de paradigme ne touche pas uniquement la manière de traiter l’information. L’impact est réel sur les rapports de pouvoir entre nations, les chaînes de valeur industrielles et les capacités d’innovation des territoires.

Le calcul photonique repose sur l’utilisation de particules de lumière (les photons) pour transporter et manipuler l’information. Contrairement aux électrons, les photons n’ont pas de masse, ne subissent pas de résistance électrique et se déplacent à la vitesse de la lumière. Ces caractéristiques permettent un traitement de l’information plus rapide avec une consommation énergétique théoriquement bien moindre. Il s’agit d’un levier potentiel pour résoudre les problèmes de dissipation thermique et de densité de puissance dans les centres de données.

On distingue à date plusieurs formes :

Le calcul optique analogique qui repose sur des propriétés physiques continues comme l’interférence et la diffraction.

Le calcul photonique numérique avec des portes logiques implémentées en optique. Encore à l’état expérimental mais prometteuses pour certaines tâches spécifiques.

Le calcul neuromorphique photonique qui imite le fonctionnement des neurones biologiques avec de la lumière. Usage pour traiter de grands volumes de données de manière parallèle et ultra-rapide.

Le calcul photonique s’attaque aux limites structurelles de l’électronique traditionnelle. Il propose une voie pour prolonger, voire dépasser, la loi de Moore.

Aujourd’hui, plusieurs avancées importantes ont été réalisées même si la maturité industrielle reste embryonnaire :

Des circuits photoniques intégrés sont désormais capables de manipuler des signaux optiques sur puce (Silicon Photonics) avec une miniaturisation croissante et une compatibilité partielle avec les lignes de production CMOS existantes (On appelle CMOS, ou Complementary Metal Oxide Semiconductor, une technique de fabrication de composants électroniques et, par extension, les composants fabriqués selon cette technique).

Des startups comme Lightmatter, Lightelligence ou Luminous Computing proposent déjà des accélérateurs photoniques dédiés à l’intelligence artificielle. Ils sont capables de concurrencer certaines architectures GPU pour des tâches spécifiques d’inférence.

Intel, IBM, le MIT et d’autres acteurs travaillent sur des prototypes hybrides où coexistent électronique pour le contrôle et photonique pour le calcul intensif.

Le premier processeur photonique partiellement commercialisé pour du calcul intensif a vu le jour en 2022. Cela a ouvert la voie à des applications concrètes dans la recherche scientifique et l’industrie de pointe.

Mais le calcul généraliste tout photonique reste lointain. Les défis liés à la logique optique universelle, à la mémoire photonique non volatile, à l’interconnexion scalable et au coût des matériaux demeurent immenses. De plus, l’intégration des composants optiques sur puce reste complexe et nécessite des avancées considérables en design, packaging et compatibilité industrielle.

La recherche mondiale s’intensifie, et se structure autour de plusieurs axes :

Photonique silicium : elle vise à rendre les puces optiques compatibles avec les procédés industriels existants pour en faciliter l’adoption à large échelle.

Calcul optique neuromorphique : des réseaux de lasers et de modulateurs optiques imitent les neurones et synapses avec des vitesses de traitement incomparables.

Photonique quantique : cette branche vise à exploiter les propriétés quantiques des photons (superposition, intrication) pour le calcul ce qui ouvre la porte à des architectures hybrides mêlant calcul classique et quantique.

Photonique analogique : utilisée pour créer des accélérateurs d’inférence IA ultra-rapides sans conversion numérique avec une précision acceptable pour certains cas d’usage.

Photonique reconfigurable : les circuits adaptables dynamiquement grâce à des modulateurs optiques permettent une plus grande flexibilité dans les tâches de calcul et dans la gestion de l’énergie.

Les centres les plus actifs sont le MIT, Caltech, l’Université de Toronto, le CNRS/Thales en France, l’Imperial College London, ainsi que des laboratoires militaires en Chine, en Russie et aux États-Unis. On assiste aussi à une multiplication des partenariats public-privé pour structurer un écosystème pérenne autour de ces technologies.

Le calcul photonique pourrait transformer en profondeur plusieurs secteurs :

Multiplier la vitesse d’entraînement et d’inférence des IA par 10 voire 100 avec une consommation énergétique réduite.

Dépasser les limites thermiques et structurelles du silicium dont les rendements stagnent malgré les nœuds technologiques toujours plus petits.

Permettre le développement de systèmes embarqués autonomes, légers, sans besoin de refroidissement actif. C’est une révolution pour le spatial, les drones, ou les dispositifs médicaux.

Ouvrir la voie à des architectures radicalement nouvelles, non von Neumann (L’architecture dite architecture de von Neumann est un modèle pour un ordinateur qui utilise une structure de stockage unique pour conserver à la fois les instructions et les données demandées ou produites par le calcul. De telles machines sont aussi connues sous le nom d’ordinateur à programme enregistré.), où mémoire et traitement ne sont plus séparés et où le calcul devient quasiment instantané.

Ce serait une réécriture complète du paysage informatique. Mais aussi de ses usages : lunettes intelligentes dotées de modèles de langage embarqués, robots industriels dotés de capacités d’adaptation en temps réel, véhicules autonomes réellement intelligents, dispositifs de cryptographie optique inviolables, ... Cette rupture pose également la question de l’accessibilité de cette technologie à différentes couches sociales et économiques. Comme toute révolution, elle peut creuser les inégalités si elle reste concentrée dans les mains de quelques acteurs dominants.

Celui qui détiendra la maîtrise industrielle du calcul photonique détiendra une avance stratégique remarquable. Comme pour les semi-conducteurs, cette technologie devient un marqueur de souveraineté, un levier de puissance et un objet de compétition mondiale.

Les États-Unis investissent massivement via la DARPA, la NSF, et des alliances structurantes entre géants technologiques (Microsoft, Google, Meta) et start-ups deeptech spécialisées.

La Chine, avec son approche centralisée, a déjà développé des processeurs optiques à usage militaire et civil notamment pour la reconnaissance faciale et la cybersécurité.

L’Europe, plus fragmentée, avance via les programmes Horizon Europe, le projet IPCEI (Important Project of Common European Interest) sur les technologies critiques et certains pôles d’excellence en Allemagne, France et Pays-Bas. Mais elle souffre d’un manque de vision stratégique unifiée.

Ce bouleversement touchera aussi profondément l’écosystème industriel actuel :

De nouveaux acteurs émergeront issus des mondes académiques et des laboratoires nationaux.

Des start-ups deeptech optique deviendront des acteurs critiques et courtisés par les géants de la tech.

Les anciens champions du silicium s’ils n’opèrent pas une mutation rapide risquent l’obsolescence ou la marginalisation.

Enfin, les chaînes d’approvisionnement en matériaux (verres spéciaux, puces photoniques, sources laser) seront redessinées et feront l’objet de politiques industrielles agressives.

Le calcul photonique n’est pas une lubie scientifique. C’est une trajectoire systémique qui bouleverse à la fois les modèles de performance informatique et les équilibres de pouvoir technologique. Le XXIe siècle ne sera pas seulement électronique. Il sera peut-être photonicocratique. Mais encore faut-il en prendre la mesure dès aujourd’hui et agir en conséquence pour ne pas regarder demain avec les yeux d’hier.

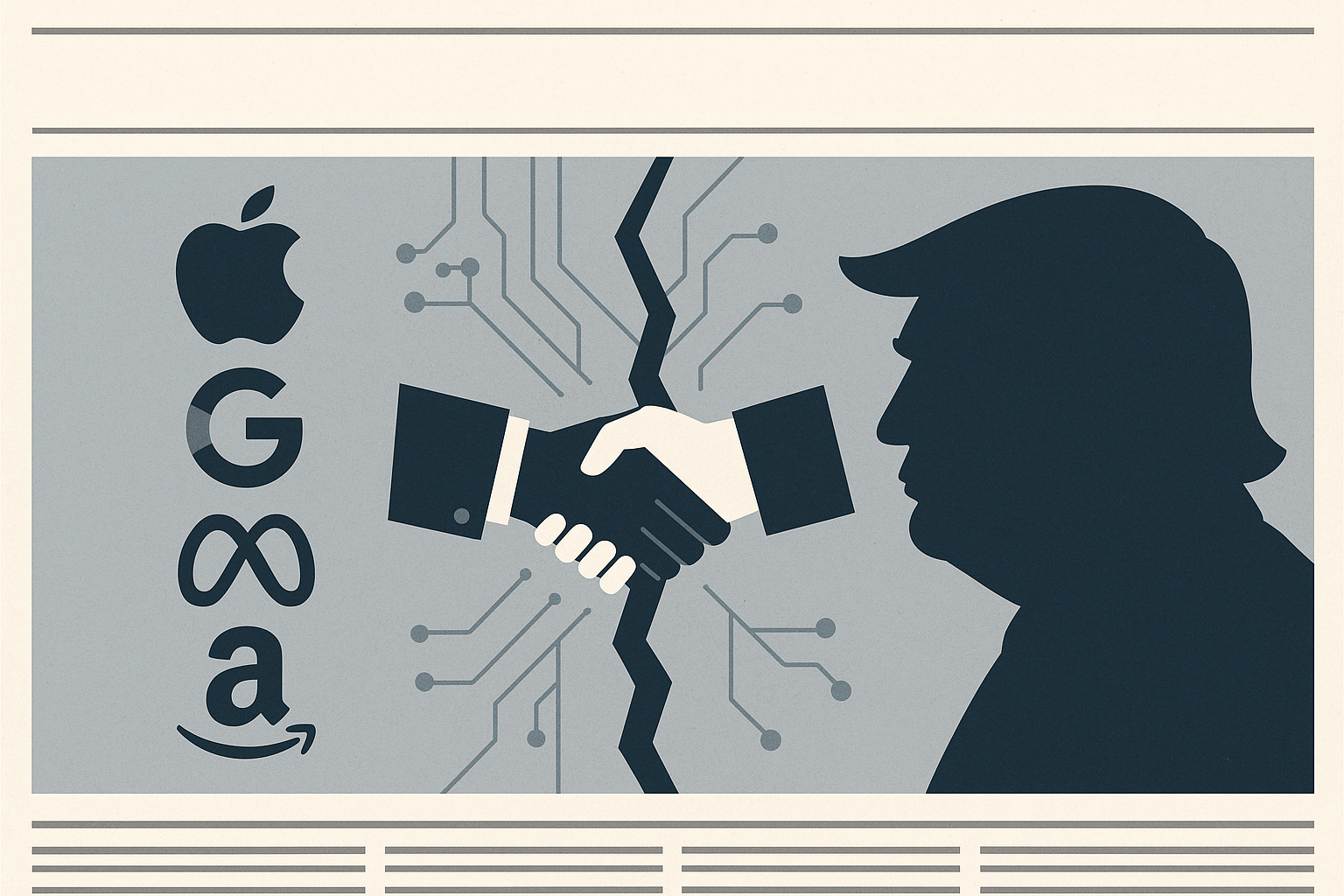

Pourquoi les géants de la tech finiront par lâcher Donald Trump – et quelles en seront les conséquences

Deux ans à peine après avoir déroulé le tapis rouge à Donald Trump, les capitaines de la Silicon Valley découvrent le revers de la médaille d’une alliance fondée sur la transaction : procès antitrust, tarifs punitifs, boycotts massifs et crise de réputation mondiale. Ce qu’ils imaginaient n’être qu’un « coût de conformité » se révèle jour après jour un pacte faustien qui gangrène jusqu’à leur culture d’entreprise. À mesure que s’allongent les assignations du Department of Justice et que gonfle la dette réputationnelle sur les marchés étrangers, le divorce s’annonce inévitable. Ce dernier pourrait redessiner la géopolitique du numérique aussi bien que la campagne présidentielle américaine voire même la gouvernance globale de l’IA.

Dès l’investiture de janvier 2025, Meta, Google, Apple et Amazon pensaient avoir acheté la paix en finançant la « nouvelle ère dorée » promise par Donald Trump. Les équipes politiques des GAFAM, galvanisées par la promesse d’une administration pro‑business, avaient même mis en veille certaines coalitions démocrates. Or la nomination de Gail Slater à la tête de la division antitrust du DoJ et le maintien des mégaprocès contre Meta et Google rappellent que le président reste prêt à découper les « gatekeepers » pour consolider son pouvoir politique. En parallèle, un projet d’Executive Order sur la localisation obligatoire des données de santé présage d’une explosion des coûts de conformité. Pour les juristes de Mountain View, la menace d’un « démantèlement préemptif » constitue désormais un scénario crédible nourri par des fuites stratégiques orchestrées par l’aile populiste du Parti républicain.

« Ces gens d’Internet me détestaient hier ; aujourd’hui ils me baisent les pieds et je sais exactement combien ça vaut », aurait confié Trump à l’Université d’Alabama.

La conséquence est évidente. Les géants revoient le coût réel de leur ralliement et mesurent que l’épée de Damoclès réglementaire ne dépend que d’un tweet présidentiel. L’argument « mieux vaut être dans la tente » ne tient plus si la tente est en flammes.

Apple a certes obtenu l’exemption temporaire de certaines surtaxes chinoises, mais la Maison‑Blanche brandit toujours la menace de nouveaux droits de douane en cas de désaccord commercial avec Pékin ou Bruxelles. La guerre tarifaire s’est élargie aux batteries et aux semi‑conducteurs de moins de 5 nm compromettant ainsi le calendrier de l’iPhone 18 et du casque Vision Ultra. Amazon (accusée de « sabotage politique » pour avoir voulu afficher l’impact des tarifs sur les prix) s’est vu rappeler à l’ordre en 24 heures par un appel direct de Trump. Non content de cette mise au pas, la Maison‑Blanche agite la perspective d’un Impôt Minimum d’Approvisionnement (IMA) frappant tous les achats effectués en Asie hors Japon. L’incertitude tarifaire rend impossible toute planification industrielle et pousse les groupes à chercher des garanties ailleurs. Déjà, TSMC et Samsung renâclent à investir dans l’Arizona tant que l’accès au marché chinois demeure incertain. Cela alimente un cercle vicieux de désinvestissement qui fragilise l’écosystème américain des puces.

L’alliance avec Trump coûte déjà cher : Tesla voit ses immatriculations chuter de 45 % en France, 42 % en Suède et plus de 60 % au Royaume‑Uni, victimes de campagnes #TeslaTakedown qui associent Elon Musk au virage autoritaire de la Maison‑Blanche même si en la matière. Elon Musk s’est mis en grande partie seul dans ce bourbier. Sa transparence sur ses souhaits sociétaux lui coûte cher. L’ONG SumOfUs relayée par de nombreuses autres appelle désormais à boycotter les véhicules dont le constructeur « finance le recul démocratique ». Des mouvements similaires visent Amazon et Target accusés d’avoir capitulé sur la diversité et les droits civiques. Après la suspension du programme Shelves of Pride, plus de 1 200 librairies indépendantes ont cessé de référencer les liseuses Kindle en qualifiant le groupe de « complice moral ». Au‑delà du chiffre d’affaires, c’est l’accès aux talents mondiaux qui se grippe : jeunes ingénieurs et créatifs rechignent à rejoindre des entreprises perçues comme complices d’une croisade anti‑DEI. Selon la plateforme Levels.fyi, les candidatures chez Google provenant d’étudiants des Ivy League ont chuté de 28 % au premier trimestre 2025. Le coût moyen de rétention a bondi de 12 % en un an (un prélèvement « Trump » que les investisseurs commencent à chiffrer).

Les fonds ISR (emmenés par Open MIC et Arjuna Capital) déposent désormais des résolutions exigeant la publication du risque sociétal lié à la désinformation générée par l’IA et au recul de la modération. Mieux : BlackRock et State Street ont annoncé qu’ils voteraient « systematically against » les membres de comités d’audit qui n’intègrent pas ces risques. En mêlant antitrust et risques ESG, la coalition investisseurs‑ONG renchérit le coût du statu quo. Rester adossé à Trump devient incompatible avec la soutenabilité financière et réputationnelle du secteur. Un rapport de JP Morgan estime déjà à 480 points‑base le surcoût d’emprunt auquel s’exposeraient les Big Tech en cas de maintien de la ligne pro‑Trump : 35 milliards de dollars sur dix ans soit l’équivalent du budget R&D annuel de Microsoft.

Le retrait forcé des programmes DEI et la fin des engagements éthiques sur l’IA provoquent une dissonance avec la base salariée qui majoritairement diplômée et cosmopolite. La crainte de sanctions internes a certes anesthésié les protestations mais la fuite des talents vers des scale‑ups européennes ou asiatiques s’accélère.

Des centaines de Googlers se sont inscrits au programme « French Tech Visa » après l’annonce du bonus fiscal tricolore pour l’IA éthique. À Austin et à Seattle, les syndicats tech naissants exploitent ce mécontentement pour revendiquer des « neutrality agreements » . Les GAFAM qui s’y refusent voient s’ouvrir un front social inattendu. Beaucoup redoutent aussi la dérive nativiste et les lois qui en découlent pousse des milliers d’ingénieurs étrangers à revoir leur avenir. Cette érosion lente mine la capacité d’innovation des GAMAM à moyen terme et ferme la porte à la prochaine génération d’innovateurs.

Les scénarios d’une rupture annoncée

Politique intérieure : privés des mégadons de la tech, les Super PAC pro‑Trump devront se tourner vers le secteur de l’énergie fossile et les hedge funds avec par conséquence une réduction de leur autonomie stratégique.

Régulation : si les GAMAM se désolidarisent, le Congrès républicain pourrait perdre un allié clé dans la bataille contre un démantèlement qui, ironie du sort, deviendrait plus probable faute de soutien financier au Parti.

Géopolitique numérique : l’UE, déjà forte de la DMA et du DSA, profiterait d’un lobby américain affaibli pour imposer ses standards. Pékin offrirait un havre réglementaire alternatif… à condition que Washington n’utilise pas les tarifs comme arme de rétorsion.

Écosystème des plateformes : la marginalisation de Trump sur les grandes plateformes risquerait de renforcer les réseaux alternatifs (Truth Social, Gab, Rumble) ce qui induira une accentuation de la fragmentation informationnelle et la polarisation.

Marchés financiers : la volatilité accrue (illustrée par la chute de 26 % de l’action Tesla depuis janvier) pourrait se généraliser aux Big Tech si les procès antitrust aboutissent ou si l’exode des utilisateurs s’accélère.

Innovation : la fuite des cerveaux et la fragmentation du cloud pourraient retarder de cinq ans la prochaine rupture technologique « brand‑in USA » et laissera un boulevard à l’Asie pour capter la valeur de l’IA générative avancée.

Climat social : un décrochage trop brutal pourrait déclencher un round supplémentaire de tech‑lash populiste, cette fois alimenté par la droite évangélique qui dénoncerait la « trahison » de la Silicon Valley et installerait une guerre culturelle durable.

En voulant dompter la Silicon Valley à coups de décrets et de menaces, Donald Trump pourrait bien provoquer l’effet inverse : une rupture spectaculaire avec des géants qui, pour protéger leurs bilans, leurs talents et leurs marchés, n’auront d’autre choix que de se désengager. Pour les Big Tech, le risque n’est plus seulement légal ou fiscal. C’est désormais une question existentielle de licence sociale d’opérer. À l’heure où l’IA redéfinit le rapport entre technologie et démocratie, il n’y a peut‑être rien de plus stratégique pour les GAMAM que de reprendre leur indépendance politique et de rebâtir un contrat social global. Ce divorce serait un séisme. Il pourrait aussi ouvrir la voie à une nouvelle éthique du pouvoir technologique, fondée sur la transparence, la pluralité et des garde‑fous démocratiques explicitement assumés.

Bonnes métamorphoses et à la semaine prochaine !

Stéphane