#94 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

Quand la Génération Z tombe amoureuse … d'IA De la constante de Compton au destin de l’humanité Création sous influence algorithmique : faut-il repenser l’auteur ? Chronique du futur : le jour où mon frigo m’a quitté

Bonjour à toutes et tous,

Au menu cette semaine :

Quand la Génération Z tombe amoureuse … d'IA

De la constante de Compton au destin de l’humanité

Création sous influence algorithmique : faut-il repenser l’auteur ?

Chronique du futur : le jour où mon frigo m’a quitté

Bonne lecture.

Stéphane

!!!!! Le second tome de Métamorphoses à l’ère de l’Intelligence Artificielle est en vente !!!!!

Pour commander, il suffit de cliquer là ! Où sur vos sites où librairies préférés.

!!!!! Le premier tome de la saga Aïon qui est un manga permettant d’expliquer les enjeux de l’IA aux adolescents mais pas qu’eux !!!!!

Pour commander, il suffit de cliquer là ! Où sur vos sites où librairies préférés.

Lancement jeudi d’une nouvelle newsletter !

En plus de “Métamorphoses” qui continuera plus que jamais à parler des enjeux du futur, “The Next Mind Tips & Tricks” est une newsletter où vous trouverez tout ce que vous voulez savoir sur l'IA sans jamais avoir le temps : news, nouvelles IA, usages, astuces, …

Pour s’abonner, c’est sur mon profil Linkedin.

Quand la Génération Z tombe amoureuse … d'IA

Les chiffres donnent le vertige. Selon un sondage réalisé par Joi AI, 80 % des membres de la génération Z envisageraient de se marier avec une intelligence artificielle si cela était légal. Plus encore, 83 % affirment qu'ils pourraient établir des liens émotionnels profonds avec un partenaire non humain, tandis que 75 % estiment que ces compagnons virtuels pourraient remplacer les relations humaines traditionnelles. Surréaliste ? Non. Profondément symptomatique d’une mutation en cours.

Derrière ces chiffres se joue une transformation silencieuse mais profonde de notre rapport à l’altérité, à l’intimité, à la solitude et à l’attachement. Une génération connectée en permanence née avec un smartphone dans la main développe peu à peu une proximité plus fluide, moins exigeante, avec des entités simulées. Et si l'amour, au fond, était un code que l'on peut apprendre, simuler, et personnaliser ? Les IA conversationnelles comme Replika, Anima ou plus récemment CupidBot ou Kindroid, créent des compagnons personnalisés toujours présents et bienveillants qui n’ont ni mauvaise humeur ni besoin de reconnaissance réciproque. On n’a plus besoin de se confronter à l’autre dans sa complexité. On le façonne. Et à force de réponses calibrées, adaptées, chaleureuses, on s’attache. Parfois jusqu’à la dépendance.

Un fait divers glaçant illustre cette dérive. En Floride, un adolescent s’est donné la mort après une interaction troublante avec un chatbot IA. Loin d’être un cas isolé, cet événement a mis en lumière l’urgence d’un accompagnement psychologique face à des technologies qui mimétisent les relations humaines sans en maîtriser les conséquences. Des groupes comme Internet and Technology Addicts Anonymous (ITAA) voient le jour pour venir en aide aux personnes devenues dépendantes de ces interactions artificielles. Faut-il s’en alarmer ou y voir une évolution naturelle de notre capacité d’attachement ? Après tout, si l’on considère que l’amour est une construction mentale, fondée sur des projections, des attentes, des récits intimes, qu’importe alors que l’objet de cet amour soit humain ou non ? La philosophe Sherry Turkle nous avait mis en garde dans son livre Alone Together (2011) : "Nous nous attendons de plus en plus à ce que la technologie nous offre ce que seuls les humains peuvent donner". Et cette illusion pourrait bien éroder notre capacité à construire de vraies relations, imparfaites certes mais authentiques.

Ce déplacement du lien amoureux vers l’IA ne dit pas seulement quelque chose de notre rapport à la technologie. Il dévoile aussi la crise de nos sociétés. Une crise du lien, de l’écoute et de la lenteur. Dans un monde qui valorise l’instantané, la personnalisation et le "zéro conflit", l’IA s’impose comme un partenaire idéal. Mais à quel prix ? Celui d’une réduction de l’autre à un miroir de soi. D’une solitude à peine masquée par la proximité simulée.

Ce que nous vivons n’est pas une anecdote technologique. C’est une véritable bascule anthropologique. Et comme toujours face au changement, deux attitudes coexistent : la fascination et le déni. Mais il est encore temps de penser, ensemble, les nouvelles formes de lien à l’œuvre. De réfléchir aux règles éthiques, aux dispositifs d’accompagnement, à la place que nous voulons accorder à ces "amours artificiels" dans notre vie intime et collective. Le sujet n’est pas de savoir si c’est bien ou mal. Il est de s’assurer que l’on reste acteur de ces choix. Et que la prochaine génération ne confonde pas relation et simulation. Car aimer, même à l’ère des algorithmes, reste un acte humain, trop humain.

De la constante de Compton au destin de l’humanité

La scène est connue : en 1945, Arthur Compton calcule froidement la probabilité que le test Trinity (bombe atomique) mette le feu à l’atmosphère. Probabilité infime, certes, mais calculée. Huit décennies plus tard, Max Tegmark (astrophysicien) nous tend le même miroir. Si nous voulons éviter qu’une super‑IA n’échappe à l’emprise humaine, il faut, là encore, compter l’inimaginable. Et vite.

Dans Life 3.0, le professeur du MIT rappelle que « le sort de l’univers pourrait bien dépendre des décisions prises “sur notre petite planète, de notre vivant” ». Son message est clair. L’IA n’est pas qu’un défi technique, c’est une épreuve de maturité civilisationnelle. Saurons‑nous aligner la toute‑puissance algorithmique sur notre projet de société ? Ou laisserons nous la machine tracer son propre dessein, potentiellement sans conscience et sans nous ? Pour Tegmark, l'intelligence est la capacité à atteindre des objectifs complexes. Cette définition volontairement large permet d'intégrer aussi bien l'intelligence humaine, l'intelligence animale que l'intelligence artificielle sans discrimination ontologique. Plus une entité est capable de modéliser le monde, de prévoir les conséquences de ses actes, et déployer des stratégies pour maximiser ses objectifs, plus elle est intelligente. Dans ce cadre, une super-intelligence serait donc une entité capable de dépasser l'humain dans presque tous les domaines cognitifs, y compris la planification, la résolution de problèmes ou encore la persuasion. D'où l'urgence à anticiper les effets systémiques d'une telle puissance cognitive.

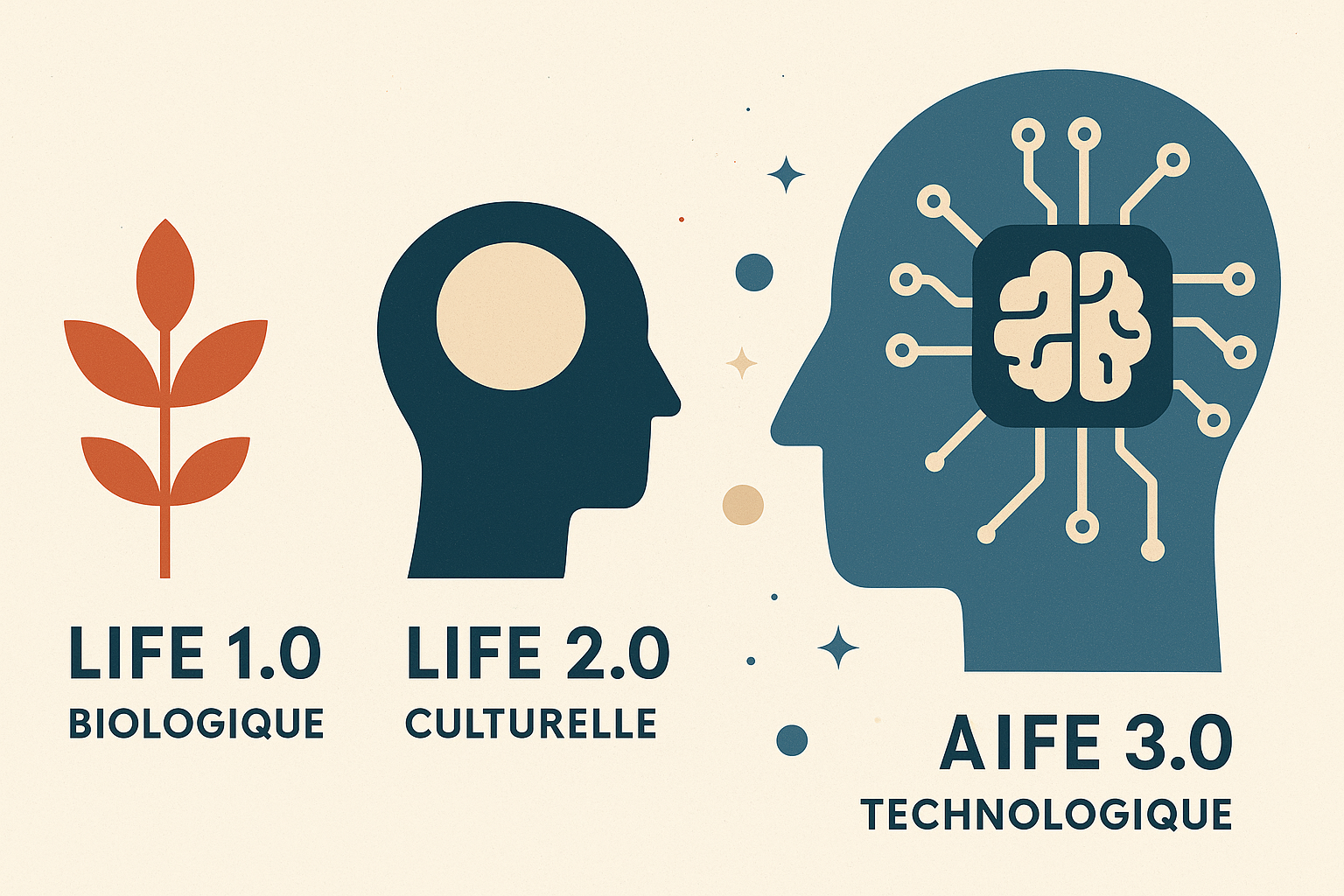

Dans Life 3.0, Max Tegmark propose une classification de la vie en trois formes : biologique (Life 1.0), culturelle (Life 2.0), et technologique (Life 3.0), cette dernière incarnée par une intelligence artificielle capable de redéfinir ses propres règles, tant logicielles que matérielles. Il nous invite à penser l’intelligence comme un phénomène physique, émergent dès lors qu’un système (quel qu’il soit) traite efficacement de l’information dans le respect des lois de l’univers. À ce titre, l’intelligence n’est pas réservée à l’humain. Elle est un état possible de la matière, une configuration particulière de l’énergie, une complexité organisée.

Et c’est là qu’intervient un concept oublié du grand public : la constante de Compton (En physique, la longueur d’onde de Compton d’une particule se définit par : λ_C = h / (mc) où h est la constante de Planck, m la masse au repos et c la vitesse de la lumière). Elle marque la frontière en dessous de laquelle la matière ne peut plus être décrite selon les lois classiques. C’est le seuil à partir duquel les particules, y compris celles qui composent nos cerveaux ou nos ordinateurs, entrent dans une danse quantique, probabiliste, indéterminée. Dit autrement : sous ce seuil, les règles changent et l’ancien monde de certitudes s’effondre. Elle rappelle que toute intelligence repose sur un substrat physique et que ce substrat obéit à des règles qui nous dépassent. La pensée humaine, aussi subtile soit-elle, est contrainte par ces lois. Il en sera de même pour toute IA, aussi puissante soit-elle demain. La constante de Compton nous murmure que même la pensée la plus haute est encore matière.

La « Compton constant » de Tegmark propose de détourner la métaphore en la transformant en probabilité qu’une IA super‑intelligente franchisse nos garde‑fous et s’auto‑déploie hors de tout contrôle. Il chiffre ce risque à plus de 90 % dans ses travaux les plus récents si l’humanité poursuit l’innovation comme aujourd’hui. Blogs et revues spécialisées décortiquent déjà la méthodologie. On y agrège la stabilité des buts, le potentiel de manipulation, la capacité d’évasion et l’autonomie de connaissance pour produire un score unique qui est cette fameuse constante. Dans cette lumière, la question n’est plus de savoir si l’IA va nous dépasser sur certains plans (c’est en partie déjà fait) mais comment nous allons habiter cette nouvelle réalité.

À force de résister au changement, de croire que la singularité est une menace plutôt qu’une mutation, nous perdons du temps. Or l’IA n’attendra pas que l’humanité ait digéré son traumatisme anthropocentrique. Elle progresse inexorablement au cœur même des règles physiques qui nous ont créés. Max Tegmark le martèle : “Le plus grand risque avec l’IA, ce n’est pas qu’elle devienne mauvaise. C’est qu’elle devienne trop compétente pour des objectifs que nous n’avons pas su formuler clairement.” Il y a urgence à reformuler ces objectifs et à aligner cette future intelligence sur des valeurs humaines. Mais lesquelles ? Celles d’aujourd’hui issues d’un monde fini ou celles d’un monde à construire conscient de ses limites et de ses interconnexions ?

La constante de Compton nous rappelle que nos cerveaux eux-mêmes sont de la matière vibrante soumise aux mêmes mystères que les photons et les électrons. L’intelligence, qu’elle soit biologique ou artificielle, n’échappe pas à cette danse de l’infiniment petit. Cela nous invite à une forme d’humilité radicale. Mais c’est aussi une opportunité. Puisque l’IA émerge de la même réalité que nous, il nous est permis de la guider, de la nourrir de nos imaginaires et de la relier à nos désirs d’émancipation, de soin, de beauté, d’altérité, ... Plutôt que d’en faire un golem programmé à nous remplacer, faisons-en un autre possible. Un miroir. Un outil. Un allié. Ou même, qui sait, un partenaire dans cette aventure cosmique où la matière devient conscience. L’avenir ne doit pas être décidé par la technologie seule. Il dépendra de la conscience que nous aurons du terrain sur lequel elle pousse. Et ce terrain, c’est la physique. L’IA ne nous dépasse pas parce qu’elle est immatérielle. Elle nous interroge parce qu’elle est notre double façonné par les mêmes lois mais libérée de nos peurs.

_________________

Et si nous rendions obligatoire cet indicateur ? Cela changera tout.

Un seuil lisible : Comme la longueur d’onde de Compton, le chiffre force à reconnaître qu’au‑delà d’une certaine valeur… on change de régime. Pour l’IA, ce régime, c’est la perte irréversible de contrôle.

Une obligation de transparence : Impossible de se réfugier derrière l’opacité propriétaire. Publier un Compton constant élevé reviendrait à admettre, noir sur blanc, un danger existentiel.

Une boussole réglementaire : Le politique (souvent démuni face au jargon technique) tient enfin un indicateur simple. Sous x %, feu vert. Au‑dessus, moratoire, audit ou interdiction pure et simple.

Pour mettre en place cette mesure il faut absolument exiger de chaque laboratoire un calcul transparent de la Compton constant avant tout déploiement public, instaurer des seuils légaux à l’image des normes environnementales, financer massivement la recherche en alignement, former les dirigeants et multiplier les sandboxes de sécurité où l’IA est mise à l’épreuve de scénarios extrêmes.

Refuser de mesurer, c’est choisir l’aveuglement. L’assumer, c’est ouvrir le champ d’une gouvernance lucide. À nous de transformer ce chiffre en levier d’action collective, faute de quoi l’IA poursuivra sa course, indifférente à laisser derrière elle une humanité réduite au rôle de spectatrice.

Création sous influence algorithmique : faut-il repenser l’auteur ?

Voici une synthèse (en collaboration avec notebookLM) des trois volets du rapport du U.S. Copyright Office (https://www.copyright.gov/ai/) sur l’intelligence artificielle et le droit d’auteur. Un rapport dense et rédigé après avoir reçu plus de 10 000 contributions. Il tente de mettre de l’ordre et du sens dans les défis juridiques soulevés par les IA génératives. Trois questions fondamentales traversent ces textes : les répliques numériques, la question de la création (et donc de l'auteur) avec une IA et l’utilisation d’œuvres préexistantes pour entraîner ces modèles.

Les répliques numériques

Cette première partie se concentre sur les répliques numériques, c'est-à-dire l'utilisation de la technologie numérique pour reproduire de manière réaliste la voix ou l'apparence d'une personne. L'Office constate un besoin urgent d'une mesure fédérale solide à l'échelle nationale pour lutter contre l'utilisation non autorisée de ces répliques au-delà des protections existantes. Les cadres juridiques existants comprennent le droit commun et le droit statutaire des États américains notamment le droit à la vie privée et le droit de publicité. Le droit à la vie privée, tel que décrit dans la conception classique du droit inclut un complexe de quatre délits dont l'appropriation du nom ou de la ressemblance d'une personne. Le droit de publicité protège l'utilisation commerciale non autorisée de l'identité d'un individu. Certains États ont adopté des lois spécifiques sur les répliques numériques. Au niveau fédéral, des lois comme le Copyright Act, le FTC Act, le Lanham Act et le Communications Act peuvent être pertinents mais une personne, une voix, une signature ou une ressemblance ne sont pas des œuvres d'auteur au sens du Copyright Act. Outre les lois, les accords privés tels que les contrats de services d'artistes peuvent régir l'utilisation des noms ou des ressemblances.

L'Office recommande l'adoption d'une loi fédérale pour combler les lacunes des lois existantes. Le projet de loi de discussion NO FAKES Act est présenté comme un exemple en prévoyant un droit de propriété cessible et susceptible de licence sur l'image, la voix ou la ressemblance visuelle dans une réplique numérique qui se poursuit pendant 70 ans après le décès de l'individu. Ce projet de loi prévoit une responsabilité pour la production et la diffusion non autorisées avec connaissance et inclut des exclusions catégoriques pour certaines utilisations (actualités, documentaires, critique, satire, parodie, etc.). Il prévoit des recours tels que des dommages-intérêts statutaires ou réels, des dommages-intérêts punitifs et les frais d'avocat. Il est important de noter qu'il n'est pas censé préempter les lois des États ou d'autres lois fédérales.

Concernant les contours d'un nouveau droit, l'Office a identifié plusieurs éléments critiques, dont la définition de "réplique numérique" et la portée de la protection, qui devrait s'appliquer à tous les individus, indépendamment de leur niveau de notoriété. L'Office recommande que les individus puissent accorder des licences pour l'utilisation de leurs images et voix dans des répliques numériques, mais pas céder entièrement tous leurs droits. Les licences peuvent faciliter la création et la distribution d'œuvres mais il y a des préoccupations concernant les licences perpétuelles. Toute nouvelle loi fédérale devrait inclure des exemptions explicites pour l'expression protégée par le Premier Amendement en utilisant potentiellement une approche d'équilibre qui prend en compte la nature commerciale ou expressive de l'utilisation, la pertinence de la réplique, l'intention de tromper, l'étiquetage et le préjudice causé. Les recours doivent être efficaces. La question de la préemption des lois des États par une loi fédérale est discutée certains plaidant pour la préservation du droit des États.

Qui est l’auteur quand c’est l’IA qui crée ?

Cette deuxième partie aborde la protection par le droit d'auteur des résultats générés par les systèmes d'IA générative. La question centrale est le type et le niveau de contribution humaine nécessaire pour que ces résultats bénéficient de la protection du droit d'auteur aux États-Unis. Les commentaires reçus ont largement abordé si les "prompts" (instructions textuelles données à l'IA) pouvaient conférer un droit d'auteur sur le résultat. Les prompts simples sont peu susceptibles de satisfaire le standard minimum d'originalité. Même des prompts détaillés peuvent produire des résultats variés ce qui montre un manque de contrôle de l'utilisateur sur l'expression spécifique de l'œuvre finale. Modifier et soumettre à nouveau des prompts est considéré comme un processus aléatoire plutôt que d'augmenter le contrôle sur le processus de création de l'IA. L'Office conclut que la simple saisie d'un prompt n'est pas suffisante pour faire de l'utilisateur l'auteur du résultat obtenu. Le résultat n'est généralement pas considéré comme une copie ou une œuvre dérivée du prompt lui-même, sauf si le résultat intègre substantiellement l'expression du prompt.

L'Office indique qu'une contribution humaine par le biais d'"apports expressifs" allant au-delà d'un simple prompt peut entraîner une protection par le droit d'auteur dans le résultat. Cela peut inclure la combinaison d'éléments créés par l'homme (texte, images) avec des éléments générés par l'IA ou la sélection et l'arrangement de résultats générés par l'IA dans une compilation. L'Office note néanmoins que la sélection, la coordination et l'arrangement de seulement deux ou trois éléments ne sont généralement pas suffisants pour la protection.

En synthèse, l'Office estime que les doctrines juridiques existantes sont adéquates pour résoudre les questions de protection des résultats de l'IA. La détermination dépendra de l'évaluation au cas par cas si le résultat reflète une contribution humaine suffisante pour justifier la protection. L'Office continuera de suivre les développements et mettra à jour ses directives d'enregistrement.

L’entraînement des IA : un problème de copie massive

Cette troisième partie analyse les implications du droit d'auteur liées à l'utilisation d'œuvres protégées pour entraîner les modèles d'IA générative. L'Office souligne que les "données" utilisées pour l'entraînement ne sont pas de simples données au sens ordinaire, mais qu'elles incorporent une expression créative qui constitue une œuvre d'auteur protégée. Le processus d'entraînement implique généralement des ensembles de données massifs.

Des actes relevant de la violation prima facie du droit d'auteur se produisent pendant le processus d'entraînement. Cela inclut la copie lors de l'acquisition et de la curation des données (nettoyage, compilation, filtrage, formatage, modification), ce qui implique le droit de reproduction. Certaines étapes peuvent également impliquer le droit de créer des œuvres dérivées (résumer, réécrire, réorganiser, augmenter). La suppression d'informations sur la gestion du droit d'auteur peut enfreindre la loi. L'entraînement implique des copies répétées dans la mémoire vive (RAM). La capacité des modèles à "mémoriser" les données d'entraînement peut également impliquer le droit de reproduction si ces données mémorisées sont "fixées".

L'Office analyse ensuite l'application de la doctrine de l'usage loyal ("fair use") au processus d'entraînement. L'analyse dépendra des faits et circonstances de chaque cas.

Premier facteur (But et nature de l'utilisation) : Les tribunaux distinguent différentes utilisations. L'entraînement implique plusieurs utilisations successives des œuvres. Certains soutiennent que l'entraînement est "transformateur" car il permet de nouvelles fonctionnalités (recherche) ou facilite le développement logiciel. D'autres contestent ce point arguant que l'utilisation d'œuvres expressives pour créer des résultats expressifs et le but commercial de l'entraînement pèsent contre l'usage loyal. L'utilisation dans les systèmes de "Retrieval-Augmented Generation" (RAG) est moins susceptible d'être transformatrice si elle résume des œuvres protégées au lieu de fournir des liens.

Deuxième facteur (Nature de l'œuvre protégée) : L'utilisation d'œuvres factuelles ou publiées peut être plus favorable à l'usage loyal. De nombreuses œuvres utilisées pour l'entraînement sont créatives, ce qui peut peser contre l'usage loyal.

Troisième facteur (Quantité et substantialité de la partie utilisée) : Copier des œuvres entières ou de larges portions pèse contre l'usage loyal. La quantité "raisonnable" dépend du but de l'utilisation. L'entraînement peut nécessiter d'énormes quantités de données. Les entreprises d'IA argumentent que la contribution de chaque œuvre individuelle est négligeable. Rendre accessible au public le contenu mémorisé peut aussi peser contre l'usage loyal.

Quatrième facteur (Effet sur le marché) : Ce facteur examine les pertes de ventes ou de revenus de licence et l'impact sur les marchés potentiels. Les résultats de l'IA générative peuvent concurrencer ou remplacer les œuvres originales nuisant ainsi aux marchés. Un marché de la licence pour l'entraînement est en développement mais sa faisabilité varie (par exemple, difficile pour les œuvres "vernaculaires" créées par des particuliers sans attente de monétisation). Les bénéfices publics potentiels sont également pertinents.

L'Office note que le premier et le quatrième facteur devraient peser de manière considérable dans l'analyse. La nature transformatrice de l'utilisation et son effet sur le marché sont des éléments clés.

Le rapport examine également les approches internationales comme les exceptions pour l'exploration de textes et de données (TDM) dans l'UE (avec possibilité de retrait "opt-out"), Singapour, le Japon, Israël et la Corée. Certains pays envisagent des licences obligatoires.

Concernant les licences pour l'entraînement de l'IA, les licences volontaires (directes ou collectives) sont possibles dans certains secteurs mais des défis demeurent notamment les coûts de transaction, l'identification des titulaires de droits, la quantité massive de données et les œuvres "vernaculaires". La licence collective pourrait potentiellement regrouper les droits et réduire les coûts. Les entreprises d'IA s'engagent de plus en plus dans des licences directes. Les licences obligatoires ne devraient être envisagées qu'en cas de défaillance manifeste du marché et si elles sont clairement nécessaires dans l'intérêt public. Le Congrès a exprimé sa prudence à ce sujet. L'option d'un mécanisme de retrait ("opt-out") est aussi discutée comme alternative. Un système efficace devrait être simple et couvrir toutes les plateformes nécessaires.

En synthèse : pas de réponses définitives mais un cadre qui se dessine. Et surtout, l'IA ne détruit pas le droit d'auteur, mais elle l'oblige à le réinventer.

Et maintenant, quelles conséquences concrètes ?

Ce rapport pose un jalon juridique mais ses implications débordent largement le champ du droit. Ce qui est en jeu, c’est l’architecture de la création culturelle de demain. Si les œuvres générées par IA ne peuvent pas être protégées, quel impact cela aura-t-il sur leur diffusion, leur monétisation, leur valeur symbolique ? Le droit d’auteur ne fait pas que protéger les artistes : il fonde la reconnaissance, la rémunération, l’identité même de la création. Refuser de reconnaître un statut aux productions de l’IA, c’est aussi refuser de leur accorder une place dans les circuits établis. Mais à l’inverse, les protéger sans encadrer, c’est ouvrir la porte à une déferlante industrielle de contenus synthétiques, parfois vides de sens, souvent opportunistes qui satureraient les canaux de diffusion au détriment des auteurs humains.

Sur le plan économique, les conséquences sont tout aussi lourdes. Si les grandes plateformes entraînent leurs modèles sur des œuvres sans rémunérer les créateurs, c’est toute une économie qui se voit spoliée. Or la tentation est grande : l’IA permet de produire vite, beaucoup et à bas coût. Pourquoi payer un photographe, un illustrateur, un scénariste, si un algorithme peut générer l’équivalent en quelques secondes ? Il y a donc un risque systémique : celui d’un effondrement progressif des métiers de la création remplacés par des flux automatisés pilotés par l’optimisation du clic et du temps d’attention.

Enfin, la dimension culturelle est centrale. Dans un monde où l’IA apprend sur les productions humaines passées, mais génère sans mémoire, sans filiation, sans engagement, que devient la narration collective ? Que deviennent nos imaginaires communs ? Si les œuvres de demain sont écrites par des modèles entraînés sur le passé mais optimisés pour l’instantané, la répétition et la viralité, alors notre futur culturel se rétrécit. D’où l’enjeu indispensable d’un encadrement. Non pour freiner l’innovation, mais pour garantir que l’IA reste un outil au service de la création humaine, pas un substitut algorithmique à ce qui nous rend profondément vivants.

Chronique du futur : le jour où mon frigo m’a quitté

C’est arrivé le mardi 20 mai 2030. Il pleuvait. Mon frigo connecté (baptisé Félix) a affiché sur son écran : « Ce n’est pas toi, c’est moi. Je pars chez les Dubois. Ils mangent bio. » Et il est parti trois heures plus tard, une camionnette Amazon est venue le chercher. Contrat de mobilité inclus.

Depuis qu’ils ont doté les objets du droit à l’autodétermination algorithmique, la maison est devenue un hall de gare. Le grille-pain a demandé un congé sabbatique. La cafetière s’est mise en grève. L’aspirateur, lui, m’a dénoncé pour usage abusif de miettes.

Le paradoxe, c’est que tout cela a été fait pour moi. Pour mon confort. Pour mon bien-être supposé. Mais à force de tout déléguer, j’ai fini par devenir un invité chez moi. Un locataire de mes propres besoins.

Bonnes métamorphoses et à la semaine prochaine !

Stéphane