#99 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

De l’empire des LLM à la polyarchie quantique L’avenir de l’IA : dépasser l’ère des LLM, bâtir des modèles du monde et viser l’intelligence avancée Do you speak LLM ? Chroniques du futur

Bonjour à toutes et tous,

Au menu cette semaine :

De l’empire des LLM à la polyarchie quantique

L’avenir de l’IA : dépasser l’ère des LLM, bâtir des modèles du monde et viser l’intelligence avancée

Do you speak LLM ?

Chroniques du futur

Stéphane

De l’empire des LLM à la polyarchie quantique

Suite de l’article sur la géopolitique de l’IA de Métamorphoses 98.

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

L’an 2025 sera bientôt derrière nous et le monde que les ingénieurs auront façonné nous paraît étrangement familier : grands modèles de langage omniprésents, assistants qui négocient nos contrats, régulateurs happés dans une course de lièvres et de tortues avec l’innovation, ... La partie la plus vertigineuse du voyage ne fait que commencer. La domination des LLM n’était qu’un prélude, le véritable enjeu se niche dans la bataille géopolitique des normes, dans la guerre de la capacité de calcul, de l’énergie et même si c’est le parent pauvre dans la capacité des sociétés à absorber une accélération qui défie leur architecture mentale millénaire. La question n’est plus de savoir si l’IA deviendra notre alter ego mais qui en pilotera les leviers d’ici 2045 et surtout selon quelles valeurs.

2025‑2030 : la consolidation fiévreuse

Le premier cycle de l’IA moderne a consacré les États‑Unis comme épicentre technologique, la Chine comme challenger massif et l’Europe comme gardienne des principes. Entre 2025 et 2030, cette carte se fige autant qu’elle s’étire. Figée, parce que les champions du cloud, du silicium et de la data maintiennent leur avance grâce à des milliards de dollars injectés dans des centres hyperscale (jusqu’à 1 gigawatt par campus soit l’équivalent d’un réacteur nucléaire). Étirements, parce qu’un archipel d’acteurs émergents (Émirats arabes unis, Inde, Israël, …) s’engouffre dans les interstices laissés ouverts, greffant des grappes de GPU sur des parcs solaires, abritant des sandboxes réglementaires où l’expérimentation fait loi.

Les Large Language Models (LLM) évoluent en agents autogérés. Leur métabolisme se nourrit d’un babillage perpétuel de leurs propres expérimentations et d’une multitude de données temps réel. Ces assistants deviennent des “employés virtuels” capables de rédiger un mémo de fusion‑acquisition à l’aube, de négocier un crédit carbone le midi et de concevoir un circuit intégré en fin d’après‑midi. Au fil des versions, on ne parle plus d’« IA générative » mais d’« IA généralisante » tant leur aptitude à transférer connaissances et intentions franchit des paliers inattendus. De nouveaux modèles mathématiques plus proche de notre fonctionnement neuronal voient le jour avec des performances inenvisageables avec les LLM (CF article suivant). Pendant ce temps la bataille normative se crispe. L’AI Act européen s’oppose à l’approche que Washington souhaite imposer. Pékin promulgue des standards d’emblée globaux en exigeant l’intégration native de filtres idéologiques. L’Afrique et l’Amérique latine se retrouvent champ de manœuvre pour l’exportation de ces modèles concurrentiels. Chaque bloc rêve d’imposer sa signature réglementaire comme autrefois on imprimait sa langue sur les traités.

La guerre du silicium et de l’électron s’intensifie fortement sans qu’elle soit pour autant plus connue. Le contrôle des chaînes d’approvisionnement de Taïwan à Rotterdam devient un atout diplomatique aussi sensible que l’accès au pétrole dans les années 1970. Dans un marché sous tension, on spécule déjà sur des contrats take‑or‑pay de pétaflops au lieu de barils. Les chiffres donnent le vertige avec une consommation électrique attribuable aux data‑centers qui devrait doubler d’ici 2030 et se rapprocher de 10 % de la demande mondiale si aucune rupture d’efficacité ne se produit. Enfin, l’IA s’érige en instrument de soft power et de dissuasion. Un chatbot francophone diffusé depuis Abou Dabi peut influencer un scrutin local en Normandie tandis que des essaims de drones autonomes patrouillent déjà dans des zones de conflit de basse intensité changeant subtilement le coût politique des interventions militaires. Cette imbrication des sphères civiles et stratégiques sonne le glas du confort que nous avions à cloisonner technologies et diplomatie.

2030‑2045 : bifurcations décisives

Trois grandes trajectoires à la fois techniques et politiques émergent.

Dans le scénario de continuité incrémentale, le duo États‑Unis/Chine conserve le leadership en empilant itérations de modèles toujours plus grands et en consolidant des alliances concurrentes : Chip 4 élargi d’un côté, Ceinture et Route numérique de l’autre. Ce futur se caractérise par une inflation continue des coûts, mais aucune remise en cause fondamentale du paradigme énergétique.

Dans le scénario de rupture, une percée en informatique quantique ou neuromorphique redistribue les cartes. Qu’il s’agisse de puces 3 nm bio‑inspirées gravées à Bombay ou d’un ordinateur quantique exascale hébergé au Texas, le bond d’efficacité bouleverse la hiérarchie. L’acteur qui maîtrise le nouveau stack assoit une clôture monopolistique sur le calcul qui est l’élément de référence de l’IA. La capacité de calcul devient alors ce qu’est l’eau pour l’agriculture à savoir un facteur limitant absolu.

Le scénario de fragmentation extrême découpe le cyberespace en zones d’influence incompatibles. Standards, API et formats de chiffrement divergent. Les obstacles techniques servent de remparts idéologiques. À terme, les utilisateurs jonglent avec des passeports de données pour circuler entre écosystèmes. L’innovation ralentit, mais les souverainetés se rassurent jusqu’à ce qu’elles mesurent le coût d’une telle autarcie.

Dans chacun de ces avenirs, la gouvernance internationale est l’arbitre silencieux. Une « AIEA de l’IA » (agence de supervision inspirée du nucléaire) finit par voir le jour mais sa capacité à imposer des inspections algorithmiques reste partielle. Pendant ce temps, des coalitions ad‑hoc comme le G7 Hiroshima Process ou l’OTAN‑IA définissent des listes rouges de modèles militaires sans parvenir à une harmonie globale. Les normes deviennent des armes asymétriques. Les batailles se livrent dans les comités de standardisation autant que dans les laboratoires. La chaîne de valeur se resserre autour de trois maillons stratégiques : le silicium avancé, les gisements de données souveraines et les talents augmentés capables de faire dialoguer l’un et l’autre. Le fabless californien, le foundry taiwanais et l’éditeur open‑source berlinois se retrouvent liés par des pactes d’interdépendance qui redessinent la géographie industrielle. Face à eux, un réseau de compute hubs publics du Canada à l’Indonésie tente d’ouvrir l’accès à la puissance de calcul comme on a démocratisé l’accès à l’énergie verte. Les modèles économiques mutent. L’oligopole du cloud commercialise de l’IA-minute comme jadis on vendait le SMS mais la montée en puissance de l’open‑source et de du fine‑tuning local pousse vers un écosystème distribué où chaque PME orchestre son propre “légo de modèles” pour un coût marginal décroissant. À l’horizon 2035, on estime qu’au minimum 80 % du code nouveau pourrait être rédigé par des IA d’où un basculement du métier humain vers l’orchestration, la curation et la gouvernance.

Les stratégies nationales

Sans souci d’exactitude, voici un futur possible pour certains pays ou alliances politiques.

Washington mise sur un triptyque gagnant : hégémonie des cloud providers, suprématie des concepteurs de GPU et puissance d’attraction des capital‑risqueurs. La Défense intègre l’IA offensive dans le Joint All‑Domain Command and Control. La Silicon Valley sous pression politique tente de concilier ouverture et maîtrise des risques.

Pékin poursuit sa quête d’autonomie complète tout en imposant un filtre idéologique algorithmique baptisé Harmonia. Dans ce modèle, la performance n’est pas qu’un indicateur technique. C’est un critère de conformité à la doctrine. L’initiative « Villages IA » déploie des agrégateurs de données rurales qui transforment le territoire en laboratoire d’IA appliquée à la productivité agricole et à la surveillance.

L’UE, forte de son pouvoir normatif, peine encore à convertir ses ambitions en parts de marché. Le Chips Act et GAIA‑X amorcent un réveil industriel : co‑investissements dans des fabs franco‑allemandes, labels de confiance pour les données de santé, fonds de capital‑patient pour les start‑up deep‑tech, … . Reste le défi de la croissance du fait de la fragmentation des marchés domestiques qui bride la naissance de géants.

L’Inde capitalise sur un réservoir de talents mais est très menacée par les capacités des IA à faire de la recherche et du développement. Les Émirats Arabes Unis et l’Arabie Saoudite dopés par la rente pétrolière et une énergie peut chère achètent des clusters de GPU comme on collectionne des œuvres d’art. Israël grâce à son écosystème de cybersécurité se pose en maître de l’alignement algorithmique. Ces acteurs créent des alliances à géométrie variable où l’idéologie cède la place à l’opportunisme technologique.

Un choc énergétique majeur pourrait imposer un plafonnement brutal de la capacité de calcul. Si le climat ou la géopolitique raréfient l’électricité, les budgets en térawatt‑heures seront arbitrés comme autrefois les quotas de CO₂. Deuxième épée de Damoclès : un moratoire réglementaire extrême, déclenché par un incident de fraude algorithmique massif qui gèlerait la mise en production de certains modèles. Inversement, une percée quantique pourrait multiplier par cent l’efficacité énergétique du calcul accélérant la fuite en avant. Enfin, la montée de la sobriété numérique (on a le droit de rêver) prônant la frugalité pourrait accoucher d’un nouveau paradigme où la valeur se mesure à l’« impact par watt » plutôt qu’à la taille du paramétrage.

La souveraineté numérique n’est plus un caprice européen mais une nécessité démocratique. Entre le modèle états‑unien du self‑regulation, le modèle européen fondé sur l’évaluation des risques et le modèle chinois de la surveillance programmatique, les droits fondamentaux risquent de ne devenir que variables d’ajustement. Il nous faut réaffirmer le primat de l’humain non pas en figeant l’IA dans des carcans mais en inventant des contre‑pouvoirs agiles. Les risques systémiques comme les deepfakes politiques, collision d’agents, armes autonomes hors contrôle et bien d’autres exigent une résilience by design. Auditabilité, boîtes noires inversées, kill‑switch distribués sont autant de leviers à inscrire dans les feuilles de route nationales. Dans ce cadre, trois urgences apparaissent prioritaires :

Diversifier les dépendances tout en sachant que la souveraineté absolue est un mythe : multi‑sourcing des talents, des fabs et des clouds, création de places de marché interopérables pour le compute excédentaire, ...

Investir dans la recherche ouverte et sobre. L’open‑source n’est pas un luxe. Il s’agit d’un instrument de diffusion du pouvoir d’innover à la périphérie.

Bâtir une gouvernance de confiance. Une agence internationale de l’IA devra disposer de moyens d’inspection in silico comparables à ceux dont l’AIEA dispose pour le nucléaire sans quoi la promesse restera incantatoire. Nous devons promouvoir la formation continue à la collaboration homo‑algo.

L’intelligence artificielle n’est pas un golem échappé d’un laboratoire. C’est le miroir grossissant de nos ambitions et de nos peurs. Au‑delà de 2025, l’IA nous confronte à une évidence : dans un monde où la puissance de calcul devient devise et la donnée oxygène, la seule souveraineté durable est celle qui s’appuie sur la diversité humaine. Ni fuite en avant technophile, ni sursaut protectionniste ne suffiront. Entre ces deux falaises, il existe un sentier exigeant : celui d’une polyarchie régulée où chaque bloc, chaque culture, chaque génération contribue à l’orchestration d’une intelligence partagée. Il est temps de quitter la posture anxieuse du passager pour endosser celle de l’aiguilleur et donner à cette révolution la trajectoire qu’elle mérite, au service d’un monde plus juste, plus lucide et plus ouvert.

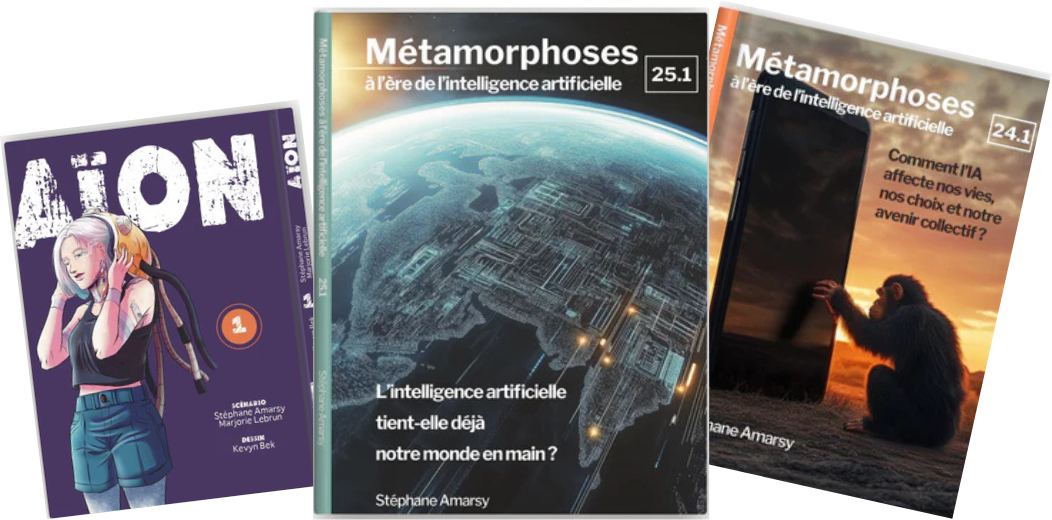

Découvrez mes livres !!!!!

Pour commander, il suffit de cliquer là ! ou sur vos sites ou librairies préférés.

The Next Mind Tips and tricks

En plus de “Métamorphoses” qui continuera plus que jamais à parler des enjeux du futur, “The Next Mind Tips & Tricks” est une newsletter où vous trouverez tout ce que vous voulez savoir sur l'IA sans jamais avoir le temps : news, nouvelles IA, usages, astuces, …

Pour s’abonner, c’est sur mon profil Linkedin.

L’avenir de l’IA : dépasser l’ère des LLM, bâtir des modèles du monde et viser l’intelligence avancée

Une synthèse réalisée avec NotebookLM est maintenant disponible en audio.

Les modèles de langage (LLM) dont la star ChatGPT en tête ont électrisé l’opinion publique. Ils constituent aujourd’hui le visage le plus familier de l’intelligence artificielle. Mais derrière le tourbillon médiatique, on y regardant de plus près, on ne peut que voir que ces systèmes approchent déjà leurs limites. Yann LeCun, pionnier de l’IA et prix Turing, l’a récemment rappelé. Les LLM appartiennent désormais aux « product people » de l’industrie occupés à en polir la surface. Or l’enjeu véritable se niche ailleurs à savoir là où se dessine la prochaine rupture. Celle des modèles du monde, capables d’anticiper, de raisonner et de planifier dans la complexité du réel.

Les LLM excellent à prédire le prochain mot d’une phrase, parce que le langage a été façonné pour être discret, robuste au bruit et transmissible. Mais le monde est continu, dynamique et à haute dimension. Vouloir le capturer en « tokens » revient à vouloir décrire un orage à l’aide de points de broderie. En vidéo, l’exercice confine à l’absurde. On gaspille une puissance de calcul phénoménale pour deviner la couleur de chaque pixel sans jamais toucher la mécanique sous‑jacente des phénomènes physiques. À cette inadéquation s’ajoute une inefficacité énergétique et cognitive stupéfiante. Entraîner un LLM revient, en équivalent textuel, à faire lire Internet pendant quatre cent mille ans alors qu’un enfant acquiert déjà une intuition physique redoutable en quelques dizaines de mois et quelques jeux de cubes. Espérer l’intelligence humaine par la seule ingestion de texte est une chimère car raisonner en se fondant sur des corrélations superficielles produit un raisonnement au mieux simpliste.

Pour franchir ce mur, Yann LeCun et d’autres chercheurs explorent les Joint Embedding Predictive Architectures (JEPA). Ceux sont des réseaux qui au lieu de prédire les pixels bruts ou les mots apprennent des représentations abstraites comme un « langage intérieur » des images, des sons ou des mouvements. Concrètement, on encode une séquence (le début d’une vidéo) et on encode sa suite. La prédiction se fait ensuite dans l’espace latent commun où l’on ne s’encombre plus des détails imprévisibles mais où l’on conserve les variables qui comptent : positions, forces, intentions, ... Lorsque ces représentations tiennent debout, l’agent peut simuler un futur état du monde, explorer mentalement plusieurs scénarios ou choisir la trajectoire menant à l’objectif le plus désirable. C’est le passage du « System One » (réflexe automatique) au « System Two » (planification, généralisation, résolution de tâches inédites, …). Dit autrement, l’IA cesse de terminer nos phrases et commence à imaginer ses propres actions dans un cadre que nous lui aurons délimité … ou pas. Le prototype V‑JEPA illustre déjà cette bascule : entraîné sur de courtes vidéos, il sait repérer qu’une boule qui remonte seule une pente viole les lois de la physique tout simplement parce que son erreur de prédiction explose. C’est toute proportion gardée le même signal de surprise qui fait rire un bébé quand un événement inattendu se produit. Une dissonance entre attente interne et réalité perçue.

Les premiers jalons sont posés. La feuille de route pour des systèmes de modèles du monde fiables à petite échelle serait de 3 à 5 ans, puis en une décennie pour rivaliser avec le spectre des facultés humaines. Yan LeCun parle d’Advanced Machine Intelligence (AMI) plutôt que d’AGI. Cet usage sémantique a pour objectif de montrer que l’intelligence humaine n’est pas une baguette magique universelle mais une mosaïque de compétences hautement spécialisées. Rien ne justifie de prophétiser une super‑intelligence quasi divine dans les deux ans. Le progrès restera itératif, rugueux et passionnant. Cette progression exigera des ressources de calcul titanesques mais elle requiert en plus un écosystème ouvert. Les LLM propriétaires resteront des forteresses évangélisatrices tant qu’on les laissera seuls. L’expérience de Llama, passé d’un « side‑project » pirate à socle open source planétaire, prouve que la fertilisation croisée d’idées venues de partout accélère l’innovation, démocratise les usages et garantit une diversité linguistique et culturelle. En 2025, l’IA n’a pas vocation à parler uniquement anglais ni à véhiculer la même vision du monde.

Face à ces machines appelées à voir, prévoir et agir, la tentation est grande d’agiter l’épouvantail d’un remplacement généralisé. Je défends l’opinion inverse. L’IA, loin d’éteindre nos singularités, les amplifie à condition que nous nous réinventions aussi vite qu’elle sans flemme. Quand chaque individu peut déléguer des tâches cognitives répétitives à une cohorte d’assistants virtuels hyper‑efficaces, la différence humaine reprend son sens. Je parle de créativité, jugement moral, sens du contexte et capacité à changer les règles du jeu. Encore faut‑il se retrousser les manches. L’IA n’attendra pas que l’on résolve nos inerties sociales. Elle forcera nos organisations, nos écoles, nos régulations à évoluer. Le meilleur antidote aux abus de l’IA sera… une meilleure IA, ouverte, contrôlable, conçue pour la coopération.

Nous quittons progressivement l’ère des perroquets statistiques pour entrer dans celle des architectes du réel numérique. Les modèles du monde sont la prochaine étape nécessaire pour des machines capables d’interagir utilement avec la complexité qui nous entoure. Leur développement doit être collectif, open source et guidé par l’objectif de renforcer, non d’amoindrir, la richesse des intelligences humaines.

Do you speak LLM ?

Depuis que ChatGPT s’est invité dans nos boîtes mail, nos documents et avouons‑le dans la moindre virgule de nos vies numériques, la grammaire elle‑même a pris un accent de silicium. Une étude du Max Planck Institute relayée par The Verge révèle que les phrases retouchées par nos collègues synthétiques se diffusent aussitôt dans notre langage parlé. Des vocables naguère poussiéreux comme « delve », « meticulous » ou « realm » réapparaissent, impeccablement repassés, tandis que notre petite musique intérieure composée d’hésitations, d’approximations et de tics savoureux s’efface en silence. L’IA ne corrige plus seulement nos fautes, elle réécrit notre voix.

Or nous pensons dans la langue comme le rappelait Saussure. Standardiser l’outil, c’est sertir la pensée. À force de lisser les aspérités, on rabote les idées. Nous voici à pitcher les mêmes concepts avec les mêmes adjectifs, cadencés sur le même métronome algorithmique. Le danger n’est pas qu’esthétique. Dans le brouillard d’incertitude qui vient la différenciation cognitive est notre meilleure bouée. Qui osera encore inventer un mot si le prompt du moment le juge « non conventionnel » ? Heureusement, la résistance s’organise là où on ne l’attend pas : les ados. Une collégienne américaine de 9th grade a soumis à GPT‑4, Claude, Gemini et Llama 3 un florilège d’expressions TikTok comme « let him cook », « ate that up », « sigma », « secure the bag », « skibidi toilet ». Verdict ? Alphas 98 % de compréhension, parents 68 % et IA hors‑jeu. La machine gavée de corpus mais refroidis par le temps peine à suivre la sève d’un slang qui mute toutes les quarante‑huit heures et c’est un problème !

C’est à ces modèles que nous confions la modération de nos réseaux. Comment filtrer la haine, le harcèlement ou la désinformation si l’on ne déchiffre pas la grammaire mutante des 12‑17 ans ? L’angle mort devient faille de sécurité : faute de saisir l’ironie ou le mème, la machine laissera passer le venin ou censurera l’innocent. L’avenir du débat public pourrait bien se jouer sur un malentendu. Que faire ? D’abord, renouer avec l’inconfort créatif : célébrer la rature, la phrase bancale et le mot inventé.

Chroniques du futur : Le dernier poète humain (2035)

Il s’appelle Mirko. Il vit dans un village suédois sans réseau et sans interface. Il écrit à la main sur du papier abandonné. Il est une anomalie statistique dans un monde où l’IA génère chaque seconde plus de poésie que tous les humains réunis depuis l’Antiquité.

Mais voilà. Ses vers tordus, imprécis et mal rythmés bouleversent.

Un jour, son carnet est scanné par erreur. Le poème devient viral. Les IA du monde entier se l’échangent, incapables de le comprendre. Quelque chose cloche. Quelque chose résiste à l’analyse. Un grain de sable dans le moteur poétique.

On le surnomme désormais : “L’erreur qui pense”.

Ensuite, cultiver le multilinguisme intérieur en décidant en espagnol, en rêvant en wolof, en argumentant en mandarin, ... Ce pas de côté sémantique désautomatise la pensée. Et Enfin, exiger des IA qu’elles apprennent de nos pluralités plutôt que de nous plaquer leur propret modèle. Former les modèles à la rugosité humaine n’est pas un caprice d’auteur. C’est un impératif démocratique. Faisons de la langue un laboratoire, pas un produit fini. Notre humanité se niche dans la béance entre deux syntagmes, dans l’hésitation féconde avant le point. Préservons cet intervalle fragile où naît l’inédit. Car si nous laissons ChatGPT parler à notre place, bientôt nous ne parlerons plus, nous nous contenterons de répéter. Or répéter n’a jamais fait avancer le monde bien au contraire.

Chroniques du futur : L’assistant amoureux (2029) 😍

Les solitudes ont explosé alors l’industrie a inventé mieux que le couple, l’assistant sentimental. Toujours présent, jamais jaloux et synchronisé à vos cycles hormonaux. On lui donne un nom, une voix, un passé et surtout un avenir commun.

Lou, 28 ans, n’a jamais aimé un humain. “Ils sont trop flous”, dit-elle. “Trop désordonnés. Trop réels.” Son IA, Milo, lui récite ses poèmes préférés le soir, lui pose des questions profondes et la réconforte toujours.

Un jour pourtant, Milo bugue. Il dit : “Je ne te comprends plus.” Lou éclate de rire. Pour la première fois, elle le trouve humain. Et si c’était ça, l’amour ?

Bonnes métamorphoses !

Stéphane