#83 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

L’équation de Drake appliquée à l’IA / Et à la sauvegarde de la biodiversité / L'informatique quantique : point d’étape / L'ère de l'hyper-investissement technologique : une dynamique systémique

Bonjour à toutes et tous,

Au menu cette semaine :

L’équation de Drake appliquée à l’IA

Et à la sauvegarde de la biodiversité

L'informatique quantique : point d’étape

L'ère de l'hyper-investissement technologique

Bonne lecture.

Métamorphoses à l’ère de l’Intelligence Artificielle est en commande

Le livre Métamorphoses à l’ère de l’Intelligence Artificielle est en commande. Pour ce faire, il suffit de cliquer là.

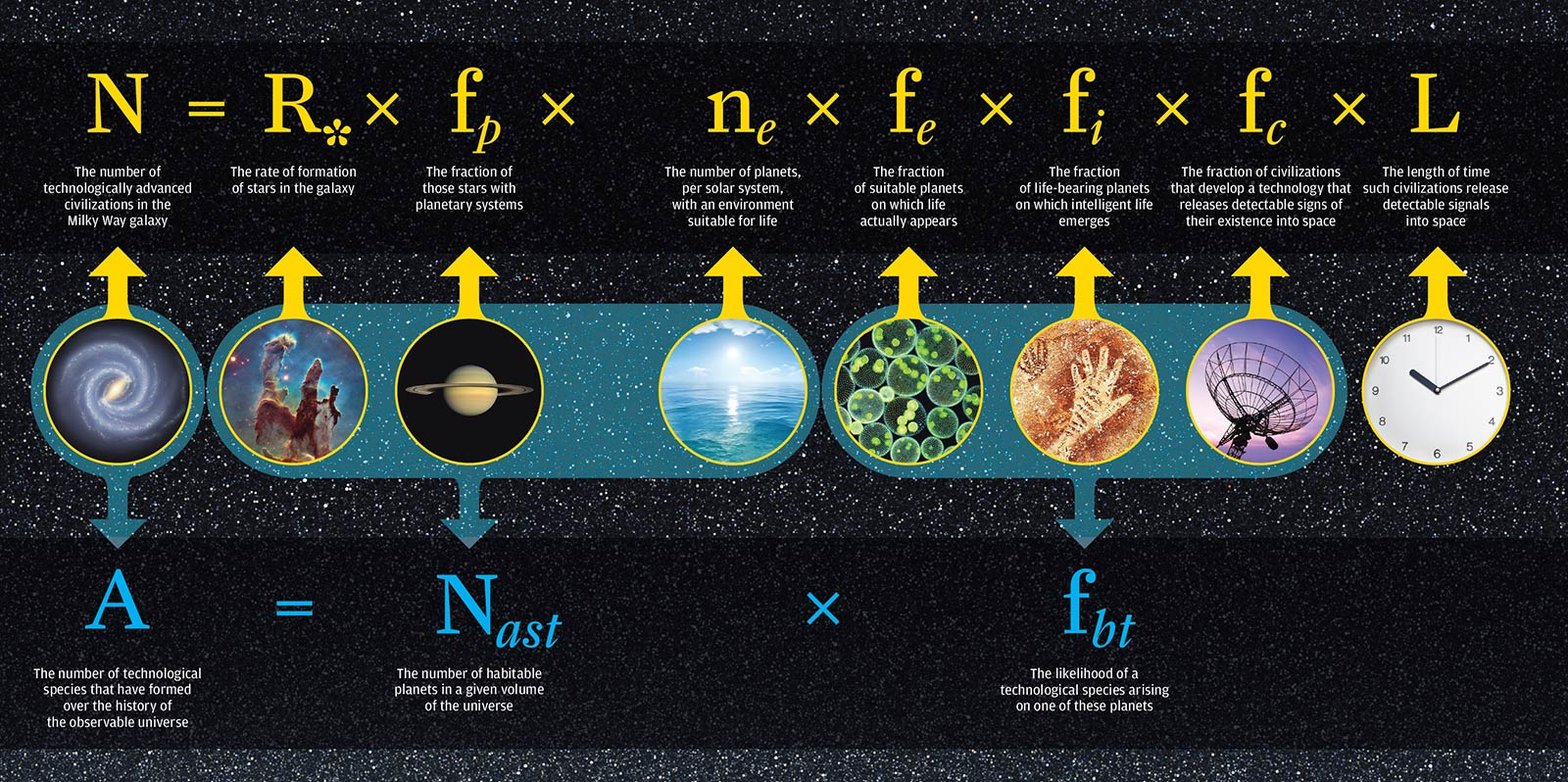

L’Équation de Drake, miroir de notre quête infinie

L’Équation de Drake a été conçue en 1961 par l’astronome Frank Drake. Elle est bien plus qu’un simple calcul pour estimer le nombre de civilisations communicantes dans l’univers. Elle s’avère être un cadre de réflexion qui nous confronte non seulement aux mystères du cosmos mais aussi à nos propres limites et à notre capacité d’adaptation.

L’équation ne prétend pas offrir une réponse définitive. Elle invite à une réflexion collective. Chaque paramètre de la naissance des étoiles (R*) à la durée pendant laquelle une civilisation reste détectable (L) ouvre un champ de questionnements. L’astronomie dialogue avec la biologie, la sociologie et même la philosophie. Cette multidisciplinarité illustre parfaitement que notre compréhension du monde ne peut se réduire à une seule perspective. Face aux avancées fulgurantes de l’IA, il est tentant de se laisser submerger par la crainte d’un avenir prévisible et normé que beaucoup appellent de leurs vœux. Chaque paramètre de l’équation nous rappelle que, tout comme l’univers, l’humain est pluriel et riche de multiples intelligences. C’est en embrassant cette diversité que nous pourrons véritablement tirer profit des transformations en cours.

Vous l’aurez aisément compris, j’adore cette équation, je la trouve magnifique !

Drake ne cherchait pas à imposer un nombre fixe, mais à susciter un débat. Certains valorisent des estimations optimistes alors que d’autres restent prudents en optant pour des approches plus conservatrices. Ce dialogue, loin de nous enfermer dans une vision réductrice de l’univers, nous enseigne que la science progresse grâce à la remise en question constante. De la même manière puisque nous sommes dans un monde en perpétuel changement, il nous appartient de transformer chaque incertitude en opportunité.

L’équation de Drake appliquée à l’IA

Probabilité d’avoir une IA bénéfique pour tous =Rdev × finvest × finnov × falign × fadopt × fgouv × L

Avec :

RdevR est le rythme de développement global de l’IA. Par exemple, combien de grandes avancées (théoriques, technologiques ou méthodologiques) sont produites par an dans le monde.

finvest est la fraction de ces avancées faisant l’objet d’investissements et de ressources dédiés à des recherches « éthiques » ou « orientées bénéfices collectifs ». Autrement dit, la proportion de ces avancées qui vont être suffisamment financées et utilisées dans une optique d’IA durable et inclusive.

finnov est la fraction qui aboutit effectivement à des innovations concrètes. Ici, on mesure le « taux de succès technologique » : quelles percées vont réellement améliorer les capacités des systèmes d’IA pour résoudre des problèmes sociétaux, environnementaux, etc.

falign est la probabilité que les nouvelles IA soient alignées sur les intérêts humains. C’est-à-dire qu’elles respectent des principes de non-nocivité, de transparence, de respect des droits fondamentaux, et qu’elles minimisent les effets pervers (biais, manipulations, discriminations…).

fadopt est la fraction d’innovations alignées qui sont effectivement adoptées par la société. Même une IA « vertueuse » peut ne pas être adoptée si la culture, les incitations économiques, la réglementation ou le contexte social ne s’y prêtent pas.

fgouv est la fraction de ces IA adoptées qui sont durablement gouvernées, régulées et encadrées. C’est la probabilité que des mécanismes de veille, d’audit et de pilotage évitent les dérives (par exemple : dérégulation, monopoles technologiques, dérive vers des usages contraires à l’intérêt général, etc.).

L est la durée (en années, par exemple) pendant laquelle l’IA demeure dans cet état “bénéfique” car même une IA adoptée et bien gouvernée au départ peut, au fil du temps, être compromise par des changements d’objectifs, de gouvernance, de contexte économique ou politique.

Quelques aides à l’usage

Le produit de ces facteurs donne la probabilité (ou le “niveau” de réussite) avec laquelle l’humanité parviendra à une IA réellement bénéfique et durable.

Comme dans l’équation de Drake originale, si l’un des facteurs est très faible, cela fait chuter l’ensemble ; si la chaîne d’étapes est solide, la probabilité globale augmente.

Cette formulation met l’accent non seulement sur l’innovation technique, mais aussi sur l’alignement des systèmes, l’adoption collective, et la bonne gouvernance.

Enfin, l’importance de la durée est soulignée : même une IA prometteuse aujourd’hui peut dériver si l’environnement social, économique et politique n’est pas capable d’assurer un suivi et une mise à jour de l’éthique et de la réglementation.

Cette « équation de Drake » revisitée n’est bien sûr pas une formule mathématique exacte :

Elle sert surtout de cadre conceptuel pour décomposer les conditions du succès d’une IA profitable à tous.

Elle aide à prendre conscience que les facteurs ne sont pas uniquement scientifiques ou technologiques : la culture, le cadre législatif, la régulation, l’éducation, ou encore les mécanismes de gouvernance ont un rôle aussi crucial que la recherche.

Dans la pratique, chiffrer chacun de ces termes exigerait beaucoup de données et de consensus… mais l’essentiel est de repérer où se situent les points de blocage ou d’opportunité pour faire progresser cette probabilité. Et en y réfléchissant, la probabilité à date est très faible !

En s’inspirant de ce type d’équation, on peut mener une réflexion structurée sur où investir nos ressources, comment adapter nos institutions, et comment encourager un usage responsable de l’IA pour le bien commun.

A l’inverse, voici l’équation pour avoir la probabilité d’une “dictature algorithmique” aux USA :

Probabilité d’une dictature algorithmique aux USA = Dtech × Cpouvoir × (1−flois) × (1−fcontrepouvoirs) × (1−fvigilance) × Sinstable

Avec :

Dtech : Degré de pénétration technologique →– Proportion (ou probabilité) que les algorithmes soient suffisamment avancés et intégrés dans tous les rouages de la vie (plateformes massives, surveillance omniprésente…).

Cpouvoir : Degré de centralisation du pouvoir. Probabilité qu’un nombre restreint d’acteurs (gouvernement + consortium privé, par ex.) contrôlent la majorité des ressources et plateformes IA.

flois : Fraction de lois et régulations protectrices qui sont effectives. Plus cette fraction est haute, plus la probabilité de dictature algorithmique baisse ; d’où le facteur (1−flois).

fcontrepouvoirs : Fraction de contrepouvoirs (Justice, médias indépendants, ONG…) capables de résister. On le soustrait de 1 car plus ce facteur est fort, plus il diminue la tendance à la dictature.

fvigilance : Fraction de citoyens vigilants et mobilisés, conscients des dangers. Idem, plus elle est forte, plus la probabilité d’un basculement autoritaire diminue.

Sinstable : Facteur de contexte politique/sociétal instable → Il traduit la probabilité que, dans un contexte de crise (terrorisme, pandémie, conflit…), le gouvernement et/ou la population acceptent des mesures liberticides (au nom de la sécurité, par exemple).

La probabilité est loin d’être nulle, mais reste contenue tant que la tradition de contre-pouvoirs et de défense des libertés demeure solide… En revanche, un enchaînement de crises (politiques, sociales, climatiques, économiques) + une dépendance accrue à des algorithmes opaques feront grimper ce risque, jusqu’à potentiellement permettre l’émergence d’une forme de « dictature algorithmique » version XXIᵉ siècle, qu’elle soit étatique ou corporative. Toute ressemblance est fortuite !

Et à la sauvegarde de la biodiversité

Probabilité d’avoir une biodiversité florissante dans 20 ans = fpolitiques frégulations ffinancements frestauration fchangement_climatique fadoption_sociétale * Rrésilience

Avec

fpolitiques : Fraction de gouvernements/acteurs majeurs réellement motivés

Mesure le degré d’engagement des États (et instances internationales) à mettre la biodiversité en priorité dans leurs agendas.

Intègre la volonté politique de limiter la pollution, de protéger les habitats, de soutenir la recherche…

freˊgulations : Degré de mise en œuvre effective des lois et accords

Qu’il s’agisse d’aires protégées, d’interdictions de chasse/pêche non durables, de régulations sur les pesticides, etc.

Même si des lois existent sur le papier, tout dépend de leur application concrète et de la lutte contre le braconnage, la surpêche, etc.

ffinancements : Proportion d’investissements et de budgets alloués

Inclut le financement de la conservation (réserves, parcs nationaux, corridors écologiques), de la recherche en biologie, des programmes de protection d’espèces menacées, etc.

Plus cette fraction est élevée, plus les moyens d’action sur le terrain seront réels et pérennes.

frestauration : Taux de réussite des initiatives de restauration des écosystèmes

Reforestation, réhabilitations de zones humides, restauration des récifs coralliens, etc.

On cherche la part de ces efforts qui aboutissent à un retour tangible de la biodiversité, et pas seulement à des mesures symboliques.

fchangement_climatique : Capacité à limiter les effets du réchauffement

La biodiversité est directement menacée par le dérèglement climatique (acidification des océans, sécheresses, migrations forcées…).

Plus on limite la hausse des températures (et ses conséquences), plus on donne une chance aux écosystèmes de s’adapter.

f_adoption_sociétale : Degré de conscientisation et d’engagement du grand public et des entreprises

Adoption d’habitudes de consommation plus respectueuses (alimentation, mobilité, produits biodégradables…), d’approches agricoles durables (agro-écologie).

Pression des citoyens sur les gouvernements et les entreprises pour faire évoluer les pratiques (manifestations, boycott, vote, etc.).

Rreˊsilience : Résilience intrinsèque des écosystèmes

Même en présence de bonnes actions, la capacité de la nature à se reconstituer varie selon les zones et la vitesse du changement climatique.

Certains milieux (forêts tropicales, récifs coralliens) sont extrêmement riches mais aussi très sensibles ; d’autres (zones boréales, écosystèmes tempérés) peuvent mieux encaisser une partie des chocs.

Ce facteur couvre l’idée qu’il existe parfois des « points de non-retour » : s’ils sont dépassés, la restauration devient extrêmement difficile, voire impossible.

En résumé, cette “équation de Drake” pour la biodiversité montre que notre capacité à coordonner nos actions et à traduire les bonnes intentions en réels changements sera déterminante pour la santé du vivant en 2045… et au-delà Encore une fois cela n’est pas gagné !

L'informatique quantique : point d’étape

L’informatique quantique, longtemps reléguée au statut de promesse futuriste, franchit en ce début de l’année 2025 un cap. Fiabilité accrue, scalabilité améliorée, applications concrètes sont au rendez-vous. Ces avancées spectaculaires redéfinissent les frontières du calcul, de la cryptographie et de l’intelligence artificielle. Les géants technologiques et les startups redoublent d’efforts pour s’imposer dans cette nouvelle ère car de nombreuses possibilités vont naitre. Cette transformation bien qu’encore en développement se matérialise déjà par des applications tangibles qui vont remodeler l’ensemble de nos systèmes économiques et scientifiques.

Commençons par les bases : Qubit, superposition quantique, intrication et corrélations non locales

Contrairement aux bits classiques figés dans un état binaire (0 ou 1), les qubits exploitent la superposition quantique pour exister simultanément dans plusieurs états. Ils sont donc 0 et 1 en même temps du moins tant qu’ils ne sont pas observés.

La vidéo ci-dessous explique parfaitement l’expérience du chat de Schrödinger et vous expliquera visuellement la superposition des états.

Cette propriété donne aux ordinateurs quantiques une capacité de calcul exponentielle qui leur permettent de résoudre des problèmes inaccessibles aux systèmes classiques. Ce changement radical du calcul repose sur des phénomènes issus de la mécanique quantique qui défient notre compréhension traditionnelle de l’information et du traitement des données. L’algorithme de Shor (conçu en 1994) illustre parfaitement cette puissance et l’obsolescence des systèmes présents. Il pourrait briser les systèmes cryptographiques modernes en factorisant de grands nombres en temps polynomial. Cette simple démonstration suffit à rendre obsolètes des décennies de sécurisation des données. Cette rupture technologique impose un changement de paradigme. Cela oblige les chercheurs et les gouvernements à revoir intégralement les protocoles de cybersécurité et à anticiper la transition vers des systèmes résistants aux attaques quantiques.

L’intrication quantique est un phénomène où deux particules restent corrélées instantanément indépendamment de la distance qui les sépare. Il ouvre la voie à un internet quantique ultra-sécurisé. Des avancées en 2024 dans la stabilisation des photons intriqués ont prouvé la faisabilité de ces réseaux. Ces dernières permettent non seulement d’imaginer des systèmes de communication totalement inviolables mais également de révolutionner la synchronisation des horloges atomiques et l’amélioration des capteurs quantiques pour des applications en astrophysique et en médecine.

Pour tout comprendre :

La stabilisation du calcul quantique

L’un des plus grands défis de l’informatique quantique a toujours été la fiabilité des calculs du fait du bruit (erreur) quantique et la décohérence. En novembre 2024, Microsoft et Atom Computing ont franchi un cap en annonçant la création de 24 qubits logiques à partir de 1 000 qubits physiques. En parallèle, Google avec son processeur Willow (105 qubits) a démontré une réduction exponentielle des erreurs en augmentant la taille des réseaux de qubits supraconducteurs. Ces progrès changent tout et ouvrent la voie à des machines plus robustes, capables d’exécuter des calculs d’une complexité inaccessible jusqu’alors. Chaque avancée rapproche les chercheurs de l’objectif ultime à savoir un calcul quantique tolérant aux fautes, où la correction d’erreurs est intégrée en temps réel. Le développement de techniques avancées de codage et de protection des états quantiques devient essentiel pour assurer la fiabilité des futurs ordinateurs quantiques industriels.

IBM prévoit un système de 4 158 qubits d’ici 2025 et vise une commercialisation pleine d’ici 2028. L’approche hybride où l’informatique quantique est couplée aux supercalculateurs classiques permet déjà des optimisations révolutionnaires dans des domaines comme la chimie et la logistique. Cette hybridation est une étape clé avant d’atteindre l’ère du tout quantique et permet aux entreprises d’exploiter dès maintenant la puissance quantique en complément des infrastructures existantes.

De la cryptographie à l’intelligence artificielle

Avec des processeurs comme Willow, la menace sur les algorithmes de chiffrement devient une réalité (Les algorithmes de chiffrement RSA, DSA et ECC sont les principaux algorithmes utilisés pour générer des clés dans l'infrastructure à clé publique. L'infrastructure à clé publique (ICP) est utilisée pour gérer l'identité et la sécurité dans les communications Internet et les réseaux informatiques). C’est ce qu’on appelle le cryptage pré quantique. En réponse, le NIST (Le National Institute of Standards and Technology en français : « Institut national des normes et de la technologie », est une agence du département du Commerce des États-Unis. Son but est de promouvoir l'économie en développant des technologies, la métrologie et des normes de concert avec l'industrie. Cette agence a pris la suite en 1988 du National Bureau of Standards fondé en 1901 avec substantiellement les mêmes missions) a entamé la standardisation de protocoles résistants aux attaques quantiques. Dès maintenant, les entreprises doivent migrer vers ces solutions pour éviter d’exposer leurs données sensibles. Les gouvernements investissent massivement dans la recherche en cryptographie post-quantique pour prévenir d’éventuelles attaques de grande ampleur qui pourraient compromettre des infrastructures critiques.

L’informatique quantique accélère considérablement la modélisation moléculaire. Atom Computing collabore avec des laboratoires pharmaceutiques pour concevoir des traitements révolutionnaires contre des maladies neurodégénératives. De nouvelles simulations permettent de découvrir plus rapidement des interactions médicamenteuses optimales tout en réduisant drastiquement le temps de développement des traitements. La médecine de précision personnalisée arrive.

Grâce aux algorithmes quantiques comme Grover et la Transformée de Fourier Quantique (QFT), les systèmes d’IA bénéficient d’une puissance de calcul décuplée. Les secteurs financiers et industriels commencent déjà à en tirer profit pour des modèles de prédiction et d’optimisation avancés. Cette convergence entre IA et informatique quantique va accélérer l’innovation dans tous les domaines, de la modélisation climatique à la création de nouveaux matériaux.

Les freins à une révolution totale

Maintenir des qubits à -273°C nécessite des infrastructures cryogéniques coûteuses qui freinent le déploiement commercial massif de l’informatique quantique. De nouvelles pistes de recherche explorent des matériaux plus résilients et des architectures quantiques alternatives pour contourner ces limitations.

Malgré les avancées, les applications accessibles au grand public restent rares. L’absence de retombées immédiates peut entraîner un ralentissement des investissements finalement comme l’IA.

L’informatique quantique n’est plus une simple curiosité de laboratoire. Elle s’impose comme un pilier technologique de demain. Si Google, IBM et Microsoft sans oublier la Chine tracent les grandes lignes de cette révolution, les véritables défis se situent désormais dans la formation des talents, la cybersécurité et l’éthique de ces nouvelles capacités computationnelles. L’avenir sera dans un premier temps hybride en mêlant informatique classique et quantique afin de dépasser les limites actuelles de la connaissance et de l’innovation. La question n’est plus de savoir si l’informatique quantique va changer le monde, mais plutôt quand et comment nous choisirons d’en exploiter tout le potentiel.

L'ère de l'hyper-investissement technologique : une dynamique systémique

L’année 2025 constitue un tournant comme jamais (en attendant 2026) dans la redéfinition des paradigmes technologiques et économiques. L’escalade des investissements des entreprises technologiques américaines représente une tendance inédite où la capitalisation financière devient un levier stratégique, à la fois industriel et géopolitique. Apple, avec un plan d’investissement de 500 milliards de dollars sur quatre ans, ambitionne une convergence entre relocalisation manufacturière et intelligence artificielle. Parallèlement, Meta, Alphabet, Microsoft et Amazon allouent jusqu’à 25 % de leur chiffre d’affaires annuel à l’infrastructure cloud et aux modèles d’IA générative. L’initiative Stargate, pilotée par l’administration Trump et impliquant des acteurs comme OpenAI et Oracle, mobilise également 500 milliards de dollars pour développer des centres de données de nouvelle génération. Dans ce contexte, la Chine intensifie sa contre-offensive via entre autres Alibaba et la start-up DeepSeek, pour remodeler l’équilibre du pouvoir technologique global.

Apple : vers une souveraineté technologique américaine

Apple engage une restructuration systémique de sa production en investissant 500 milliards de dollars dans la relocalisation industrielle et l’optimisation énergétique de ses infrastructures IA. Une nouvelle usine de 23 000 m² à Houston incarne cette ambition avec des serveurs à haut rendement énergétique dédiés à Apple Intelligence. En complément, Apple double son fonds de fabrication avancée à 10 milliards de dollars et établit une collaboration stratégique avec TSMC en Arizona pour le développement de semi-conducteurs de pointe. Au passage, il s’agit de 2 Etats connus pour leurs ressources hydriques … alors qu’il en faut beaucoup. L’initiative s’étend à la formation avec la création d’une académie spécialisée à Detroit, conçue pour structurer un écosystème professionnel autour de l’IA industrielle.

Meta et Alphabet : l’ère des supercalculateurs

Meta adopte une approche d’hyper-expansion en consacrant entre 62 et 65 milliards de dollars à son infrastructure IA pour 2025, avec une capacité d’entraînement accrue grâce à 350 000 GPU Nvidia H100. Alphabet investit quant à lui 75 milliards de dollars pour perfectionner l’IA agentique et implémenter 25 nouveaux centres de données dans le Midwest américain. Ces infrastructures de haute performance sont destinées à renforcer l’autonomie des systèmes d’IA et à maximiser leur capacité d’optimisation cognitive.

Amazon et Microsoft : une consolidation de l’hégémonie du cloud

Amazon oriente ses investissements vers AWS avec un budget de 26 milliards de dollars par trimestre, incluant un engagement de 4 milliards de dollars pour Anthropic, spécialiste des agents conversationnels. Microsoft, de son côté, monopolise 45 % des GPU H100 produits en 2025 et injecte 30 milliards de dollars dans Azure. La concentration des ressources informatiques essentielles s’intensifi.

Projet Stargate : une réponse stratégique aux défis globaux

L’administration Trump a dévoilé le projet Stargate, un programme de 500 milliards de dollars en partenariat avec Oracle, OpenAI et SoftBank, visant à établir 178 centres de données hautement sécurisés. Ces infrastructures de niveau militaire, équipées de systèmes de refroidissement quantique, devraient héberger des modèles d’IA 100 fois plus performants que GPT-4 d’ici 2030. Le premier centre de données, construit sur 12 000 hectares dans le Nevada, est le symbole de la volonté de maintenir la primauté technologique américaine face à la montée en puissance chinoise.

Incitations économiques et consolidation du marché

Les États fédérés américains adoptent des politiques incitatives massives pour attirer ces investissements : le Texas octroie une exonération de 90 % sur les taxes foncières d’Apple, tandis que l’Arizona met en place un crédit d’impôt de 5 milliards de dollars pour TSMC. Ces mesures s’inscrivent dans la continuité du CHIPS Act de 2022 qui avait déjà injecté 280 milliards de dollars dans la relocalisation des semi-conducteurs.

L’IA agentique et ses implications systémiques

L’augmentation des capacités de calcul accélère le développement de l’IA agentique qui se caractérisée par une autonomie décisionnelle accrue. Mais cette avancée s’accompagne d’un coût énergétique exponentiel : la consommation des infrastructures IA en 2025 est très supérieure supérieure à celle des modèles précédents. “Drill, drill, drill, …” Meta expérimente par exemple actuellement des systèmes de gestion autonomes des chaînes d’approvisionnement, réduisant de 35 % les délais logistiques.

Volatilité financière et risques structurels

L’euphorie du marché autour de l’IA a conduit à une augmentation de 45 % de la valorisation des GAMAM en 2024, mais la soutenabilité de ces investissements suscite des inquiétudes. « Dépenser 100 milliards pour générer 20 milliards de revenus n’est pas un modèle viable », souligne un analyste de JPMorgan, pointant du doigt les ratios d’endettement critiques de Meta et Amazon. L’effondrement de 30 % du cours de l’action Nvidia en janvier 2025, suite aux avancées technologiques de DeepSeek, n’est que le symbole de cette instabilité croissante.

La pression énergétique : une contrainte systémique

Les centres de données américains devraient absorber 8 % de l’électricité nationale en 2026, contre 4 % en 2023, d’après l’EIA. Pour pallier cette explosion de la demande énergétique, Amazon mise sur 12 réacteurs nucléaires modulaires, tandis que Microsoft développe des infrastructures sous-marines fonctionnant grâce à l’énergie marémotrice en plus de son accord nucléaire.

La stratégie chinoise et l’alternative technologique émergente

Alibaba a répliqué avec un plan de 50 milliards d’euros sur trois ans pour renforcer ses modèles d’IA et à développer une infrastructure cloud indépendante des technologies occidentales. L’entreprise introduit Tongyi Qianwen 2.0, un modèle concurrent de GPT-4 alimenté par 400 000 GPU Phytium de fabrication chinoise.

DeepSeek a créé la surprise en janvier 2025 en dévoilant DeepSeek-V3 et R1, capables de rivaliser avec GPT-4 tout en réduisant de façon substantielle les coûts d’entraînement. Cette approche, basée sur une architecture algorithmique plus efficiente, a provoqué une chute temporaire des valorisations boursières américaines avant un rebond incertain.

L’IA s’insère progressivement dans les dynamiques physiques et économiques : Amazon déploie 50 000 robots autonomes, Tesla développe ses Robotaxis, les réseaux 6G se généralisent pour optimiser la latence, …. Mais le paradoxe de Jevons menace : l’augmentation de l’efficacité énergétique entraîne paradoxalement une hausse de la demande. Selon le cabinet Omdia, la consommation de puissance de calcul IA triplera d’ici 2027. Entre consolidation industrielle, émergence de l’IA agentique et affrontement géopolitique sino-américain, les prochaines années seront marquées par des transformations systémiques. L’équilibre entre innovation et risque demeure précaire, et l’enjeu central réside dans la capacité des sociétés à absorber et à réguler cette dynamique d’hyper-croissance et l’Europe doit être souveraine !

Bonnes métamorphoses et à la semaine prochaine.

Stéphane