#76 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

Superintelligence, entre fascination et précipice / Mark Zuckerberg et la transformation de Meta / L’IA dans la recherche scientifique / L’IA et l’érosion de la pensée critique / Vivre avec l'IA : opportunité ou menace ? / Lexique des outils de l’IA et concepts clés

Bonjour à toutes et tous,

Au menu cette semaine :

Superintelligence, entre fascination et précipice

Mark Zuckerberg et la transformation de Meta

L’IA dans la recherche scientifique

L’IA et l’érosion de la pensée critique

Vivre avec l'IA : opportunité ou menace ?

Lexique des outils de l’IA et concepts clés

Bonne lecture.

Superintelligence, entre fascination et précipice

Le concept de superintelligence est au croisement de la science et de la philosophie. Il pose autant de questions qu’il ouvre de perspectives. Selon Sam Altman (CEO d’OpenAI), l'émergence de la superintelligence constitue une avancée révolutionnaire qui est en capacité de transformer radicalement notre capacité à résoudre des problèmes globaux tout en introduisant d’importantes incertitudes systémiques. Selon lui, une coopération mondiale est essentielle afin de garantir un développement responsable de cette technologie (ouf). Fondée en 2015, OpenAI avait pour mission initiale de promouvoir une IA bénéfique et accessible. L’organisation a adopté au fil des années un modèle hybride qui combinait une entité à but lucratif plafonné et une entité à but non lucratif. Elle va continuer sa mue vers une société purement commerciale. Ce changement vise à attirer des investissements. Cette transition a suscité des critiques académiques et sociétales. Certains dénoncent une érosion des principes de transparence et d’accessibilité qui étaient au cœur de la vision initiale.

Sam Altman estime que l’intelligence artificielle générale (AGI) (définie comme une IA capable d’accomplir toutes les tâches cognitives humaines) est à portée de main. La prochaine étape est selon lui celle de la superintelligence à savoir un système dépassant les capacités humaines et apte à explorer des horizons scientifiques inaccessibles aux méthodes conventionnelles. Au regard de la tournure des événements, cette dernière sera réalisée par une entreprise commerciale américaine (xAI d’Elon Musk pour son écosystème de cloud computing, OpenAI pour sa capacité à innover et leur petit temps d’avance et Google pour sa gestion de l’ensemble de la chaine de valeur sans besoin d’argent extérieur sont à mon avis les mieux positionnées) ou chinoise. ll faut bien comprendre que le premier à y arriver sera très probablement le roi du monde. Cela impose de répondre urgemment à des questions sur ce que nous souhaitons : quelles garanties avons-nous que ces systèmes resteront alignés avec les valeurs humaines ? Comment gérer les risques liés à leur autonomie croissante ? Quel modèle sociétal et économique ? … ? … ?

Evidemment, les promesses associées à la superintelligence sont éblouissantes : accélération des découvertes médicales, solutions aux crises climatiques et création de modèles économiques plus efficaces. Ces avancées potentielles s’accompagnent de risques éthiques profonds. L’opacité des algorithmes, la concentration du pouvoir technologique entre quelques entreprises et les possibles détournements à des fins malveillantes constituent des menaces systémiques, sans parler du risque d’échappement … Sam Altman plaide pour une gouvernance globale. Il préconise un cadre de collaboration internationale et une responsabilité partagée comme le fait l’UNESCO depuis deux ans sans être écouté.

Il faut aller très vite car à titre d’exemple OpenAI prévoit le déploiement de systèmes d’IA autonomes dès 2025. Chaque avancée s’accompagne d’une opacité accrue quant aux conséquences de ces technologies. Le contrôle et l’alignement des systèmes sur des intérêts collectifs ne peuvent plus être laissés au hasard. En plaçant l’éthique au cœur du débat, il devient possible de prévenir les dérives potentielles et de s’assurer que la superintelligence ne soit pas un instrument d’oppression et de domination. Sans un cadre de responsabilité solide, l’innovation risque de devenir une quête déconnectée des besoins de l’humanité et comme nous le savons tous pour protéger l’humain de l’IA, il faut protéger l’IA de l’humain.

Il vaut mieux s’occuper du changement avant qu’il ne s’occupe de nous !

Mark Zuckerberg et la transformation de Meta

La réorientation récente de Méta est marquée entre autres par d’impactantes décisions sur la modération des contenus et la liberté d'expression. Cela renvoie à la gouvernance des plateformes numériques et leur rôle dans les dynamiques sociopolitiques contemporaines. La restructuration initiée par Mark Zuckerberg s’inscrit dans un contexte politique fortement polarisé et a été amplifiée par une rencontre récente avec Donald Trump à Mar-a-Lago. Cette étape est aussi un virage interne vers une gestion plus centralisée des décisions stratégiques qui impliquent un cercle restreint de collaborateurs triés sur le volet contrairement aux pratiques habituelles de consultation élargie de Meta. Cette approche réduit l’influence des processus participatifs internes, traditionnellement valorisés chez Meta.

Les annonces récentes comme l’assouplissement des restrictions sur les discours controversés, la suppression du programme de vérification des faits et l’augmentation des contenus politiques dans les fils d’actualité ont induits de nombreuses réactions divergentes. Si elles ont été accueillies favorablement par certains milieux conservateurs, elles ont également provoqué des critiques véhémentes de la part de chercheurs, de militants LGBTQ+ et de l’administration Biden. Le nouveau système de modération communautaire est inspiré des "Notes Communautaires" de X. En s'appuyant sur les contributions des utilisateurs pour signaler et contextualiser les contenus potentiellement trompeurs, ce modèle risque de renforcer fortement les biais cognitifs existants. Comme les utilisateurs interagissent principalement avec des contenus conformes à leurs croyances, ils verront leurs perspectives encore plus confirmées ce qui limitera ainsi l'exposition à des points de vue divergents. Cette dynamique favorise la formation de chambres d'écho, exacerbe la polarisation et entrave le dialogue constructif entre différentes communautés.

Les décisions de Mark Zuckerberg reflètent une vision personnelle émanant d’une perception critique des dynamiques actuelles de modération des contenus. Déplorant ce qu’il considère comme une surpolitisation des débats en ligne, il cherche à “recentrer” Meta sur sa mission initiale : « donner aux gens le pouvoir de partager ». Cette réorientation a été explicitée lors d’une interview avec Joe Rogan où il a affirmé sa détermination à diminuer l’influence des pressions extérieures. Ses choix s’accompagnent d’effets collatéraux significatifs. La transition d’une politique de « discours de haine » à celle de « conduite haineuse » introduit un changement sémantique susceptible de reconfigurer les mécanismes de modération. De plus, la réduction des initiatives en faveur de la diversité et de l’inclusion a intensifié les tensions internes, généré des démissions et exacerbé les divisions au sein de l’entreprise.

Les transformations impulsées par Zuckerberg suscitent un débat sociétal sur la responsabilité éthique des plateformes numériques en général. Alors que la promesse affichée est celle d’une plus grande liberté d’expression et d’un débat sociétal élargi, le risque d’amplification des contenus nuisibles et de polarisation accrue demeure prégnant voir en augmentation. Dans ce contexte, le rôle des géants technologiques dans la structuration des discours publics n’est pas uniquement technique mais foncièrement politique. La centralisation du pouvoir décisionnel chez un nombre restreint d’acteurs privés renforce les inégalités systémiques et concentre les risques de biais dans l’arbitrage des discours. Il nous faut d’urgence un cadre réglementaire adapté aux nouveaux enjeux des plateformes numériques. Il ne s’agit pas de contrôler les décisions de Meta, mais de repenser la manière dont les tensions entre liberté d’expression, sécurité collective et justice sociale sont arbitrées à l’échelle sociétale. Ne lâchons pas les belles avancées sociétales que nous avons difficilement réalisées partiellement (le combat n’est pas fini) comme le sexisme et le rejet de la différence sans compromission sur la nécessité de disposer d’un cadre de vie commun.

L’IA dans la recherche scientifique

Une étude approfondie du Wall Street Journal, menée auprès de 1 018 scientifiques travaillant dans un grand centre de R&D américain, a révélé des conséquences de l’adoption de l’IA dans la recherche. L’analyse s’est attachée à étudier la productivité, les transformations structurelles du métier de chercheur et les implications sociologiques profondes pour la motivation des scientifiques.

L’étude révèle un écart notable entre différents segments de chercheurs quant à leur capacité à exploiter l’IA. Les 10 % les plus performants enregistrent une augmentation spectaculaire de leur productivité, atteignant +81 %, grâce à une utilisation optimisée des outils d’IA.

En revanche, les 25 % les moins performants constatent une amélioration marginale de 1,1 %.

Cet écart gigantesque n’est que la traduction d’une inégalité d’accès aux compétences nécessaires pour intégrer efficacement l’IA dans les processus de recherche.

Paradoxalement, malgré les gains objectifs en productivité, l’étude fait état d’une baisse forte de la satisfaction au travail qui touchent 82 % des chercheurs interrogés. L’automatisation des tâches créatives et exploratoires par l’IA semble en être la cause majeure. Cette redéfinition du rôle du chercheur, recentré sur l’analyse et l’interprétation des données produites par l’IA, entraîne un sentiment de dévalorisation des compétences humaines traditionnelles. « Une partie substantielle de ma formation est devenue obsolète », déclare sans surprise un chercheur. Cette dynamique interpelle sur la capacité des institutions académiques à maintenir un équilibre entre innovation technologique et valorisation du potentiel humain dans un contexte où l’IA ne fait qu’accélérer.

Malgré ces tensions, l’IA a permis des progrès substantiels :

Une augmentation de 44 % dans les découvertes de nouveaux matériaux.

Un accroissement de 39 % des dépôts de brevets.

Une amélioration de 17 % des prototypes de produits innovants.

Ces chiffres montrent le potentiel de l’IA à accélérer l’innovation. La durabilité de ces gains dépendra de la capacité des systèmes de recherche à s’adapter à ces nouvelles dynamiques sans sacrifier la satisfaction et l’engagement des chercheurs sauf à remplacer les chercheurs par de l’IA …

L’étude met aussi en évidence une réorganisation structurelle des tâches scientifiques. Les chercheurs ne sont plus principalement engagés dans la création active, mais jouent un rôle croissant d’évaluateurs des résultats générés par des systèmes d’IA. Ce changement redéfinit le cadre de la recherche ce qui provoque un décalage entre les attentes professionnelles de ces derniers et les réalités du terrain. Cette évolution induit de s’interroger sur l’attractivité du métier pour les nouvelles générations de scientifiques.

Personnellement, je pense que l’IA ne doit pas remplacer l’humain, mais agir comme un catalyseur de ses capacités. Nous ne sommes pas sociétalement prêts pour qu’il en soit autrement. Pour répondre à ces enjeux, il est impératif de développer des politiques publiques et des cadres éthiques adaptés aux réalités d’une recherche transformée par l’IA. Mon choix limite de fait les capacités de l’IA mais sans cela, elle nous échappera.

L’IA et l’érosion de la pensée critique

Alors que l’IA continue de s’intégrer dans les processus sociétaux et professionnels, les gains en efficacité et en personnalisation sont incontestables. Mais ces avancées posent un problème majeur à savoir les implications cognitives pour les individus et les collectifs face à une dépendance croissante aux systèmes automatisés. Une étude présentée au 8ème Symposium international sur l’IA et le traitement des données met en évidence les risques liés au phénomène d’offloading cognitif.

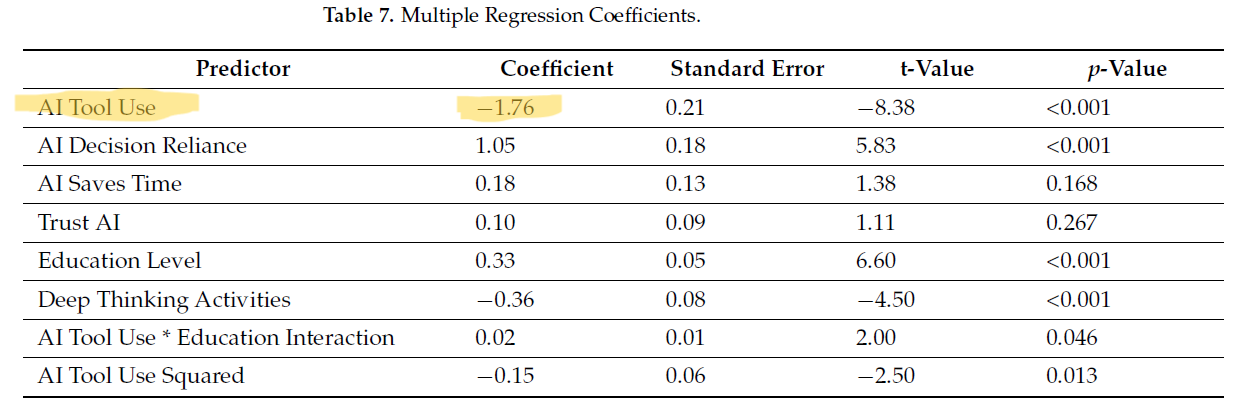

L’article s’appelle “AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking” et a été écrit par Michael Gerlich

Décrite par D.F. Halpern comme une compétence essentielle impliquant l’analyse, l’évaluation et la synthèse d’informations, la pensée critique est de plus en plus menacée par l’utilisation extensive de l’IA. Les outils d’IA (conçus pour offrir des solutions immédiates et optimisées) tendent à éclipser les processus cognitifs profonds et encouragent une acceptation passive des résultats générés. Ce phénomène, qualifié de "paresse cognitive", est particulièrement préoccupant chez les jeunes générations dont les interactions avec des systèmes algorithmiques sont omniprésentes.

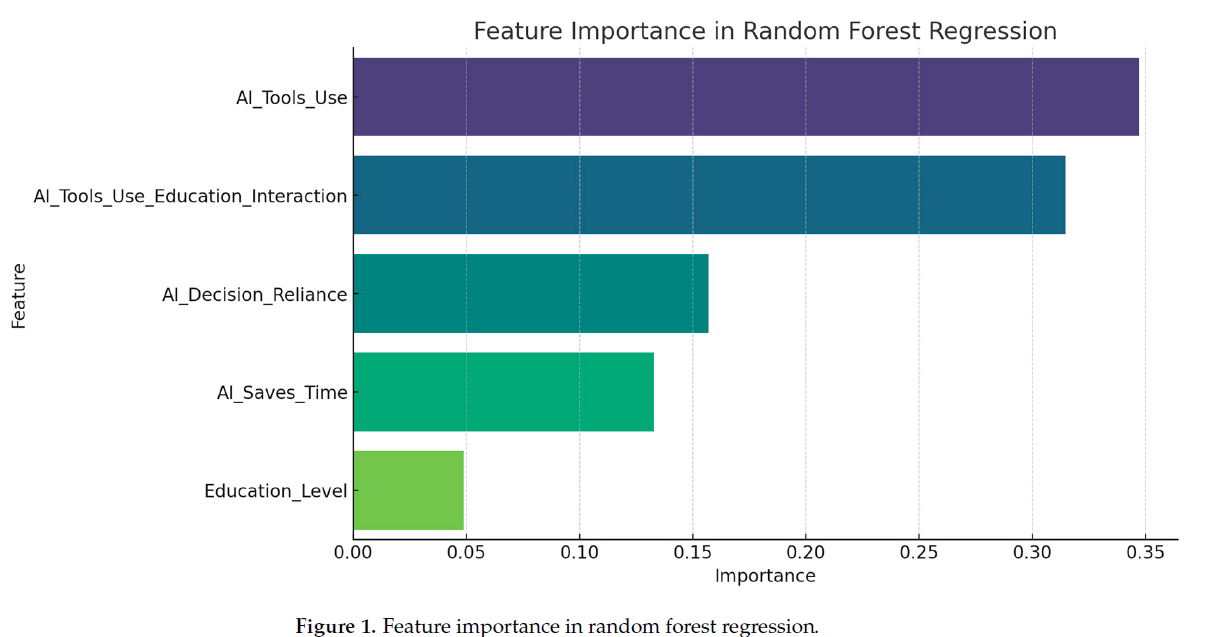

Le coefficient négatif indique que plus l’usage de l’IA est élevé, plus la pensée critique diminue.

La pensée critique est la variable à expliquer. L’usage de l’IA et une variable qui combine le niveau d’éducation et l’usage de l’IA sont les deux facteurs discriminants le plus la pensée critique.

L’offloading cognitif désigne le transfert de tâches mentales à des aides externes comme les systèmes d’IA dans le but de réduire la charge cognitive. Même si cette stratégie peut libérer des ressources pour des activités complexes, une dépendance excessive à ces outils peut résulter en une diminution de l’engagement intellectuel. Par exemple, dans les établissements académiques, les plateformes d’apprentissage adaptatif simplifient l’accès à l’information, mais peuvent éroder les capacités des étudiants à traiter les concepts de manière critique. Cette tendance risque de transformer les élèves en consommateurs passifs de connaissances au détriment d’une compréhension approfondie et nuancée. Dans les secteurs professionnels comme la santé ou la finance, l’adoption de l’IA impose des problèmes similaires : les systèmes d’aide à la décision en médecine offrent des diagnostics précis mais pourraient affaiblir la capacité des cliniciens à évaluer de manière critique des cas atypiques. En finance, les algorithmes de trading automatisés réduisent les risques d’erreurs humaines tout en diminuant le rôle du jugement humain. Cette érosion des compétences analytiques pose des questions sur la capacité des systèmes à répondre à des imprévus ou à des défis inédits.

Pour réconcilier les avantages fonctionnels de l’IA avec la préservation des capacités humaines, une approche éthique et opérationnelle s’impose :

Transparence des systèmes : Les algorithmes doivent expliciter leurs mécanismes, permettant une évaluation critique de leurs recommandations.

Incitation à l’engagement cognitif : Les concepteurs peuvent introduire des dispositifs encourageant les utilisateurs à comparer ou justifier les résultats générés par l’IA.

Réforme éducative : Les programmes académiques doivent intégrer des modules spécifiques d’apprentissage critique, adaptés à un environnement où l’IA est partout.

L’utilité de l’humain dans ce monde rempli d’IA repose sur une vigilance collective et un engagement constant envers le développement de la pensée critique. Cette compétence essentielle à la fois pour l’innovation et pour une citoyenneté informée doit rester une priorité face à l’émergence d’une automatisation omni-pénétrante. En cultivant un équilibre entre adoption technologique et sauvegarde des capacités cognitives, nous pouvons à la fois tirer parti des opportunités offertes par l’IA et préserver ce qui constitue le fondement de notre humanité.

Vivre avec l'IA : opportunité ou menace ?

Afin de mieux comprendre la perception de l’IA à travers le monde, Ipsos a mené une grande enquête dans 11 pays, pour la 21ème édition des Entretiens de Royaumont que vous pouvez trouver en détail ici.

L’IA est perçue comme une opportunité dans certains domaines, mais ses usages suscitent des débats profonds, notamment sur la responsabilité, l’éthique, et l’équité. Ces résultats montrent un besoin urgent d’encadrement clair, de régulation adaptée, et de dialogue global pour aligner cette révolution technologique avec les attentes et valeurs de la société. Le biais de sur confiance est également bien présent ce qui n’est pas un bon signe pour l’avenir. L’information et l’éducation n’ont pas d’autres alternatives que de s’emparer de ces sujets pour que nous puissions être acteurs conscients de nos futurs.

Pour plus de détail :

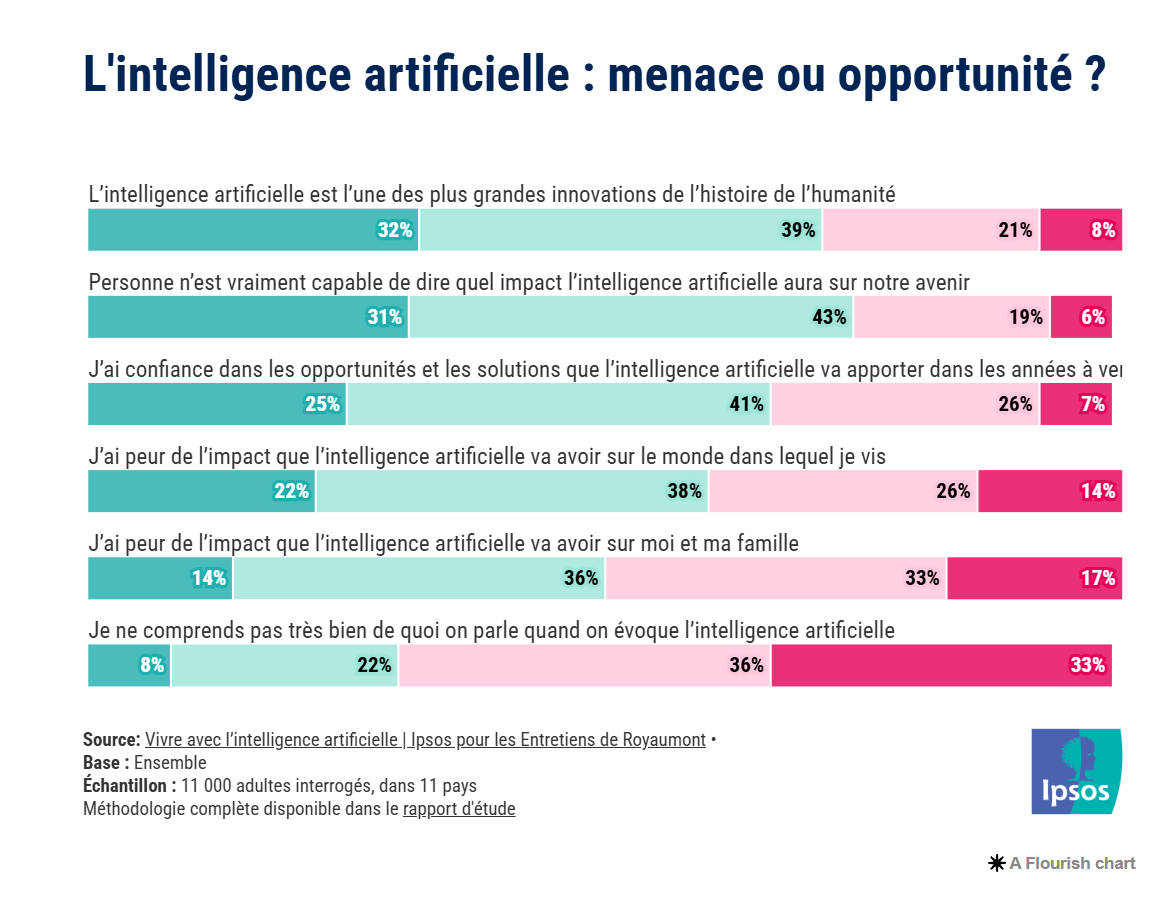

Une innovation majeure…

Pour 71 % des interrogés, l’IA est perçue comme l’une des plus grandes innovations de l’histoire de l’humanité. Un tiers exprime des doutes sur les impacts qu’elle pourrait avoir sur notre avenir. Cette ambivalence est révélatrice d’un manque de clarté sur ce que l’IA promet réellement et sur son cadre d’utilisation dont le juridique fait partie.

Des opportunités… mais la confiance …

Alors que 66 % des répondants disent avoir confiance dans les opportunités que l’IA pourrait apporter, 74% pensent (à mon avis à juste titre) que personne ne sait où cela nous mène.

Les peurs : rationnelles ou amplifiées ou sous estimées ?

22 % des personnes interrogées déclarent avoir très peur de l’impact de l’IA sur le monde dans lequel elles vivent et 14 % redoutent fortement ses effets sur leur vie personnelle et familiale. Ces peurs sont-elles exagérées par des récits alarmistes ou au contraire la traduction d’une méconnaissance des potentialités réelles de l’IA. Je penche pour la seconde solution accompagnée du discours ultra positif des gourous techno entrepreneurs.

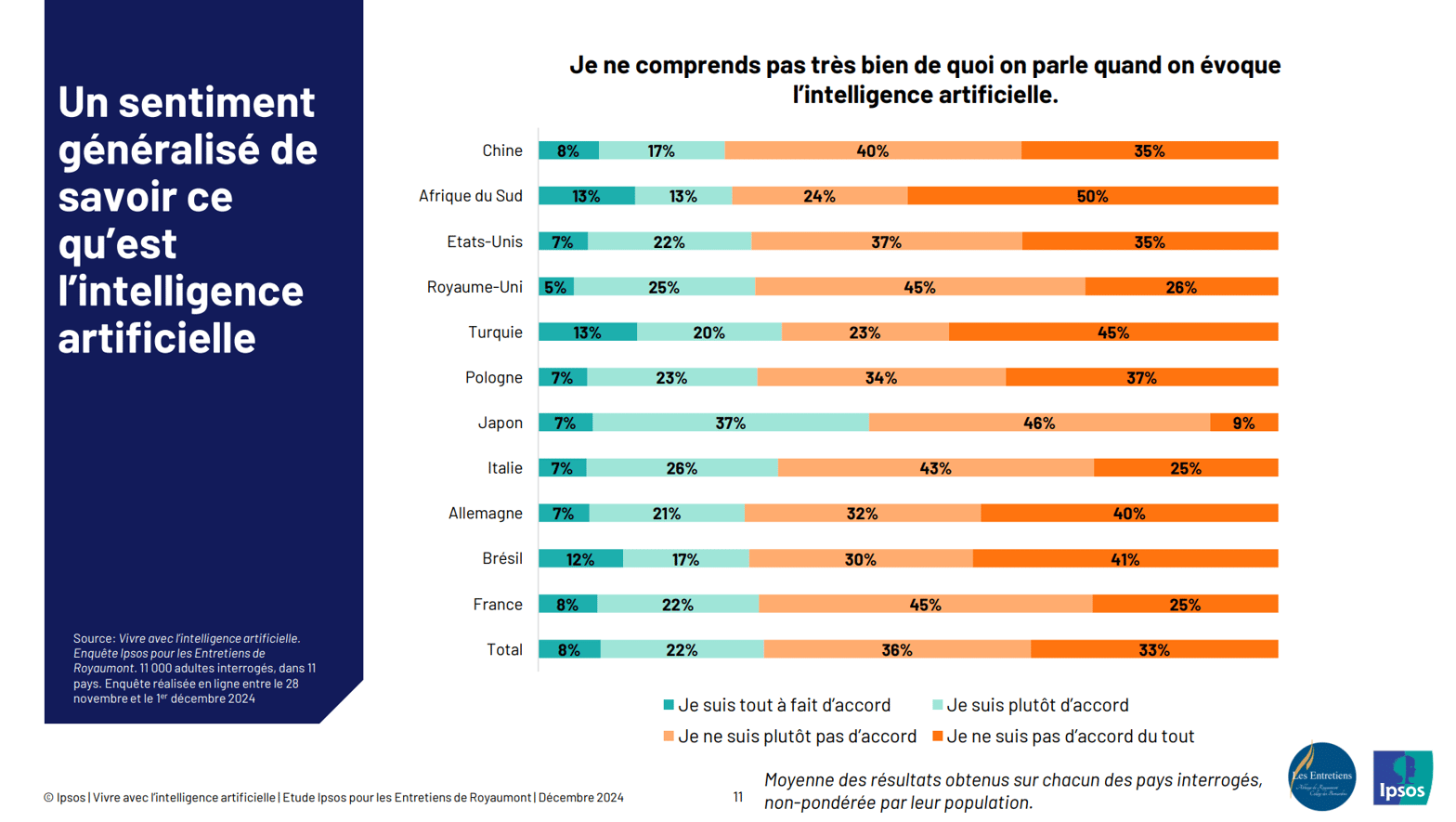

Biais de certitude.

Un chiffre interpelle : 69% des participants déclare comprendre précisément de quoi il s’agit lorsqu’on parle d’IA … A titre personnel, je ne dirai pas ça alors que je baigne dedans depuis de nombreuses années et ce n’est pas non plus ce que je constate auprès de mes clients. Ce chiffre est inquiétant car il conduit à une société pensant savoir alors que nous n’en sommes qu’au début de cette technologie.

___________

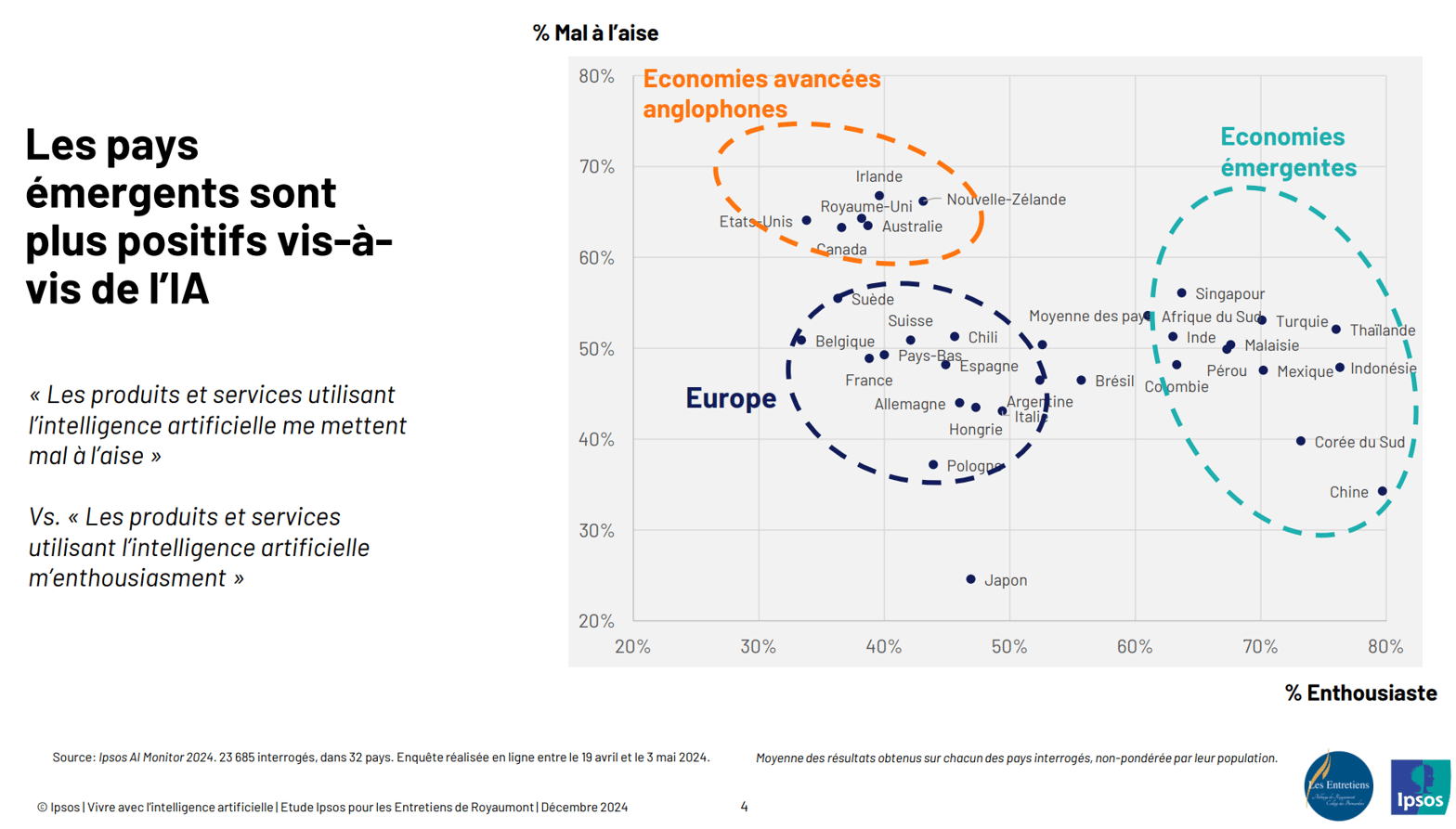

Les pays émergents se montrent nettement plus enthousiastes vis-à-vis des produits et services basés sur l’IA, tandis que les économies avancées, notamment anglophones, affichent une méfiance bien plus marquée.

L’Europe, entre prudence et curiosité

L’Europe se positionne au milieu du spectre, avec un mélange de prudence et d’intérêt. Les raisons en sont certainement culturelles. Cela reflète peut être aussi un niveau de maturité différent dans la compréhension des implications de l’IA. A date, cette prudence européenne est essentiellement vu comme un frein à l’innovation mais comme rien n’est unilatérale, elle est aussi une force pour assurer un développement plus responsable de l’AI à condition de disposer d’un véritable marché pour se développer.

Les économies émergentes

Les pays comme la Chine, l’Indonésie ou le Mexique se montrent particulièrement enthousiastes pour des raisons différentes. Pour l'Indonésie et le Mexique, on peut l’interpréter comme une confiance dans le potentiel de l’IA à transformer leur société et accélérer leur développement économique. Pour la Chine, c’est une condition de survie de son modèle sociale et de son importance géopolitique du fait de la décroissance démographique à venir. L’interrogation repose sur l’équilibre à avoir avec des régulations et une réflexion éthique.

Les économies avancées anglophones

Les États-Unis, le Royaume-Uni et l’Australie expriment un inconfort marqué face aux produits et services liés à l’IA. Cette attitude est-elle le reflet d’une réelle lucidité sur les défis éthiques et les dangers potentiels de l’IA ou bien une peur irrationnelle alimentée par les médias et la polarisation sociétale ? Certainement les deux. La prochaine mise à jour de cette étude sera en cela passionnante à découvrir avec la très probable dérégulation à venir aux USA.

____

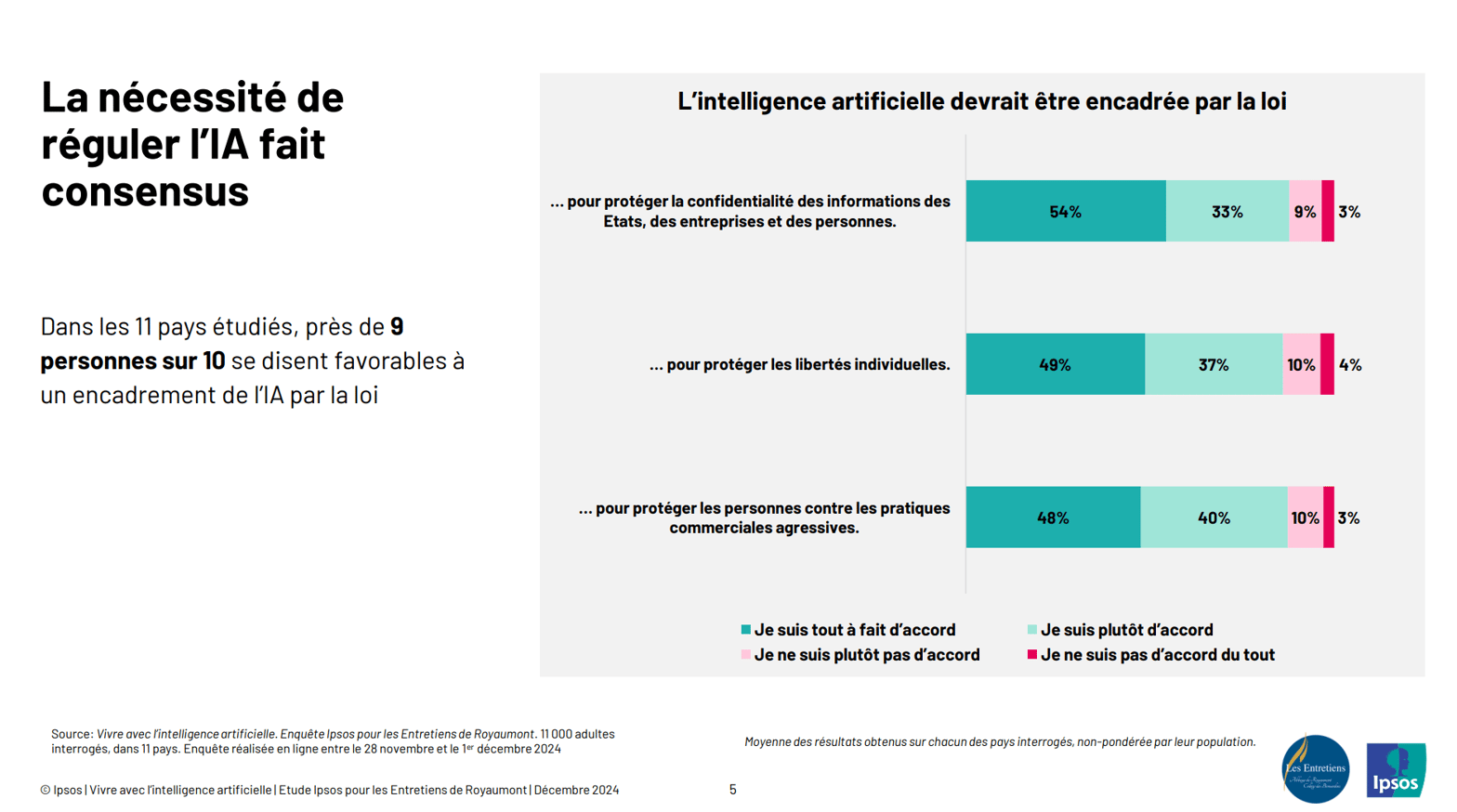

Près de 9 personnes sur 10 dans les 11 pays étudiés se déclarent favorables à un cadre légal pour l’IA. Cette adhésion massive traduit une préoccupation collective visant à garantir que l’IA serve les intérêts de tous tout en minimisant les risques.

Confidentialité, libertés individuelles et pratiques commerciales

Les attentes des citoyens sont partagées :

87 % estiment prioritaire de protéger la confidentialité des informations des États, des entreprises et des individus.

86 % insistent sur la nécessité de préserver les libertés individuelles.

88 % souhaitent être protégés contre des pratiques commerciales jugées agressives.

Ces priorités révèlent un besoin de transparence et d’éthique dans le développement de l’IA. Mais sommes-nous réellement capables d’encadrer ces enjeux à temps ? Pour l’autre moitié, ces sujets

Une régulation, oui… mais comment ?

L’adhésion à une régulation est forte, mais les contours de cette régulation restent flous.

Quels mécanismes juridiques garantiraient la protection sans freiner l’innovation ?

Comment éviter une régulation trop lourde qui étoufferait les startups tout en assurant une surveillance efficace des grandes entreprises ?

Des interrogations pour l’avenir

Cette demande de régulation traduit elle un manque de confiance envers les entreprises tech, ou bien une peur légitime de la dérive de l’IA ? Et surtout, dans un monde globalisé, comment assurer une cohérence entre des régulations nationales et une technologie aux impacts transfrontaliers ? Pas de réponse pour l’instant.

_____

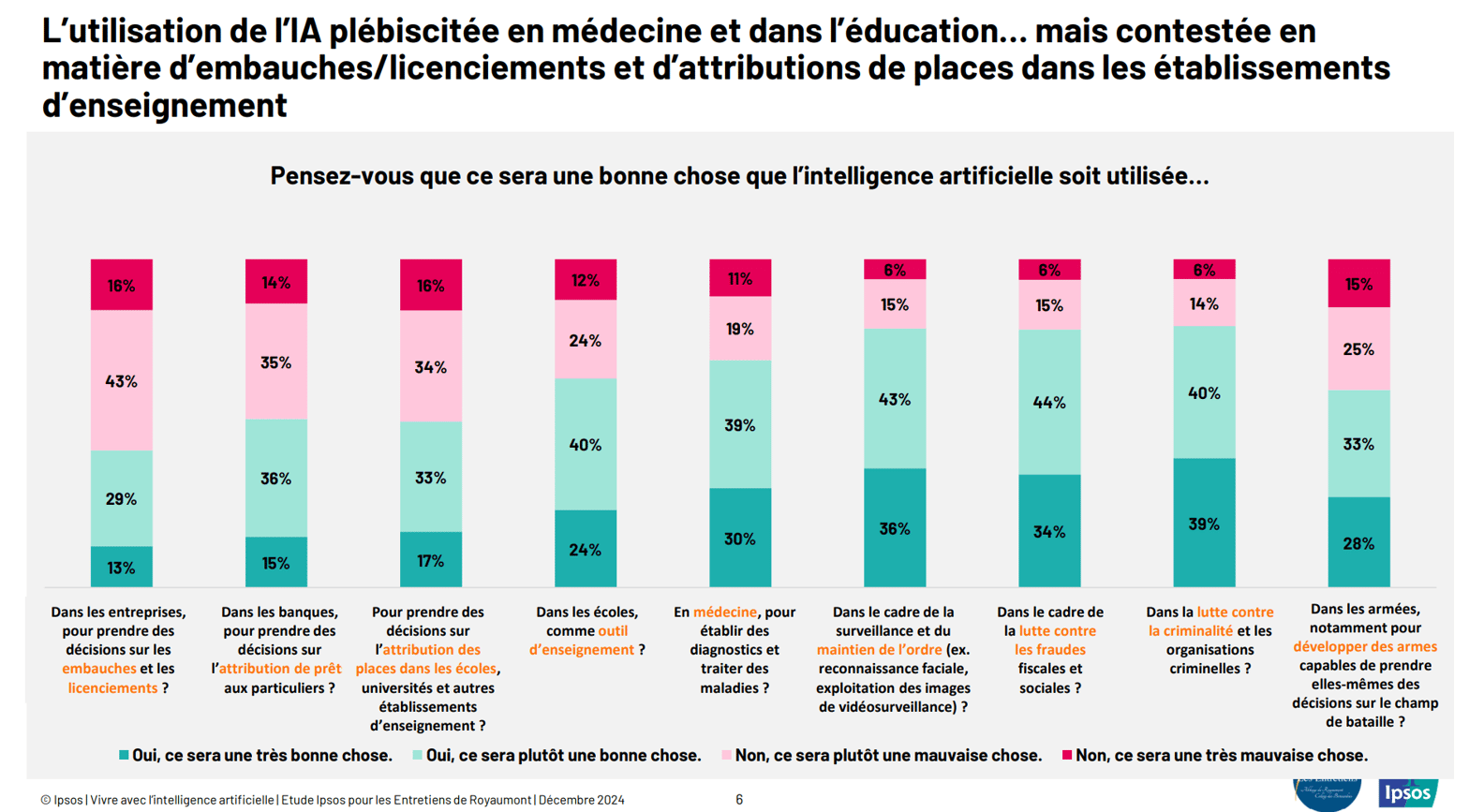

L’étude met en évidence une acceptation contrastée de l’IA selon les contextes : si elle est largement plébiscitée dans des domaines comme la médecine et l’éducation, son utilisation dans des décisions personnelles (embauches, banques et éducation) suscite beaucoup plus de réticences.

Un soutien massif en médecine et pour l’éducation

69 % des sondés trouvent positif l’usage de l’IA pour établir des diagnostics et traiter des maladies.

En tant qu’outil pédagogique, 73 % des participants y voient une opportunité. Mais jusqu’où l’IA doit-elle intervenir ? Peut-elle remplacer le rôle humain dans l’apprentissage ?

Une méfiance notable pour les décisions sensibles et personnelles

Prendre des décisions sur les embauches et licenciements est mal perçu par 59 % des répondants. Sans surprise, dès qu’il s’agit de questions personnelles, l’adhésion est moins forte.

L’attribution de places dans les écoles (51 % de réticence)

Des usages sécuritaires divisés et souvent en contradiction avec la position sur les libertés individuelles

L’utilisation de l’IA pour la surveillance et le maintien de l’ordre est approuvée par 58 %. Mais où se situe la frontière entre sécurité et atteinte aux libertés individuelles qui est jugé indispensable par 49% ?

Pour la lutte contre la criminalité, le soutien monte à 72 %. Pourtant, peut-on garantir que ces systèmes soient exempts de biais et respectueux des droits fondamentaux et donc par exemple contraire aux libertés individuelles ?

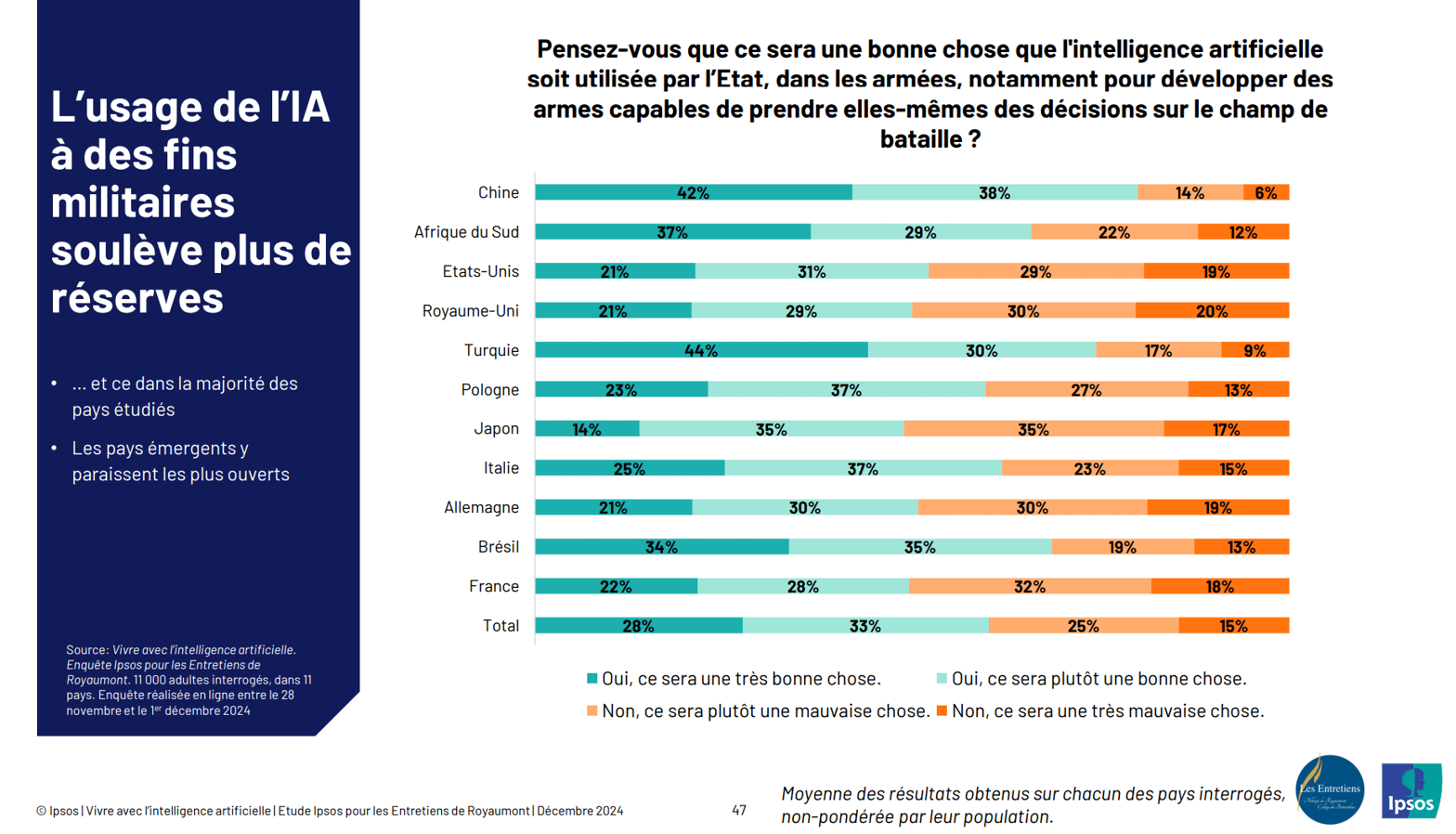

L'IA dans les armées : un rejet étonnamment faible

40 % des sondés considèrent comme une très mauvaise chose que l’IA développe des armes autonomes. Ce chiffre me semble très faible mais je suis biaisé. Les lobbyistes et de nombreux ouvrages ont fait leur effet dans cette acceptation alors que l’imaginaire de ces développements n’est jamais positif …

____

Une grande majorité comprend l’IA …

Ces résultats amènent à une question simple : Savons-nous réellement de quoi nous parlons ?

Le Japon présente une spécificité avec 44 % des répondants affirmant ne pas bien comprendre l’IA.

Dans un monde où l’IA influence de plus en plus de décisions sociétales, la lecture simpliste de ces résultats conduit à la conclusion qu’il reste un travail de fond à faire pour le tiers qui déclarent ne pas savoir. La réalité est plus complexe, le danger vient des personnes pensant savoir. Prétendre comprendre l’IA aujourd’hui représente un danger de certitude qui diminuera notre vigilance. L’IA n’en est qu’à ses débuts et se développe rapidement.

_____

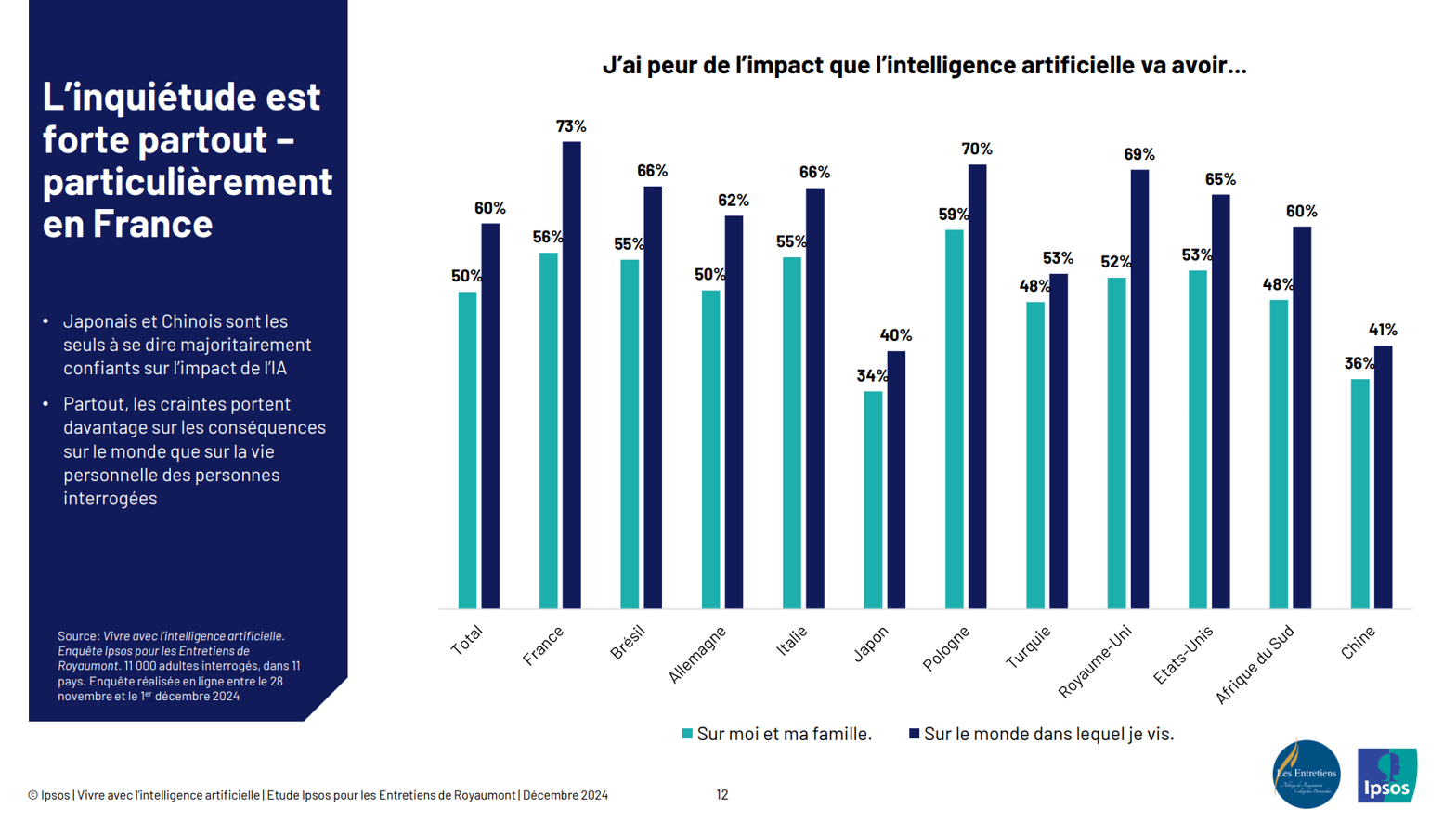

Partout dans le monde, l’intelligence artificielle suscite des craintes, et particulièrement en France, où 73 % des sondés expriment leur peur de son impact sur le monde. Ce sentiment dépasse largement les préoccupations personnelles.

Des différences culturelles marquées

En France, 55 % craignent aussi pour leur vie personnelle, contre seulement 34 % au Japon.

En Chine, où seuls 41 % des sondés se disent préoccupés, cette confiance est-elle le fruit d’une acceptation technologique plus rapide, ou d’un contexte où les impacts sont perçus différemment ?

Un paradoxe : le progrès alimente l’angoisse

Dans des pays technologiquement avancés comme l’Allemagne (66 %) ou le Royaume-Uni (65 %), les craintes sont élevées. La crainte de perdre le contrôle face à une technologie en constante évolution doit jouer.

Le monde avant les individus

L’impact de l’IA sur le monde inquiète davantage que sur soi-même ou sa famille, dans tous les pays étudiés. Est-ce une prise de conscience des enjeux environnementaux, économiques et sociaux à l’échelle globale ? Ou les individus se sentent ils impuissants face à des décisions systémiques influencées par des technologies qu’ils ne maîtrisent pas ?

Ces résultats montrent qu’un travail de pédagogie reste à faire. Les interrogations sont multiples :

Comment réduire cet écart de perception entre l’impact individuel et global ?

Les entreprises et gouvernements font-ils assez pour expliquer les bénéfices potentiels de l’IA et le “côté obscur de la force” ?

Peut-on imaginer une gouvernance mondiale de l’IA qui donnerait des garanties aux citoyens ?

Est ce que ces craintes deviendront des résistances ?

____

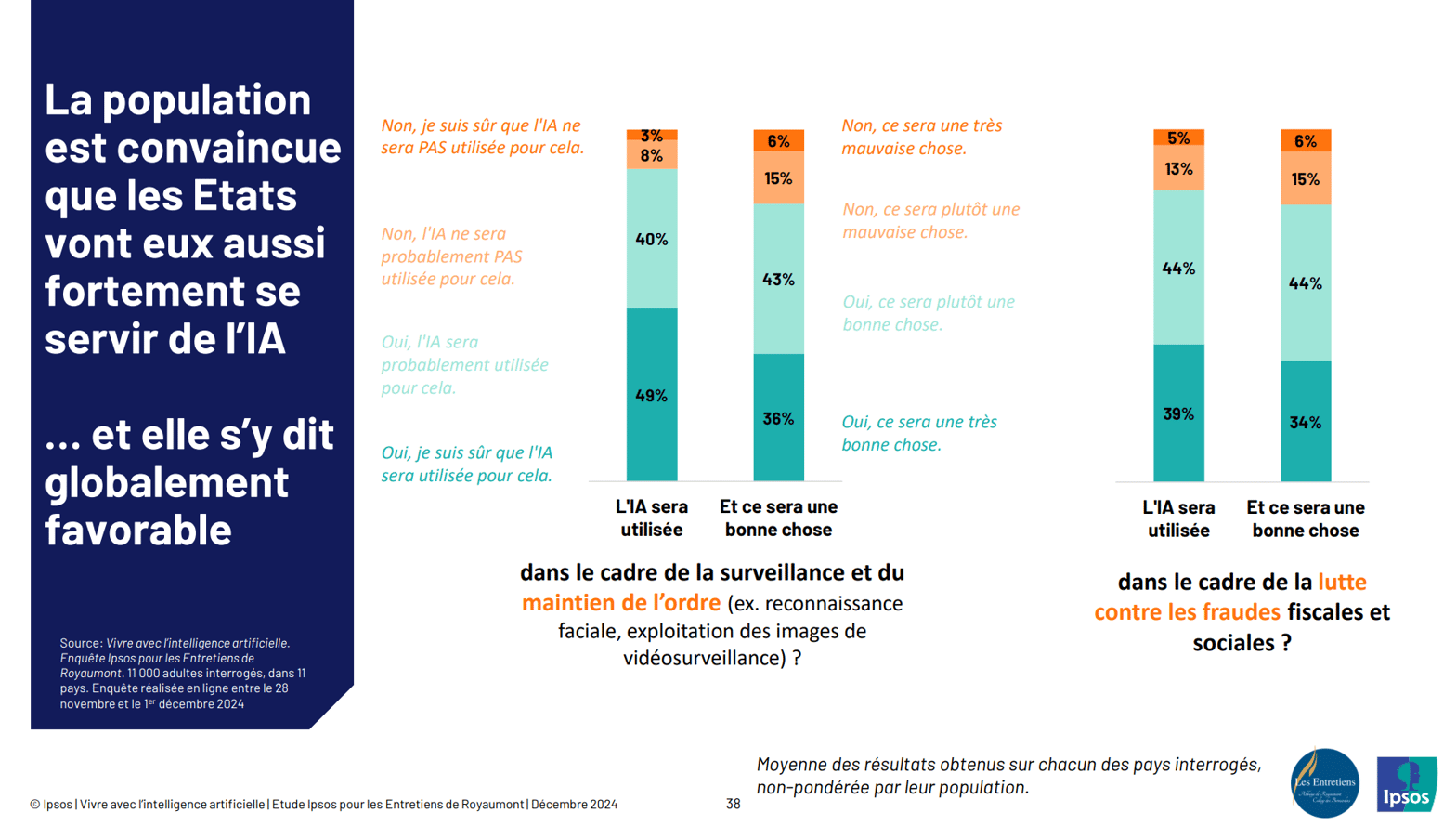

L’IA, un outil que les États adopteront massivement selon les citoyens

L’étude révèle une double certitude : non seulement la majorité des répondants pense que les gouvernements adopteront largement l’IA, mais ils s’y disent également globalement favorables. Cet optimisme impose de répondre à une question : sommes-nous réellement prêts à accepter les implications sociétales et éthiques d’une IA déployée par les États ?

Surveillance et maintien de l’ordre : un terrain favorable, mais délicat

49 % des sondés pensent que l’IA sera utilisée dans le cadre de la surveillance (reconnaissance faciale, vidéosurveillance), et 79 % estiment positif son usage.

Pourtant, l’approbation diminue face aux préoccupations éthiques et aux risques d’atteinte aux libertés individuelles comme nous l’avons vu précédemment. Où tracer la ligne entre sécurité renforcée et respect des droits fondamentaux ?

Dans un contexte où l’IA s’impose dans des domaines stratégiques, la transparence, l’éthique et l’implication citoyenne seront déterminantes. Mais sommes-nous capables d’imposer ces attentes avant que l’adoption ne devienne irréversible ?

____

L’IA militaire : une acceptation surprenante et diversifiée

L’utilisation de l’IA dans un contexte militaire, et notamment pour développer des armes autonomes capables de prendre des décisions sur le champ de bataille, est plébiscité à 61% !!!!!.

Des clivages géographiques significatifs

Les pays émergents comme la Chine et la Turquie se montrent les plus favorables à une adoption de l’IA militaire.

À l’opposé, des pays comme le Japon, l’Allemagne, les USA, la France, le Royaume Uni sont plus partagés. La raison est certainement liée à l’histoire et culturelle.

Face à ces réserves, il semble essentiel d’ouvrir un débat global sur l’avenir de l’IA dans les armées. Mais la vraie question reste : peut-on réellement contrôler une technologie conçue pour agir sans intervention humaine ?

Lexique des outils de l’IA et concepts clés

Ce lexique offre un aperçu des outils et concepts clés dans le domaine de l’IA. Il s’agit d’un point de départ pour approfondir la compréhension et l’intégration de ces technologies dans divers contextes.

Prompt : Un prompt est une instruction ou une requête textuelle fournie à un modèle d’intelligence artificielle, comme GPT, pour générer une réponse. Il constitue le point de départ de l’interaction avec le système. Un bon prompt doit être clair et précis pour obtenir des résultats pertinents.

Assistant IA : Un assistant IA est un système conçu pour fournir une assistance interactive aux utilisateurs. Ces outils utilisent des modèles d’IA pour répondre aux questions, exécuter des commandes vocales, ou automatiser des tâches. Ils peuvent être simple comme les GPT d’OpenAI ou plus complexes.

Agent IA : Un agent IA est un programme capable d’agir de manière autonome dans un environnement pour atteindre des objectifs prédéfinis. Les agents peuvent apprendre et s’adapter en temps réel, souvent grâce à des techniques d’apprentissage par renforcement.

Edge Computing : L’edge computing réfère à une approche d’informatique distribuée où les données sont traitées à proximité de leur source plutôt que dans des centres de données centralisés. Cette technologie réduit la latence et améliore les performances des applications d’IA en temps réel, notamment dans l’Internet des objets (IoT).

RAG (Retrieval-Augmented Generation) : RAG est une technique combinant des méthodes de recherche d’information et de génération de texte pour fournir des réponses plus précises. En intégrant des documents externes ou des bases de connaissances, les modèles RAG enrichissent les générations avec des informations factuelles actualisées.

Machine Learning (ML) : Le machine learning est une branche de l’IA qui repose sur la création d’algorithmes capables d’apprendre à partir de données sans être explicitement programmés. Les modèles de ML s’améliorent au fur et à mesure qu’ils traitent davantage de données.

Deep Learning : Sous-ensemble du machine learning, le deep learning utilise des réseaux neuronaux profonds pour analyser des données complexes. Cette technologie est à la base des avancements récents en reconnaissance d’images, traitement du langage naturel et systèmes autonomes.

Natural Language Processing (NLP) : Le NLP est une discipline qui vise à permettre aux machines de comprendre, interpréter et générer un langage humain naturel. Les applications incluent la traduction automatique, la reconnaissance vocale et les chatbots.

Computer Vision : La vision par ordinateur consiste à doter les machines de la capacité à comprendre et analyser des images ou des vidéos. Elle est largement utilisée dans des domaines comme la reconnaissance faciale, la santé et les véhicules autonomes.

Réseaux Génératifs Adverses (GAN) : Les GAN sont un type de modèle d’IA composé de deux réseaux neuronaux qui s’opposent pour améliorer leurs performances. L’un génère des données (comme des images ou des vidéos) tandis que l’autre évalue leur authenticité, permettant ainsi la création de contenus réalistes.

Explainable AI (XAI) : L’IA explicable cherche à rendre les systèmes d’IA compréhensibles pour les humains. Elle vise à expliquer les décisions prises par des modèles complexes, en renforçant la transparence et la confiance des utilisateurs.

Apprentissage par Renforcement (Reinforcement Learning) : Cette technique d’apprentissage repose sur l’interaction d’un agent avec un environnement. L’agent apprend en répétant des actions et en recevant des récompenses ou des punitions selon les résultats obtenus.

Transfer Learning : L’apprentissage par transfert consiste à utiliser les connaissances acquises par un modèle sur une tâche pour améliorer ses performances sur une autre tâche. Cela réduit le temps et les ressources nécessaires à l’entraînement.

Federated Learning : L’apprentissage fédéré permet de former des modèles d’IA sur des données distribuées sur plusieurs appareils, sans centraliser les données. Cette méthode préserve la confidentialité tout en permettant l’entraînement collaboratif.

Chatbot : Un chatbot est un programme basé sur l’IA conçu pour interagir avec les utilisateurs via des discussions textuelles ou vocales. Ils sont couramment utilisés dans le service client et la gestion des requêtes simples.

Bonnes métamorphoses et à la semaine prochaine.

Stéphane