#77 Il vaut mieux s'occuper du changement avant qu'il s'occupe de vous !

World Economic Forum : le futur des jobs / L’édition génomique humaine / Les recommandations économiques d’Open AI / Plongée dans Coconut

Bonjour à toutes et tous,

Au menu cette semaine :

World Economic Forum : le futur des jobs

L’édition génomique humaine

Les recommandations économiques d’Open AI

Plongée dans Coconut

Bonne lecture.

Métamorphoses à l’ère de l’Intelligence Artificielle est en commande

Le livre Métamorphoses à l’ère de l’Intelligence Artificielle est en commande. Pour ce faire, il suffit de cliquer là.

L’intelligence artificielle, une révolution à décrypter !

J’ai eu l’honneur d’être interviewé par l'APM - Association Progrès du Management partager ma vision sur un sujet qui me passionne et qui bouleverse nos sociétés : l’intelligence artificielle.

Dans cet entretien, je propose une lecture singulière des avantages et inconvénients de l'IA, en explorant ses impacts profonds sur nos vies, nos choix, et notre avenir collectif.

World Economic Forum : le futur des jobs

Ce rapport de 290 pages est passionnant. Il est le résultat d’une enquête sur plus de 1 000 employeurs mondiaux de premier plan représentant collectivement plus de 14 millions de travailleurs dans 22 groupes industriels et 55 économies du monde entier. Même si ces chiffres sont impressionnants, ils n’en demeurent pas moins biaisés car ils ne sont que la projection de ces acteurs à partir de leurs connaissances. Vous l’aurez aisément compris aussi, ils ne concernent pas les PME ou ETI. Certains résultats le montrent parfaitement mais gardons le suspense.

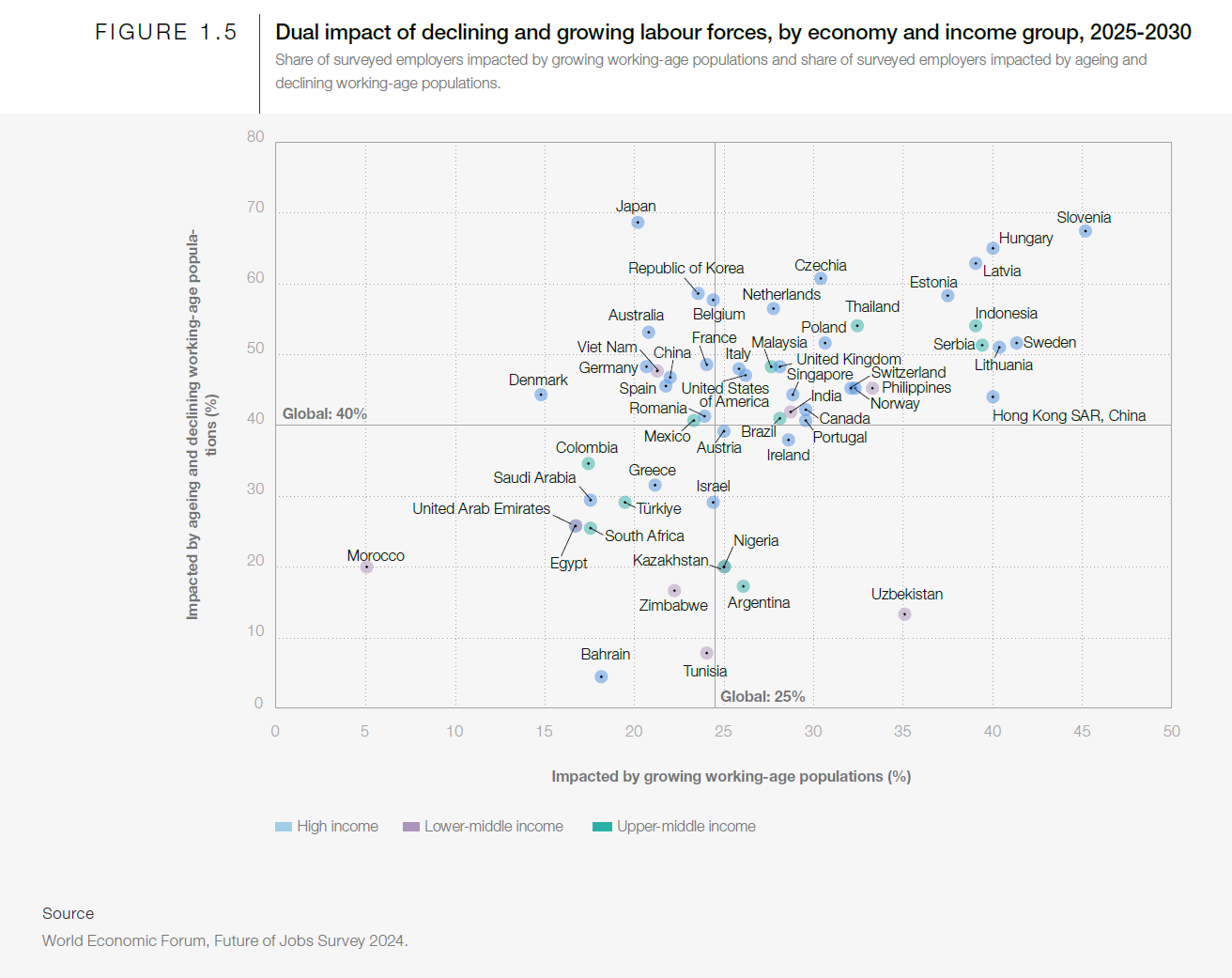

Afin de comprendre les résultats, il est fort utile de rappeler que le futur de l’emploi est très lié à la dynamique démographique et les situations sont très différentes.

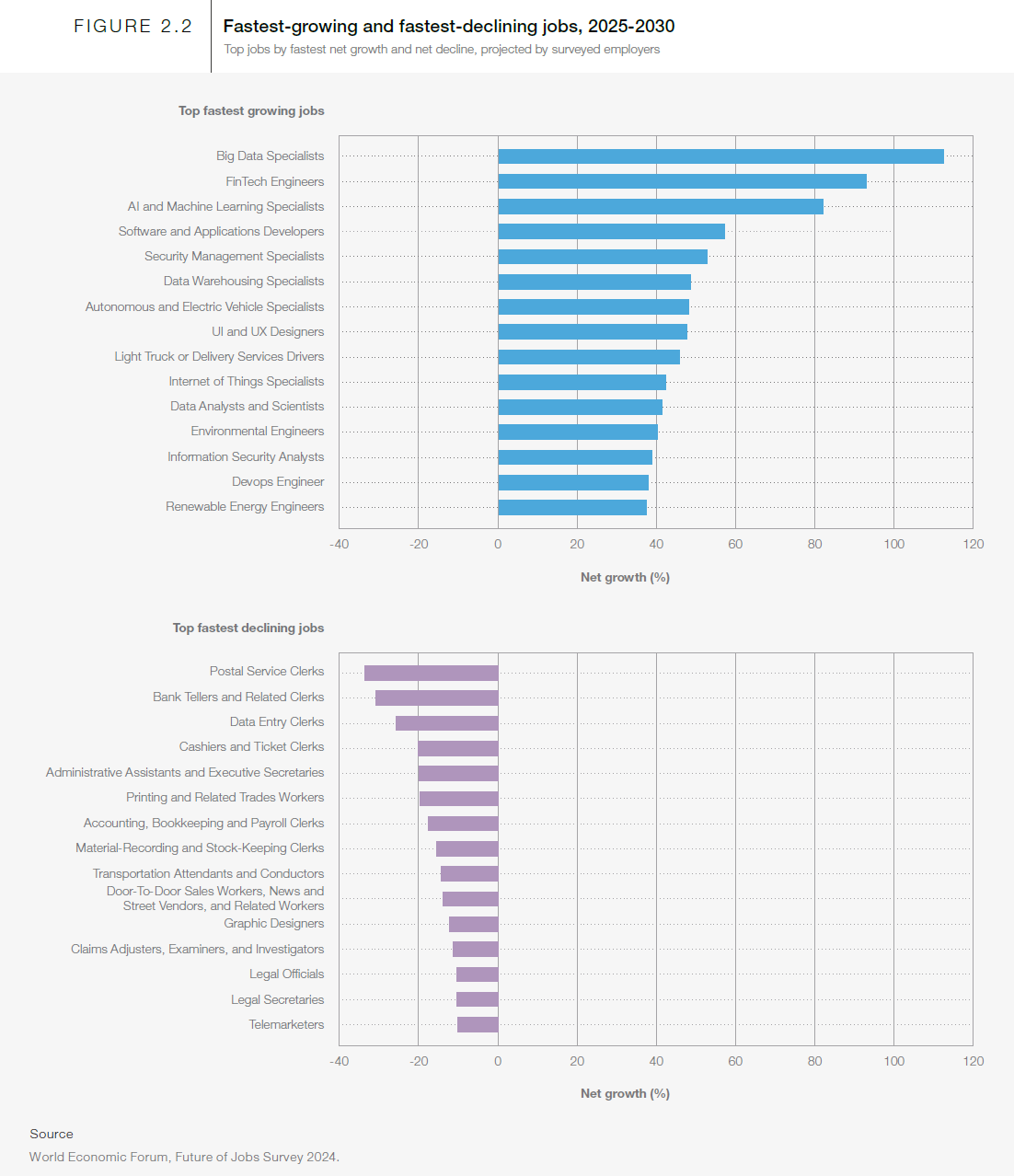

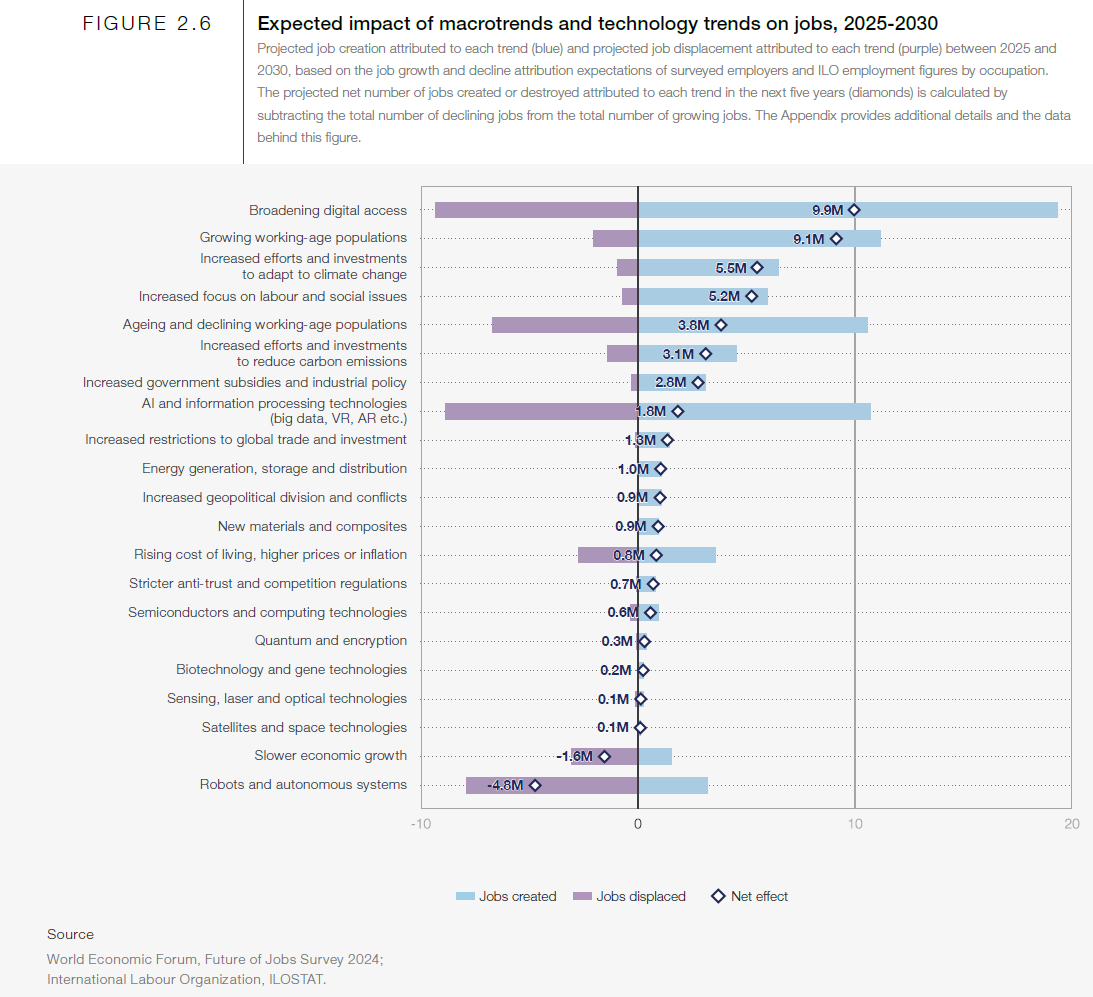

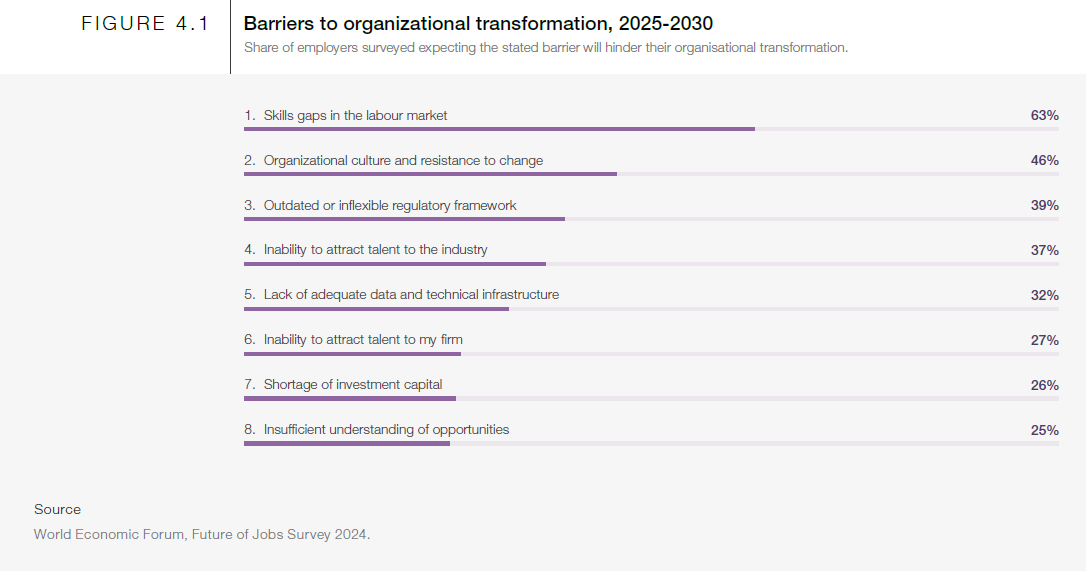

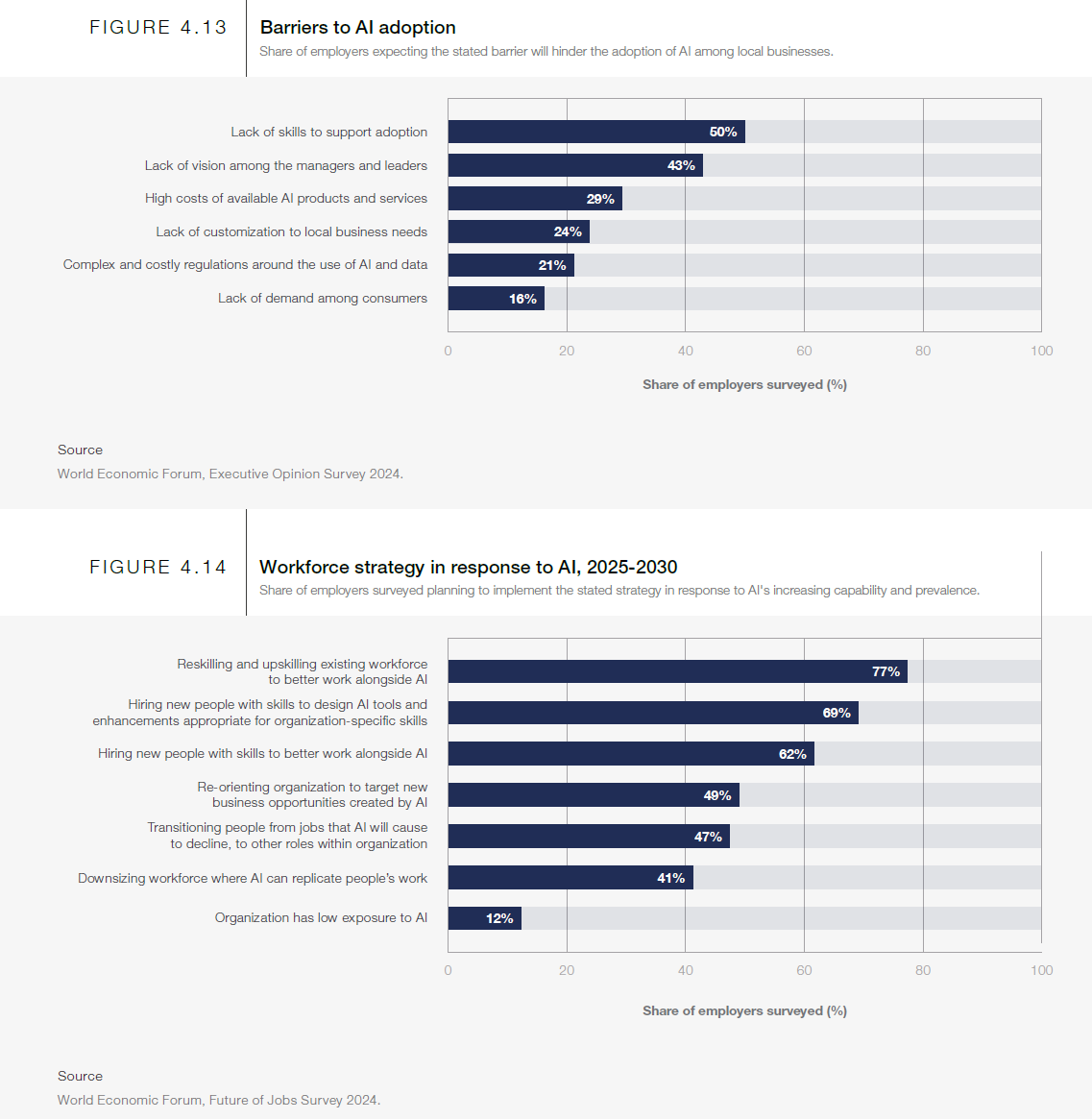

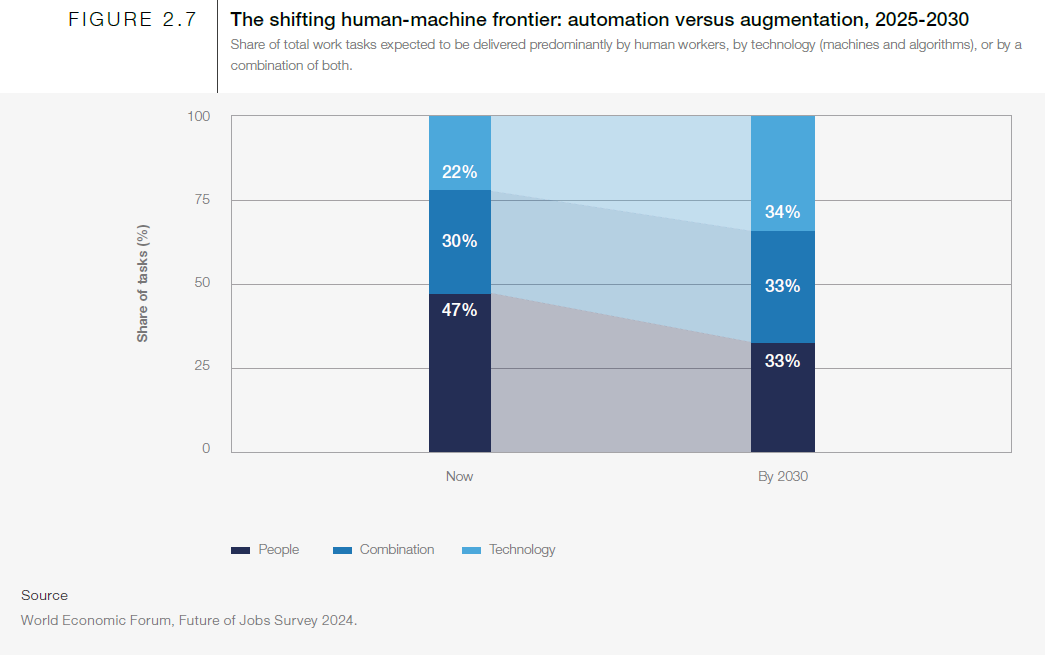

Le dernier rapport du Forum Économique Mondial sur le Futur de l’Emploi en 2030 met en exergue la vitesse à laquelle l’IA et l’automatisation transforment la nature du travail. S’il est indéniable que certaines tâches de routine sont appelées à disparaître, il est tout aussi évident que de nombreux métiers émergent pour accompagner ces bouleversements technologiques. Dans l’industrie, la banque, le marketing ou encore le secteur public, l’IA réorganise déjà les chaînes de valeur et génère de nouveaux rôles professionnels, qu’il s’agisse d’analystes de données, de “dresseurs” d’algorithmes ou de spécialistes de la maintenance prédictive. Mais derrière ces constats parfois purement techniques, il y a en réalité une invitation à repenser la place de l’humain et la manière dont nous concevons nos organisations.

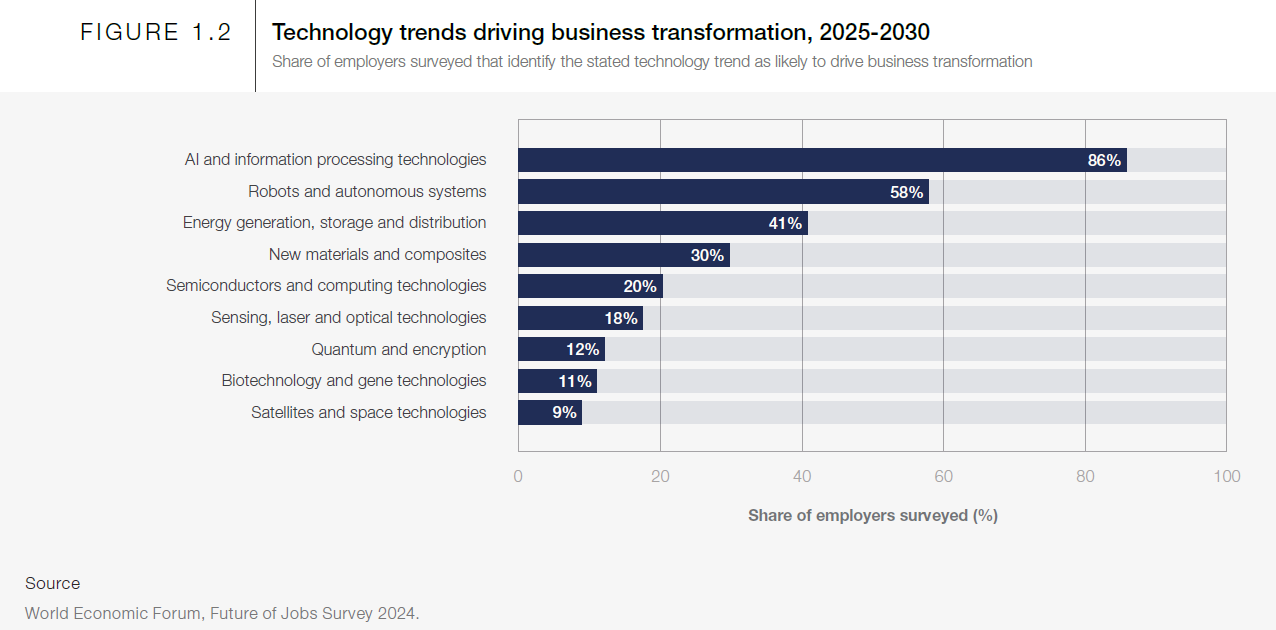

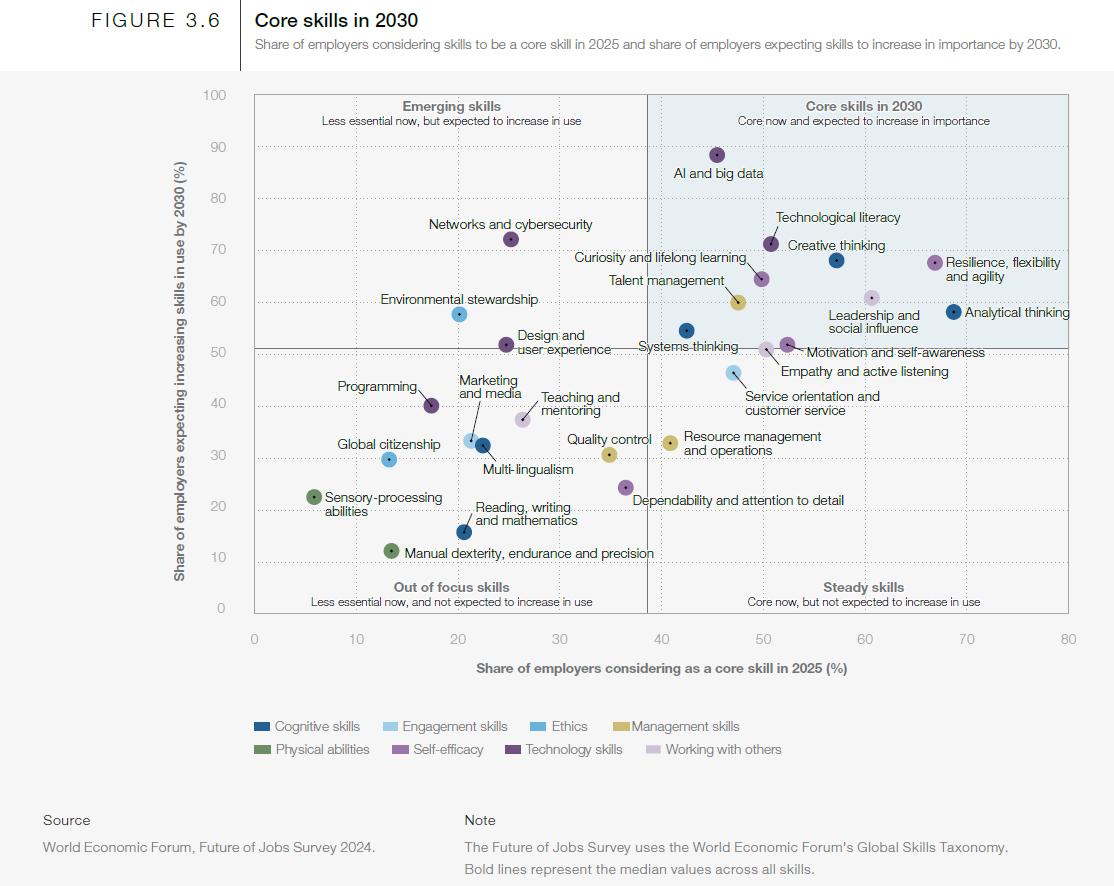

Pour ne pas se perdre dans une vision trop simpliste de destruction et de création d’emplois, il faut d’abord comprendre que cette révolution impose un changement de paradigme en matière de compétences. La capacité à maîtriser des technologies comme le cloud, la data ou le machine learning devient une priorité selon les entreprises interviewées, d’où l’insistance du rapport sur l’accélération du “reskilling” et de l’“upskilling”.

Les entreprises et les gouvernements sont exhortés à offrir plus de formations ciblées, à innover dans leurs méthodes pédagogiques et à favoriser des parcours continus d’apprentissage, afin que chacun puisse s’adapter à la cadence effrénée de l’innovation. On parle même de moderniser les systèmes éducatifs, avec notamment l’intégration de la programmation et de la culture numérique dès le plus jeune âge, pour donner aux générations à venir un socle solide sur lequel bâtir.

Ces mutations ne se limitent pas à la sphère technologique. L’employabilité de demain passe aussi, et peut-être surtout, par des compétences comportementales qui se révèlent peu automatisables : la pensée critique, la collaboration, la créativité, la capacité d’adaptation et l’empathie. Le rapport rappelle d’ailleurs qu’un algorithme, si perfectionné soit-il, manque de la contextualisation intuitive et de la sensibilité proprement humaines. Voilà pourquoi les entreprises les plus réactives valorisent aujourd’hui davantage la cohésion, la communication et cette fameuse “intelligence émotionnelle” comme des atouts stratégiques face à des marchés incertains et évolutifs.

En parallèle de ces impératifs liés à la formation et à l’évolution des compétences, le Forum Économique Mondial insiste sur les transformations structurelles des entreprises elles-mêmes. Mettre en place des systèmes d’IA va bien au-delà d’un projet ponctuel d’automatisation : il s’agit souvent de repenser l’organisation dans son ensemble. Les départements dédiés à l’analyse de données, les équipes pluridisciplinaires où cohabitent ingénieurs, marketeurs et spécialistes métiers ou encore les démarches de gouvernance de l’IA (comités d’éthique, protocoles de transparence algorithmique) deviennent des éléments centraux de la stratégie d’entreprise. Cette gouvernance de l’IA n’est pas un gadget : elle répond à une double nécessité, à la fois juridique (respect des réglementations, gestion des risques) et éthique (prévenir les dérives et les biais discriminatoires).

Le défi réglementaire est d’ailleurs un autre axe clé du rapport. Au rythme où évoluent les technologies, les pouvoirs publics ont parfois du mal à suivre, ce qui peut nuire à la fois à la confiance du grand public et à la sécurité des données. Transmettre, stocker et exploiter des volumes exponentiels d’informations exige des garanties robustes en matière de cybersécurité, de respect de la vie privée et de souveraineté numérique. Il devient urgent de définir des cadres clairs qui protègent l’intérêt général sans brider l’innovation. Dans le même temps, les administrations elles-mêmes sont invitées à s’appuyer sur l’IA pour améliorer la qualité des services rendus aux citoyens (démarches en ligne, e-gouvernance, open data…), tout en contribuant à une meilleure harmonisation internationale des standards autour de la technologie.

On ne peut bien sûr aborder la révolution IA sans mentionner l’ensemble des enjeux sociaux et environnementaux. D’un point de vue éthique, il est indispensable d’éviter les biais algorithmiques susceptibles de renforcer les discriminations. D’un point de vue sociétal, il faut faire en sorte que la transformation ne creuse pas davantage les inégalités, que ce soit entre salariés hautement qualifiés et peu qualifiés, ou entre grandes puissances économiques et pays moins avancés technologiquement. Du côté de l’écologie, le rapport souligne les atouts de l’IA dans la réduction des émissions carbones et la meilleure gestion des ressources, à condition que la course à la puissance de calcul (et donc à la consommation énergétique) soit pensée de manière responsable. L’IA peut servir la planète, mais elle peut aussi l’accélérer vers un usage abusif des ressources si son déploiement n’est pas mesuré.

Le télétravail, le freelancing et l’économie des plateformes s’imposent aussi comme des tendances fortes. L’entreprise est de plus en plus délocalisée, virtuelle, fonctionnant par projets. Ce nouveau fonctionnement hybride représente à la fois une opportunité de flexibilité et une source de stress et d’isolement. Les enjeux de santé mentale, de cohésion et de préservation d’un sentiment d’appartenance au collectif se posent avec acuité. Parallèlement, les systèmes de protection sociale doivent impérativement être repensés pour ne pas laisser sur le carreau ceux qui vivent de missions courtes, de contrats précaires ou qui se trouvent en zone grise vis-à-vis des droits et devoirs sociaux.

Enfin, le rapport met en avant l’importance de l’ouverture des données publiques (open data) et des coopérations internationales. Partager l’information, harmoniser les normes et standardiser les règles de gouvernance offrent un immense potentiel d’innovation. Sans cette volonté de collaboration, la “course à l’IA” risque de se transformer en fragmentation technologique, avec des standards hétérogènes et une concurrence exacerbée. Les entreprises qui sauront naviguer dans cet univers en s’appuyant à la fois sur la R&D, l’échange de bonnes pratiques et le respect des nouvelles obligations réglementaires tireront leur épingle du jeu, d’autant plus qu’elles seront mieux préparées à anticiper les nombreux métiers de demain, particulièrement dans des domaines comme la santé numérique, l’énergie verte ou la logistique intelligente.

Ce panorama, aussi large soit-il, laisse entrevoir à quel point l’intelligence artificielle est un levier de croissance et de transformation radicale de nos sociétés. Mais on voit également que la technique ne suffit pas : sans une vraie prise en compte de l’humain, de la diversité et des impacts sociétaux, la modernisation risque de se faire au détriment du lien social et de la confiance, indispensables à la pérennité des organisations.

Pour relever ces défis, plusieurs leviers concrets se dessinent et méritent l’attention des dirigeants. Il est d’abord essentiel d’analyser en profondeur la maturité d’une organisation vis-à-vis de l’IA : il faut savoir où se situent les compétences existantes, déterminer à quel rythme et sur quels processus se concentrer, puis définir comment intégrer l’IA au cœur de la stratégie plutôt que de la confiner à un service isolé. Dans le même élan, les entreprises gagneront à soutenir des parcours de formation avancée et à encourager une culture de l’apprentissage permanent. Des programmes de développement des soft skills et de découverte des technologies IA instaurent progressivement une confiance mutuelle entre les équipes et un climat propice à la créativité.

Ensuite, la mise en place d’un système de gouvernance et d’éthique de l’IA s’impose pour garantir la transparence et la responsabilisation. Cela peut se traduire par la création d’un comité dédié, qui inclut non seulement des experts techniques, mais aussi des représentants des ressources humaines, du juridique et de la direction générale. Dans la mesure où cette transformation ne peut se faire seul, il est indispensable de tisser des partenariats avec des universités, des startups ou encore des organismes publics. Cette ouverture vers l’extérieur encourage la circulation d’idées, l’innovation partagée et l’émergence de standards reconnus.

Enfin, il faut accorder une attention spécifique à la dimension sociétale, et donc inscrire la transition technologique dans une démarche responsable. Mesurer et piloter l’impact sur l’emploi local, sur la diversité et sur l’environnement constitue un pas important pour valoriser la contribution sociale de l’entreprise et préserver sa réputation. Au lieu de réduire l’IA à un levier d’optimisation des coûts, on gagne à la positionner comme un catalyseur d’intelligence collective, où la machine libère du temps aux collaborateurs pour des tâches à plus forte valeur ajoutée, et où la complémentarité humain-IA devient un moteur d’innovation continu.

Anticiper le Futur de l’Emploi, c’est donc comprendre que la technologie n’est jamais neutre, qu’elle pose des questions éthiques et organisationnelles majeures, et qu’elle exige un leadership capable d’embrasser le changement sans sacrifier le potentiel humain. Les entreprises qui réussissent dans ce contexte ont pour point commun de remettre l’humain au centre, de miser sur la coopération entre l’intuition créative des femmes et des hommes et la puissance de calcul inégalée des systèmes d’IA, tout en adoptant une démarche préventive sur les risques associés à la confidentialité, aux biais algorithmiques et aux inégalités. Celles qui sauront s’inspirer de ces enseignements en faisant évoluer leur structure, leur culture et leurs pratiques, s’ouvriront un vaste champ d’opportunités économiques et sociétales.

L’édition génomique humaine

La revue scientifique Nature (l'une des publications les plus respectées dans le domaine) a réactivé en janvier 2025 le débat sur l’édition du génome humain. L’éditorial appelle à une discussion mondiale sur cette pratique rejetée à date. Il souligne qu’elle pourrait réduire à terme les risques de maladies multifactorielles comme la schizophrénie, le diabète ou Alzheimer. Au-delà des promesses théoriques, cette perspective induit indubitablement des interrogations plus qu’impliquantes concernant les conséquences éthiques, scientifiques et sociétales d’une telle entreprise.

L’édition génétique humaine n’est pas une idée nouvelle. En 2018, He Jiankui (un chercheur chinois) a provoqué une onde de choc en annonçant la naissance de jumelles génétiquement modifiées surnommées Lulu et Nana. Cette manipulation, effectuée avec l’outil CRISPR-Cas9, avait pour objectif de réduire leur susceptibilité au VIH. Mais les effets secondaires imprévus et les questions éthiques soulevées par cette expérience ont mis en sur le devant de la scène les dangers d’une course technologique débridée. Le cas des jumelles est rapidement devenu un symbole des risques encourus lorsqu’une technologie puissante est employée sans régulation ni concertation internationale. He Jiankui a été condamné à trois ans de prison. Son initiative reste un avertissement sur les dérives potentielles. Elle montre que l’accès aux outils de manipulation génétique de plus en plus simplifiés et abordables favoriseront probablement des initiatives isolées et irresponsables surtout dans un monde en pleines mutations dont la montée de l’infertilité. Cette affaire illustre également la nécessité d’établir des normes éthiques et légales communes au niveau international afin de prévenir d'autres utilisations imprévues de ces technologies.

L’éditorial de Nature se concentre sur une approche dite « polygénique », c’est-à-dire la modification simultanée de plusieurs gènes pour réduire les risques de maladies multifactorielles. Cette stratégie se fonde sur la prémisse que de nombreuses maladies complexes résultent de l’interaction de multiples gènes et de facteurs environnementaux mais l’intervention sur plusieurs gènes en même temps introduit un degré d’incertitude élevé. Les interactions génomiques, par ailleurs souvent peu comprises, pourraient produire des effets inattendus ou contre-productifs, allant jusqu’à engendrer des mutations hors cible au sein du génome modifié. En conséquence, certains scientifiques s’interrogent : quels sont les seuils de fiabilité scientifique nécessaires avant d’envisager une application clinique ? Quels seraient les impacts sur la diversité génétique à long terme ? Et dans quelle mesure ces interventions peuvent-elles réellement résoudre des problèmes de santé publique qui trouvent souvent leur origine dans des facteurs sociaux ou environnementaux ? Ces interrogations exigent un dialogue entre scientifiques, éthiciens et sociologues afin de construire une vision globale, partagée et intégrée des impacts potentiels.

Cette révolution annoncée repose sur les scores polygéniques. Ils mesurent la probabilité qu’un individu développe une maladie à partir de l’analyse statistique de vastes bases de données génomiques. Ces scores présentent de sérieuses limitations statistiques. Ils reposent sur des corrélations plutôt que des causalités et négligent souvent les effets contextuels liés à l’environnement. Par exemple, un individu ayant un risque élevé de diabète selon son score génomique pourrait ne jamais développer cette maladie grâce à une alimentation saine et à une activité physique régulière. Malgré ces incertitudes, certains laboratoires proposent déjà des services de sélection embryonnaire basés sur ces scores sans réel consensus scientifique ou éthique. Cette pratique soulève des craintes quant à une potentielle marchandisation de la procréation, avec des conséquences imprévisibles sur la perception sociale de l’héritage génétique. Elle pourrait également exacerber les inégalités sociales en réservant l’accès à ces technologies aux plus riches et en privant d’autres groupes de solutions thérapeutiques accessibles.

L’initiative de Nature vise à sensibiliser sur les opportunités et les risques liés à l’édition génomique. Cette invitation peut être perçue comme une tentative de normalisation d’une technologie encore immature et potentiellement dangereuse. Des experts, comme Kevin Mitchell, mettent en garde contre l’optimisme excessif et soulignent que les bénéfices annoncés ne doivent pas faire oublier les risques. Plus largement, l’idée de modifier l’ADN pour « améliorer » l’humain pose des questions sociétales profondes et rappelle de très mauvais souvenirs. Une telle approche peut aussi conduire à minimiser l’importance des politiques de santé publique et des interventions préventives, comme la lutte contre les pollutions, l’accès aux soins ou l’amélioration des conditions de vie. Les enjeux éthiques deviennent encore plus complexes lorsqu’on considère les conséquences intergénérationnelles de ces modifications. Modifier l’ADN d’un embryon implique des impacts potentiels sur plusieurs générations ce qui impose la question de la responsabilité envers des individus non encore nés.

Les progrès réalisés grâce à CRISPR-Cas9 ont ouvert des perspectives considérables notamment pour le traitement de maladies rares. La frontière entre médecine réparatrice et modification génétique à des fins d’optimisation reste floue et doit être clarifiée par un cadre éthique rigoureux. Une gouvernance claire et internationale doit être établie pour encadrer les pratiques. Cela implique de définir des standards scientifiques, éthiques et réglementaires pour s’assurer que ces technologies soient d’abord testées dans des contextes limités et supervisées par des comités multidisciplinaires si nous décidons de continuer. La technologie doit rester au service de l’humanité et non devenir un vecteur d’inégalités accrues ou de dérives eugénistes.

Les recommandations économiques d’Open AI

Cet article est composé d’une synthèse du document “AI in America OpenAI's Economic Blueprint” écrit par OpenAI et d’une analyse de ce dernier.

Synthèse du document

Plus de 175 milliards de dollars de capitaux sur la planète sont disponibles pour des projets IA mais l’argent ne fait pas tout. Si les États-Unis n’agissent pas rapidement, ces investissements risquent de renforcer l’influence technologique de la Chine dont les initiatives sont souvent soutenues par le Parti communiste chinois. Ce contexte compétitif exige des États-Unis qu’ils demeurent à l’avant-garde pour protéger leur leadership technologique et leur sécurité nationale.

Le développement de l’IA repose sur quatre piliers principaux : les semi-conducteurs, l’énergie, les données et le talent humain. Les infrastructures actuelles sont insuffisantes pour répondre à une demande croissante voir exponentielle. Par exemple, la pénurie mondiale de semi-conducteurs affecte non seulement les systèmes IA mais aussi des secteurs critiques comme l’automobile et les télécommunications. Cette situation freine considérablement le développement de l’IA.

Une réglementation fragmentée au niveau étatique ou international risque de freiner l’innovation tout en permettant des abus. Une harmonisation est essentielle pour accélérer le développement de modèles avancés. Les États-Unis doivent également se positionner comme leaders dans l’établissement de normes mondiales pour éviter que des régimes autoritaires n’imposent leurs propres standards.

L’IA ne doit pas devenir un outil de contrôle autoritaire. OpenAI préconise le partage sécurisé de ses modèles avancés avec des alliés dans le but de renforcer des écosystèmes démocratiques tout en limitant leur accès à des nations susceptibles de les détourner à des fins malveillantes. À titre d’exemple, l’entreprise déclare déjà collaborer avec des institutions comme le Laboratoire national de Los Alamos et l’US Air Force Research Laboratory pour tester les risques liés à ses modèles et anticiper les menaces cybernétiques.

Pour capitaliser sur le potentiel de l’IA, OpenAI appelle à des investissements massifs dans les infrastructures, notamment pour :

Produire des semi-conducteurs en abondance et développer des technologies énergétiques durables comme la fusion nucléaire ou le solaire.

Créer des zones économiques dédiées à l’IA, accélérant les permis pour des projets critiques tels que les centres de données et les réseaux énergétiques.

Soutenir une National AI Research Resource, un réseau d’infrastructures accessible à tous pour démocratiser la recherche et l’innovation.

Pour protéger les utilisateurs, des normes claires doivent être établies. Cela inclut l’utilisation de standards ouverts, comme ceux de la Coalition for Content Provenance and Authenticity (C2PA), pour garantir la traçabilité des contenus générés par l’IA. OpenAI travaille également avec des organisations comme le National Center for Missing and Exploited Children pour prévenir les abus, notamment en matière de contenu nuisible. En outre, les utilisateurs doivent être autonomisés grâce à des outils leur permettant de personnaliser leurs interactions avec l’IA, tout en conservant le contrôle sur leurs données personnelles. Cela nécessitera des efforts conjoints pour renforcer l’éducation et l’alphabétisation numérique.

Une stratégie nationale d’éducation sur l’IA est indispensable pour préparer la future main-d’œuvre. Cela inclut le développement de hubs régionaux spécialisés, par exemple en agriculture dans le Kansas ou en énergie au Texas, pour répondre aux besoins locaux tout en intégrant les technologies avancées. Ces initiatives doivent également cibler les zones marginalisées pour garantir que l’ensemble du pays bénéficie de la prospérité générée par l’IA.

OpenAI plaide pour des alliances internationales afin de fixer des normes globales pour l’IA. Un pacte transatlantique, par exemple, pourrait renforcer les collaborations technologiques entre les États-Unis et l’Union Européenne. Parallèlement, une harmonisation des évaluations de sécurité nationale permettrait de standardiser les protocoles tout en réduisant les obstacles bureaucratiques.

En synthèse, si les recommandations de l’entreprise sont suivies, OpenAI pense que « Avec l’IA, nos enfants pourront faire des choses que nous ne pouvons pas, et, un jour, la vie de chacun pourrait être meilleure que la meilleure vie d’aujourd’hui. ». Rien que ça.

Analyse et décodage

Ce document illustre une vision classique et économique de l’IA, une vision ancrée dans une hégémonie nationale des États-Unis et qui veut renforcer des paradigmes existants plutôt que de les questionner. Malgré de nombreuses bonnes intentions affichées (démocratisation de l'accès à l'IA, promotion de la sécurité, et collaboration avec des alliés), il manque une réflexion véritablement disruptive sur ce que pourrait être un modèle sociétal différent, dans lequel l’IA servirait tous de manière égalitaire et durable.

Le texte est imprégné d’un discours nationaliste. L’IA est envisagée comme un levier pour maintenir la suprématie américaine face à la Chine sans grand considération pour le reste du monde. Certes, cette posture peut être compréhensible dans un contexte géopolitique tendu, mais elle réduit l’IA à un outil stratégique et économique, sans aborder la possibilité d’une gouvernance mondiale. Où est la vision collective et humaniste d’une IA pensée pour transcender les frontières et répondre aux défis globaux comme la pauvreté, les inégalités ou le changement climatique ? On parle ici davantage de compétition que de coopération, ce qui perpétue les divisions et au passage contredit la mission d’Open AI qui est de construire une IA pour le bien de l’humanité.

L’idée de "démocratie" autour de l’IA est superficielle et unilatérale. Elle est évoquée comme une manière de favoriser les entreprises américaines, mais pas réellement pour donner un pouvoir équivalent aux citoyens du monde entier. Cette approche met l’accent sur le rôle des entreprises, des gouvernements et des élites, mais elle ignore comment intégrer réellement les communautés locales et marginalisées dans les processus décisionnels autour de l’IA. D’où ma question : où est l'humain dans cette équation ?

Le document repose sur une hypothèse implicite que les structures économiques, sociales et politiques actuelles sont immuables. On ne questionne pas le modèle de consommation exponentielle d'énergie ou la logique extractive des ressources nécessaires pour produire les infrastructures et encore moins ce que sera le travail et l’emploi dans le futur. Pourquoi ne pas envisager une transition vers un modèle où l’IA servirait à repenser nos modes de vie, à ralentir notre course au profit d’un bien-être collectif, et à privilégier une économie de la sobriété technologique ? Ce point est frappant par son absence.

L'insistance sur les "main streets" de développeurs et les "AI economic zones" montre une volonté de capitaliser sur l’IA comme moteur de croissance économique. Mais cela revient à intégrer l’IA dans un système qui produit déjà des inégalités et des injustices structurelles. Pourquoi ne pas proposer une alternative où l’IA permettrait de redistribuer les richesses de manière plus équitable, et non de renforcer les monopoles ?

Le document prône des partenariats entre l’État et les entreprises pour piloter le développement de l’IA. Bien que la régulation soit indispensable, ce modèle risque de concentrer encore davantage de pouvoir dans les mains de quelques acteurs clés, tout en marginalisant les citoyens. L’IA pourrait devenir un outil de surveillance et de contrôle sous couvert de sécurité nationale, ce qui irait à l’encontre des libertés individuelles que ce même texte affirme défendre.

Le document propose une centralisation du pouvoir autour de l'État et des grandes entreprises pour développer et réguler l'IA. Ce modèle, bien qu'efficace pour des gains rapides, est dangereux à long terme, car il renforce les déséquilibres de pouvoir. Pourquoi ne pas imaginer une gouvernance décentralisée et réellement démocratique ? Cela pourrait inclure la création de coopératives locales et internationales pour gérer les données et le développement d'algorithmes. Ces coopératives donneraient une voix à tous les citoyens, pas seulement aux gouvernements ou aux entreprises. Les utilisateurs pourraient participer à des décisions stratégiques, comme l'utilisation des modèles IA dans leurs communautés, ou la redistribution des bénéfices issus des innovations technologiques. De plus, une telle gouvernance nécessiterait des cadres éthiques établis par des assemblées citoyennes et scientifiques, garantissant que l'IA reste un outil au service du bien commun. Une telle approche pourrait éviter que l’IA ne soit utilisée à des fins de surveillance, de contrôle ou d’enrichissement exclusif.

L'absence de réflexion écologique dans le document est inquiétante, surtout quand on connaît l'empreinte carbone des infrastructures IA, des centres de données et de la fabrication de puces. La proposition de réindustrialisation est problématique si elle repose sur une exploitation croissante des ressources naturelles sans considération pour les limites planétaires. Un modèle alternatif devrait intégrer la sobriété technologique comme principe fondateur. Cela signifierait développer des IA plus légères et moins consommatrices en énergie, favoriser les circuits courts pour les infrastructures technologiques (fabrication locale de composants, recyclage des matériaux existants) et investir massivement dans les énergies renouvelables pour alimenter les centres de données, tout en promouvant des modèles distribués de stockage et de traitement des données (edge computing) pour réduire la centralisation énergétique. Ce n’est pas seulement une question de transition écologique, mais aussi une opportunité de repenser le rapport entre technologie et environnement. L’IA pourrait devenir un levier pour concevoir des solutions plus durables et non pour alimenter un modèle extractiviste dépassé.

Le document reste enfermé dans une logique de croissance infinie, voyant l’IA comme un moteur pour accélérer l'économie. Pourtant, cette vision ignore les conséquences néfastes de ce modèle, notamment les inégalités croissantes et la destruction des écosystèmes. Pourquoi ne pas envisager l’IA comme un outil pour favoriser une société résiliente, plutôt qu’une économie toujours plus expansive ? Un modèle post-croissance pourrait se concentrer sur : L’autonomie locale (utiliser l’IA pour renforcer les circuits courts, optimiser la gestion des ressources locales (eau, énergie, alimentation) et réduire la dépendance aux marchés globaux), la réduction des inégalités (développer des outils d’IA pour identifier et corriger les inégalités structurelles, notamment dans l'accès à l'éducation, à la santé ou à l'information) et Le ralentissement utile (favoriser une IA qui soutient une société moins rapide mais plus juste, en mettant l'accent sur le bien-être humain plutôt que sur la productivité. Cela impliquerait de redéfinir les indicateurs de "succès" de l’IA : non pas le PIB ou le nombre de nouvelles entreprises, mais des mesures de santé collective, d’équité et de durabilité.

OpenAI se focalise sur une opposition binaire États-Unis/Chine et sur l’idée de défendre la souveraineté technologique américaine. Cette perspective réduit l’IA à une arme dans une guerre froide technologique. Une vision plus inclusive et équitable est nécessaire. Pourquoi ne pas proposer une gouvernance internationale de l’IA, sous l’égide d’un organisme global indépendant, tel que l’ONU ou un autre ? Cette entité pourrait définir des règles communes pour éviter que l’IA ne devienne un outil de surveillance ou de manipulation à grande échelle, garantir un partage équitable des bénéfices de l’IA entre les nations, en priorisant les pays en développement qui risquent d’être laissés pour compte dans cette course technologique et créer un fonds mondial pour financer des projets IA répondant aux besoins globaux (lutte contre le réchauffement climatique, gestion des catastrophes naturelles, prévention des pandémies). Une telle gouvernance internationale permettrait d’éviter l’accaparement des ressources et du savoir-faire technologique par une poignée de pays ou d’entreprises tout en renforçant la coopération globale face aux défis communs.

Ce document manque de radicalité et de vision à long terme. Il se contente de renforcer un modèle déjà existant, en espérant que l’IA puisse "réparer" ce qui dysfonctionne, sans oser réimaginer ce que pourrait être une société profondément transformée. Si nous voulons une IA pour l’humanité, il faudra oser sortir des sentiers battus et poser les bonnes questions sur la finalité même de cette technologie.

Plongée dans Coconut

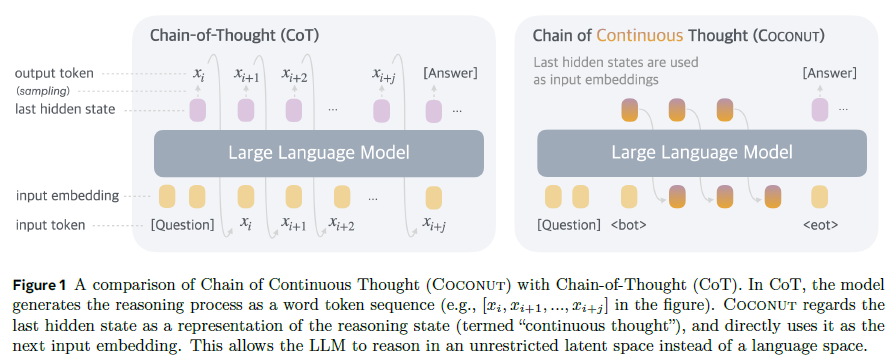

Cet article est une synthèse du document “Training Large Language Models to Reason in a Continuous Latent Space” écrit par Shibo Hao, Sainbayar Sukhbaatar, DiJia Su, Xian Li, Zhiting Hu, JasonWeston, Yuandong Tian qui travaillent pour FAIR chez Meta ou à l’UC San Diego.

Les modèles de langage (LLMs) sont omniprésents dans l’IA générative et comme vous avez pu le constater ont encore de nombreux défauts et en particulier leur capacité à raisonner face à des problèmes complexes. L’approche Coconut (« Chain of Continuous Thought »), développée par FAIR chez Meta, améliore le raisonnement des LLMs en explorant un espace latent continu.

Les LLMs actuels raisonnent principalement dans un espace linguistique. Chaque étape du raisonnement est générée sous forme de tokens en langage naturel (« Chain-of-Thought » ou CoT). Cette approche pose plusieurs problèmes dont :

Surcoût cognitif : La majorité des tokens servent à la cohérence textuelle plutôt qu’au raisonnement.

Rigidité structurelle : Les étapes critiques (nécessitant une planification complexe) sont limitées par cette approche.

Les neurosciences ont montré que le langage humain est davantage un outil de communication qu’un support optimal pour des processus de raisonnement complexes. L’approche Coconut propose une évolution conceptuelle permettant de changer la façon de procéder en déplacent le raisonnement dans un espace latent continu. Voici les trois principes fondamentaux (c’est un peu technique …) :

Espace de raisonnement sans langage : Les états cachés du modèle représentent directement les étapes du raisonnement, sans passer par des tokens textuels.

Optimisation globale : Le raisonnement est affiné par une optimisation end-to-end via descente de gradient.

Exploration simultanée : Coconut peut explorer plusieurs chemins possibles en parallèle avant de converger vers une solution.

Coconut combine deux modes d’opération :

Mode langage : Fonctionne comme un LLM classique, produisant des tokens textuels.

Mode latent : Les états cachés remplacent les tokens comme entrées successives.

Ces modes alternent ce qui permet une transition fluide et un contrôle précis du raisonnement.

Les performances de Coconut ont été évaluées sur plusieurs benchmarks :

Math Reasoning (GSM8k) : Coconut améliore la précision en réduisant le nombre de tokens générés.

Logical Reasoning (ProsQA) : Le modèle surpasse CoT dans des tâches impliquant planification et exploration de graphes complexes.

Efficacité : Coconut diminue le temps d’inférence tout en offrant des réponses de meilleure qualité ce qui est une très bonne nouvelle.

Contrairement à une simple chaîne linéaire, Coconut modélise le raisonnement comme un arbre de recherche. Cela permet :

Exploration parallèle : Plusieurs possibilités sont envisagées simultanément.

Planification dynamique : Les choix critiques sont décalés, ce qui évite les décisions prématurées.

Priorisation adaptative : Les chemins les plus prometteurs sont favorisés grâce à une évaluation implicite.

Coconut redéfinit le raisonnement des LLMs en s’affranchissant des limites linguistiques. Cette approche promet de transformer des domaines variés, allant des mathématiques à la planification stratégique, tout en rapprochant les modèles d’une cognition plus humaine.

A suivre

Bonnes métamorphoses et à la semaine prochaine !

Stéphane